上一篇

分布式数据采集系统未响应

- 行业动态

- 2025-05-06

- 2

分布式数据采集系统未响应可能因网络中断、节点故障、资源不足或配置错误,需查网络、节点状态、资源及配置,逐项排查修复

分布式数据采集系统未响应的排查与解决方案

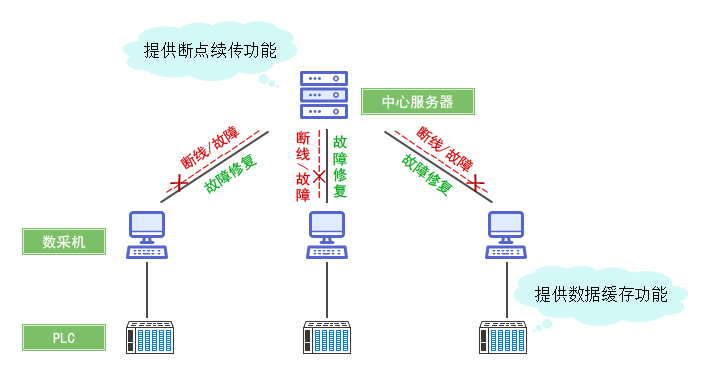

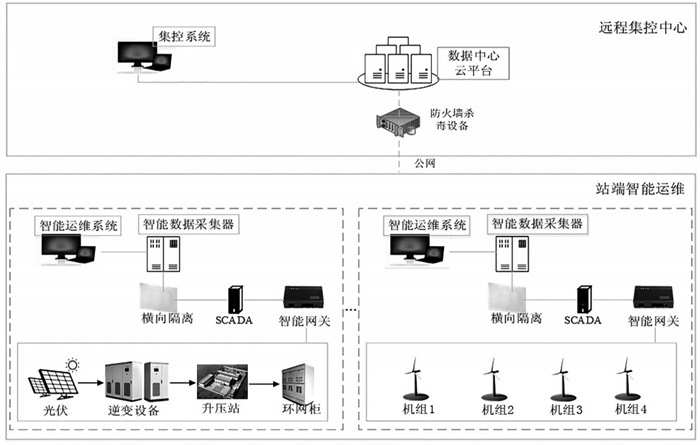

分布式数据采集系统在大规模数据处理场景中扮演重要角色,但其复杂性也导致故障排查难度较高,当系统出现未响应问题时,需从多维度分析潜在原因,以下是系统性排查框架:

问题影响范围判断

| 检查项 | 操作步骤 | 预期结果 |

|---|---|---|

| 服务健康状态 | 通过监控平台查看各节点CPU、内存、磁盘IO、网络流量 | 确认是否为全局性故障 |

| 数据链路完整性 | 检查数据采集→传输→存储全链路状态(如Kafka消费进度、数据库写入延迟) | 定位故障环节 |

| 业务影响面 | 统计受影响的数据源数量、数据量,观察下游任务是否积压 | 评估故障严重等级 |

核心故障原因分析

以下为常见未响应场景的分类及解决方案:

网络层问题

| 故障类型 | 典型症状 | 诊断方法 | 解决方案 |

|---|---|---|---|

| 防火墙阻断 | 节点间Ping不通,端口不可达 | 检查安全组规则、防火墙策略 | 开放必要端口(如50051/50010) |

| 带宽饱和 | 网络延迟突增,数据传输速度归零 | 使用iftop/nload监控带宽 | 优化数据压缩算法,扩容网络资源 |

| DNS解析失败 | 服务注册中心访问超时 | 检查/etc/resolv.conf配置 | 切换DNS服务器或启用本地缓存 |

服务端资源耗尽

| 故障类型 | 典型症状 | 诊断方法 | 解决方案 |

|---|---|---|---|

| 线程池耗尽 | 请求队列堆积,服务响应时间飙升 | 监控JVM线程数(jstack分析) | 增加线程池容量,启用动态扩容 |

| 内存泄漏 | JVM老年代频繁Full GC,系统卡死 | Heap Dump分析(jmap+MAT) | 修复内存泄漏代码,调整堆内存大小 |

| 文件句柄耗尽 | 日志无法写入,”Too many open files” | lsof查看进程打开文件数 | 修改ulimit -n,优化文件句柄管理 |

客户端异常

| 故障类型 | 典型症状 | 诊断方法 | 解决方案 |

|---|---|---|---|

| 心跳超时 | 采集器被误判为离线 | 检查心跳间隔配置(如Fluent Bit的netflow_timeout) | 延长心跳周期,优化网络稳定性 |

| 数据格式不匹配 | 解析失败日志增多,数据丢失 | 对比Schema版本,检查序列化配置 | 升级协议兼容性,增加数据校验 |

| 客户端崩溃 | 进程退出,无错误日志 | 启用核心转储(ulimit -c),分析崩溃现场 | 修复空指针等代码缺陷,增加监控 |

数据层瓶颈

| 故障类型 | 典型症状 | 诊断方法 | 解决方案 |

|---|---|---|---|

| Kafka分区倾斜 | 部分Broker消息积压,Replica落后过多 | 使用kafka-topics.sh查看分区分布 | 重新分配Partition,启用自动平衡 |

| 数据库锁冲突 | SQL执行超时,事务回滚率上升 | 分析慢查询日志,检查索引覆盖率 | 优化SQL语句,拆分大表 |

| 存储介质故障 | 磁盘IO等待时间超过阈值 | smartctl检测硬盘健康状态 | 更换故障磁盘,启用RAID冗余 |

配置错误

| 故障类型 | 典型症状 | 诊断方法 | 解决方案 |

|---|---|---|---|

| 超时参数过短 | 网络抖动导致连接中断 | 检查connect_timeout/read_timeout设置 | 调大超时阈值,增加重试次数 |

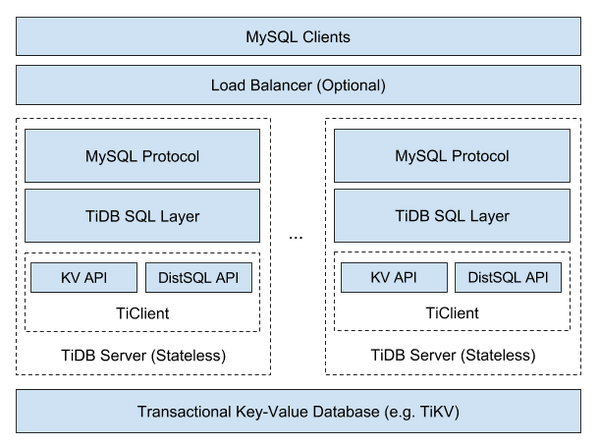

| 负载均衡策略错误 | 部分节点流量过高,其他节点空闲 | 分析Nginx/HAProxy日志 | 调整权重算法,启用会话保持 |

| 动态扩容失效 | CPU使用率100%持续5分钟无缓解 | 检查容器编排策略(如Kubernetes HPA) | 修复指标采集,配置弹性伸缩规则 |

应急处理流程

快速恢复服务

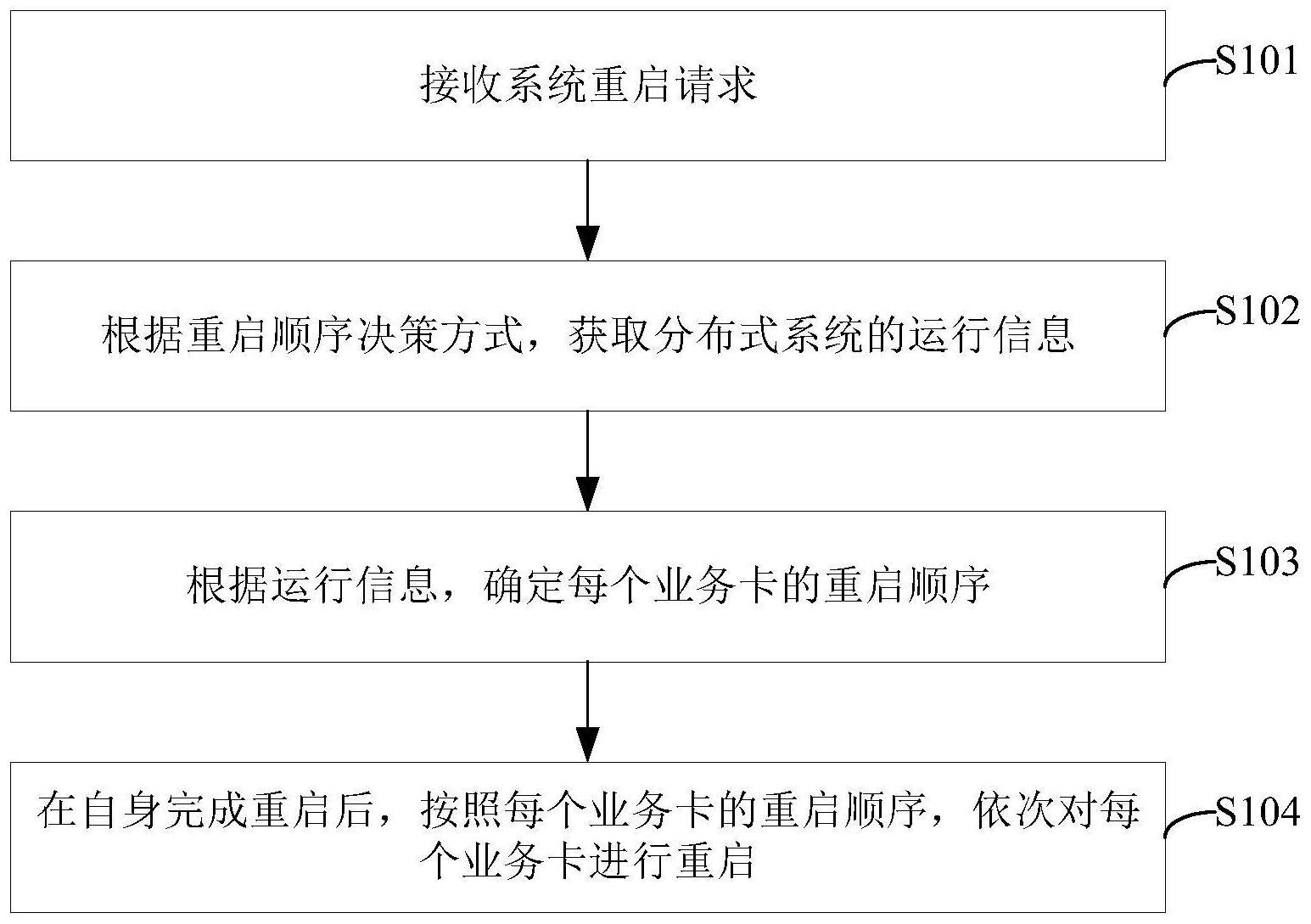

- 优先重启无响应节点(

kill -9强制终止后启动新进程) - 切换至备用链路(如启用多活数据中心)

- 临时关闭非核心数据采集任务

- 优先重启无响应节点(

根因分析

- 收集故障时段日志(建议保留最近1小时全量日志)

- 生成系统快照(Docker容器可

commit,虚拟机可克隆) - 复现故障场景(搭建模拟环境验证修复方案)

长效预防机制

- 部署猫头鹰监控(Prometheus+Granfana)实时捕获异常指标

- 启用混沌工程(Chaos Monkey演练网络分区)

- 实现熔断降级(Hystrix隔离故障模块)

相关问答FAQs

Q1:如何快速定位分布式系统中首个失效节点?

A1:

- 使用分布式追踪工具(如Jaeger)查看调用链,找到首个超时节点

- 分析心跳监控系统(如ZooKeeper/Consul)的最后心跳时间戳

- 检查各节点日志中首次出现错误的绝对时间,排序比对

Q2:如何预防数据采集系统雪崩效应?

A2:

- 背压机制:限流(如令牌桶算法控制采集速率)

- 缓冲设计:增加内存队列(如Disruptor框架)暂存突发流量

- 优先级策略:区分关键业务数据与非核心数据,优先保障前者

- 自动扩缩容:基于队列长度动态扩展采集器实例数量