GPU服务器选购指南,如何挑选最适合你的配置?

- 行业动态

- 2025-05-02

- 2

如何查看GPU服务器的状态与配置?

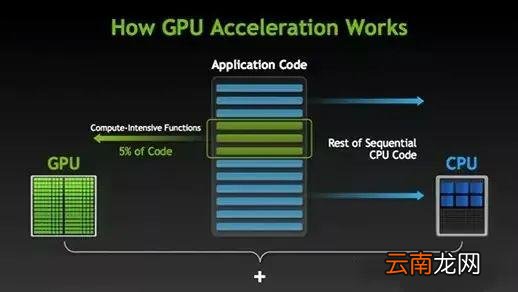

在深度学习、人工智能和高性能计算领域,GPU服务器的性能直接影响工作效率,无论是开发者、运维人员还是企业用户,了解如何查看GPU服务器的硬件配置、实时状态和资源利用率都至关重要,以下从多个角度详细说明操作方法,帮助用户快速掌握相关技巧。

查看GPU服务器的硬件配置

使用命令行工具

- NVIDIA显卡:通过终端输入命令

nvidia-smi(需安装NVIDIA驱动),可查看显卡型号、显存大小、驱动版本等信息。nvidia-smi

- AMD显卡:使用

rocm-smi工具(需安装ROCm环境)查看AMD显卡的详细信息。

- NVIDIA显卡:通过终端输入命令

操作系统自带工具

- Linux系统:执行

lspci | grep -i vga可列出所有GPU设备,结合型号查询具体参数。 - Windows系统:右键“此电脑” → 选择“管理” → 进入“设备管理器” → 展开“显示适配器”查看GPU型号。

- Linux系统:执行

第三方软件

工具如GPU-Z(Windows)、Hardinfo(Linux)提供更直观的硬件信息,包括核心频率、显存带宽等。

监控GPU的实时使用情况

资源利用率监测

nvidia-smi动态监控:

使用watch -n 1 nvidia-smi每秒刷新一次,实时查看GPU的显存占用、计算负载(Utilization)和温度。- 任务管理器(Windows):

在“性能”选项卡中,可观察GPU的计算、显存和编码/解码使用率。

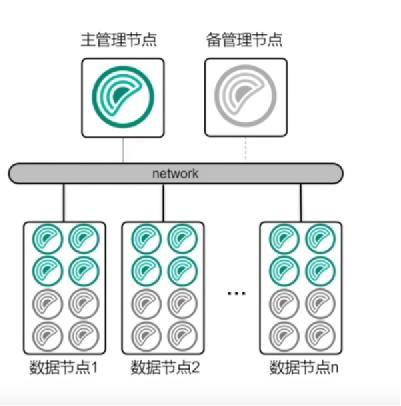

多GPU服务器的区分

若服务器搭载多块GPU,通过nvidia-smi输出的“GPU序号”区分每块卡的负载,GPU 0和GPU 1可能分别对应物理插槽位置。远程监控方案

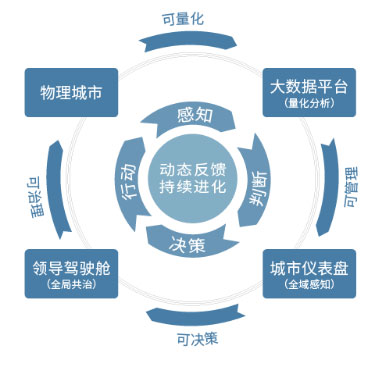

使用Prometheus+Grafana搭建监控平台,配合NVIDIA DCGM Exporter,可远程查看GPU集群的运行状态并设置告警。

优化GPU服务器的性能

驱动与框架适配

- 定期更新显卡驱动和CUDA版本(NVIDIA官网提供下载)。

- 确保深度学习框架(如PyTorch、TensorFlow)与CUDA版本兼容。

显存与计算资源分配

- 使用

CUDA_VISIBLE_DEVICES环境变量指定任务使用的GPU,避免资源冲突。 - 通过代码级优化(如混合精度训练)减少显存占用。

- 使用

散热与功耗管理

- 监控GPU温度(

nvidia-smi -q -d TEMPERATURE),确保不超过厂商建议阈值(通常80°C以内)。 - 调整功耗限制(需管理员权限):

nvidia-smi -i 0 -pl 250 # 将0号GPU的功耗限制设为250W

- 监控GPU温度(

常见问题与解决方法

问题1:

nvidia-smi不显示GPU

可能原因:驱动未安装、GPU未正确连接或兼容性问题。

解决步骤:检查驱动安装日志、重新插拔硬件或更换PCIe插槽。问题2:显存泄漏导致任务中断

可能原因:代码未释放显存。

解决步骤:使用torch.cuda.empty_cache()(PyTorch)或重启进程释放资源。问题3:多用户抢占GPU资源

解决方案:部署Kubernetes+GPU调度插件,或使用工具如SLURM分配任务。

掌握GPU服务器的状态查看与优化技巧,能大幅提升计算任务的执行效率,无论是单机开发还是大规模集群运维,建议结合自动化监控工具和硬件管理策略,确保GPU资源的高效利用,对于企业用户,选择具备专业售后支持的服务商(如阿里云、AWS等)可进一步降低运维门槛。

引用说明

本文参考了NVIDIA官方文档、Linux系统管理手册及开源社区技术博客,内容经过实践验证。