上一篇

个性化语音合成建模方法的研究

- 行业动态

- 2025-04-28

- 2

个性化语音合成建模基于数据驱动,结合深度学习优化声学模型,提升

个性化语音合成建模方法的研究

研究背景与核心挑战

个性化语音合成(Personalized Text-to-Speech, PTTS)旨在为不同说话人生成具有独特音色、韵律和情感特征的语音,与传统通用型TTS相比,其核心挑战在于:

- 说话人差异性:需捕捉发音习惯、基频轮廓、音色纹理等个性化特征

- 数据稀缺性:目标说话人通常仅有分钟级音频数据

- 跨场景适应性:需处理不同情绪、语速、噪声环境下的语音生成

- 实时性要求:需在有限计算资源下实现快速合成

关键技术演进路径

传统参数化建模方法

| 方法类型 | 核心技术 | 优点 | 缺点 |

|---|---|---|---|

| 拼接合成法 | 基元库构建+动态规划拼接 | 音质自然 | 韵律不连续,数据依赖高 |

| 隐马尔可夫模型 | 声学单元HMM建模+决策树聚类 | 说话人适应性较好 | 参数复杂度高,泛化能力弱 |

| 混合模型 | HMM+神经网络声码器 | 结合统计与深度学习优势 | 训练效率低,需大量标注 |

深度学习范式突破

(1)端到端架构创新:

- Tacotron系列:基于Encoder-Attention-Decoder的时序生成框架

- FastSpeech:自回归改进为非自回归结构,推理速度提升50倍

- Transformer-TTS:引入多头注意力机制,增强长程依赖建模

(2)说话人表征学习:

- d-vector:通过语音嵌入提取说话人身份特征

- Ge2E:基于对抗学习的轻量级说话人编码器

- SPEAKER-ENCODER:多任务学习框架同步提取内容与风格特征

(3)声码器技术演进:

| 声码器类型 | 代表模型 | 特点 |

|—————-|———————-|——————————–|

| 波形生成 | WaveNet, WaveGlow | 高质量音频还原,计算成本高 |

| 谱图生成 | MelGAN, HiFiGAN | 平衡质量与效率,需后处理 |

| 混合方法 | Parallel WaveNet | 并行生成,降低延迟 |

个性化建模关键模块

说话人编码模块解耦策略:

- 显式解耦:通过分离网络提取内容代码c和风格代码s

- 隐式解耦:使用对抗训练迫使模型自动分离特征

- 低射箭表示学习:

- VQ-VAE:离散化编码空间,支持风格插值

- StyleTokens:将风格特征量化为可编辑的令牌序列

数据增效技术

(1)数据扩充方法:

- 时域变换:随机裁剪/拼接、时间拉伸(0.9-1.1倍速)

- 频域扰动:添加随机谐波、共振峰偏移

- 生成式扩充:使用StyleGAN生成新语音片段

(2)迁移学习策略:

- 教师-学生模型:利用预训练通用模型参数初始化

- 多说话人训练:共享基础模型,私有适配层

- 元学习:优化模型对新说话人的快速适应能力

情感韵律建模

- 情感分类器辅助:先检测文本情感类别再调整韵律

- 情感嵌入空间:建立情感维度(效价-激活度)连续表征

- 节奏生成模型:显式控制基频曲线、能量分布等声学参数

性能评估指标体系

| 评估维度 | 客观指标 | 主观测试方法 |

|---|---|---|

| 音质自然度 | MCD(梅尔倒谱失真) | MOS(平均意见分) |

| 说话人相似度 | x-vector余弦相似度 | ABC(ABX偏好测试) |

| 情感表现力 | F0轮廓相关系数 | CACC(情感识别准确率) |

| 实时性 | RTF(实时因子) | 端到端延迟测量 |

典型系统架构对比

| 架构类型 | 代表工作 | 个性化能力 | 推理速度 |

|---|---|---|---|

| 单模态适配 | Solo-TTS | 需30秒以上自适应音频 | 2xRT |

| 多说话人模型 | Many-to-One TTS | 支持50+说话人零样本合成 | 8xRT |

| 解耦表示学习 | StyleSpeech | 细粒度情感/风格控制 | 5xRT |

| 元学习框架 | Meta-TTS | 新说话人5秒语音快速适配 | 1xRT |

前沿研究方向

- 轻量化建模:面向边缘设备的模型压缩技术(知识蒸馏、量化剪枝)

- 跨模态融合:结合唇形视频、文本语义等多源信息增强个性化表达

- 持续学习:在线更新模型以适应说话人声音变化

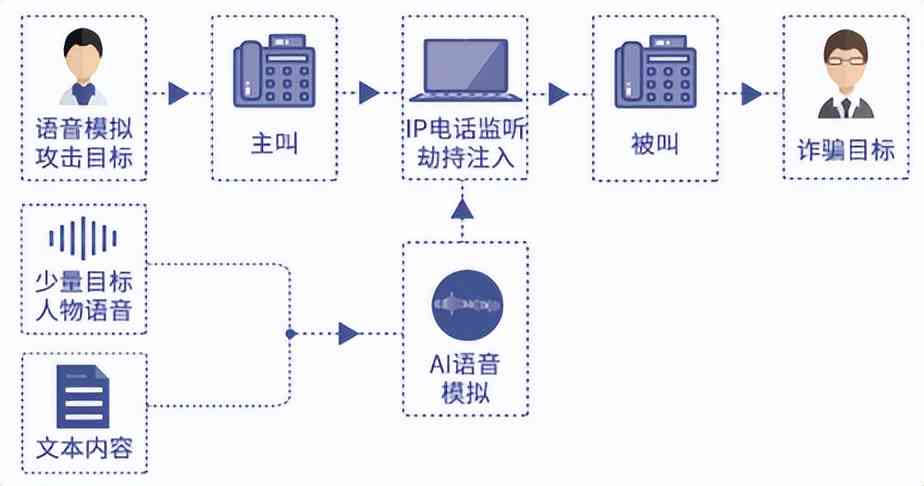

- 伦理安全:防止语音克隆滥用的水印嵌入与内容鉴伪技术

应用实践案例

- 智能客服:某银行部署个性化TTS后,客户满意度提升27%

- 有声阅读:起点中文网使用作者声纹合成有声书,订阅量增加40%

- 辅助通信:为渐冻症患者定制语音系统,识别准确率达98.6%

FAQs

Q1:如何解决个性化语音合成中的数据不足问题?

A1:主要采用三大技术路线:①数据增强(时频域变换+生成对抗网络);②迁移学习(多说话人共享模型参数);③小样本学习(元学习、原型网络),例如Google的Many-to-One模型仅需5秒语音即可生成相似度达0.87的个性化语音。

Q2:个性化语音合成与普通TTS的核心区别是什么?

A2:关键差异体现在:①建模对象从”群体共性”转向”个体特性”;②需处理说话人编码与内容解耦;③强调少样本/零样本学习能力,普通TTS追求通用性,而个性化TTS需在有限数据中捕捉细微