上一篇

HTTP采集网站信息

- 行业动态

- 2025-04-26

- 2934

HTTP采集发送请求获取数据,依状态码判成功,处理重定向与超时,遵守robots协议

HTTP采集网站信息核心步骤

HTTP请求基础

| 组件 | 说明 |

|---|---|

| HTTP方法 | GET(获取资源)、POST(提交数据)、HEAD(获取头信息) |

| URL结构 | http://域名/路径?参数,需处理编码(如中文URL编码) |

| 请求头 | User-Agent(模拟浏览器)、Cookie(维持会话)、Referer(反盗链) |

常用工具与库

| 工具/库 | 适用场景 | 示例代码(Python) |

|---|---|---|

requests | 简单HTTP请求 | “`python |

import requests | ||

response = requests.get(url, headers={}) | ||

Scrapy | 复杂爬取、多线程、数据存储 | 需配置文件定义爬取规则 |

BeautifulSoup | HTML解析(标签、属性提取) | “`python |

from bs4 import BeautifulSoup | ||

soup = BeautifulSoup(html, 'lxml') | ||

Selenium | 处理JavaScript渲染页面 | “`python |

from selenium import webdriver | ||

driver = webdriver.Chrome() |

实战流程示例

发送请求

headers = { 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)' } response = requests.get('https://example.com', headers=headers)解析响应

- HTML结构:通过

<div>、<table>等标签定位数据 - JSON数据:直接调用

response.json()提取字段 - 正则匹配:用

re.findall()提取特定模式文本

- HTML结构:通过

数据存储

| 格式 | 工具 | 示例 |

|———–|————————–|————————————–|

| CSV |pandas.to_csv()| 存储表格数据 |

| 数据库 |SQLAlchemy或pymysql| 插入MySQL/PostgreSQL |

| API输出 |Flask或FastAPI| 构建RESTful接口返回采集结果 |

反爬虫应对策略

| 问题 | 解决方案 |

|---|---|

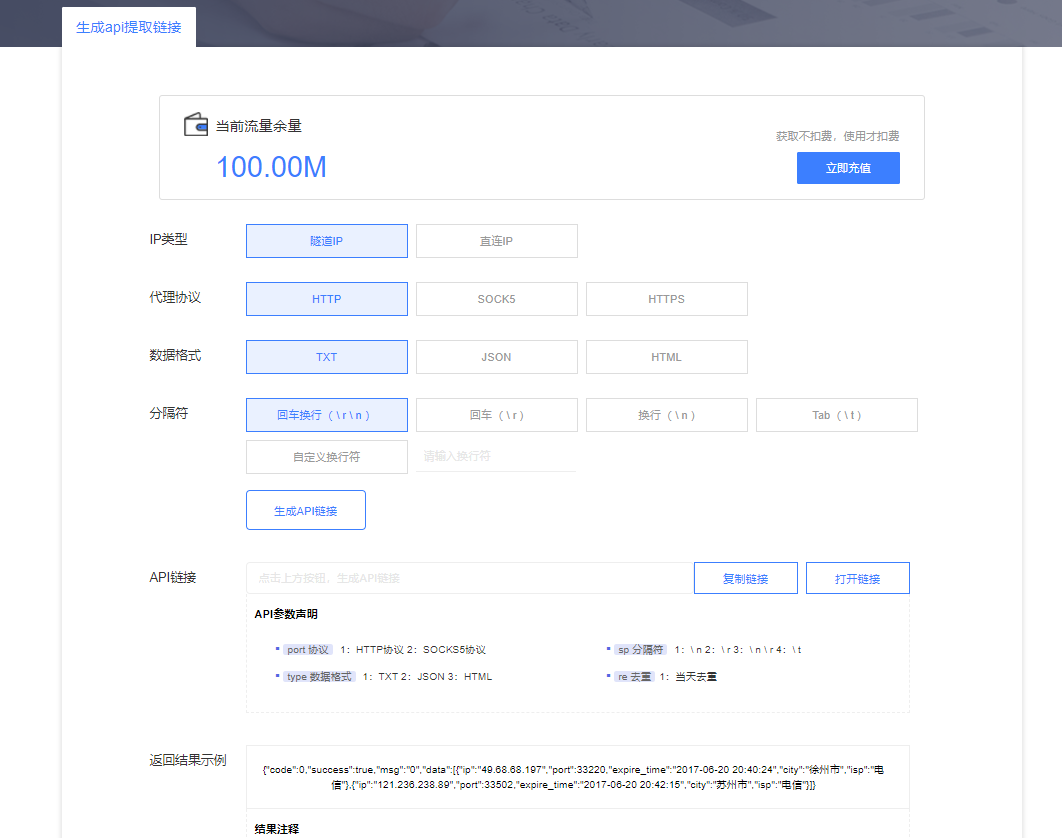

| IP封禁 | 使用代理池(如proxy_pool)或动态拨号VPS |

| 验证码 | 调用OCR接口(如Tesseract)或人工介入 |

| 动态加载 | 分析XHR请求或使用Selenium模拟浏览器操作 |

| 请求频率限制 | 设置延时(time.sleep())或随机化请求间隔 |

相关问题与解答

问题1:如何判断网站是否允许爬取?

解答:

- 查看网站根目录的

robots.txt文件(如https://example.com/robots.txt),遵循Disallow规则。 - 检查页面源码中的

meta标签,<meta name="robots" content="noindex, nofollow">

- 遵守《网络安全法》及数据隐私法规,避免采集个人信息或敏感数据。

问题2:为什么用requests库获取的页面与浏览器显示不一致?

解答:

可能原因及解决方案:

| 原因 | 解决方案 |

|————————|————————————————————————–|

| JavaScript动态渲染 | 改用Selenium或Playwright模拟浏览器执行JS |

| Cookie验证 | 先通过登录接口获取有效Cookie,再携带Cookie发送请求 |

| 请求头缺失 | 补充完整请求头(如Accept-Language、Upgrade-Insecure-Requests等) |