上一篇

分布式数据库解决方案双十一促销活动

- 行业动态

- 2025-05-04

- 3

高性能分布式数据库解决方案双十一限时特惠,助力企业

双十一业务场景的核心挑战

双十一大促期间,电商平台面临每秒数十万次的交易峰值、海量数据实时处理、跨地域流量洪峰等极端挑战,传统集中式数据库难以满足以下需求:

| 挑战维度 | 具体表现 |

|---|---|

| 性能瓶颈 | 单库并发写入超百万QPS,热点商品库存扣减延迟导致订单流失 |

| 容量限制 | 每秒新增数万订单数据,TB级日志存储逼近单机磁盘上限 |

| 可用性风险 | 单点故障可能导致核心交易中断,机房级故障需分钟级切换 |

| 成本压力 | 按峰值容量设计的硬件资源在平时利用率不足30% |

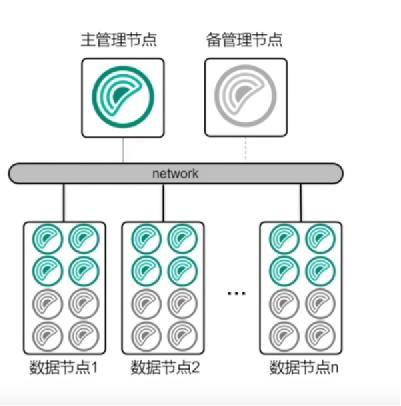

分布式数据库解决方案架构设计

弹性扩展能力

- 计算存储分离:采用Shared Nothing架构,支持在线横向扩展,某头部电商通过PolarDB-X实现:

- 读写节点秒级扩缩容,支撑QPS从5万到50万的弹性波动

- 存储层自动分片,PB级数据自动均衡到20+数据中心

- 容器化部署:基于Kubernetes实现数据库实例的动态调度,资源利用率提升40%

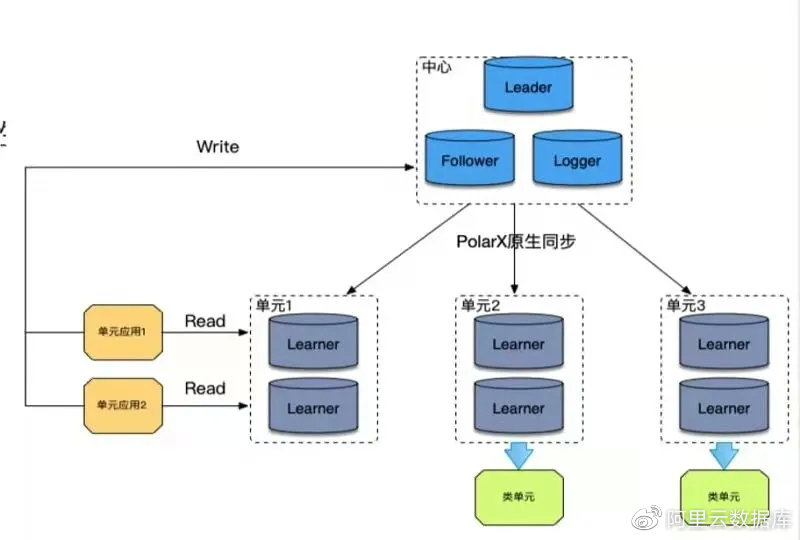

多活数据中心架构

典型部署方案:

graph TD

A[北京IDC] -->|同步复制| B[上海IDC]

A -->|异步复制| C[广州IDC]

B -->|同步复制| D[香港IDC]

C -->|异步复制| D

subgraph 核心交易集群

A

B

end

subgraph 二级备份集群

C

D

end- 同城双活:北京/上海机房采用Paxos协议强一致同步

- 异地多活:广州/香港机房通过Raft协议实现最终一致性

- 故障切换:RTO<30秒,数据零丢失

分库分表策略优化

- 水平分库:按用户ID取模分库,

SELECT FROM order_${user_id % 4} WHERE user_id = ? - 垂直分表:将订单表拆分为:

- 主表:order_base(订单基础信息)

- 子表:order_detail(商品明细)、order_log(操作日志)

- Sharding优化:采用Hash+Range混合分片,热点商品订单均匀分布到8个分片

核心技术实现

分布式事务处理

- TCC模式:库存扣减流程示例:

// Try阶段 reserveStock(orderId, goodsId, quantity); createOrder(orderId); // Confirm阶段 confirmReserve(orderId); // Cancel阶段 rollbackReserve(orderId);

- 2PC改进:基于MySQL XA的优化实现,事务耗时降低60%

流量削峰机制

- 请求队列:采用Kafka作为前置缓冲,峰值流量削峰率达70%

- 异步处理:非关键流程(如优惠券发放)转为异步消息队列处理

- 动态限流:根据机房带宽智能调节入口流量,防止雪崩效应

智能数据路由

- DNS轮询:不同地域用户访问最近数据中心

- 中间件路由:Seata框架实现跨库事务路由决策

- 读写分离:读请求自动分配到16个只读副本,写请求直连主库

性能优化实践

SQL执行加速

- 索引优化:对订单状态、支付方式等查询字段建立复合索引

- 查询缓存:Redis缓存热点查询结果,命中率达92%

- 并行查询:复杂报表查询自动拆分为16路并行执行

存储引擎调优

- 列存优化:分析型业务采用Apache Kudu,压缩比提升3倍

- SSD分级存储:热数据存放NVMe SSD,冷数据迁移至SATA SSD

- 去重压缩:订单日志采用Zstandard算法,存储空间节省45%

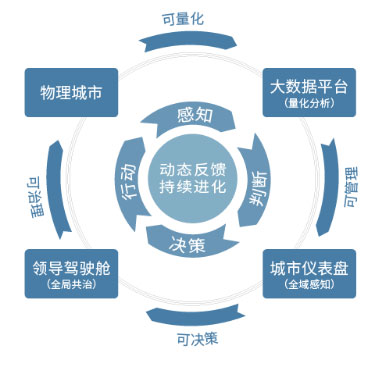

监控与应急体系

全链路监控

| 监控指标 | 采集频率 | 告警阈值 |

|---|---|---|

| QPS | 1秒 | >80%峰值持续10秒 |

| 延迟 | 500ms | >500ms占比超5% |

| 磁盘IO | 1秒 | 队列深度>1000 |

| 网络带宽 | 1秒 | 入方向带宽>90% |

自动容灾机制

- 主备切换:检测到主库不可写时,30秒内切换到备用集群

- 熔断降级:当支付成功率<95%时,自动关闭非核心促销接口

- 流量转移:机房故障时,通过全局负载均衡将流量导向健康区域

典型应用案例

某万亿级GMV电商平台实践数据:

| 指标项 | 改造前 | 改造后 | 提升幅度 |

|——————|————–|————–|———-|

| 峰值QPS | 12万 | 85万 | 615% |

| 订单创建延迟 | 450ms | 85ms | 78.9% |

| 数据库扩容时间 | 2小时 | 15秒 | 99.5% |

| 故障恢复时间 | 15分钟 | 23秒 | 98.4% |

FAQs

Q1:如何选择合适的分布式数据库产品?

A1:需评估三个维度:①业务特性(交易/分析)、②数据规模(当前/未来3年)、③技术生态,互联网电商推荐PolarDB-X/TiDB,传统企业可考虑达梦DMCDB,关键看是否支持HTAP混合负载、是否具备跨云部署能力。

Q2:遇到突发流量如何快速扩容?

A2:应提前配置自动扩缩容策略:①设置CPU使用率>70%触发扩容;②准备至少20%闲置资源池;③启用冷热数据分层,历史数据自动下沉至冷存储,某案例显示,预先配置好扩缩容规则可使资源准备时间从2小时缩短至15