上一篇

hive视频

- 行业动态

- 2025-05-06

- 2201

Hive是大数据处理工具,支持SQL查询,学习视频可参考B站、慕课网等平台,涵盖基础操作、优化技巧及实战案例,助快速掌握分布式数据处理技能

Hive技术详解与实战应用指南

Hive核心概念解析

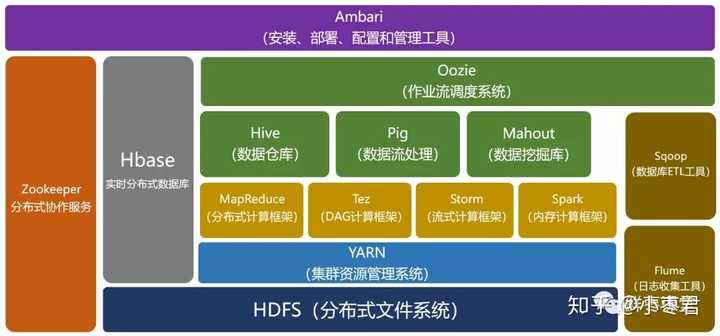

Apache Hive是基于Hadoop的数据仓库工具,通过类SQL语法(HiveQL)实现对大规模数据的存储、计算和管理,其核心架构包含以下组件:

| 组件 | 功能说明 |

|---|---|

| Driver | 编译执行计划,包含编译器、优化器、执行器 |

| Metastore | 元数据管理(表结构/分区信息等),默认使用内嵌Derby数据库,可对接MySQL/PostgreSQL |

| Thrift Server | 提供JDBC/ODBC接口服务 |

| Execution Engine | 任务执行引擎,支持MapReduce、Tez、Spark等多种计算框架 |

关键特性对比表:

| 特性 | 传统数据仓库 | Hive |

|---|---|---|

| 数据规模 | TB级 | PB级 |

| 扩展性 | 垂直扩展 | 水平扩展 |

| 开发成本 | 高(专有系统) | 低(SQL兼容) |

| 实时性 | 高(OLTP) | 低(批处理) |

环境部署全流程

前置条件

- Hadoop集群(2.x+版本)

- JDK1.8+

- MySQL(推荐5.7+)用于Metastore

配置要点

# hive-site.xml核心配置 <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://metastore_host:3306/hive_metastore</value> </property> <property> <name>hive.execution.engine</name> <value>mr</value> <!-可选tez/spark --> </property>

元数据库初始化

# 创建Metastore数据库 mysql -uroot -p -e "CREATE DATABASE hive_metastore;" # 授权用户 GRANT ALL ON hive_metastore. TO 'hiveuser'@'%' IDENTIFIED BY 'hivepass';

核心操作实战

数据存储管理

-创建分区表 CREATE TABLE user_logs ( uid STRING, event STRING, timestamp BIGINT ) PARTITIONED BY (dt STRING) STORED AS ORC; -动态分区加载 LOAD DATA INPATH '/data/logs/' INTO TABLE user_logs PARTITION (dt='2023-10-01');

复杂查询示例

-窗口函数分析用户行为 SELECT uid, event, COUNT(event) OVER (PARTITION BY uid ORDER BY timestamp ROWS BETWEEN 2 PRECEDING AND CURRENT ROW) AS event_chain FROM user_logs WHERE dt='2023-10-01';

性能调优策略

| 优化方向 | 实施方法 |

|——————-|————————————————————————–|

| 数据存储 | 使用ORC格式+Snappy压缩,开启BloomFilter减少IO |

| 计算引擎 | 切换Tez/Spark提升执行效率(配置hive.execution.engine=tez) |

| SQL优化 | 避免全表扫描,合理使用分区裁剪,控制UDF使用 |

| 资源配置 | 调整mapreduce.reduce.memory.mb等参数,启用CBO优化器 |

企业级应用场景

用户行为分析

- 日志聚合:收集APP/Web埋点数据

- 路径分析:计算用户行为转化漏斗

- 留存分析:构建用户生命周期价值模型

业务报表生成

- 销售看板:按地区/时间维度统计GMV

- 库存分析:预测商品周转率

- 财务审计:生成合规性数据报告

数据管道集成

- 与Kafka集成:实时消费业务日志

- 与Spark集成:构建混合处理流程(批+流)

- 与BI工具对接:Tableau/PowerBI直连Hive数据源

常见问题解决方案

Metastore连接异常

- 症状:

java.sql.SQLException: Access denied for user - 解决:检查MySQL用户权限,确保

hiveuser具有ALL PRIVILEGES权限

小文件过多问题

- 影响:Map任务数量激增,Job跟踪开销大

- 方案:设置

hive.merge.mapfiles=true,使用HIVE_MERGE_SIZE参数控制合并阈值

FAQs

Q1:Hive是否支持ACID事务?

A1:自Hive 0.14版本开始支持ACID特性,需满足以下条件:

- 使用ORC/Parquet列式存储格式

- 开启事务配置:

SET hive.support.concurrency=true - 表属性设置:

TBLPROPERTIES ('transactional'='true')

注意:ACID操作会产生额外写开销,建议在关键业务场景使用。

Q2:如何监控Hive作业执行情况?

A2:可通过以下方式进行监控:

- Web界面:访问Hadoop JobHistory Server(默认端口19888)

- 命令行:使用

hive --auxpath加载增强工具包,执行show job查看进度 - 日志分析:检查YARN/MapReduce日志文件(通常位于

/var/log/hadoop-yarn) - 集成监控:接入Prometheus+Grafana,配置Hive J