上一篇

hive选择一个数据库

- 行业动态

- 2025-05-06

- 3

在Hive中切换数据库用

USE database_name;,查看现有库用 SHOW DATABASES;,创建新库则执行`CREATE DATABASE

Hive选择数据库的核心考量与实践指南

Hive数据库选择的核心要素

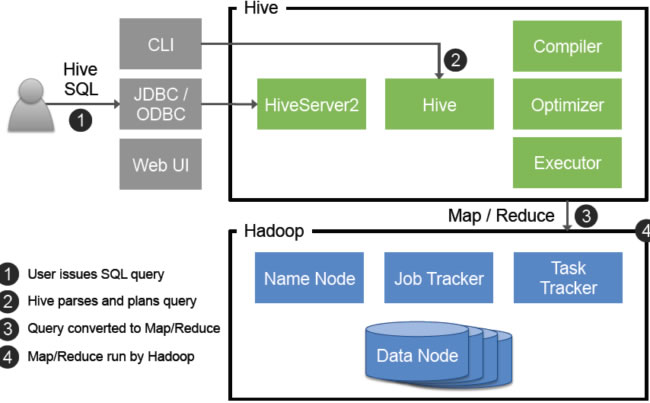

Hive作为大数据领域的事实标准SQL引擎,其数据库(Database)选择直接影响数据管理效率、查询性能和系统可维护性,以下从六个维度解析关键决策要素:

| 维度 | 评估要点 |

|---|---|

| 存储架构 | 内部表/外部表选择、存储格式(Text/Parquet/ORC)、压缩算法(Snappy/Zlib) |

| 性能指标 | 数据规模(TB/PB级)、查询延迟、并发处理能力 |

| 元数据管理 | 命名规范、权限体系、跨集群同步需求 |

| 业务特性 | 数据生命周期(热/温/冷数据)、更新频率、ACID需求 |

| 生态兼容 | 与BI工具(Tableau/PowerBI)、计算引擎(Spark/Presto)的集成 |

| 运维成本 | 存储扩容方案、元数据备份策略、权限管理复杂度 |

存储架构决策矩阵

内部表 vs 外部表

内部表:Hive完全管理生命周期,删除表会清除数据

外部表:仅管理元数据,数据由外部系统维护,适合共享存储场景

| 场景 | 推荐类型 | 典型应用 |

|---|---|---|

| 原始日志采集 | 外部表 | HDFS目录共享给Flume/Logstash |

| ETL中间结果存储 | 内部表 | 每日清洗任务临时存储 |

| 长期归档数据 | 外部表 | 多计算引擎共享基础数据集 |

存储格式选型

| 格式 | 优势 | 适用场景 |

|---|---|---|

| Text | 通用性强,调试方便 | 小规模测试、非结构化数据 |

| Parquet | 列式存储,高压缩比 | OLAP分析、交互式查询 |

| ORC | 优化写入性能,支持复杂类型 | 大规模ETL、频繁查询场景 |

| Avro | Schema演化支持 | 日志流式处理 |

性能对比实验:某电商日志分析场景中,ORC格式比Text格式查询速度提升4.2倍,存储节省68%

性能优化关键策略

分区设计原则

- 粒度控制:日期分区(ds=YYYYMMDD)适用于日志类数据,地区分区(region)适合地理维度分析

- 层级组合:

year=2023/month=08/day=15三级分区比单日分区查询效率提升30% - 动态分区:INSERT语句配合

PARTITION(dt)实现自动化分区,需注意开启hive.exec.dynamic.partition

桶(Bucket)策略

- 哈希桶:均匀分布数据,适合JOIN操作优化

- 采样桶:按业务字段取模,例如用户ID%10实现负载均衡

- 注意事项:桶数量需与集群并行度匹配,建议取节点数×2的倍数

元数据管理实践

命名规范体系

-推荐命名规则 db_name = lower_case_letters + underscores table_name = plural_nouns (e.g. user_events, order_details) partition_name = dt/hr/province 等明确语义字段

权限管理方案

| 权限类型 | 适用场景 | 实现方式 |

|---|---|---|

| 读权限 | 数据分析团队 | GRANT SELECT ON TABLE |

| 写权限 | ETL作业账户 | GRANT INSERT, DROP |

| 所有权转移 | 项目交接 | REVOKE + GRANT组合操作 |

企业级方案:集成Ranger/Apache Sentry实现细粒度权限控制,支持LDAP同步用户体系

典型业务场景决策树

实时日志分析

- 选择外部表 + Parquet格式

- 按小时分区,创建8个桶(对应服务器数量)

- 开启ORC文件的BloomFilter优化

历史数据归档

- 使用内部表管理生命周期

- 采用Snappy压缩降低存储成本

- 按年月两级分区,关闭自动清理

机器学习训练集

- 混合存储:特征表用ORC,原始样本用Avro

- 添加分区剪裁(Partition Pruning)优化

- 配置向量查询加速(Vectorized Execution)

常见误区与规避方案

| 错误做法 | 后果 | 解决方案 |

|---|---|---|

| 过度分区(超过10k个) | 元数据加载缓慢 | 合并小分区,使用二级分区 |

| 单一RCFile格式 | 压缩效率低,读取速度慢 | 迁移至Parquet/ORC |

| 忽略ACID属性 | 并发写入导致数据不一致 | 启用事务表(TBLPROPERTIES) |

| 未设置合理的TTL | 存储成本失控 | 配置Hive生命周期策略 |

性能调优检查清单

参数配置

mapreduce.job.reduces:根据数据量动态调整(默认1→调整为COW数量×1.5)hive.exec.parallel:开启多线程执行(0→true)hive.vectorized.execution:启用向量化执行(false→true)

索引优化

- Bitmap索引:适合低基数字段(状态、类型)

- BloomFilter:减少IO扫描量(ORC文件自动支持)

资源隔离

- YARN队列配置:为Hive查询分配专用资源池

- 内存优化:

mapreduce.map.memory.mb≥4G(处理大分区)

跨集群数据迁移方案

| 场景 | 工具选择 | 注意事项 |

|---|---|---|

| 同版本Hive迁移 | DistCp + Metadata导出导入 | 保持序列化格式一致 |

| 跨版本升级迁移 | Apache Falcon数据流水线 | 验证ACID表兼容性 |

| 异构系统迁移 | Sqoop + Hive DDL重构 | 处理NULL值转换差异 |

监控与维护体系

健康检查指标

- 元数据锁等待时间(>1min需预警)

- 分区目录数量(超过5k触发自动清理)

- 文件碎片率(小文件占比>30%需合并)

自动化运维脚本

# 清理30天前的分区 hive -e "ALTER TABLE logs DROP IF EXISTS PARTITION(dt='2023-06-01')" # 合并小文件 hadoop fs -mkdir /user/hive/warehouse/merged_data hive --hiveconf mapred.reduce.tasks=200 -f merge_small_files.sql

FAQs

Q1:如何将现有数据库迁移到新的Hive实例?

A1:步骤如下:

- 使用

USE db_name切换目标数据库 - 导出元数据:

hive -e "SHOW CREATE TABLE table_name" > ddl.sql - 导出表数据:

INSERT OVERWRITE DIRECTORY '/backup/' SELECT FROM table_name - 在新集群创建相同结构的空表

- 使用DistCp复制HDFS数据:

distcp -p etl_base_dir new_cluster:/path - 验证数据完整性:

ANALYZE TABLE table_name COMPUTE STATISTICS

Q2:如何限制特定用户只能访问某个数据库?

A2:通过Hive权限体系实现:

- 创建专用角色:

CREATE ROLE report_users - 授予数据库权限:

GRANT ALL ON PROJECT.db_report TO ROLE report_users - 绑定用户到角色:

GRANT ROLE report_users TO USER john_doe - 验证权限:`SHOW GRANTS USER john_do