上一篇

GPU服务器能否显著提升你的业务运行效率?

- 行业动态

- 2025-05-01

- 4

GPU服务器是一种配备高性能图形处理器的计算设备,专注于加速并行计算任务,广泛应用于深度学习训练、科学模拟、图像渲染及大数据分析等领域,其强大的浮点运算能力与多核架构可显著提升复杂算法处理效率,支持多卡协同工作,适用于需要高吞吐量与低延迟的计算场景。

GPU服务器:驱动智能时代的算力引擎

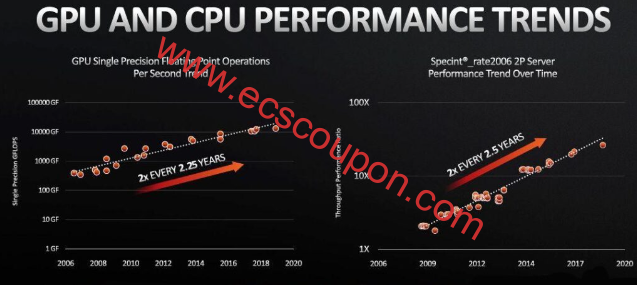

在人工智能、大数据分析、科学计算等领域高速发展的今天,传统CPU服务器的算力已难以满足复杂任务的需求。GPU服务器凭借其并行计算能力与高性能架构,成为企业、科研机构及开发者的核心工具,本文将从技术原理、应用场景、选型建议等维度,全面解析GPU服务器的价值与未来趋势。

什么是GPU服务器?

GPU服务器是搭载图形处理器(GPU)的高性能计算设备,与传统CPU服务器不同,GPU服务器通过数千个计算核心实现大规模并行计算,特别适合处理以下任务:

- 密集型计算:如深度学习模型训练、科学模拟(气候预测、流体力学)。

- 图形渲染:影视特效、3D建模、游戏开发。

- 实时数据处理:金融高频交易、物联网数据分析。

以NVIDIA A100 GPU为例,其单卡可提供每秒312万亿次浮点运算(FP32),远超CPU的算力极限。

GPU服务器的核心优势

- 算力飞跃

GPU的并行架构可同时处理数万个线程,加速训练时间,训练ResNet-50模型时,GPU服务器耗时仅为CPU的1/10。 - 能效比优化

GPU在相同功耗下提供更高算力,降低数据中心运营成本。 - 灵活性扩展

支持多卡互联(如NVIDIA NVLink),轻松扩展算力集群,满足超大规模计算需求。

GPU服务器的应用场景

- 人工智能与深度学习

- 自然语言处理(NLP):如ChatGPT等大模型训练。

- 计算机视觉:人脸识别、自动驾驶算法开发。

- 科学计算与仿真

- 生物医药:蛋白质结构预测、药物分子模拟。

- 能源勘探:地震数据处理、油藏建模。

- 云游戏与元宇宙

实时渲染高画质游戏画面,支持低延迟流媒体传输。

- 金融科技

高频交易策略优化、风险建模与实时分析。

如何选择适合的GPU服务器?

- 明确需求

- 训练场景:选择显存大、支持多卡互联的型号(如NVIDIA H100)。

- 推理场景:注重能效比,可选T4或A2等低功耗GPU。

- 硬件配置

- GPU型号:根据框架兼容性选择(如TensorFlow对Ampere架构优化更佳)。

- CPU与内存:需与GPU算力匹配,避免瓶颈。

- 存储与网络:NVMe SSD和高速网络(如100Gbps InfiniBand)提升数据吞吐效率。

- 软件生态

支持CUDA、ROCm等开发环境,兼容主流AI框架(PyTorch、TensorFlow)。

GPU服务器的未来趋势

- 异构计算普及

CPU+GPU+DPU协同架构将成为数据中心标配,提升整体效率。 - 绿色算力

液冷技术、低功耗芯片设计(如NVIDIA Grace Hopper)推动可持续发展。 - 云服务集成

公有云厂商(AWS、阿里云)提供弹性GPU实例,降低企业使用门槛。

维护与优化建议

- 定期更新驱动:确保兼容最新算法框架。

- 监控温度与功耗:避免过热导致性能降频。

- 分布式训练优化:使用Horovod、NCCL库提升多卡并行效率。

引用说明

本文数据与案例参考自:

- NVIDIA官方技术白皮书(2025)

- IDC《全球AI基础设施市场报告》

- TOP500超算榜单性能分析

通过科学选型与高效部署,GPU服务器将成为企业数字化转型的核心引擎,如需进一步了解行业解决方案,欢迎联系专业服务商获取定制化支持。