GPU服务器UDP通信失败如何快速排查与解决

- 行业动态

- 2025-04-23

- 2

GPU服务器UDP协议不通的常见原因包括:防火墙或安全组拦截UDP端口、服务器未正确绑定监听端口、网络路由或交换机配置错误、UDP缓冲区溢出、操作系统内核参数限制,或应用层未正确处理UDP数据包,可通过逐层排查网络配置与服务状态定位问题。

GPU服务器UDP不通过的可能原因及解决方案

当用户在GPU服务器上遇到UDP协议通信失败的问题时,通常需要从多个层面进行排查,UDP(用户数据报协议)是一种无连接的传输层协议,其特点是高效但不可靠,若出现UDP不通的情况,可能与网络配置、系统设置、硬件性能或应用程序本身相关,以下是常见原因及对应解决方案:

网络配置问题

防火墙或安全组限制

大多数云服务器的安全组或本地防火墙默认仅开放TCP协议,UDP端口需手动配置。

解决方案:- 检查服务器防火墙规则(如

iptables、firewalld或云平台安全组),确认UDP端口已放行。 - 使用命令

nc -vz -u <IP> <端口>测试UDP连通性。

- 检查服务器防火墙规则(如

网络设备过滤

路由器、交换机或负载均衡器可能配置了ACL(访问控制列表),阻止UDP流量。

解决方案:联系网络管理员检查中间设备配置,确认UDP流量未被过滤。

MTU与分片问题

UDP数据包超过网络MTU(最大传输单元)时会被分片,部分网络设备可能丢弃分片包。

解决方案:- 调整应用程序发送的数据包大小,确保不超过MTU(通常为1500字节)。

- 使用

ping -M do -s <大小> <IP>测试分片是否正常。

服务器硬件与驱动问题

网卡性能瓶颈

GPU服务器通常用于高并发场景(如深度学习训练),若网卡带宽不足或队列过载,可能导致UDP丢包。

解决方案:- 升级万兆(10Gbps)或更高带宽网卡。

- 通过

ethtool -S <网卡名>查看丢包统计,优化数据发送频率。

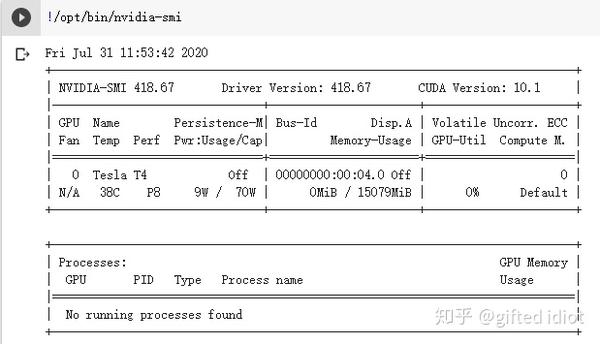

GPU驱动或固件不兼容

部分GPU型号的固件可能因版本过低导致与网络模块冲突。

解决方案:- 更新GPU驱动和服务器主板固件至最新版本。

- 检查系统日志(

dmesg或/var/log/messages)是否有硬件报错。

操作系统与内核参数

Socket缓冲区溢出

UDP通信依赖内核的接收/发送缓冲区,若缓冲区过小,高负载时可能丢包。

解决方案**:- 修改内核参数,增大缓冲区:

sysctl -w net.core.rmem_max=26214400 sysctl -w net.core.wmem_max=26214400

- 在应用程序中设置更大的Socket缓冲区。

- 修改内核参数,增大缓冲区:

端口绑定冲突

多个进程可能竞争同一UDP端口,导致数据无法接收。

解决方案:- 使用

netstat -anu | grep <端口>查看端口占用情况,终止冲突进程。

- 使用

应用程序问题

代码逻辑错误

程序未正确绑定端口、未处理ICMP错误(如“Port Unreachable”)或未启用多线程接收数据。

解决方案:- 使用抓包工具(如

tcpdump或Wireshark)分析数据流向。 - 捕获命令示例:

tcpdump -i eth0 udp port <端口> -vvv

- 使用抓包工具(如

权限不足

非特权用户可能无法绑定1024以下端口。

解决方案:- 以root权限运行程序,或使用

setcap授予端口绑定权限:setcap cap_net_bind_service=+ep /path/to/program

- 以root权限运行程序,或使用

外部环境干扰

DDoS防御机制误判

云服务商或本地网络若启用UDP Flood防护,可能误拦截正常流量。

解决方案:联系服务商调整防护策略,或降低UDP发包速率。

ISP或跨境延迟

跨境网络链路可能因政策或拥塞导致UDP丢包。

解决方案:- 通过

traceroute -n -u <目标IP>追踪路由,联系ISP优化链路。

- 通过

总结排查流程

- 基础检查:确认IP、端口、防火墙配置正确。

- 抓包分析:验证数据是否到达服务器或客户端。

- 系统调优:调整内核参数、硬件配置和程序代码。

- 环境验证:更换网络链路或测试节点,排除外部干扰。

引用说明

- Linux内核参数调优参考:Red Hat Documentation

- UDP协议RFC标准:RFC 768

- 云服务器安全组配置:阿里云安全组设置