上一篇

GBDT算得上真正的深度学习算法吗

- 行业动态

- 2025-04-25

- 3693

GBDT(梯度提升决策树)是一种集成学习算法,而非深度学习技术,它通过迭代训练多个弱决策树模型,利用梯度下降优化残差,逐步提升预测精度,擅长处理结构化数据任务,深度学习则基于多层神经网络自动提取特征,适用于图像、语音等高维非结构化数据,二者在模型架构与适用场景上存在本质差异。

GBDT是一种深度学习算法吗?

在机器学习领域,GBDT(Gradient Boosting Decision Tree,梯度提升决策树)因其高效的预测能力和广泛的应用场景而备受关注,许多人误将其归类为深度学习算法,本文将详细解析GBDT的技术原理、深度学习的核心特点,以及两者的本质区别,帮助读者清晰理解这一话题。

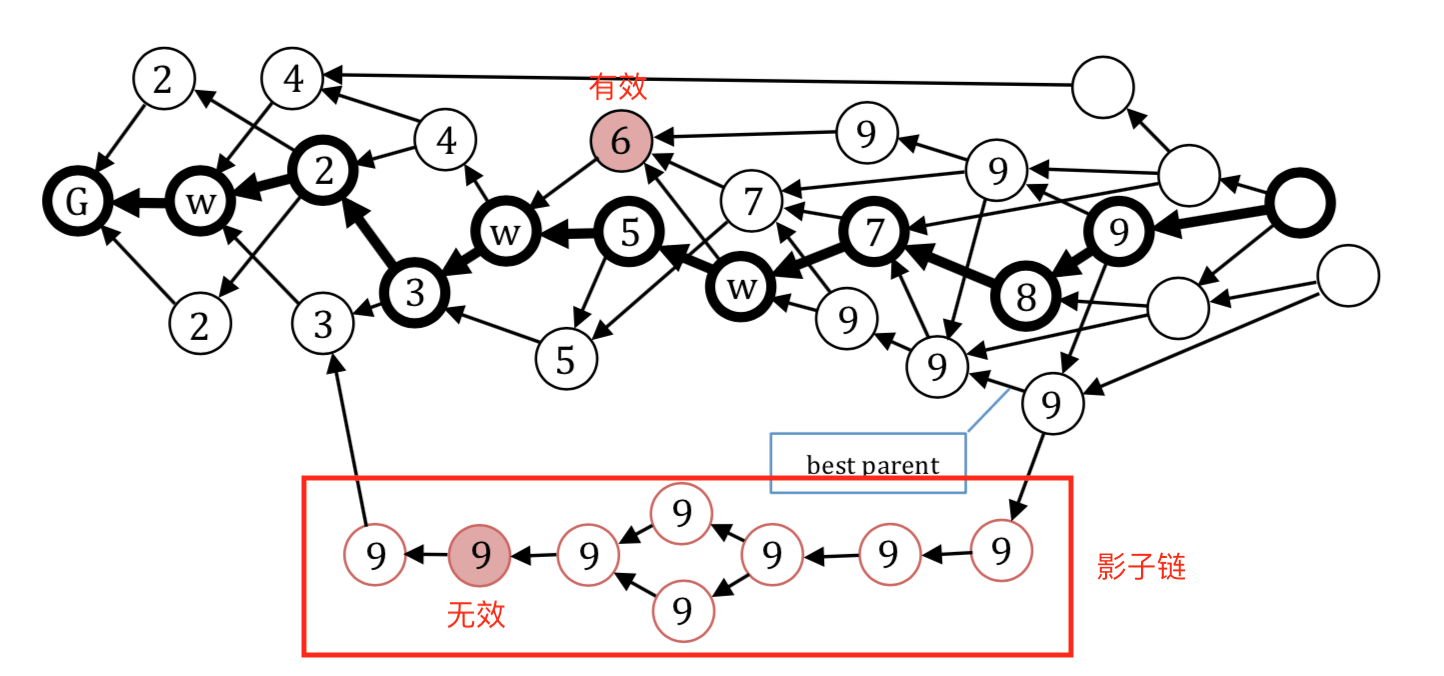

GBDT的核心原理

GBDT是一种基于决策树的集成学习算法,其核心思想是通过梯度提升(Gradient Boosting)逐步优化模型的预测能力。

- 决策树基础:GBDT使用回归树或分类树作为基学习器,每一棵树通过迭代的方式修正前一棵树的预测误差。

- 梯度优化:通过计算损失函数的负梯度(即残差),不断调整模型参数,使整体预测结果逼近真实值。

- 集成学习框架:通过多棵树的加权组合,实现模型的高精度和强泛化能力。

GBDT的代表性实现包括XGBoost、LightGBM和CatBoost,这些工具在结构化数据(如表格数据)的预测任务中表现尤为突出。

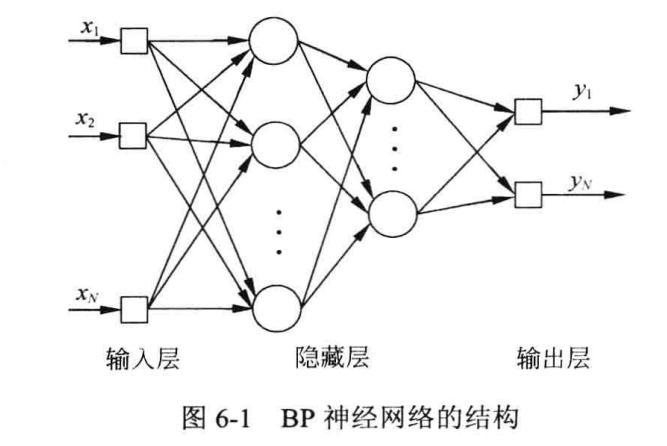

深度学习的定义与特点

深度学习是机器学习的一个子领域,其核心是多层神经网络,深度学习的特点包括:

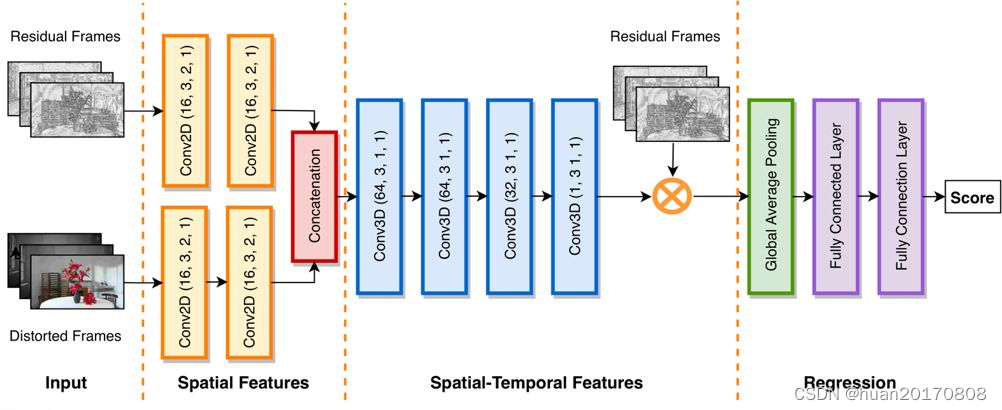

- 端到端学习:通过多层非线性变换直接学习输入到输出的映射关系。

- 自动特征提取:深度模型能够从原始数据(如图像、文本)中自动提取高层次特征,无需人工设计。

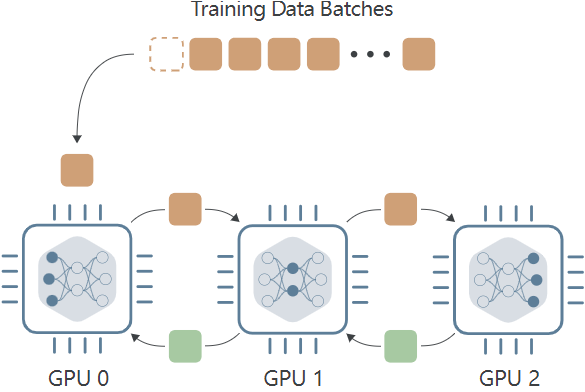

- 大数据依赖:通常需要大量标注数据和计算资源(如GPU)进行训练。

典型的深度学习模型包括卷积神经网络(CNN)、循环神经网络(RNN)和Transformer。

GBDT与深度学习的本质区别

| 对比维度 | GBDT | 深度学习 |

|---|---|---|

| 技术原理 | 基于决策树的集成学习 | 基于多层神经网络的端到端学习 |

| 数据适应性 | 擅长处理结构化数据(表格、特征清晰) | 擅长非结构化数据(图像、文本) |

| 特征工程需求 | 需要人工设计特征 | 可自动提取特征 |

| 训练效率 | 训练速度快,适合中小型数据集 | 训练资源消耗大,依赖大数据 |

| 可解释性 | 模型可解释性较强(树结构可视化) | 可解释性较低(“黑箱”特性) |

为什么有人误认为GBDT是深度学习?

- 术语混淆:“深度学习”常被泛化为“高性能机器学习模型”的代名词,导致非技术人员产生误解。

- 应用场景重叠:GBDT和深度学习均可用于预测任务(如点击率预估、推荐系统),但技术路径不同。

- 技术结合:部分场景中,GBDT与深度学习结合使用(如通过GBDT生成特征输入神经网络),进一步模糊了界限。

如何正确选择模型?

- 结构化数据场景(如金融风控、广告点击率预测):优先选择GBDT或其变体(如XGBoost)。

- 非结构化数据场景(如图像分类、自然语言处理):选择深度学习模型(如ResNet、BERT)。

- 资源受限场景:若计算资源有限或数据量较小,GBDT通常更高效。

GBDT是一种强大的集成学习算法,但其技术原理与深度学习有本质区别,深度学习的核心在于多层神经网络和自动特征学习,而GBDT依赖决策树集成与梯度优化,两者在适用场景、数据需求和技术路线上各有优劣,理解这些差异有助于在实际项目中做出更合理的选择。

引用说明

- Friedman, J. H. (2001). Greedy Function Approximation: A Gradient Boosting Machine.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- XGBoost官方文档:https://xgboost.readthedocs.io/

- PyTorch官方教程:https://pytorch.org/