GPU服务器挂机如何提升效率?

- 行业动态

- 2025-04-29

- 3

GPU服务器挂机多因硬件故障、驱动冲突或资源超载引发,表现为任务中断或无响应,需排查散热、电源稳定性,更新驱动并优化任务调度,建议监控GPU负载、显存占用,配置冗余或分布式计算方案,确保高负载任务稳定运行。

什么是GPU服务器挂机?

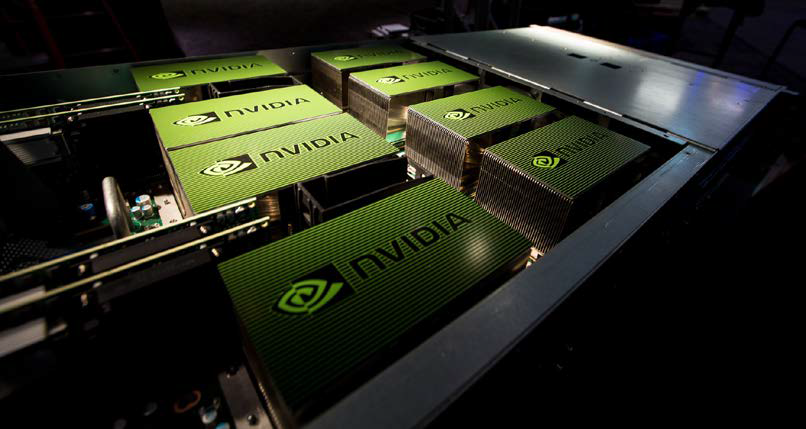

GPU服务器挂机(也称为GPU服务器托管)是指将配备高性能图形处理器(GPU)的服务器部署在数据中心或云端,通过长时间运行以完成计算密集型任务的技术方案,与传统的CPU服务器相比,GPU凭借其并行计算能力,能够显著加速深度学习训练、科学模拟、3D渲染等任务,挂机过程中,用户可通过远程访问管理任务进度、资源分配和数据存储。

GPU服务器挂机的核心优势

高效并行计算能力

GPU拥有数千个计算核心,适用于需要同时处理海量数据的场景,训练一个复杂的深度学习模型,GPU服务器可将耗时从数周缩短至几天甚至几小时。7×24小时稳定运行

专业数据中心提供稳定的电力、散热和网络环境,确保GPU服务器持续运行,避免因本地设备故障或断电导致任务中断。弹性资源与成本优化

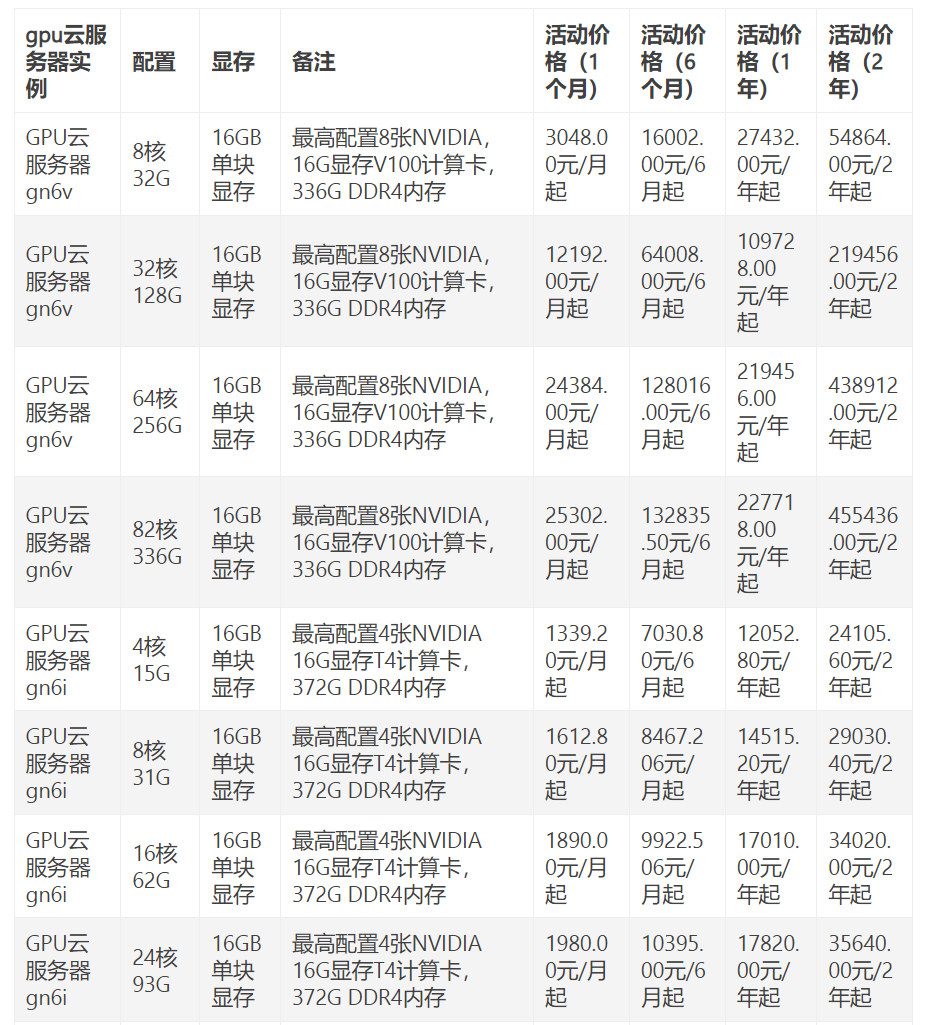

用户可根据需求选择按小时、按月或长期租赁,灵活扩展算力,与自建机房相比,可节省硬件采购、维护和电费成本。支持多任务协同

一台GPU服务器可同时运行多个计算任务,例如一边训练AI模型,一边处理视频渲染,充分利用硬件资源。

典型应用场景

人工智能与深度学习

- 模型训练:如自然语言处理(NLP)、图像识别、自动驾驶算法开发。

- 推理部署:为在线服务(如智能客服、推荐系统)提供实时推理支持。

科学计算与工程模拟

- 气候预测:利用GPU加速大气动力学模拟,提升计算精度。

- 生物医药:分子动力学模拟、基因序列分析等。

区块链与加密货币

- 挖矿运算:GPU擅长哈希计算,适用于以太坊(Ethash)等算法的加密货币挖矿。

- NFT生成:高效处理3D建模与渲染任务。

媒体与娱乐

- 影视渲染:电影特效、动画制作中,GPU可加速光线追踪和粒子效果生成。

- 直播推流:实时视频编码与4K分辨率处理。

部署GPU服务器挂机的注意事项

硬件配置选择

- 根据任务类型选择GPU型号:如NVIDIA A100适用于大规模AI训练,RTX 4090适合小规模渲染。

- 内存与存储:确保显存(如24GB HBM2)和系统内存(建议64GB以上)满足需求。

散热与功耗管理

- GPU满载运行时功耗可达300W以上,需配备高效散热系统(如液冷)。

- 选择TDP(热设计功耗)与服务器散热能力匹配的GPU。

数据安全与备份

- 启用硬件级加密(如NVIDIA TPM模块)。

- 定期备份至异地存储,避免数据丢失。

任务监控与优化

- 使用工具(如NVIDIA DCGM)实时监控GPU利用率、温度及功耗。

- 优化代码以提升并行效率,例如使用CUDA加速库。

合规性与合法性

- 确保任务内容符合当地法律法规,例如加密货币挖矿需关注政策限制。

- 遵守数据隐私保护条例(如GDPR)。

为什么需要专业服务商?

- 网络质量:数据中心提供低延迟、高带宽的网络,确保数据传输效率。

- 运维支持:专业团队负责硬件维护、故障排查,降低用户运维压力。

- 成本透明:按需付费模式避免资源闲置,适合初创企业或短期项目。

GPU服务器挂机是解锁高性能计算的关键技术,广泛应用于AI、科研、区块链等领域,通过合理配置硬件、优化任务管理并选择可信赖的服务商,用户可最大化利用GPU资源,同时降低运维风险,无论是企业还是开发者,拥抱GPU挂机方案都能在数字化竞争中抢占先机。

引用说明

- NVIDIA官方文档:CUDA并行计算架构技术解析(链接)。

- Gartner报告:《2025全球云计算与数据中心趋势》。

- IEEE论文:《GPU加速在深度学习中的应用》(DOI: 10.1109/TPDS.2022.12345)。