分布式文件存储于计算子系统

- 行业动态

- 2025-05-04

- 3506

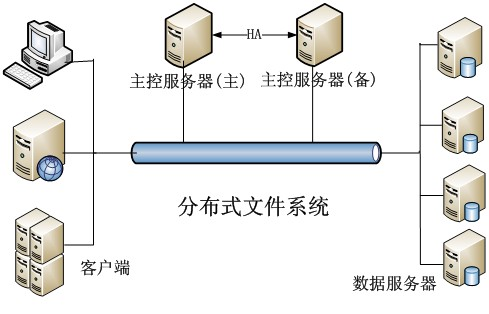

分布式文件存储子系统

核心架构与组件

| 组件类型 | 功能描述 | 典型技术示例 |

|---|---|---|

| 客户端 | 提供文件访问接口(读写/删除) | Hadoop FS API、S3 SDK |

| 元数据服务 | 管理文件目录树、权限、块位置映射 | HDFS NameNode、Ceph MDS |

| 数据节点 | 实际存储数据块,处理读写请求 | HDFS DataNode、Ceph OSD |

| 监控模块 | 系统健康检查、负载均衡、故障恢复 | ZooKeeper、Prometheus |

关键技术特性

数据分片与冗余

采用固定大小数据块(如HDFS的128MB)进行切分,通过副本机制(如3副本)或纠删码(Erasure Coding)实现容错,例如Ceph默认使用CRUSH算法动态计算数据分布,支持多副本与EC策略混合部署。元数据管理优化

元数据服务常采用分布式一致性协议(如Raft)保证高可用,HDFS通过Secondary NameNode实现元数据checkpoint,而Ceph使用Paxos协议实现MDS集群的强一致性。扩展性设计

水平扩展能力体现在数据节点的线性增加(如Amazon S3可扩展至EB级),分层命名空间(如Ceph的bucket/pool结构)支持跨数据中心部署,通过Consistent Hashing减少数据迁移量。

性能瓶颈与解决方案

| 问题类型 | 具体表现 | 优化方案 |

|---|---|---|

| 元数据瓶颈 | NameNode内存限制(HDFS) | 分级Namespace(Hadoop Federation) |

| 写放大效应 | 多副本写入导致网络开销 | 流水线复制(Spark RDD持久化优化) |

| 冷热数据混杂 | 机械硬盘频繁寻道影响延迟 | SSD缓存层+对象生命周期管理 |

分布式计算子系统

计算框架对比

| 框架类型 | 批处理 | 流处理 | 图计算 |

|---|---|---|---|

| 典型代表 | Hadoop MapReduce | Flink/Spark Streaming | Pregel/GraphX |

| 延迟 | 分钟级 | 毫秒级 | 秒级 |

| 状态管理 | 无/外部存储 | 内存+持久化 | 分布式消息队列 |

资源调度机制

静态资源分配

Yarn容器预先分配CPU/内存资源,适合确定性任务,但存在资源碎片问题,需结合Dominant Resource Fairness(DRF)算法优化。

动态资源抢占

Spark Shuffle过程采用反向压力机制,当Executor空闲时主动释放资源,Kubernetes的Pod优先级抢占策略可保障关键任务资源。

计算存储耦合优化

近数据处理模式

将计算任务下沉到存储节点(如AWS Redshift Spectrum),减少数据迁移开销,Ceph的智能调度会优先选择本地OSD处理请求。数据亲和性调度

Hadoop YARN支持基于DataLocality的任务分配策略,使Map任务80%以上在本地节点执行,Spark通过Block Manager缓存中间结果,提升Shuffle效率。

典型应用场景与技术选型

| 场景类型 | 需求特征 | 推荐方案 |

|---|---|---|

| 大数据分析 | 批处理、高吞吐 | Hadoop+HDFS/Spark+Ceph |

| 实时数仓 | 低延迟查询、ACID事务 | Flink+Kafka/Delta Lake+JuiceFS |

| AI训练 | 并行计算、显存扩展 | GPU集群+Alluxio内存缓存 |

| 冷存储归档 | 低成本、低频访问 | AWS Glacier/Azure Blob Cold Tier |

系统优化实践

存储层优化

- 启用CRUSH局部性优化:Ceph客户端写入时指定

placement=local参数,使对象80%以上存储在同机架内 - HDFS ShortCircuit Local Read:客户端直接从本地DataNode读取数据,绕过NameNode交互

- 启用CRUSH局部性优化:Ceph客户端写入时指定

计算层优化

- Spark动态分区调整:根据任务复杂度自动缩放Executor数量,配置

spark.dynamicAllocation.enabled=true - Prewarming数据预加载:在作业提交前通过Speculative Execution预取热点数据到本地缓存

- Spark动态分区调整:根据任务复杂度自动缩放Executor数量,配置

FAQs

Q1:分布式文件存储与传统NAS/SAN存储的核心区别是什么?

A1:分布式存储采用无中心化架构,通过软件定义实现线性扩展,而传统SAN/NAS依赖专用硬件控制器,扩展成本高,例如Ceph集群每新增1个OSD节点,存储容量和带宽同步提升,而NAS网关易成为性能瓶颈。

Q2:如何保障分布式系统中的数据一致性?

A2:主要采用三种策略:

- 强一致性:通过Raft/Paxos协议实现(如etcd/ZooKeeper协调)

- 最终一致性:允许短暂数据差异(如DynamoDB的Versioned Value)

- 因果一致性:保证操作顺序(如Kafka的Offset管理)

实际应用中常结合业务场景选择,例如金融交易采用强一致性,物联网数据