上一篇

如何选择最适合的GPU云计算服务器配置?

- 行业动态

- 2025-04-27

- 4950

GPU云计算服务器采用高性能GPU加速卡(如NVIDIA A100/V100),配备多核CPU、大内存及高速SSD存储,支持弹性扩容与分布式计算,通过虚拟化技术实现资源按需分配,适用于深度学习训练、科学仿真、渲染等计算密集型场景,兼具高效运算与成本优势。

为什么GPU云计算服务器成为算力新宠?

近年来,人工智能、大数据分析和科学计算的爆炸式增长,让传统CPU算力逐渐“力不从心”,GPU(图形处理器)凭借其并行计算能力,成为处理复杂任务的核心硬件,根据IDC数据,2025年全球GPU云计算市场规模已突破300亿美元,年增长率超40%,无论是训练千亿参数的AI大模型,还是实时渲染4K影片,GPU云服务器的配置选择直接决定效率与成本。

GPU云计算服务器的核心配置要素

GPU型号与性能

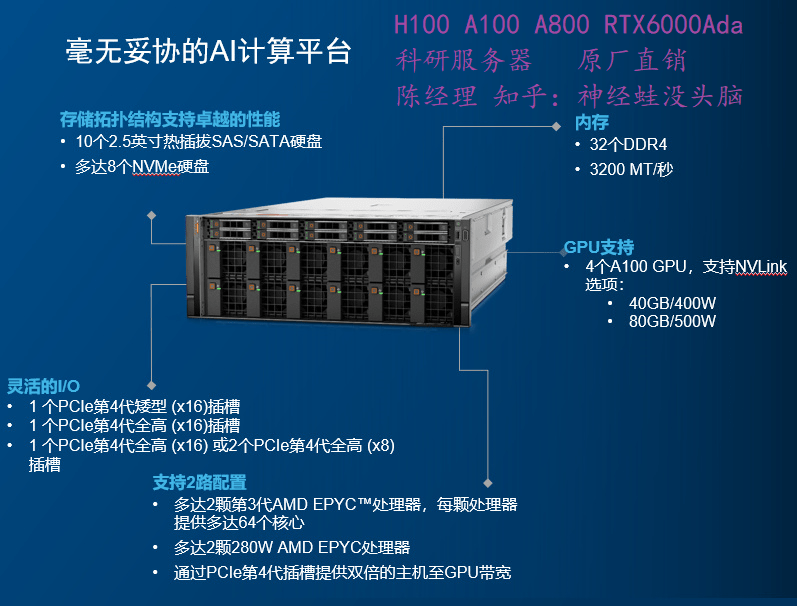

- 计算型GPU:如NVIDIA A100、H100,专为AI训练和高性能计算(HPC)设计,支持FP64双精度浮点运算,适合科研机构与大型企业。

- 推理型GPU:如T4、A10,侧重低功耗、高吞吐量,适用于实时推理(如人脸识别、自然语言处理)。

- 图形渲染GPU:如AMD Radeon Pro V620,针对3D建模、影视特效优化,支持OpenGL/Vulkan等图形接口。

显存(VRAM)容量

- 显存决定单卡可处理的数据量,训练GPT-3需至少80GB显存(如A100 80GB),而轻量级模型(ResNet)16GB显存即可。

- 多GPU并行时,需通过NVLink或PCIe 4.0互联提升显存共享效率。

CPU与内存的协同

- GPU依赖CPU调度任务,推荐配置多核处理器(如Intel Xeon Platinum 8362或AMD EPYC 7763),避免形成算力瓶颈。

- 内存容量建议为GPU显存的2-4倍,例如单卡A100(80GB)搭配256GB DDR4内存。

存储与网络

- 存储类型:NVMe SSD提供超高速IOPS(如7GB/s读取速度),适合频繁读取训练数据;冷数据可存入高容量S3对象存储。

- 网络带宽:多机多卡训练需25Gbps以上RDMA网络(如InfiniBand),降低通信延迟。

散热与扩展性

- 高密度GPU服务器(如8卡A100)需液冷散热,确保长期满载运行的稳定性。

- 机架式服务器支持灵活扩展,适合未来业务增长。

主流GPU云服务器配置方案

| 应用场景 | 推荐配置 | 适用客户 |

|---|---|---|

| 大模型训练 | 8×NVIDIA H100 + 2TB内存 + 100G RDMA网络 + 50TB NVMe存储 | AI实验室、云计算服务商 |

| 实时推理 | 4×NVIDIA T4 + 512GB内存 + 25Gbps网络 + 10TB SSD | 互联网公司、边缘计算场景 |

| 科学计算 | AMD Instinct MI250X + EPYC 7763 CPU + 1TB内存 + InfiniBand HDR | 高校、气象/生物医药研究机构 |

| 影视渲染 | 4×AMD Radeon Pro V620 + 512GB内存 + 20TB高速存储 | 动画工作室、广告制作公司 |

选型建议:如何匹配业务需求?

明确算力需求

- 计算密集型任务(如深度学习训练):优先选择FP32/FP64性能高的GPU(如H100),并配置多卡互联。

- IO密集型任务(如数据库分析):侧重高带宽存储与网络。

平衡成本与性能

- 短期项目可选用按小时计费的公有云(如AWS EC2 P5实例),长期需求建议混合云或私有化部署。

- 通过压测工具(如MLPerf)对比不同配置的性价比。

关注软件生态兼容性

- NVIDIA CUDA仍是主流框架(PyTorch、TensorFlow)的首选,AMD ROCm逐步兼容更多开源工具。

- 预装环境(如NGC容器)可节省部署时间。

应用案例:不同行业如何选择配置?

- 自动驾驶:某车企采用8卡A100集群,训练时长从2周缩短至3天,显存瓶颈通过NVLink桥接技术解决。

- 医疗影像:三甲医院使用4卡T4服务器,实时处理CT扫描数据,推理延迟控制在50ms以内。

- 金融风控:银行部署AMD MI250X服务器,利用OpenCL加速蒙特卡洛模拟,交易分析效率提升6倍。

注意事项:避开“高配低效”陷阱

- 避免过度配置:小型企业无需盲目追求8卡服务器,单卡A10可能更经济。

- 软件适配:部分开源框架对AMD GPU支持不足,需提前验证。

- 数据安全:选择通过ISO 27001认证的服务商,加密数据传输与存储。

未来趋势:GPU云计算的下一站

- 异构计算架构:CPU+GPU+DPU协同,提升资源利用率(如NVIDIA Grace Hopper Superchip)。

- 绿色算力:液冷技术降低PUE值,符合“双碳”政策要求。

- 国产化替代:华为昇腾、壁仞科技等国产GPU逐步进入公有云市场,满足信创需求。

常见问题(FAQ)

Q1:是否需要自行购买GPU硬件?

- 初创企业建议直接使用云服务(如阿里云GN7系列),免去运维成本;大型机构可考虑混合部署。

Q2:如何评估GPU服务器的算力?

- 参考TFLOPS(浮点运算能力)和显存带宽,例如H100的FP32算力为67 TFLOPS,带宽3.35 TB/s。

Q3:云服务商是否提供GPU型号试用?

- 主流平台(如Azure NDv4系列)支持按需测试,部分厂商提供免费额度。

引用说明

- 数据来源:IDC《全球云计算基础设施市场跟踪报告》(2025Q2)

- 技术参数:NVIDIA A100/H100白皮书、AMD Instinct MI250X官方文档

- 行业案例:AWS客户成功案例库、阿里云解决方案中心