如何通过服务器均衡负载代理提升网站性能?

- 行业动态

- 2025-04-27

- 3

服务器负载均衡代理通过反向代理技术将用户请求动态分配到多个服务器节点,避免单点过载,它采用轮询、加权算法等策略优化资源分配,支持健康检查及自动容错,可显著提升系统并发处理能力、响应速度和业务连续性,适用于高流量网站及云计算环境。

在数字化时代,随着用户访问量的激增和高并发请求的常态化,如何确保服务器稳定运行并快速响应用户需求,成为企业技术架构的核心挑战。服务器均衡负载代理(Load Balancing Proxy)作为一种关键基础设施,通过智能分配流量、优化资源利用率,成为保障业务连续性的“隐形守护者”,以下从技术原理、实践价值与选型策略等维度展开深度解析。

负载均衡代理的核心逻辑:流量调度的“智能大脑”

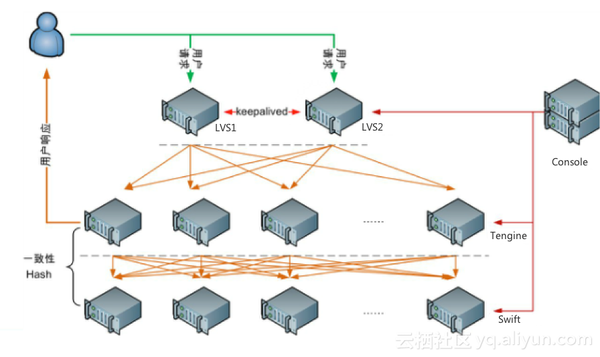

负载均衡代理的核心功能是将客户端请求合理分发到后端多台服务器,避免单一节点过载,其工作流程可拆解为:

- 流量接收:代理服务器作为入口,接收所有客户端请求。

- 健康检查:通过心跳检测(如HTTP/HTTPS探针、TCP端口探测)实时监控后端服务器的可用性。

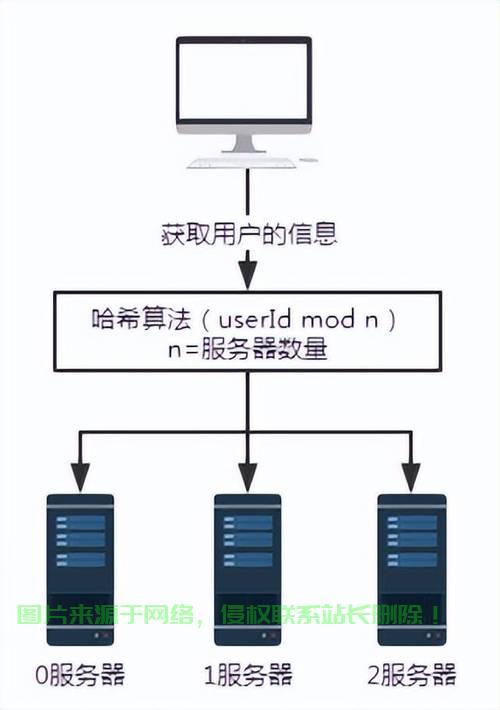

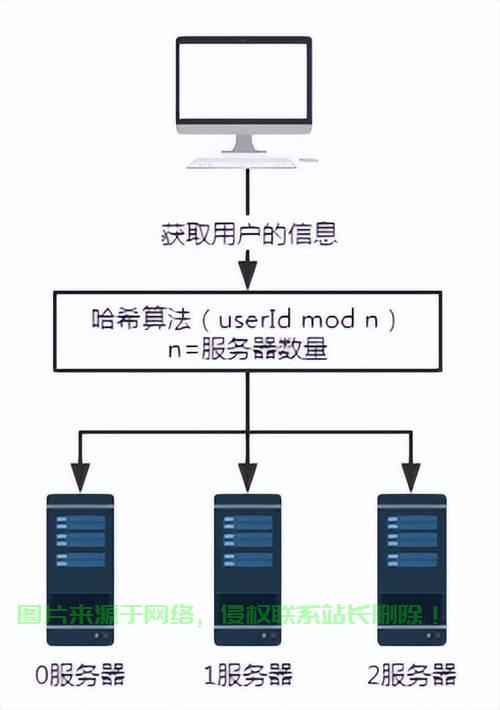

- 算法决策:根据预设策略选择目标服务器,常见算法包括:

- 轮询(Round Robin):依次分配请求,适合服务器性能均等场景。

- 加权轮询(Weighted Round Robin):为高性能服务器分配更高权重。

- 最少连接(Least Connections):优先选择当前连接数最少的节点。

- IP哈希(IP Hash):根据客户端IP固定分配服务器,保障会话一致性。

- 请求转发:通过反向代理(如HTTP/HTTPS重定向)或四层转发(如TCP/UDP)完成数据传输。

典型案例:某电商平台在“双11”期间通过动态调整加权轮询算法的权重参数,将80%的流量导向扩容后的高配服务器,确保核心交易链路零宕机。

技术实现:硬件、软件与云服务的“三足鼎立”

硬件负载均衡设备

- 代表产品:F5 BIG-IP、Citrix NetScaler

- 优势:高性能(支持百万级并发)、内置安全防护(如DDoS防御)

- 适用场景:金融、政务等对安全性与稳定性要求极高的行业

软件负载均衡方案

- 开源工具:

- Nginx:占据全球Web服务器34%市场份额(W3Techs数据),支持HTTP/HTTPS七层代理与灵活配置。

- HAProxy:擅长TCP四层负载,适用于数据库集群等场景。

- 容器化方案:Kubernetes Ingress Controller通过声明式API实现动态流量管理。

云原生负载均衡服务

- AWS ALB/NLB:支持自动伸缩、与云监控深度集成。

- 阿里云SLB:提供跨可用区容灾和DDoS高防套餐。

- 技术趋势:服务网格(Service Mesh)通过Sidecar代理(如Istio)实现微服务间智能流量控制。

选型决策矩阵:匹配业务需求的“黄金三角”

| 评估维度 | 硬件方案 | 软件方案 | 云服务 |

|---|---|---|---|

| 成本 | 高(CAPEX投入) | 低(开源免授权费) | 按需付费(OPEX) |

| 扩展性 | 有限(物理扩容) | 高(横向扩展) | 弹性自动扩缩 |

| 运维复杂度 | 需专业团队 | 中(需配置优化) | 低(托管式服务) |

| 典型场景 | 银行核心系统 | 中小型Web应用 | 互联网初创企业 |

决策建议:

- 初创企业:优先选择云服务,快速部署且避免基础设施维护成本。

- 传统行业:混合架构(硬件+云)平衡安全与弹性需求。

- 高并发场景:采用Nginx+Lua脚本扩展,实现定制化分流策略。

前沿演进:从流量分发到全域智能

AI驱动的预测性负载均衡

基于机器学习分析历史流量模式,提前预判峰值并自动扩容,Netflix通过实时用户行为分析实现区域级流量调度。边缘计算融合

结合CDN节点部署负载均衡代理,将计算能力下沉至离用户最近的边缘,Cloudflare Workers等方案可实现毫秒级响应。安全与性能一体化

现代负载均衡器集成WAF(Web应用防火墙)、Bot防护等功能,例如F5的“一站式安全负载”架构。

最佳实践:规避常见误区

误区1:过度依赖单一算法

解决方案:采用混合策略,例如静态算法为主,结合实时性能监控动态切换。误区2:忽视会话保持机制

解决方案:在购物车、支付等场景启用Cookie或IP绑定,避免用户状态丢失。误区3:配置后缺乏持续优化

解决方案:通过Prometheus+Grafana监控QPS、响应时间等指标,定期调优参数。

引用说明

- Gartner《2025年全球负载均衡市场指南》

- AWS官方文档《弹性负载均衡最佳实践》

- Nginx开源社区技术白皮书