上一篇

光年日志分析工具使用方法分析

- 行业动态

- 2025-04-23

- 2549

导入日志文件,配置分析参数,工具自动解析数据,生成可视化报告,支持结果

核心功能模块

| 功能模块 | 说明 |

|---|---|

| 数据导入 | 支持本地文件、FTP/SFTP、数据库等多种数据源,兼容压缩格式(如.gz、.zip)。 |

| 预处理与清洗 | 字段提取、正则表达式匹配、时间格式转换、去重、过滤无效行。 |

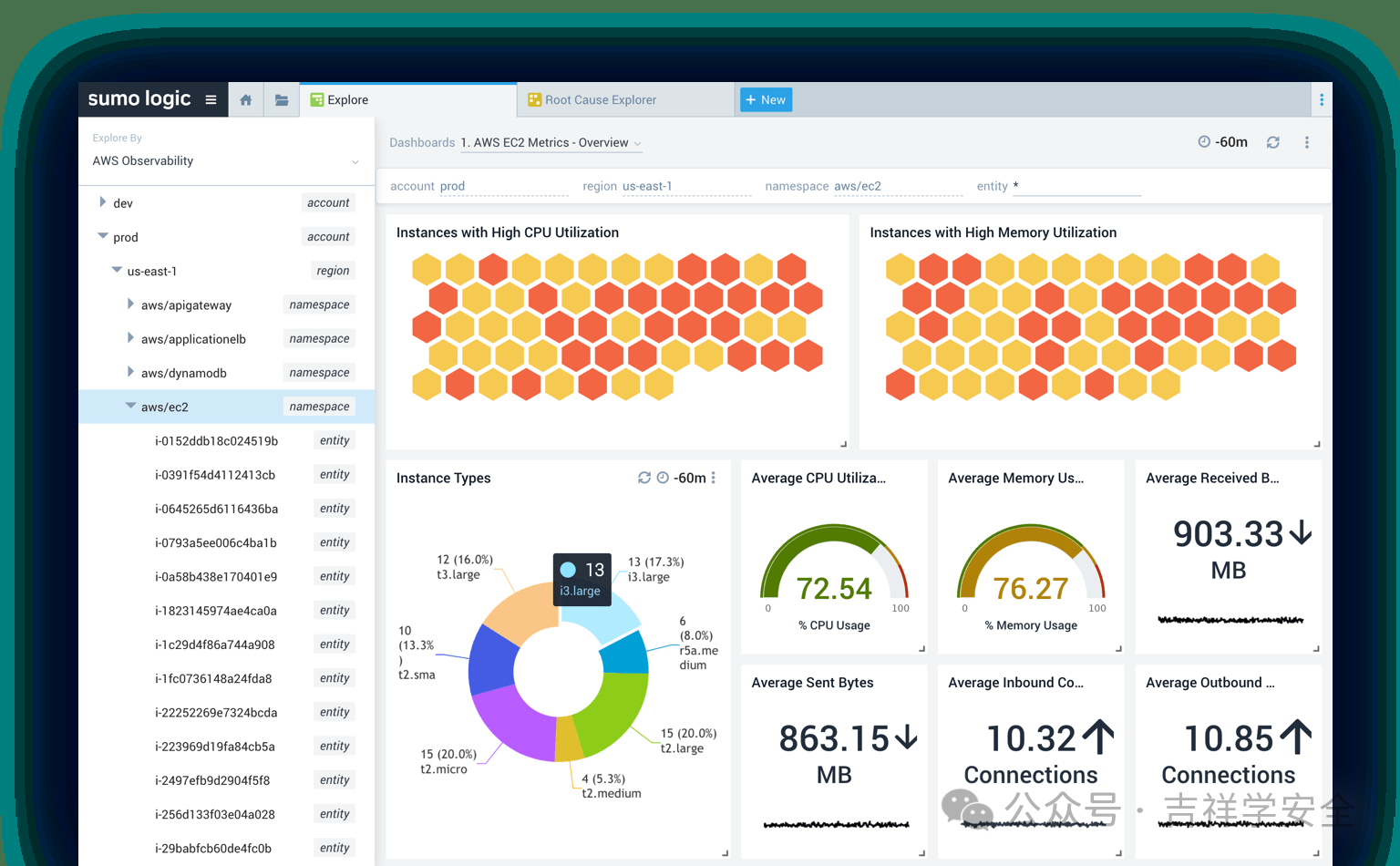

| 实时查询与分析 | 支持SQL语法、关键词搜索、时间范围筛选,支持聚合计算(计数、求和、平均值等)。 |

| 可视化展示 | 自动生成折线图、柱状图、饼图、表格,支持自定义图表类型和时间粒度。 |

| 告警与通知 | 设置阈值规则(如错误率>5%),触发后通过邮件、Webhook推送告警。 |

操作步骤详解

数据导入

步骤:

- 进入“数据源管理”界面,点击“添加数据源”。

- 选择日志文件类型(如JSON)及存储路径。

- 配置解析规则(如指定时间字段、IP字段等)。

- 完成导入后,系统自动生成索引。

示例:

// 日志样例(JSON格式) { "timestamp": "2023-10-01T12:00:00Z", "level": "ERROR", "message": "Database connection failed", "ip": "192.168.1.1" }

数据预处理

操作:

- 过滤:通过条件(如

level == "ERROR")筛选日志。 - 转换:将时间戳统一为UTC+8时区,或提取IP地址段。

- 聚合:按分钟/小时/天统计错误日志数量。

- 过滤:通过条件(如

SQL示例:

SELECT COUNT() AS error_count, DATE_FORMAT(timestamp, '%H:00') AS hour FROM logs WHERE level = 'ERROR' GROUP BY hour;

查询与分析

常用函数:

| 函数 | 作用 | 示例 |

|——————-|——————————|———————————–|

|SUM()| 求和 |SUM(response_time)|

|AVG()| 平均值 |AVG(duration)|

|MAX()| 最大值 |MAX(memory_usage)|

|REGEXP_MATCH()| 正则匹配 |REGEXP_MATCH(message, "timeout")|复杂查询:

// 统计每个IP的错误次数并排序 SELECT ip, COUNT() AS error_count FROM logs WHERE level = 'ERROR' GROUP BY ip ORDER BY error_count DESC;

可视化与导出

- 图表类型:折线图(趋势分析)、饼图(占比分布)、热力图(时间密度)。

- 导出格式:PNG/PDF图表、CSV/Excel数据表、JSON原始日志。

性能优化建议

| 场景 | 优化方法 |

|---|---|

| 大文件处理 | 分块加载(如每次处理100万行),避免内存溢出。 |

| 查询速度慢 | 预先建立字段索引(如timestamp、level),减少全表扫描。 |

| 实时性要求 | 启用增量导入模式,仅加载新增日志。 |

常见问题与解答

问题1:导入日志时提示“解析失败”如何解决?

- 解答:

- 检查日志格式是否与配置的解析规则一致(如JSON键名是否匹配)。

- 查看错误日志详情,确认是否存在非规字符或格式错误。

- 尝试手动指定分隔符(如CSV文件使用或

t)。

问题2:查询结果为空,可能是什么原因?

- 解答:

- 确认时间范围是否正确(如

timestamp >= "2023-10-01")。 - 检查过滤条件是否过于严格(如

level = "WARN"但日志中实际为WARNING)。 - 验证字段名称是否拼写正确(如

statusvshttp_status)。

- 确认时间范围是否正确(如

通过以上步骤,可高效完成日志数据的导入、清洗、查询及可视化分析,若需进一步定制功能(如机器学习模型集成),可参考官方API文档扩展工具能力