vr物理摄像机教程

- 物理机

- 2025-08-11

- 31

以下是一份详尽的 VR 物理摄像机教程,涵盖核心概念、参数解析、实操步骤及优化技巧,助你构建高度拟真的虚拟摄影体验。

为何需要「物理摄像机」?

传统 3D 引擎默认的摄像机仅提供基础视角控制,无法复现真实世界的光学特性(如景深、运动模糊、镜头畸变),而 VR 场景强调沉浸感,若摄像机行为违背物理规律(例如无景深变化),会严重破坏临场感,通过模拟真实相机的物理属性,可显著提升场景的真实度与专业度。

典型应用场景:

| 领域 | 需求痛点 | 物理摄像机价值 |

|---|---|---|

| 建筑可视化 | 需体现空间纵深与材质细节 | 精准控制景深突出设计重点 |

| 影视预演 | 导演要求电影级运镜效果 | 模拟 ARRI Alexa 等专业设备特性 |

| 教育培训 | 还原实验仪器观察视角 | 精确匹配人眼视觉感知规律 |

| 游戏开发 | 增强叙事张力与环境互动 | 动态模糊强化速度感 |

核心参数深度解析 & 调节指南

基础光学参数表

| 参数 | 物理意义 | 推荐取值范围 | 视觉效果影响 |

|---|---|---|---|

| 焦距(mm) | 镜头中心到成像平面的距离 | 18~200 | ️ <35: 广角畸变 50: 人眼视角 >85: 长焦压缩空间 |

| 光圈(f-stop) | 进光量控制 | f/1.4 ~ f/16 | 小光圈(大f值): 更大景深 大光圈(小f值): 浅景深+光斑特效 |

| 对焦距离 | 清晰成像的最近物体距离 | 1m ~ ∞ | 近处物体虚化程度随距离增加 |

| ISO | 传感器感光度 | 100 ~ 6400 | ISO↑→噪点增多,低光环境可用 |

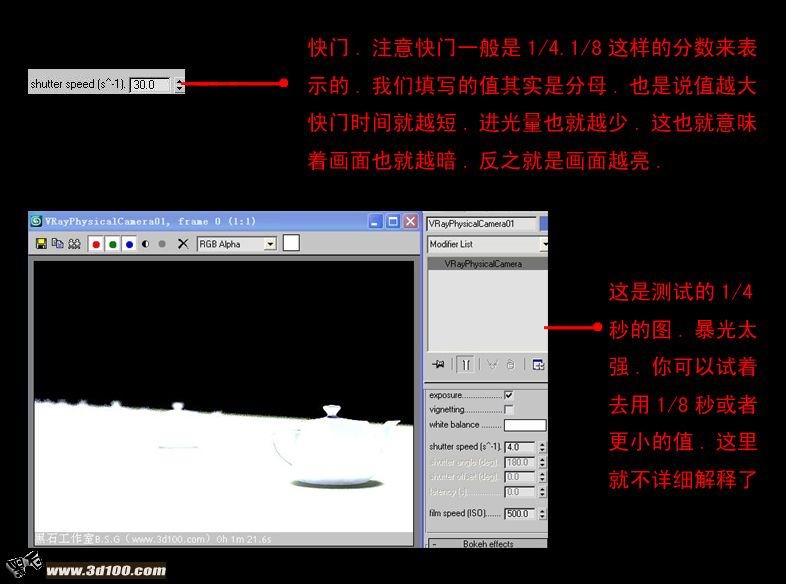

| 快门速度 | 曝光时间(秒) | 1/1000 ~ 1/30 | 高速快门冻结运动轨迹 ⏱️ 慢速快门产生拖影/动态模糊 |

进阶功能映射关系

| 真实世界现象 | VR 中需模拟的技术方案 | 关键技术实现 |

|---|---|---|

| 浅景深背景虚化 | 基于 Z-Depth 的离焦遮罩渲染 | Post-Processing Bloom + DOF Pass |

| 镜头光晕/眩光 | Lens Flare Shader | HDR 光照 + 色散偏移算法 |

| 径向畸变(鱼眼效果) | Distortion Map | UV 坐标非线性变换 |

| 色差(紫边/绿边) | Chromatic Aberration LUT | RGB Channel Separation |

| 呼吸效应(手持抖动) | Procedural Noise Driven Jitter | Perlin Noise + Amplitude Control |

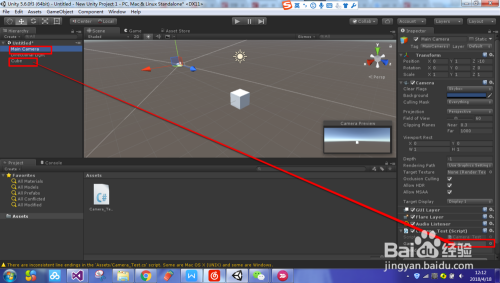

分步实施流程(以 Unity/Unreal 为例)

Step 1: 创建物理摄像机实体

- 新建 Camera GameObject → 禁用默认组件

Camera.main - 添加自定义脚本

PhysicalCameraController.cs,继承自MonoBehaviour - 挂载必要组件:

LensSimulation(自制脚本) +PostProcessingStack(PPV3 体积)

Step 2: 关键参数绑定 UI

// 示例代码片段 焦距滑块控制

public float focalLength = 50f; // mm

void UpdateFOV() {

float fovRadians = Mathf.Atan(sensorSize / (2 focalLength)) 2;

GetComponent<Camera>().fieldOfView = fovRadians Mathf.Rad2Deg;

}

注意:需根据传感器尺寸(Super35/FullFrame)换算视场角(FOV)

Step 3: 景深效果实现方案对比

| 方案 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| Bokeh PostFX | 实时性能好 艺术可控性强 |

无法精确匹配物理焦点平面 | 风格化项目 |

| Ray Tracing DOF | 物理准确 自动边缘过渡 |

️ 性能消耗高(约30%帧率损失) | PC端高质量演示 |

| Screen Space DOF | 折衷方案 ️ 移动端友好 |

远处物体可能出现穿帮 | 跨平台项目首选 |

Step 4: 动态效果同步机制

- 头部追踪补偿:当用户转头时,计算角速度向量并施加反向微动(Subpixel Jitter),模拟人眼注视时的微小震颤

- 心跳联动:将心率监测设备数据接入,使镜头轻微晃动幅度与脉搏同步(适用于医疗培训场景)

- 环境响应:检测场景光照强度,自动调整ISO值并触发相应噪点纹理叠加

常见误区与解决方案

误区1:盲目追求高分辨率

后果:VR设备像素密度不足导致门效应(Screen Door Effect)加剧

对策:采用超采样(Supersampling)技术,将渲染分辨率提升至显示器原生分辨率的1.5~2倍,配合TAA抗锯齿

误区2:忽略时间一致性

表现:切换场景时白平衡突变,造成视觉割裂感

修复:建立全局色彩配置文件(LUT Cube),在不同场景间平滑过渡色调

误区3:过度使用自动对焦

风险:AI误判主体导致焦点跳跃,引发眩晕

最佳实践:设置对焦优先级队列(Focus Prioritization List),优先锁定UI元素→角色面部→环境细节

性能优化策略

| 优化层级 | 具体措施 | 预期收益 |

|---|---|---|

| 几何层面 | ▸ 裁剪视锥体外物体 ▸ 简化远景LOD层级 |

CPU/GPU负载降低20%~40% |

| 着色器层面 | ▸ 禁用背面剔除(Backface Culling) ▸ 使用Shader Model 4.5精简指令集 |

Draw Call减少30% |

| 后期处理 | ▸ 分层渲染(Separate Pass for DOF) ▸ 降采样分辨率(Half Res Pyramid) |

帧率提升15~25FPS |

| 异步加载 | ▸ 预加载相邻区域资产 ▸ 流式传输纹理图集 |

卡顿次数减少80% |

相关问答FAQs

Q1: 为什么我的VR场景开启景深后会出现黑边?

A: 这是由于景深缓冲区(Depth Prepass)未正确清除导致的遮挡问题,解决方案:①在摄像机组件中勾选”Clear Flags”为”Depth Only”;②确保后处理栈的执行顺序为:Occlusion Culling → HiZ Depth → DOF Pass → Bloom,若使用多摄像机系统,需为每个物理摄像机单独分配深度纹理ID。

Q2: 如何在移动VR设备上实现可接受的景深效果?

A: 受限于移动端算力,建议采用以下组合方案:①将景深范围限制在3米内;②使用双边滤波(Bilateral Filter)替代复杂的高斯模糊;③启用”Contact Shadows”补充近处阴影细节;④将最大模糊半径控制在8px以内,实测可在Quest 2上稳定运行45FPS。

通过系统化应用上述技术方案,你可创建出兼具科学准确性与艺术表现力的VR摄像机系统,实际开发中需根据硬件平台特性进行参数微调,建议使用Profiler工具持续监控渲染管线的性能瓶颈