VR拍摄不用摄像机?

- 物理机

- 2025-07-06

- 1

当我们谈论虚拟现实(VR)时,常常会听到“VR摄像机”或“虚拟摄像机”这样的术语,这可能会让一些用户产生一个根本性的疑问:VR头盔里是不是真的装了一个小型的物理摄像机,用来拍摄画面?

答案是明确的:没有,VR头盔内部并没有安装传统意义上的物理摄像机。

这个结论乍看之下可能有些反直觉,毕竟我们是通过VR头盔“看到”一个虚拟世界的,理解为什么VR不需要物理摄像机,以及“虚拟摄像机”到底是什么,是理解VR技术核心原理的关键一步。

物理摄像机 vs. 虚拟摄像机:本质区别

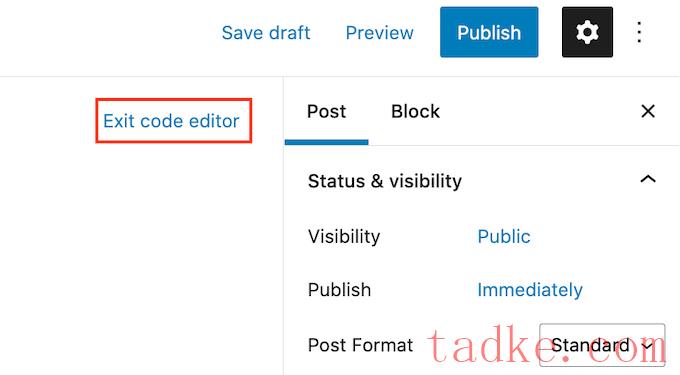

- 物理摄像机: 这是我们日常熟悉的概念,无论是手机摄像头、单反相机还是电影摄影机,它们都是实体设备,核心组件包括镜头、图像传感器(如CMOS或CCD)、光圈、快门等,它们的工作原理是捕捉现实世界中物体反射或发出的光线,将其转换为电子信号,最终形成我们看到的照片或视频,物理摄像机记录的是客观存在的物理空间。

- 虚拟摄像机: 在VR(以及计算机图形学、游戏引擎中),这是一个纯粹由软件定义的概念,它本质上是一个数学构造,一组定义了观察点(位置) 和观察方向(朝向) 的坐标和角度参数,你可以把它想象成一个存在于计算机程序(或VR应用)内部的、无形的“观察点”或“视点”。它不捕捉任何光线,也不包含任何物理镜头或传感器。

VR的视觉是如何产生的?

既然没有物理摄像机拍摄画面,那么我们通过VR头盔看到的逼真世界是从哪里来的呢?整个过程依赖于复杂的软件算法和硬件协同工作:

- 用户头部追踪: VR头盔内置了高精度的运动追踪传感器(如加速度计、陀螺仪、磁力计,以及外置或内置的光学追踪摄像头/激光定位基站),这些传感器实时、连续地监测用户头部的运动,精确测量其位置(X, Y, Z坐标) 和朝向(偏航Yaw, 俯仰Pitch, 翻滚Roll角度),这就是所谓的“六自由度”(6DoF)追踪。

- 虚拟摄像机参数设定: VR应用程序(或游戏引擎)会根据用户头部的实时位置和朝向数据,动态地更新和设定虚拟摄像机的参数,用户的头部位置决定了虚拟摄像机在虚拟3D空间中的坐标点,头部的朝向决定了虚拟摄像机镜头“指向”哪里。

- 3D场景渲染: 应用程序中存储或实时生成了一个详细的虚拟3D世界模型(包含几何形状、纹理、光照、材质等信息),基于虚拟摄像机当前的参数(位置和朝向),强大的图形处理器(GPU)会进行复杂的计算:

- 视锥体计算: 确定虚拟摄像机在当前视角下“能看到”的虚拟空间范围(一个金字塔形的区域)。

- 几何变换: 将虚拟3D模型中的顶点坐标,根据虚拟摄像机的位置和朝向,转换到以摄像机为原点的观察坐标系中。

- 投影变换: 将3D观察坐标投影到2D成像平面上(模拟透视效果)。

- 光栅化与着色: 将投影后的2D图形填充像素,计算每个像素的颜色(考虑光照、纹理、阴影等效果)。

- 双屏显示与光学镜片: GPU为左右眼分别渲染出两幅略有视角差的2D图像(模拟人眼间距),这两幅图像被分别传送到VR头盔内部的两个独立显示屏(或一个屏幕的分区)上,头盔内部的特殊光学镜片(菲涅尔透镜、Pancake透镜等) 位于屏幕和用户眼睛之间,这些镜片的主要作用是将屏幕上显示的微小、近距离的2D图像进行光学放大和弯曲,使其覆盖用户的大部分视野,并产生一种“看向远方”的感觉,同时将左右眼图像融合,最终在用户大脑中形成具有深度感(立体视觉) 和沉浸感的3D画面。

- 畸变校正: 由于光学镜片会引入特定的扭曲(如桶形畸变),在图像渲染的最后阶段,GPU会应用一个反向的畸变算法(畸变校正着色器),对输出到屏幕的图像进行预扭曲,这样,当图像通过镜片时,扭曲就被抵消了,用户看到的就是正常的画面。

为什么说“VR没有物理摄像机”?核心原因

- 源头不同: VR呈现的视觉内容并非来源于对现实物理世界的光学捕捉(这是物理摄像机的核心功能),而是完全由计算机程序生成(CGI)或基于预先拍摄的360°全景视频/照片(但播放时仍需虚拟摄像机控制视角),即使是在观看360°视频时,头盔内的传感器和虚拟摄像机决定了你“看向”视频中的哪个部分,而不是有一个物理镜头在实时拍摄你面前的景象。

- 依赖传感器而非光学捕捉: VR头盔感知用户动作的核心是运动追踪传感器,它们测量的是物理运动本身(加速度、角速度、磁场变化、光学标记点位置等),而不是像摄像机那样捕捉环境的光学影像,这些传感器数据是驱动虚拟摄像机更新的输入信号。

- 渲染是核心: 用户最终看到的画面是GPU根据虚拟摄像机的参数实时计算(渲染)出来的,不是通过物理镜头感光形成的。

- 光学镜片的作用是显示,不是成像: VR头盔的光学系统负责将计算生成的图像以舒适、沉浸的方式呈现给眼睛,其作用类似于投影仪或显示器的光学组件,而非摄像机镜头那样负责采集光线成像。

“虚拟摄像机”术语的意义

虽然VR中没有物理摄像机,但“虚拟摄像机”这个术语在技术领域被广泛使用,因为它完美地类比了传统摄像/摄影中的核心概念——视点控制,开发者通过编程控制这个虚拟摄像机的位置和朝向,就等同于在虚拟世界中控制用户的“眼睛”看向哪里,这个概念在游戏开发、3D动画和VR内容创作中至关重要。

沉浸感的源泉是算法与传感器

VR技术创造的惊人沉浸感,其视觉基础并非依赖于头盔内部的一个微型物理摄像机去“拍摄”虚拟世界(这本身就是一个悖论),相反,它建立在一系列精密技术的协同之上:高精度的头部运动追踪传感器实时捕捉用户动作,软件定义的虚拟摄像机根据这些动作动态设定观察点,强大的GPU据此实时渲染出对应的立体视图,最后通过特殊的光学系统将图像舒适地送入用户双眼。 理解“VR没有物理摄像机”这一事实,有助于我们更深刻地认识到VR作为一项仿真与交互技术的本质——它通过算法和硬件模拟我们的视觉感知,将我们“传送”到完全由数字构建或增强的环境中,这种对物理世界成像原理的“舍弃”,恰恰是VR能够突破现实物理限制、创造无限可能体验的关键所在。

引用说明:

- 虚拟摄像机概念与渲染管线原理参考自标准计算机图形学教材(如《Real-Time Rendering》)及主流游戏引擎(如Unity, Unreal Engine)官方文档。

- VR头盔追踪技术(IMU, Inside-Out/Outside-In Tracking)描述基于Oculus (Meta), HTC Vive, Valve Index, PlayStation VR等主流设备公开的技术白皮书与开发者文档。

- VR光学显示原理(透镜作用、畸变校正)参考了光学工程领域相关研究论文及头显制造商(如Meta, Sony, HTC)的技术说明。

- 对物理摄像机与虚拟摄像机本质区别的论述,综合了斯坦福大学、麻省理工学院等机构公开的VR/AR技术课程资料要点。