openstack跨物理机

- 物理机

- 2025-08-05

- 17

enStack作为开源云计算平台,其核心价值之一在于通过虚拟化技术整合多台物理机的资源,形成统一的计算、存储和网络池,关于“跨物理机”的具体实现方式与限制,需要结合架构原理和技术细节进行深入分析,以下是详细说明:

OpenStack对物理资源的管理机制

-

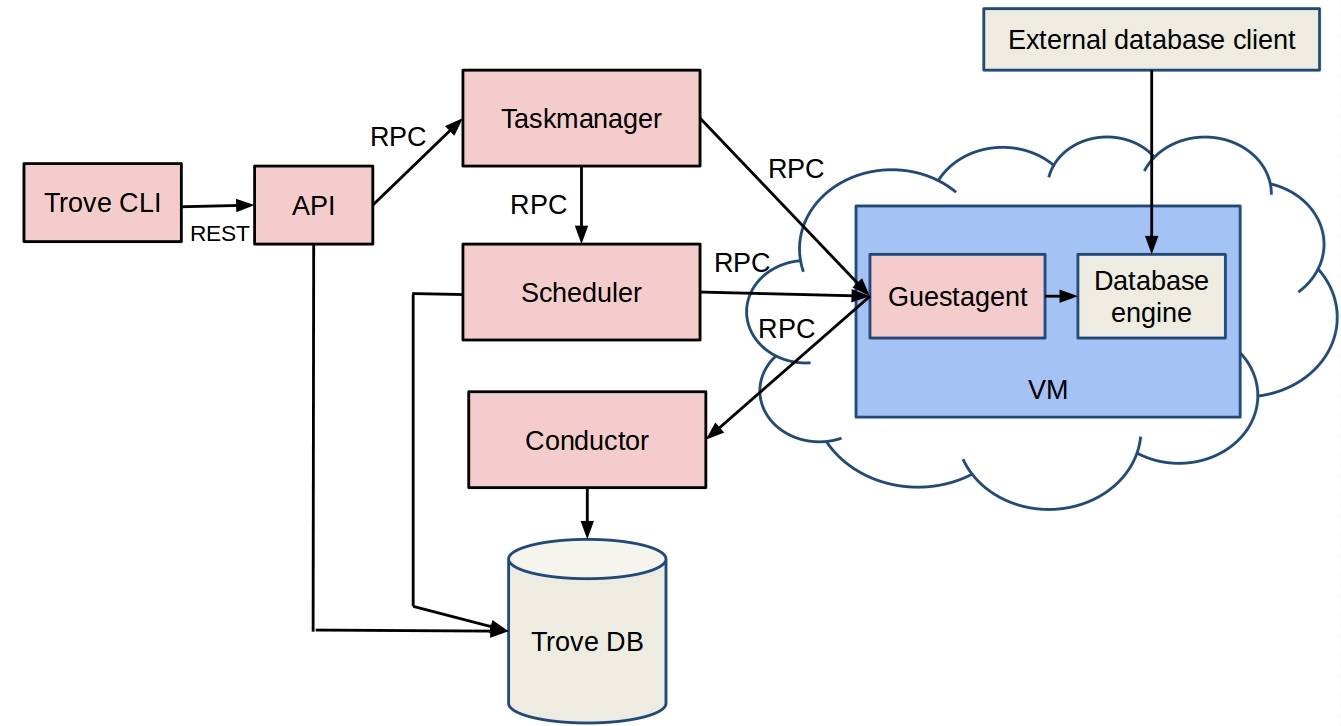

组件协同工作

- Nova(计算服务):负责调度虚拟机到合适的物理节点,并监控生命周期,它基于过滤算法选择满足CPU/内存需求的宿主机;

- Neutron(网络服务):提供软件定义网络能力,确保跨主机通信;

- Cinder(块存储):管理持久化磁盘,支持将卷挂载到不同物理机的实例上;

- Glance(镜像库):存储标准化操作系统镜像供快速部署使用;

- Keystone(身份认证):统一权限控制,保障多租户环境下的安全性。

-

资源抽象与隔离:OpenStack将物理机的硬件资源(如vCPU核心数、内存容量)封装为可动态分配的逻辑单元,一个4核4G的虚拟机可以被部署在单个2核2G的物理机上,通过超分技术实现资源复用,但此时仅涉及单台物理设备的超额订阅,而非真正的跨机协作。

虚拟机能否跨越物理机运行?

从技术本质来看,当前主流虚拟化方案均不支持同一虚拟机实例同时使用多台物理机的CPU和内存资源,具体表现为:

| 资源类型 | 是否支持跨物理机分配 | 替代方案 |

|————–|————————–|———————————-|

| CPU/内存 | 不可跨物理机 | 通过超分技术在单台宿主机上模拟更大容量 |

| 磁盘 | 可跨物理机存储 | 利用分布式存储系统实现数据冗余与共享 |

这意味着用户无法创建一个由两台物理机各提供2核组成的4核虚拟机,但可以将该虚拟机的磁盘分散保存在多个物理节点对应的存储系统中,这种设计源于虚拟化层的技术约束——内存访问的低延迟要求和CPU上下文切换必须在同一宿主机内完成。

实现跨物理机的几种典型场景

尽管单个虚拟机无法直接横跨多台物理机,但OpenStack提供了多种间接方式达成类似效果:

-

热迁移(Live Migration)

- 适用条件:源与目标物理机均连接共享存储;

- 操作流程:通过

nova live-migration <实例ID> <目标节点>命令触发实时迁移,期间业务无感知中断; - 性能影响:依赖网络带宽传输内存状态,建议在闲时执行。

-

冷迁移(Cold Migration)

- 特点:停机状态下拷贝磁盘文件至新宿主机,适合维护窗口期操作;

- 优势:不要求共享存储,兼容本地磁盘模式;

- 风险:需手动更新数据库中的主机关联记录。

-

存储独立于计算节点部署

- 案例:使用Ceph RBD作为后端存储时,虽然默认不支持在线热迁移,但可通过第三方工具提升效率;

- 优化手段:引入XSKY SDS等企业级解决方案,实现纳管卷与多集群协同,使跨物理机的存储迁移不受容量限制。

高级扩展方案:存算分离架构

针对复杂业务需求,行业实践中衍生出以下增强型设计模式:

-

计算与存储解耦

- 拓扑结构:单独设置计算集群和存储集群,二者通过高速网络互联;

- 收益:灵活扩展各类资源,避免单一组件瓶颈;

- 挑战:需解决跨集群延迟问题,通常采用缓存机制缓解。

-

第三方技术支持下的无缝迁移

- 代表方案:XMotion纳管热迁移技术;

- 核心能力:自动化完成虚拟机及其关联存储的跨集群转移,支持速率调节和任务取消;

- 应用场景:版本升级、硬件轮换、灾备演练等运维活动。

常见问题解答(FAQs)

Q1: OpenStack是否允许一个虚拟机同时使用多台物理机的CPU和内存?

A: 目前主流的KVM/Xen等虚拟化方案均不支持跨物理机的CPU时间片调度或内存统一寻址,可以通过超分技术在单台物理机上模拟更大的资源配置,若需突破单机性能上限,应考虑横向扩展应用架构而非依赖单个虚机。

Q2: 如何实现虚拟机在不同物理机之间的在线迁移?

A: 前提条件是所有相关物理机必须接入同一套共享存储系统,满足此条件后,可通过OpenStack原生命令nova live-migration执行实时迁移,对于使用本地存储的场景,则需要借助第三方工具实现块设备的同步复制。

OpenStack通过灵活的资源调度和丰富的迁移方案,实现了跨物理机的动态资源管理,虽然单个虚拟机无法直接共享多台物理机的计算资源,但通过合理的架构设计和工具支持,可以构建高可用、