上一篇

虚拟机CPU资源能否实现跨物理服务器共享?

- 物理机

- 2025-05-28

- 2161

虚拟机的CPU资源通过虚拟化技术可实现跨物理服务器共享,依托动态分配和集群调度机制,不同宿主机间的计算资源可按需整合,实现负载均衡与弹性扩展,该模式提升了硬件利用率及系统容灾能力,但需协调网络延迟、资源争抢等问题,适用于云平台等分布式环境。

在云计算和虚拟化技术的广泛应用下,虚拟机的CPU资源管理成为企业IT架构中的核心议题之一,许多人好奇:虚拟机的CPU资源是否真的可以跨物理服务器共享?这种共享机制如何实现?又会带来哪些优势与挑战?本文将从技术原理、应用场景、实际价值等多角度展开解析。

虚拟机的CPU资源共享机制

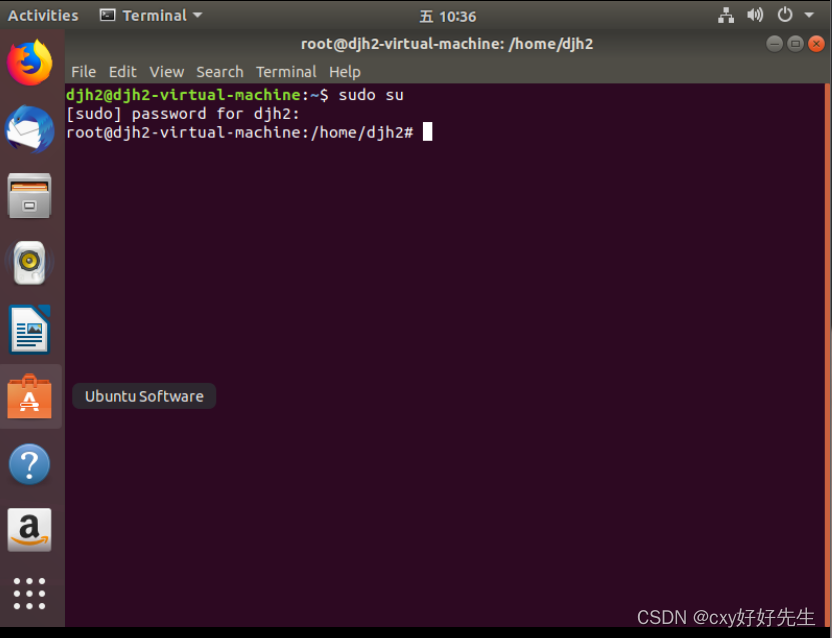

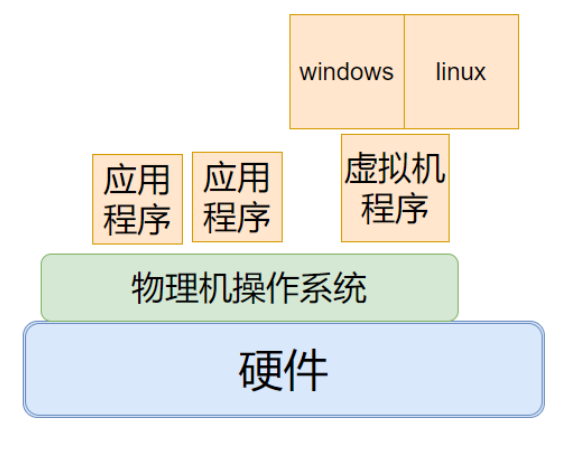

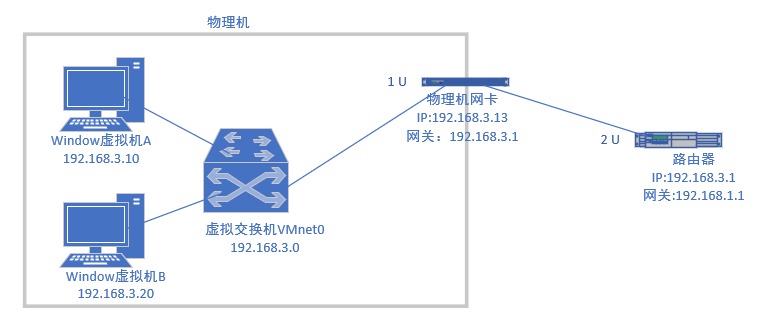

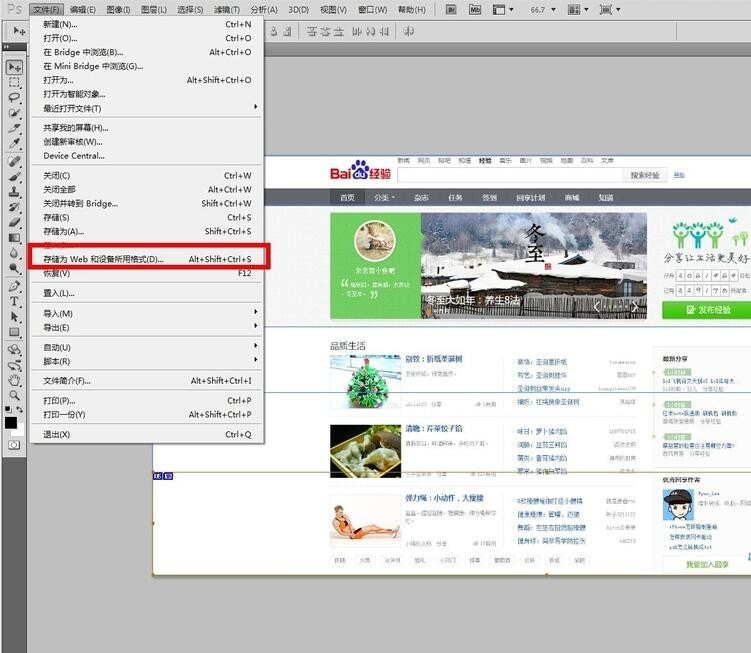

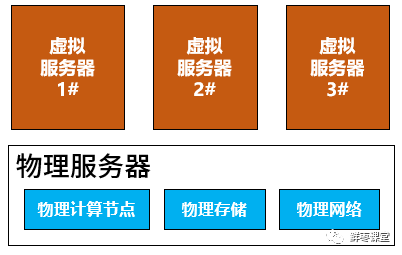

虚拟化技术的核心在于通过Hypervisor(虚拟化管理程序)将物理服务器的硬件资源抽象化,形成可动态分配的“资源池”,在此过程中,CPU资源以时间片轮转的方式分配给不同的虚拟机,一台物理服务器的CPU可能被划分为多个虚拟CPU(vCPU),每个vCPU在特定时间段内独占物理CPU的计算能力。

跨物理服务器的资源共享则更进一步,通过以下技术实现:

- 动态迁移(Live Migration)

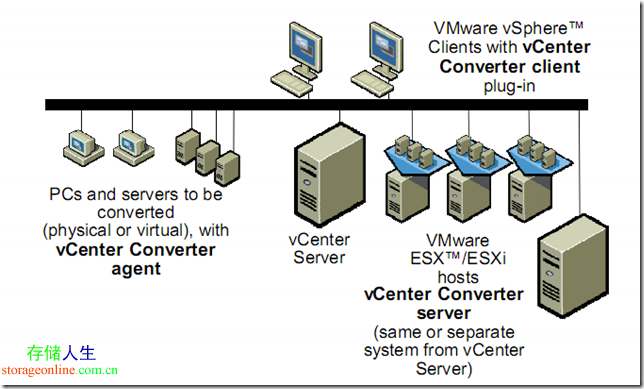

虚拟机可在不中断服务的情况下,从一台物理服务器迁移至另一台,迁移过程中CPU负载会被重新分配到目标主机,VMware的vMotion和Hyper-V的实时迁移功能均支持此操作。 - 集群与资源池化

多台物理服务器组成集群后,CPU、内存等资源将被整合为统一资源池,当某台物理服务器的CPU负载过高时,集群调度系统(如Kubernetes或OpenStack)会自动将虚拟机调度至负载较低的节点。 - 分布式资源调度(DRS)

通过智能算法,系统可实时监控各物理节点的资源利用率,动态调整虚拟机分布,实现跨服务器的CPU资源共享。

跨物理机共享CPU资源的优势

- 提升资源利用率

传统物理服务器的CPU平均利用率通常不足20%,而虚拟化资源池可将利用率提升至70%以上,减少硬件浪费。 - 灵活应对业务波动

在电商大促或突发流量场景下,系统可自动调用其他物理节点的空闲CPU资源,保障业务稳定性。 - 增强容灾能力

当某台物理服务器故障时,虚拟机会自动迁移至其他节点,避免服务中断。

挑战与注意事项

尽管跨物理机共享CPU资源具有显著优势,但也需关注以下问题:

- 性能波动风险

若物理节点间的网络延迟过高,或资源调度策略不合理,可能导致虚拟机性能下降。 - 资源隔离性

尽管虚拟化技术通过CPU份额(Shares)、资源预留(Reservation)等机制保障优先级,但极端情况下仍可能发生资源争抢。 - 调度策略优化

需根据业务类型(如计算密集型、I/O密集型)制定差异化的资源分配策略,AI训练任务可能需要绑定特定物理核以避免上下文切换开销。

典型应用场景

- 云计算平台

AWS、阿里云等公有云服务商通过全局资源池实现跨地域、跨机房的CPU资源共享,用户可按需获取算力。 - 企业私有云

VMware vSphere或Nutanix超融合架构中,多台物理服务器的CPU资源可被统一管理,支撑ERP、数据库等关键业务。 - 开发测试环境

DevOps团队可快速创建虚拟机,并利用跨主机资源池实现并行编译、自动化测试,缩短交付周期。

虚拟机跨物理服务器的CPU资源共享,本质是通过虚拟化层和智能调度系统实现的逻辑层资源整合,这种技术不仅突破了单台硬件的算力限制,还为企业提供了弹性扩展、成本优化的核心价值,其有效性和稳定性高度依赖底层架构设计,例如网络带宽、存储性能、调度算法的协同优化,随着边缘计算和异构计算的普及,跨节点资源调度将面临更复杂的场景,但也将释放更大的技术红利。

引用说明

- VMware官方文档 – 《vSphere资源管理指南》

- Intel白皮书 – 《硬件辅助虚拟化技术解析》

- AWS技术博客 – 《EC2实例的CPU资源共享机制》

- Gartner报告 – 《2025年云计算关键技术趋势》