上一篇

kubernetes物理机

- 物理机

- 2025-08-10

- 23

Kubernetes支持物理机部署,通过裸金属架构实现高性能容器编排与

背景与核心概念解析

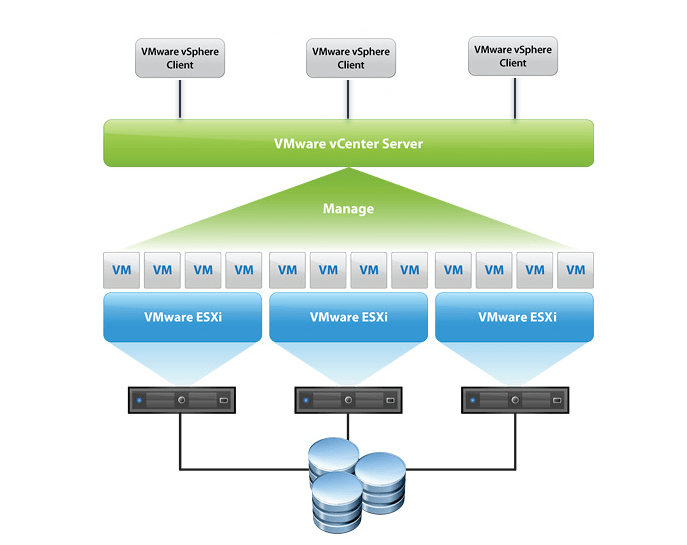

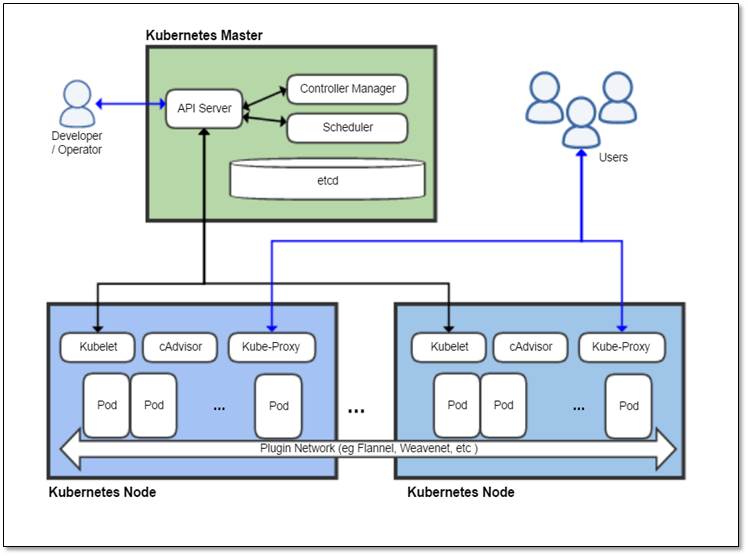

Kubernetes(K8s) 作为容器编排领域的事实标准,其底层运行环境传统上基于虚拟化平台(如VMware vSphere、OpenStack),但随着业务对性能、成本及定制化需求的提升,直接将Kubernetes运行于物理机的场景逐渐增多,此处的“物理机”指未经过虚拟化的裸金属服务器(Bare Metal Server),通过特定技术实现操作系统与硬件资源的直接交互,这种模式结合了容器轻量化与物理机高性能的优势,适用于AI训练、大数据处理、高频交易等对算力敏感的场景。

为何选择物理机承载Kubernetes?

| 维度 | 传统虚拟机方案 | 物理机直连方案 | 关键差异 |

|---|---|---|---|

| 性能损耗 | 存在Hypervisor层开销(CPU/内存抢占约5%-15%) | 无中间层,硬件资源全量透传 | 物理机可降低延迟30%以上 |

| 资源隔离性 | 依赖VMM实现严格隔离 | 需通过命名空间/cgroups控制资源配额 | 物理机需更精细的资源调度策略 |

| 部署复杂度 | 自动化工具链成熟(Ansible+Terraform) | 需手动处理RAID卡、HBA卡等硬件适配 | 初期配置时间增加40%-60% |

| 故障域 | 单宿主机宕机会影响多个VM实例 | 单物理机故障仅影响自身承载POD | 容灾设计需采用跨机房冗余部署 |

| TCO(总拥有成本) | 长期受License费用制约 | 一次性硬件投入+开源软件栈 | 三年期成本可降低25%-40% |

典型适用场景包括:① 边缘计算节点需极致I/O吞吐;② 科学计算任务要求GPU显存直通;③ 金融交易系统对网络延迟敏感;④ 私有云建设追求最高性价比。

物理机集群搭建全流程

硬件选型与拓扑规划

- 基础配置建议:每节点≥2颗Intel Xeon Gold系列CPU、128GB DDR4 ECC内存、NVMe SSD做系统盘+SAS HDD做持久化存储

- 网络架构:推荐采用万兆以太网+RDMA技术,通过SR-IOV实现网卡虚拟化直通

- 存储方案:本地磁盘LVM卷组(适合小规模集群) vs. 分布式块存储(Ceph/Sheepdog,适合大规模集群)

- 典型拓扑示例:

| 节点类型 | 数量 | CPU核数 | 内存容量 | 存储介质 | 特殊硬件 |

|———-|——|———|———-|—————-|——————-|

| Master | 3 | 16C | 64GB | 2×960GB SSD | 冗余电源模块 |

| Worker | 10 | 32C | 128GB | 4×3.84TB HDD+2×960GB SSD | GPU加速卡(可选) |

操作系统与驱动准备

- 推荐OS:CentOS/RHEL 8.x(内核版本≥5.4)、Ubuntu 20.04 LTS

- 关键驱动安装:

- Mellanox OFED驱动(用于InfiniBand高速网络)

- Intel IOMMU驱动(启用VT-d实现设备直通)

- LSI MegaRAID SAS控制器驱动(若使用硬件RAID卡)

- 内核参数调优:

vm.overcommit_memory=1、net.core.somaxconn=65535等

Kubernetes组件部署

- 初始化方式:优先采用

kubeadm init --config custom-config.yaml进行定制化初始化 - 核心组件分布:

- API Server/ETCD:部署于负载均衡后的Master节点群

- Control Plane组件:按高可用模式跨Master节点部署

- Workers节点:通过

kubelet --feature-gates=...启用DevicePlugins特性

- 设备插件集成:编写CustomResourceDefinition(CRD)注册GPU/FPGA设备,示例片段:

apiVersion: deviceplugin.kubernetes.io/v1alpha1 kind: DevicePlugin metadata: name: nvidia-gpu-plugin spec: resourceName: nvidia.com/gpu devicePaths: [/dev/dri/renderD128]

网络与存储解决方案

- CNI插件选择:

- Calico(基于BGP的三层路由,适合跨AZ部署)

- Flannel(简单易用,适合扁平化网络)

- Multus CNI(支持多网卡绑定,满足SR-IOV需求)

- CSI存储集成:

- Local Path Provisioner(管理本地磁盘)

- Rook Ceph(构建统一存储池)

- OpenEBS(提供动态卷供给)

运维管理要点

监控告警体系

- 指标采集:Prometheus+NodeExporter监控硬件状态(温度、风扇转速、电源状态)

- 日志聚合:Fluentd收集所有节点日志至Elasticsearch,设置关键词触发告警

- 健康检查:每日执行

kubectl get nodes核查Ready状态,使用nmon工具监测TOP进程

安全防护措施

- 访问控制:RBAC授权体系+PodSecurityPolicy限制特权容器

- 破绽扫描:Clair定期扫描镜像,Trivy检测运行时容器破绽

- 数据加密:ETCD启用静态加密(–encryption-provider-config),TLS终止于API Server前端

升级与扩缩容

- 滚动升级:依次更新Master→Etcd→Worker节点,保持至少N-1个节点可用

- 横向扩展:新增物理机时需同步更新CA证书、加入etcd集群、注册到DNS服务发现

- 纵向扩展:替换旧节点时采用Drain+Delete+Join流程,确保业务连续性

常见挑战与应对策略

| 挑战类型 | 现象描述 | 解决方案 |

|---|---|---|

| PXE启动失败 | 新物理机无法从iLO/iDRAC获取启动镜像 | 检查DHCP作用域配置,验证TFTP服务器连通性 |

| IOMMU分组冲突 | PCI设备无法被容器独占 | 在BIOS中开启IOMMU并设置合理分组大小 |

| 磁盘空间碎片化 | LVM卷组剩余空间不足导致调度失败 | 定期执行pvresize扩展物理卷,优化PV分配策略 |

| 网络丢包 | 跨交换机通信出现UDP校验和错误 | 关闭网卡节能模式,调整MTU值为1500 |

| 时钟同步偏差 | Chrony服务无法同步NTP时间 | 配置ptp4l同步PTP时钟,禁用虚拟化时钟源 |

相关问答FAQs

Q1: 如何在不重启物理机的情况下热插拔硬盘?

A: 需满足三个条件:① 主板支持AHCI/SAS模式;② 操作系统已加载相应驱动模块;③ Kubelet配置volumeAttachmentTimeout≥300秒,操作步骤:先通过lsblk确认新磁盘识别,执行parted新建分区→mkfs格式化→创建PV卷,最后通过CSI驱动自动挂载。

Q2: 物理机集群能否混合使用不同型号的CPU?

A: 可以但需注意两点:① 确保所有CPU均支持相同的指令集扩展(如AVX2);② 在Pod反亲和性规则中添加nodeSelector标签区分架构类型,建议同一工作负载尽量部署在同代CPU上,避免