上一篇

PVE虚拟机最多能直通多少张网卡?

- 物理机

- 2025-06-06

- 4254

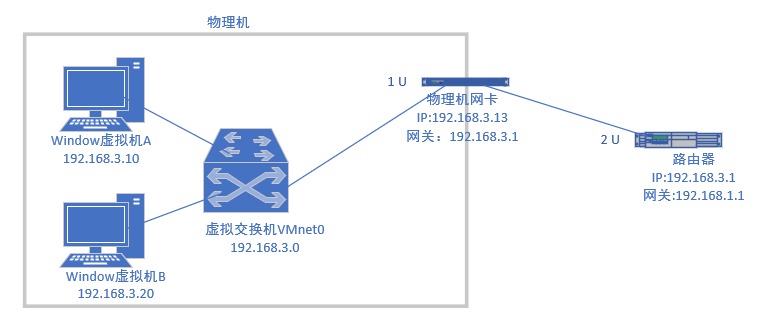

PVE虚拟机可通过PCIe直通直接使用物理网卡,需硬件支持SR-IOV/VT-d,单个虚拟机最多可直通多个网卡(通常受限于PCIe插槽和系统资源),直通后该网卡由虚拟机独占,绕过宿主机网络栈,显著提升网络性能。

深度解析Proxmox VE直通物理网卡的数量限制与实战方案

在Proxmox VE(PVE)环境中实现物理网卡直通(PCI Passthrough),能大幅提升虚拟机网络性能,消除虚拟化层带来的延迟和CPU开销,对于需要低延迟、高吞吐量的应用场景至关重要。

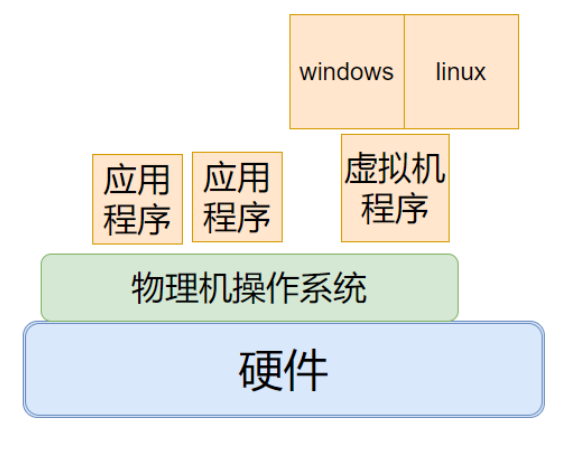

一、物理网卡直通的核心原理

物理网卡直通是将宿主机的物理PCIe设备(如网卡)绕过Hypervisor层,直接分配给特定虚拟机使用的技术:

- IOMMU技术支持:Intel VT-d或AMD-Vi技术实现物理地址转换与设备隔离

- 直接硬件访问:虚拟机获得网卡100%控制权,性能接近物理机

- 中断处理优化:虚拟机直接处理网络中断,减少上下文切换

# 检查系统IOMMU支持状态 (PVE Shell) dmesg | grep -e DMAR -e IOMMU -e AMD-Vi # 预期输出示例: [ 0.000000] DMAR: IOMMU enabled [ 0.000000] AMD-Vi: IOMMU performance counters supported

️ 二、网卡直通的硬件限制因素

CPU与芯片组限制

| CPU品牌 | 必需技术 | 最大直通通道数 |

|---|---|---|

| Intel | VT-d技术 | 16个设备 |

| AMD | AMD-Vi | 16个设备 |

注:实际数量受主板PCIe通道数限制(如消费级主板通常16-20条,服务器主板可达128条)

IOMMU分组约束

# 查看IOMMU分组情况 (关键命令)

for d in /sys/kernel/iommu_groups/*/devices/*; do

n=${d#*/iommu_groups/*}; n=${n%%/*}

printf 'IOMMU Group %s ' "$n"

lspci -nns "${d##*/}"

done

- 独立分组:网卡独占一个IOMMU Group才支持直通

- 组内捆绑:若多设备同组,需同时直通组内所有设备(不实用)

物理插槽与拓扑限制

- PCIe插槽数量上限(主板物理限制)

- PCIe通道分配策略(x16插槽拆分为x8/x8或x4/x4/x4/x4)

- 网卡类型(单口/多口,4口网卡占用1个PCIe插槽=4个直通设备)

️ 三、软件层配置上限与突破方案

内核参数优化

编辑 /etc/default/grub:

# Intel CPU配置示例 GRUB_CMDLINE_LINUX_DEFAULT="quiet intel_iommu=on iommu=pt pcie_acs_override=downstream" # AMD CPU配置示例 GRUB_CMDLINE_LINUX_DEFAULT="quiet amd_iommu=on iommu=pt pcie_acs_override=downstream"

关键参数解析:

pcie_acs_override=downstream:突破IOMMU分组限制(有安全风险)iommu=pt:仅对直通设备启用IOMMU- 更新后执行

update-grub并重启

虚拟机配置文件修改

直通设备ID写入VM配置(/etc/pve/qemu-server/VMID.conf):

# 直通示例(多个网卡重复添加) hostpci0: 01:00.0,pcie=1,rombar=0 hostpci1: 03:00.0,pcie=1,rombar=0

四、实战配置案例:8口网卡直通拓扑

环境配置:

- 服务器:Supermicro X11主板(64条PCIe通道)

- CPU:Intel Xeon Silver 4210(支持VT-d)

- 网卡:2张Intel I350-T4(4口千兆) + 1张Mellanox ConnectX-4(双口25G)

直通方案:

graph TD

A[PVE宿主机] --> B[VM1-防火墙 pfSense]

A --> C[VM2-存储服务器 TrueNAS]

A --> D[VM3-应用服务器 Ubuntu]

B --> |直通 I350-T4端口1-4| B

C --> |直通 Mellanox端口1| C

D --> |直通 Mellanox端口2| D

️ 五、直通网卡数量优化策略

- SR-IOV高级方案:

- 单张支持SR-IOV的网卡可虚拟化为多个VF(Virtual Function)

- 示例:Intel X710网卡可创建≤64个VF,每个VF独立直通

- PCIe拆分技术:

- 使用PCIe Switch芯片扩展(如PLX系列)

- x16插槽拆分为4个x4通道(需主板支持)

- 硬件选购建议:

- 服务器主板 > 消费级主板(通道数更多)

- 多口网卡 > 单口网卡(节省PCIe插槽)

- 优选支持SR-IOV的型号(Intel 82599/X710, Mellanox ConnectX)

️ 六、关键注意事项

- 直通后宿主机无法使用该网卡(包括管理接口)

- ACS补丁(

pcie_acs_override)降低安全性,生产环境慎用 - Windows虚拟机需提前注入驱动(virtio-win驱动)

- 直通网卡的热插拔支持有限(建议关机操作)

理论上PVE支持直通的物理网卡数量=可用PCIe设备数,实际受限于:

- CPU/芯片组IOMMU能力

- 主板PCIe通道总数

- IOMMU分组隔离情况

- 内核参数配置优化

通过SR-IOV技术、ACS补丁、多口网卡选型,可在单台PVE服务器实现12+物理网口直通,建议生产环境部署前,使用lspci和dmesg工具详细验证硬件兼容性,并逐步增加直通设备进行稳定性测试。

参考资料

- Proxmox VE官方文档 – PCI Passthrough章节 (pve.proxmox.com)

- Linux Kernel Documentation – IOMMU特性说明 (kernel.org)

- Intel VT-d技术白皮书 – 设备直通架构 (intel.com)

- Red Hat虚拟化文档 – SR-IOV配置指南 (access.redhat.com)