上一篇

GPU云服务器是否真能带来极致性能体验?

- 行业动态

- 2025-05-01

- 3

GPU云服务器通过高性能显卡集群提供强大的并行计算能力,适用于深度学习训练、科学模拟及图形渲染等场景,其弹性资源可按需扩展,用户无需购置硬件,大幅降低运维成本,支持远程灵活调用,显著提升数据处理效率与项目部署便捷性。

什么是GPU云服务器?

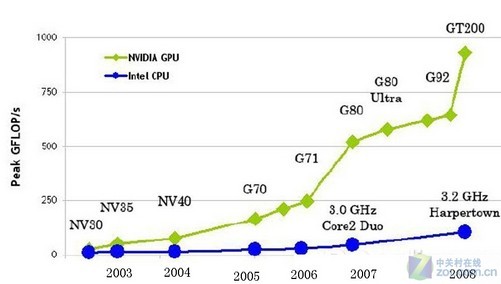

GPU云服务器是基于云计算技术提供的虚拟化服务,配备高性能图形处理器(GPU),能够加速计算密集型任务,与传统CPU服务器相比,GPU凭借其并行计算能力,在处理人工智能训练、深度学习、3D渲染、科学模拟等任务时效率提升数十倍甚至百倍,用户无需购买物理设备,即可按需租用算力,灵活控制成本。

为什么选择GPU云服务器?

- 高性能计算:以NVIDIA A100、V100等旗舰显卡为例,单卡可提供每秒数百万亿次浮点运算(TFLOPS),训练复杂AI模型的时间可从数天缩短至几小时。

- 成本优化:按需付费模式避免硬件闲置,中小企业和开发者能以更低门槛使用顶级算力,训练一个图像分类模型,单小时成本可低至3-5元(不同厂商定价差异)。

- 灵活扩展:支持秒级扩容,应对突发算力需求,比如电商大促期间的实时推荐系统,可快速增加GPU实例数量。

- 高可靠性:云服务商提供99.95%以上的可用性承诺,数据备份、容灾方案保障业务连续性。

适用场景深度解析

- AI与机器学习

训练大规模神经网络(如GPT-3、Stable Diffusion)需海量算力,单台物理服务器难以满足,云上GPU集群可分布式训练,提升效率,案例:某自动驾驶公司通过GPU云服务将模型迭代周期从1周压缩至8小时。 - 科学计算与仿真

气候模拟、基因测序等任务依赖高精度计算,GPU加速可将仿真时间从数月缩短至数天。 - 影视与游戏渲染

单帧4K特效渲染通常需数小时,采用云上多GPU并行渲染,效率提升5-10倍,某动画工作室借助云端算力,将项目交付周期减少60%。 - 医疗与金融分析

GPU加速药物分子筛选、高频交易策略回测,帮助机构快速决策。

如何选择GPU云服务器?

服务商对比

- 阿里云:提供含光800、A10等多型号,配套PAI机器学习平台,适合企业级AI应用。

- 酷盾:GN10x系列支持NVIDIA Tesla T4,性价比突出,适合中小规模训练。

- AWS EC2:P4实例配备A100 GPU,与SageMaker深度集成,适合全球化团队。

- 新兴厂商(如UCloud、Lambda)价格更低,但需关注稳定性。

配置选择指南

- GPU型号:

- 训练大模型:选A100/H100(显存≥80GB)

- 推理任务:T4或A10(兼顾能效比)

- 内存与存储:建议内存≥GPU显存的2倍,NVMe SSD加速数据读取。

- 网络带宽:分布式训练需25Gbps以上内网带宽,避免通信瓶颈。

- GPU型号:

用户体验真实反馈

- 开发者@TechLead:“在AWS上部署BERT模型训练,8块V100 GPU并行,成本比自建机房低30%,且无需维护硬件。”

- 设计师Luna:“使用酷盾实时渲染,4K场景导出时间从3小时降到20分钟,项目交付速度大幅提升。”

- 科研团队负责人:“阿里云的RDMA网络让多节点GPU协作效率超预期,论文实验周期缩短40%。

未来趋势:GPU云服务的革新方向

- 边缘GPU计算:将算力下沉至靠近数据源的边缘节点,降低延迟(如智慧工厂实时质检)。

- 绿色节能:服务商通过液冷技术降低PUE值,部分数据中心PUE已低于1.1。

- 混合云架构:企业核心数据存于私有云,峰值算力调用公有云GPU,平衡安全与弹性。

常见问题解答(FAQ)

Q1:GPU云服务器和物理服务器如何选择?

A:短期项目或波动需求选云服务;长期稳定高负载(如矿机)可考虑自建。

Q2:如何避免算力浪费?

A:使用监控工具(如Prometheus)分析资源利用率,设置自动伸缩策略。

Q3:是否支持跨区域GPU集群?

A:主流厂商支持全球节点调度,但需注意数据传输成本(如AWS跨区流量费)。

Q4:数据安全性如何保障?

A:选择通过等保三级、ISO27001认证的服务商,结合VPC私有网络+加密存储。

引用说明

- NVIDIA官方性能白皮书:https://www.nvidia.com/en-us/data-center/

- Gartner 2025云服务报告:https://www.gartner.com/reviews/market/public-cloud-iap

- IDC全球算力指数预测(2025-2027)