上一篇

分布式架构云原生资源

- 行业动态

- 2025-05-09

- 2

分布式架构通过云原生资源实现弹性扩展与高效运维,依托容器化、微服务及自动化编排,优化资源利用率

分布式架构与云原生资源深度解析

分布式架构的核心特征与演进路径

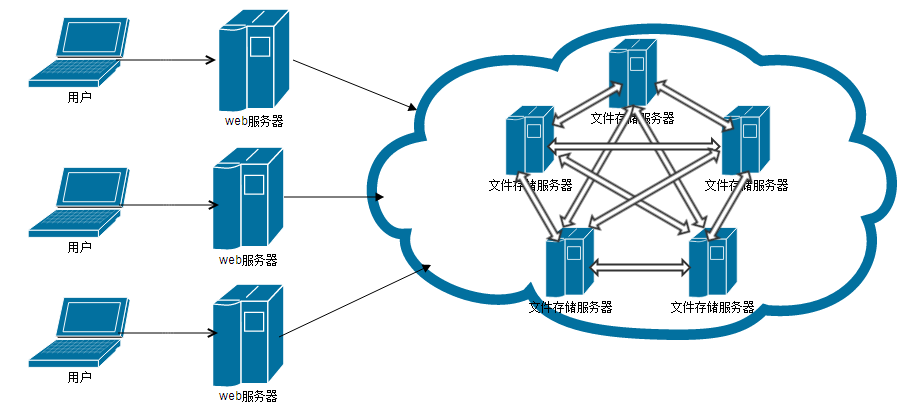

分布式架构通过将系统拆分为多个独立服务模块,利用网络协同实现高性能、高可用和弹性扩展,其核心特征包括:

- 无状态设计:服务节点不依赖本地存储状态

- 水平扩展能力:通过增加节点实现算力线性增长

- 容错机制:自动故障转移与数据副本保障

- 去中心化治理:通过注册中心实现服务发现

演进路径经历了从单体架构→垂直拆分→SOA→微服务→Serverless的迭代过程,当前主流技术栈包含:

- 容器化技术(Docker/Podman)

- 服务网格(Istio/Linkerd)

- 不可变基础设施(Terraform/Ansible)

- 混沌工程(Chaos Monkey/Gremlin)

云原生资源体系架构

云原生资源管理围绕以下四个维度构建:

| 资源类型 | 典型代表 | 核心功能 |

|---|---|---|

| 计算资源 | Kubernetes Node/Pod | 工作负载调度与生命周期管理 |

| 存储资源 | CSI驱动/Rook/Portworx | 持久化数据存储与动态扩容 |

| 网络资源 | Cilium/Calico/Flannel | 服务间通信与安全策略实施 |

| 观测资源 | Prometheus/Grafana/ELK | 全链路监控与日志分析 |

关键资源管理组件详解

容器编排引擎

- Kubernetes已成为事实上的标准,通过Deployment/StatefulSet等控制器实现:

- 自动扩缩容(HPA/VPA)

- 滚动升级与回滚

- 资源配额管理(ResourceQuota/LimitRange)

- 调度算法优化方向:

- 拓扑感知调度

- 亲和性/反亲和性策略

- GPU/FPGA异构资源调度

- Kubernetes已成为事实上的标准,通过Deployment/StatefulSet等控制器实现:

服务发现与负载均衡

- 服务网格实现方式对比:

| 实现模式 | 代表框架 | 数据平面 | 控制平面 |

|—————-|—————-|——————–|——————–|

| Sidecar代理 | Istio/Linkerd | Envoy/Proxy | Pilot/Control Plane|

| SDK嵌入 | OpenTelemetry | 轻量级Agent | 中央采集系统 | - 流量管理策略:

- 蓝绿部署与金丝雀发布

- 熔断降级(Hystrix模式)

- 自适应路由(基于延迟/错误率)

- 服务网格实现方式对比:

存储抽象层

- 容器存储接口(CSI)规范实现:

- 动态供给(StorageClass)

- 快照与克隆(VolumeSnapshot)

- 数据保护(Replication/Backup)

- 存储分类:

| 存储类型 | 适用场景 | 典型方案 |

|—————-|—————————|————————-|

| 块存储 | 数据库/状态服务 | AWS EBS/Azure Disk |

| 文件存储 | 共享配置/临时文件 | NFS/CephFS |

| 对象存储 | 静态资源/归档数据 | S3/MinIO |

- 容器存储接口(CSI)规范实现:

资源调度优化策略

集群自动伸缩

- 基于指标的弹性策略:

- Cluster Autoscaler(CA)监控节点组

- Vertical Pod Autoscaler(VPA)调整资源请求

- 成本优化模型:

# 简化版成本函数示例 def cost_optimization(cpu_util, mem_util, spot_price): if (cpu_util > 80% or mem_util > 75%) and spot_price < ondemand_price0.7: return "启动Spot实例" else: return "维持现有规模"

- 基于指标的弹性策略:

资源隔离与质量保证

- Kubernetes资源配额机制:

apiVersion: v1 kind: ResourceQuota metadata: name: compute-quota spec: hard: requests.cpu: "4" requests.memory: 8Gi limits.cpu: "10" limits.memory: 20Gi count/pods: 20 - 服务质量保障(QoS)等级:

| QoS类别 | CPU/Memory请求设置 | 优先级 |

|—————|——————–|—————–|

| Guaranteed | = Request=Limit | 最高(不可驱逐)|

| Burstable | Request<Limit | 中等 |

| BestEffort | 无请求 | 最低(优先驱逐)|

- Kubernetes资源配额机制:

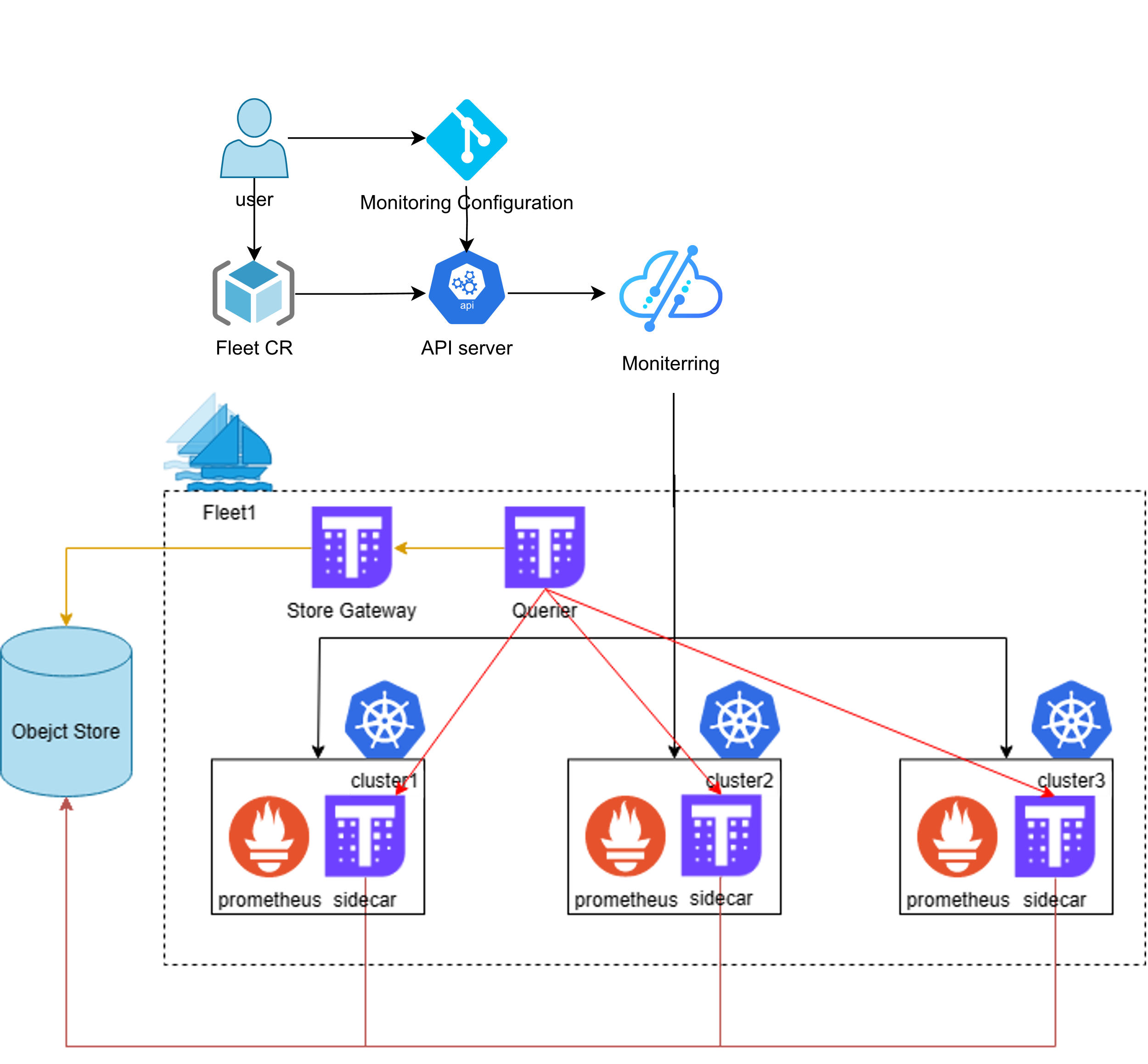

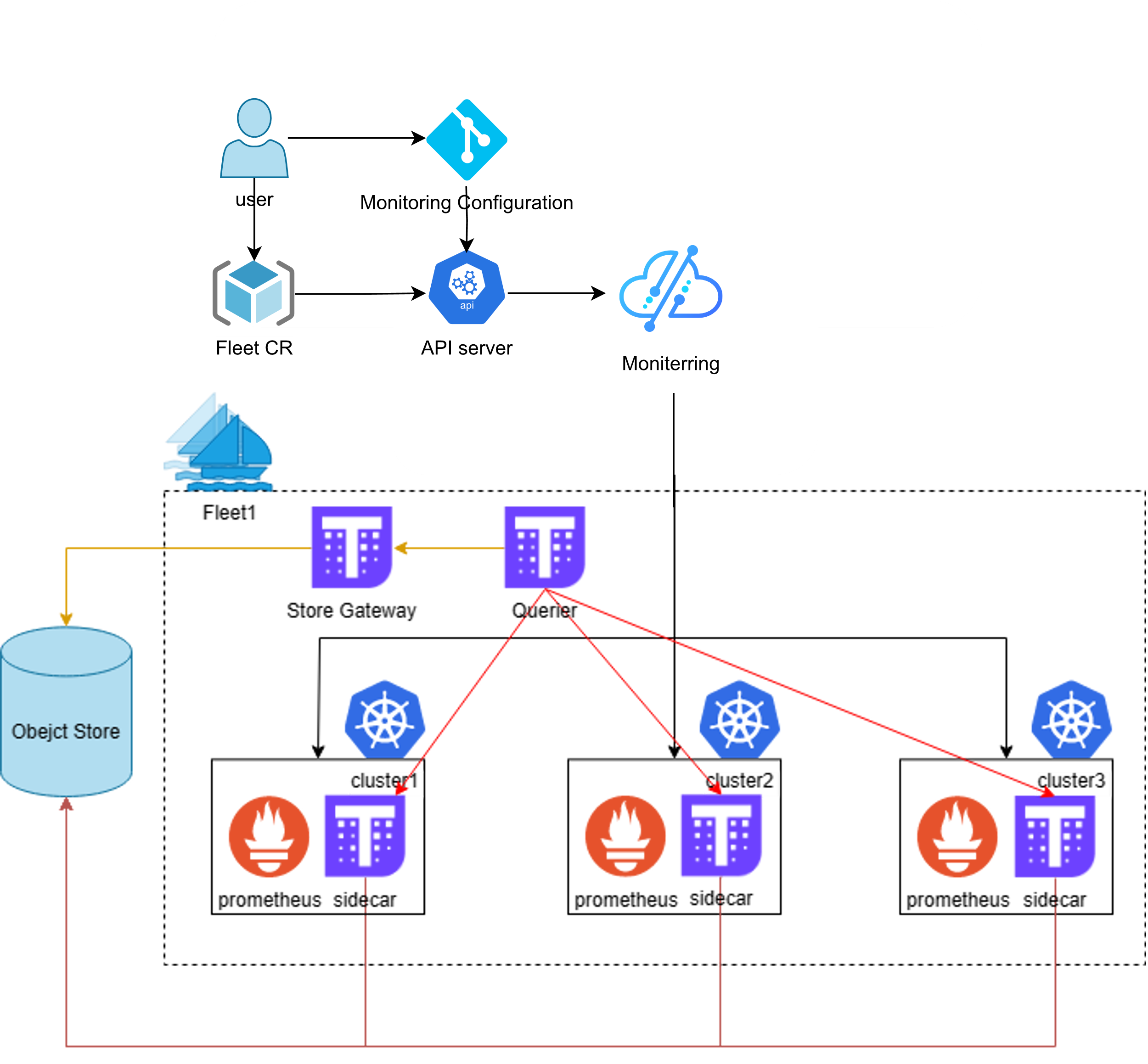

混合云场景下的资源管理

多云资源抽象层

- 通过Cross-plane Federation实现:

- 集群联邦(KubeFed)

- 服务网格跨域连接(Istio Multi-cluster)

- 统一监控面板(Prometheus Thousand Eyes)

- 通过Cross-plane Federation实现:

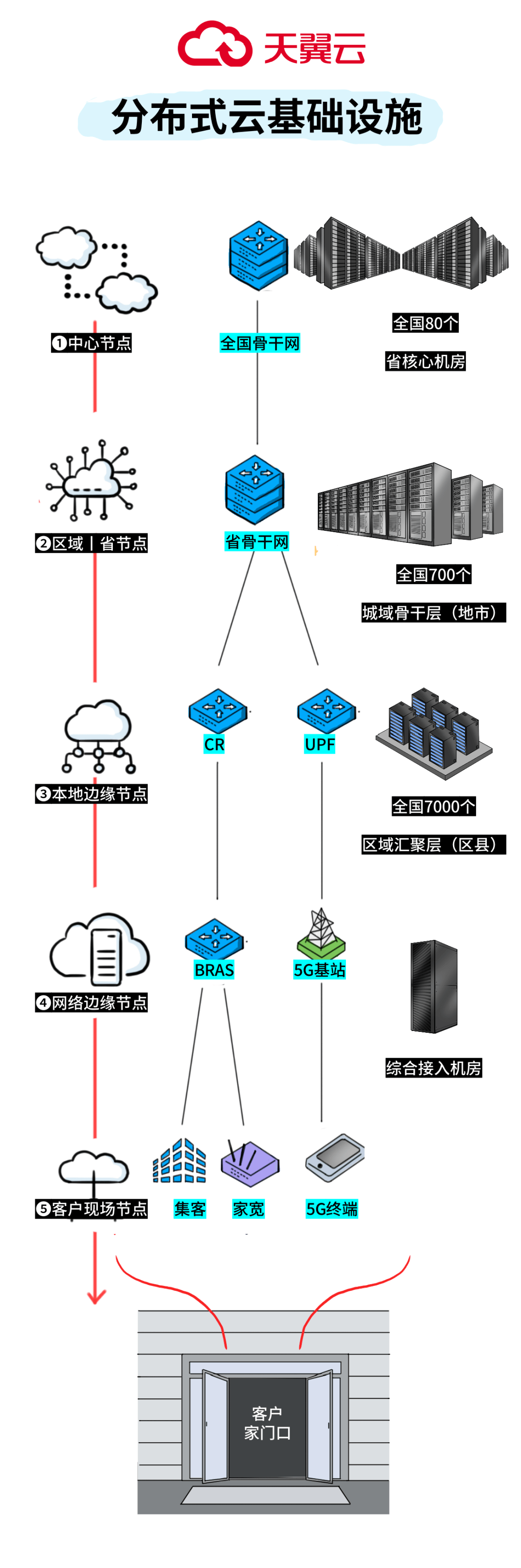

边缘计算资源适配

- 轻量化运行时:

- K3s(Rancher精简版)

- MicroK8s(Canonical解决方案)

- 中断容忍设计:

- 网络分区检测(TCP BBR算法)

- 本地缓存策略(ServiceMesh本地断路器)

- 轻量化运行时:

典型应用场景实践

微服务架构资源分配

- 基于服务拓扑的资源染色:

graph TD A[API网关] --> B[用户服务] A --> C[订单服务] B --> D[库存服务] C --> D D --> E[支付服务] style A fill:#f9f,stroke:#333,stroke-width:2px;

- 资源分配策略:

- 核心服务(支付/订单):Guaranteed QoS + 多AZ部署

- 边缘服务(缓存/推荐):Burstable QoS + 自动缩放

- 基于服务拓扑的资源染色:

AI训练任务资源优化

- 参数服务器架构资源分配:

| 组件类型 | CPU/GPU需求 | 网络带宽 | 存储类型 |

|—————-|————-|———-|——————-|

| 参数服务器 | 低CPU/高GPU | 高带宽 | NVMe SSD(参数存储)|

| 计算节点 | 高CPU/GPU | 中带宽 | 本地SSD(Checkpoint)|

| 数据预处理节点 | 高CPU | 低带宽 | HDD/对象存储 | - 混合精度训练资源节省:

- FP16计算节省50%显存

- 梯度压缩减少30%网络带宽

- 参数服务器架构资源分配:

挑战与应对方案

资源碎片化问题

- 症状表现:

- 节点资源利用率低于60%但无法调度新任务

- 频繁出现PEP(Pod Eviction Protection)告警

- 解决方案:

- 集群拓扑感知调度(Topology-aware scheduling)

- 空闲资源回收(Idle resource reclaiming)

- 工作负载合并(Co-location scheduling)

- 症状表现:

多租户资源隔离

- 安全风险:

- Noisy Neighbor效应

- 数据泄露风险

- 防护措施:

- Kata Containers(虚拟机+容器混合模式)

- 硬件虚拟化隔离(Intel VT-d/AMD-Vi)

- SELinux/AppArmor策略强化

- 安全风险:

FAQs

Q1:云原生架构下如何实现跨AZ(可用区)的高可用部署?

A1:需结合以下技术实现多可用区容灾:

- 使用StatefulSet部署有状态服务,配置multi-zone拓扑

- 启用Kubernetes的Pod Anti-Affinity规则

- 采用跨AZ的负载均衡器(如ALB的跨可用区模式)

- 数据库采用同步复制+异步备份策略(如PostgreSQL的Streaming Replication)

- 配置PDB(Pod Disruption Budget)限制故障影响范围

Q2:在混合云环境中如何统一管理不同云厂商的资源?

A2:可采取以下方案:

- 使用CNCF认证的多云管理平台(如Clusternet/OpenShift ManagedCluster)

- 通过Terraform provider抽象不同云的API差异

- 建立统一的监控体系(Prometheus联邦集群+Grafana多数据源)

- 实施策略中心化管理(GitOps+ArgoCD实现配置同步)

- 采用CNI插件兼容多云网络(如Calico支持AWS/