上一篇

hive元数据存储在

- 行业动态

- 2025-05-09

- 4

Hive元数据存储于关系型数据库(如MySQL、PostgreSQL等)中,包含数据库、表结构、分区及权限等信息,不同部署场景下可选择不同

Hive作为大数据领域的核心组件之一,其元数据管理机制直接影响集群的稳定性和可维护性,本文将从存储架构、配置实践、容灾方案等维度深入解析Hive元数据存储的关键技术细节,并提供生产环境最佳实践。

Hive元数据核心概念

Hive元数据包含以下关键信息:

| 类别 | 示例内容 |

|——-|———-|

| 数据库对象 | 库(database)、表(table)、分区(partition)、字段(column) |

| 存储属性 | 文件格式(ORC/Parquet)、存储引擎(HDFS/S3)、压缩算法 |

| 权限体系 | 用户/角色权限、HDFS路径映射关系 |

| 事务日志 | ACID事务记录、时间戳标记 |

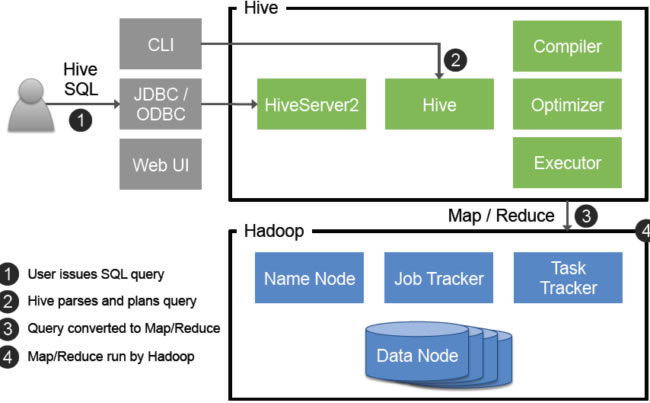

这些元数据通过Thrift服务接口对外提供,是Hive编译执行计划、解析SQL的核心依据。

默认存储机制与局限性

Hive默认采用内嵌式Apache Derby数据库存储元数据,该模式仅适用于开发测试环境:

-Derby元数据存储路径示例 /user/hive/warehouse/metastore_db/

主要限制:

- 单进程限制:Derby不支持多客户端并发访问

- 性能瓶颈:嵌入式数据库处理高并发请求时延迟显著

- 扩展性缺陷:无法横向扩展,存在单点故障风险

- 存储容量:默认配置仅支持GB级元数据存储

生产级元数据存储方案

关系型数据库选型

| 数据库类型 | 推荐版本 | 驱动配置 | 优势 |

|---|---|---|---|

| MySQL | 7+ | com.mysql.jdbc.Driver | 社区支持完善,性能稳定 |

| PostgreSQL | 12+ | org.postgresql.Driver | 事务性强,地理分布式支持 |

| Oracle | 12c+ | oracle.jdbc.driver.OracleDriver | 企业级特性丰富 |

| SQL Server | 2017+ | com.microsoft.sqlserver.jdbc.SQLServerDriver | Windows生态集成 |

配置示例(MySQL):

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://metastore-host:3306/hive_metastore?createDatabaseIfNotExist=true</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>metastore_user</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>secure_password</value> </property>

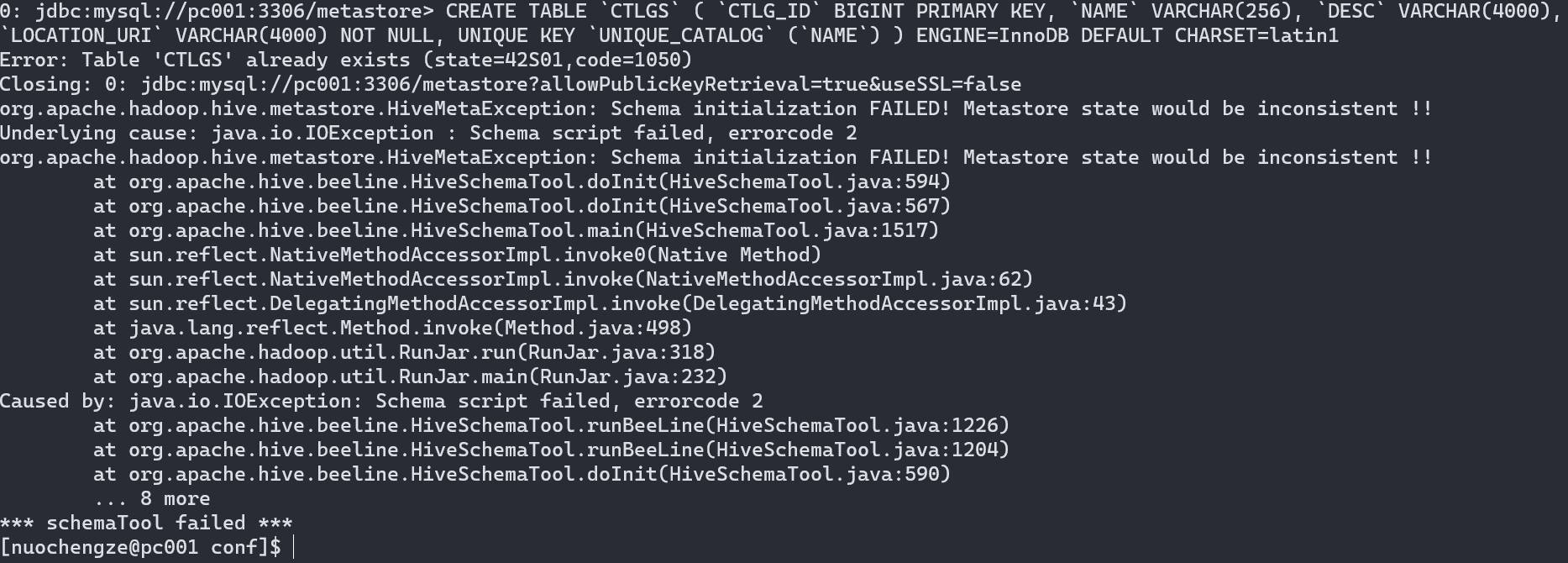

初始化配置流程

# 1. 创建数据库实例 mysql -u root -p -e "CREATE DATABASE hive_metastore;" # 2. 授予权限 grant all privileges on hive_metastore. to 'metastore_user'@'%' identified by 'password'; # 3. 配置Hive环境变量 export HIVE_HOME=/opt/hive export CLASSPATH=`$HIVE_HOME/bin/hive --auxpath`:$CLASSPATH # 4. 初始化元数据库 schematool -initSchema -dbType mysql

元数据高可用架构

双活节点部署方案

graph TD

A[Client] --> B{Load Balancer}

B --> C[Metastore Node 1]

B --> D[Metastore Node 2]

C -.-> E[MySQL Cluster]

D -.-> E

E --> F[MySQL Secondary Node]关键配置:

- 启用MySQL GTID复制模式

- 配置Keepalived实现VIP漂移

- Hive客户端配置多数据源连接池

Zookeeper协调方案

<property> <name>hive.metastore.ha.zookeeper.quorum</name> <value>zk1:2181,zk2:2181,zk3:2181</value> </property> <property> <name>hive.metastore.ha.uris</name> <value>thrift://metastore1:9083,thrift://metastore2:9083,thrift://metastore3:9083</value> </property>

元数据备份与恢复策略

全量备份方案

# MySQL物理备份(推荐) mysqldump -u metastore_user -p --all-databases --routines --events > /backup/hive_metastore_$(date +%F).sql # 逻辑备份(应急使用) hive -e "USE metastore_database; SCRIPT;" > /backup/hive_metastore.hql

增量备份实现

-创建心跳表记录变更 CREATE TABLE metastore_heartbeat ( id BIGINT PRIMARY KEY, update_time TIMESTAMP DEFAULT CURRENT_TIMESTAMP, table_name STRING, operation_type STRING ); -定期捕获变更 INSERT INTO metastore_heartbeat (table_name,operation_type) SELECT 'tables', 'insert' FROM information_schema.tables WHERE update_time > last_backup_time;

灾难恢复流程

sequenceDiagram

participant Admin

participant RecoveryNode

participant MetastoreDB

Admin->>RecoveryNode: 挂载备份文件

RecoveryNode->>MetastoreDB: 执行mysql导入

Admin->>MetastoreDB: 验证版本兼容性

Admin->>HiveServices: 重启所有Beeline会话权限管理体系实现

Hive通过RBAC模型实现细粒度权限控制:

-创建安全角色 CREATE ROLE data_scientist; -绑定HDFS路径权限 GRANT ALL ON TABLE default.employee_data TO ROLE data_scientist; GRANT SELECT ON DIRECTORY /user/hive/warehouse/employee_stage TO ROLE data_scientist; -用户角色分配 GRANT ROLE data_scientist TO USER alice;

权限同步机制:

- 元数据变更触发HDFS ACL更新

- 使用Ranger/Sentry进行统一策略管理

- 定期执行权限审计脚本:

# 权限一致性检查示例 def audit_permissions(): hive_roles = hive.execute("SHOW ROLES") hdfs_acls = hdfs.getAcl("/user/hive/warehouse") for role in hive_roles: if not permission_mapping[role] in hdfs_acls: raise PermissionMismatchError(f"Role {role} missing HDFS mapping")

常见故障处理指南

| 故障现象 | 诊断方法 | 解决方案 |

|---|---|---|

| 元数据读取超时 | 检查Metastore日志中的TProtocolException | 优化JDBC连接池参数,增加maxConnections |

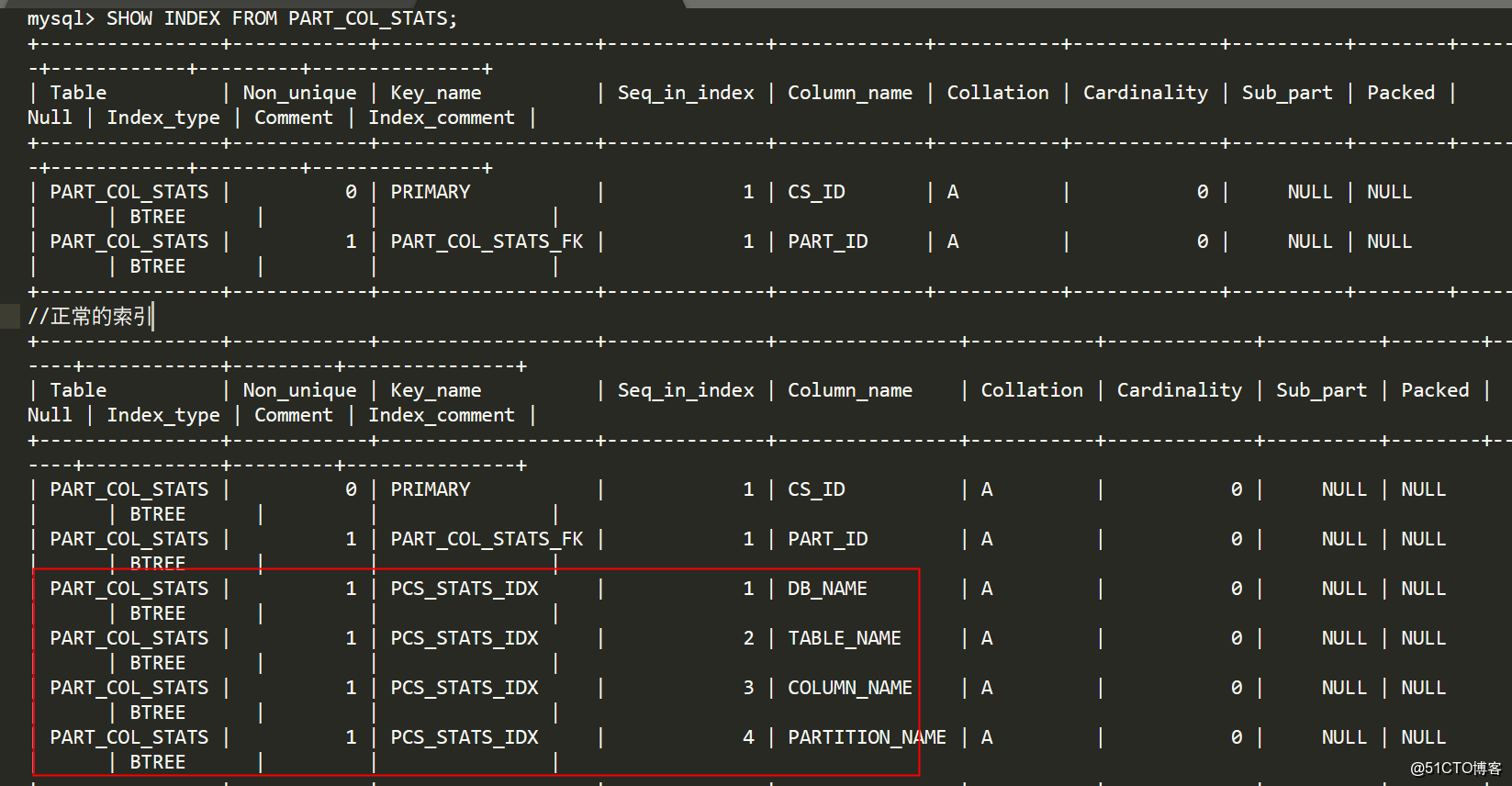

| 版本升级后不兼容 | 对比schemaVersion表 | 执行schematool -updateSchema升级脚本 |

| 跨集群迁移失败 | 校验UUID冲突 | 启用hive.metastore.event.db.notification.listener |

| 事务回滚异常 | 检查txn_components表状态 | 强制清理未决事务:DELETE FROM TXNS WHERE state=’OPEN’ |

FAQs

Q1: 如何将元数据库从MySQL迁移到PostgreSQL?

- 在源库执行逻辑备份:

mysqldump -R -u user -p --set-gtid-purged=OFF --single-transaction --databases hive_metastore > backup.sql - 修改导出文件的语法差异(如TINYINT转BOOLEAN)

- 在目标PostgreSQL创建同名数据库

- 使用pg_restore导入调整后的SQL文件

- 更新Hive配置文件中的JDBC连接参数

- 执行版本兼容性检查:

schematool -dbType postgres -info

Q2: 元数据服务宕机后如何快速恢复?

- 立即切换至备用Metastore节点(需提前配置HA)

- 如果无HA,启动备用服务器并指向相同数据库实例

- 检查Zookeeper中临时节点状态(若使用ZK协调)

- 重启HiveServer2和HMS服务

- 验证元数据完整性:

SELECT FROM version; - 监控HMS