hdfs节点间负载均衡迁移

- 行业动态

- 2025-05-09

- 4

HDFS通过Balancer工具实现节点间负载均衡,基于磁盘使用率差异,自动或手动迁移数据至低负载节点

HDFS节点间负载均衡迁移是分布式存储系统中确保资源合理利用和提升集群稳定性的关键环节,本文将从负载均衡触发条件、核心机制、迁移策略及实操要点四个维度展开分析,并通过对比表格揭示不同迁移方式的差异。

负载均衡触发条件与阈值计算

当HDFS集群中DataNode存储容量差异超过预设阈值时,系统会自动或手动触发负载均衡,Hadoop默认阈值为集群平均存储使用率的±10%,具体计算公式为:

阈值上限 = 平均使用率 + 10%

阈值下限 = 平均使用率 10%集群平均使用率为65%时,超过75%的节点会向低于55%的节点迁移数据,该阈值可通过dfs.balance.threshold参数调整(取值范围0.0-1.0)。

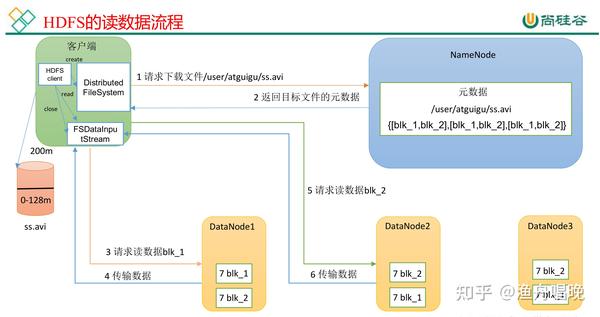

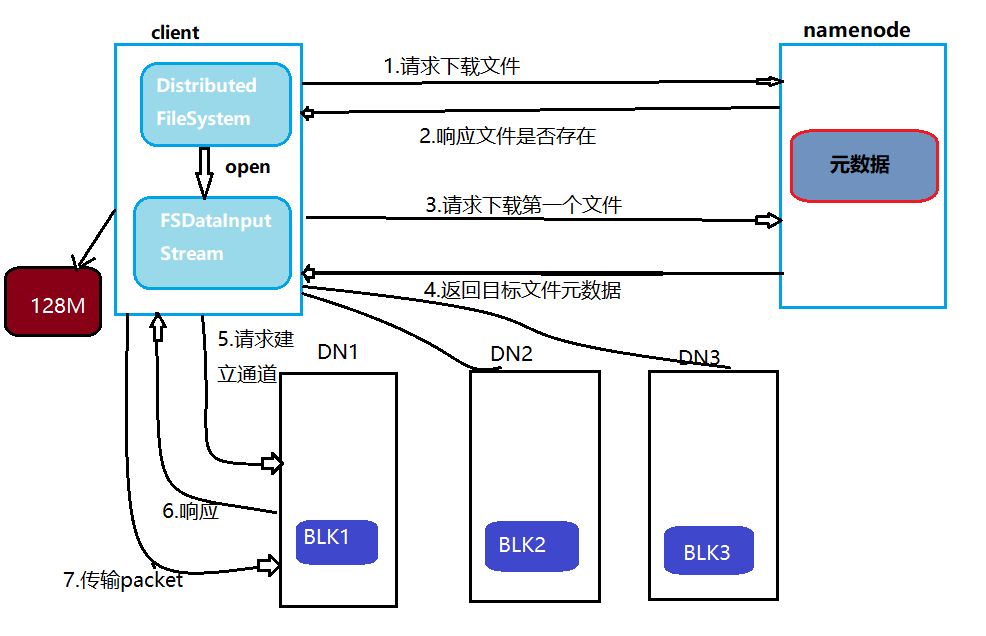

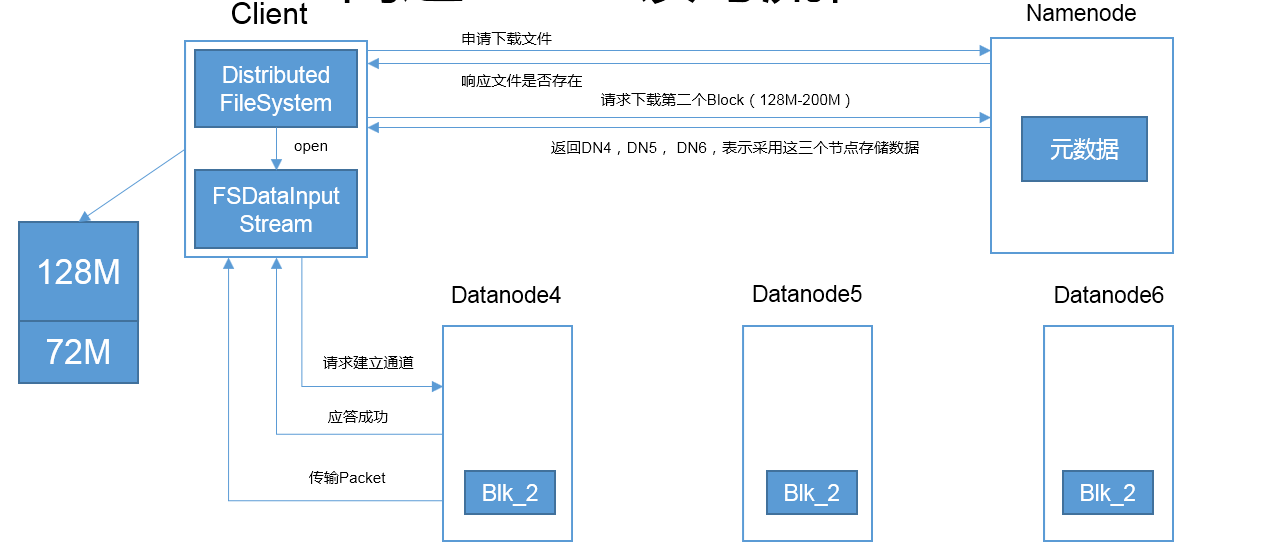

Balancer工具的核心工作机制

HDFS自带的Balancer工具采用三级迁移策略:

- 源节点筛选:选择存储利用率超过上限的DataNode

- 目标节点匹配:寻找存储利用率低于下限且网络拓扑最近的节点

- 块迁移决策:

- 优先迁移大尺寸块(>128MB)

- 排除正在被写入的块

- 跳过已达到副本数的块

迁移过程采用流式复制技术,通过HTTP POST协议传输数据块,同时更新NameNode元数据,整个过程分为扫描、计划、执行三个阶段,默认并发线程数为4。

手动迁移与自动迁移对比

| 特征 | 自动Balancer | 手动迁移 |

|---|---|---|

| 触发方式 | 定时任务/阈值触发 | 人工干预 |

| 迁移粒度 | 块级别精细控制 | 目录/文件级操作 |

| 网络带宽占用 | 动态自适应 | 需人工限速 |

| 回滚能力 | 自动补偿机制 | 依赖手动恢复 |

| 适用场景 | 常规负载均衡 | 紧急扩容/缩容 |

生产环境实操指南

迁移前准备

- 检查网络连通性:确保源/目标节点间MTU≥1500字节

- 预留存储空间:目标节点可用空间需≥待迁移数据量的1.2倍

- 禁用块报告缓存:

hdfs dfsadmin -refreshNodes

关键命令组合

# 查看存储分布

hdfs dfsadmin -report | grep "^ [0-9]" | awk '{print $1,$2,$3}'

# 强制触发均衡

start-balancer.sh -threshold 0.2 -exclude []

# 手动迁移特定目录

hadoop distcp -p hdfs://source:8020/user/data/ /target/data/性能优化参数

| 参数 | 默认值 | 调优建议 |

|---|---|---|

| dfs.datanode.balance.bandwidth | 1MB/s | 10MB/s(万兆网络) |

| dfs.balance.max.concurrent.moves | 4 | 8-16(SSD节点) |

| dfs.client.block.write.locations | 1 | 3(多副本优化) |

迁移过程监控指标

- 进度监控:通过NameNode Web UI的”Utilities”->”Balancer progress”查看

- 性能指标:

- 网络IO:netstat -anp | grep 50010

- 磁盘IO:iostat -dx 1

- 健康检查:

- 块完整性:hdfs fsck / -files -blocks -locations

- 数据一致性:校验checksum(默认开启)

常见问题处理

场景1:迁移速度过慢

- 检查防火墙规则是否阻断50010端口

- 调整

dfs.datanode.handler.count参数(默认3→10) - 启用短回路优先策略(机架感知功能)

场景2:数据不一致

- 立即终止迁移:

stop-balancer.sh - 执行块修复:

hdfs fsck / -delete - 重新生成块报告:

hdfs dfsadmin -refreshNodes

FAQs

Q1:自动Balancer和手动distcp迁移的主要区别是什么?

A1:自动Balancer基于块粒度智能迁移,会自动计算最优迁移路径并保持副本数,适用于常规负载均衡;手动distcp属于文件级复制,需要人工指定源/目标路径,适合跨集群数据迁移或紧急扩容场景。

Q2:迁移过程中出现DataNode离线如何处理?

A2:首先排查网络故障,若确认节点故障,应立即执行hdfs dfsadmin -report查看块副本状态,对于缺失副本的情况,可使用hdfs dfsadmin -safemode leave退出安全模式后,通过hadoop balancer命令重新触发