hdfs负载均衡带宽

- 行业动态

- 2025-05-08

- 3

HDFS负载均衡与带宽优化深度解析

HDFS负载均衡机制与带宽关联性

HDFS(Hadoop Distributed File System)作为大数据存储核心组件,其负载均衡能力直接影响集群带宽利用率,负载均衡通过数据块(Block)的均匀分布,避免数据节点(DataNode)的存储与网络资源倾斜,从而降低跨机架数据传输频率,提升整体带宽效率。

表1:HDFS负载均衡核心指标与带宽关系

| 指标 | 描述 | 对带宽的影响 |

|———————|——————————-|———————————–|

| 数据节点存储利用率 | 各节点存储容量占比 | 倾斜会导致热点节点带宽拥堵 |

| 数据块副本分布 | 副本跨机架比例 | 跨机架传输增加网络带宽消耗 |

| 客户端请求分布 | MapReduce任务数据本地性 | 低本地性导致跨节点读取,占用带宽 |

HDFS带宽消耗的核心场景

数据复制(Replication)

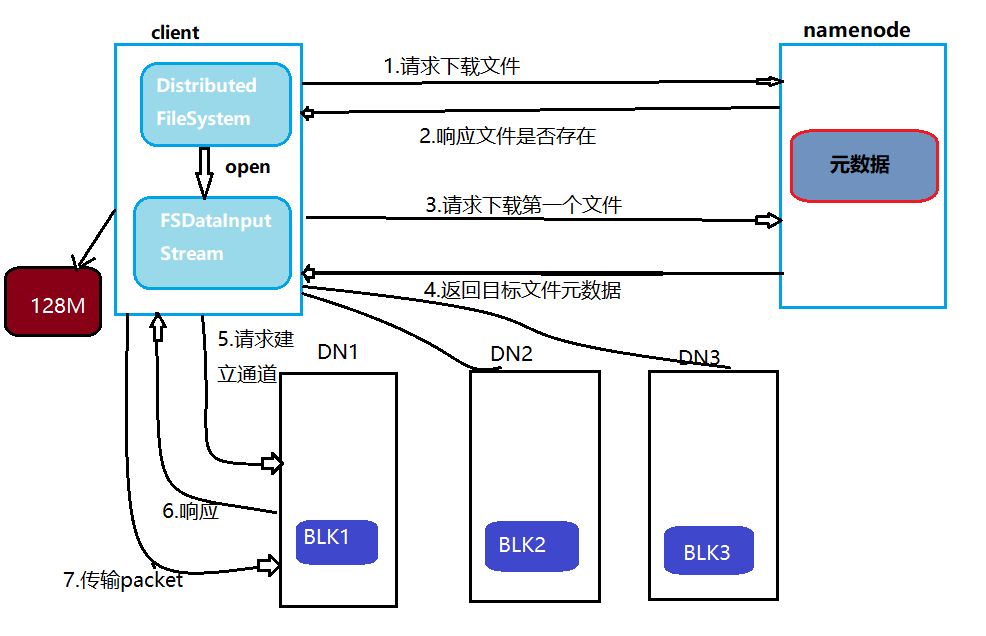

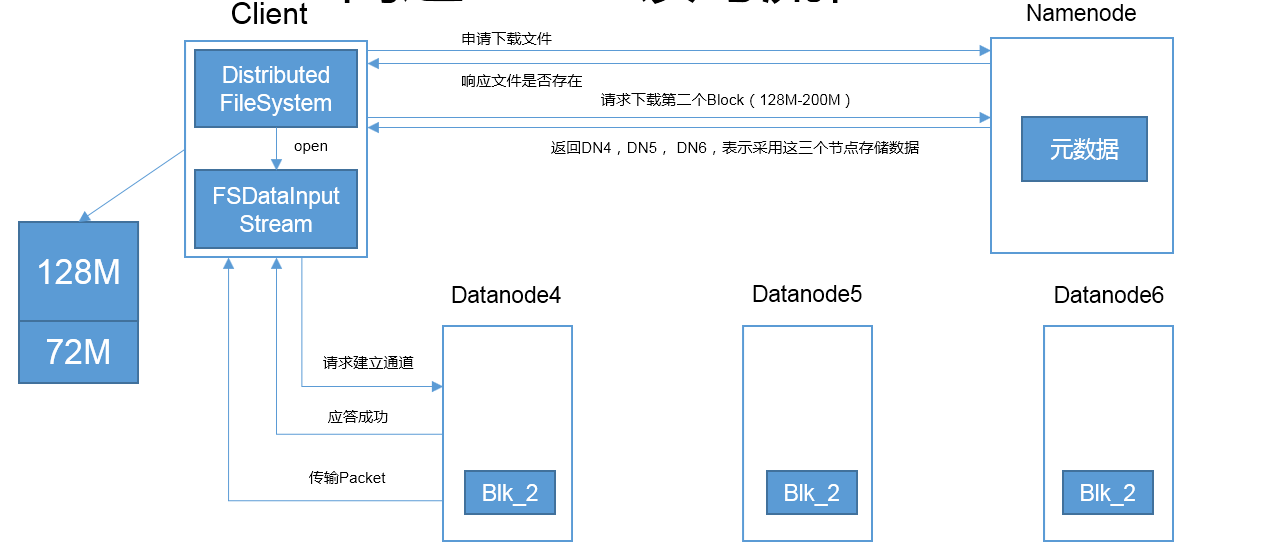

每个Block默认存储3份副本(由dfs.replication控制),副本分配策略遵循机架局部性原则,若副本分布不合理(如多个副本集中在同一机架),则客户端读取时需跨机架传输,加剧带宽压力。心跳与元数据交互

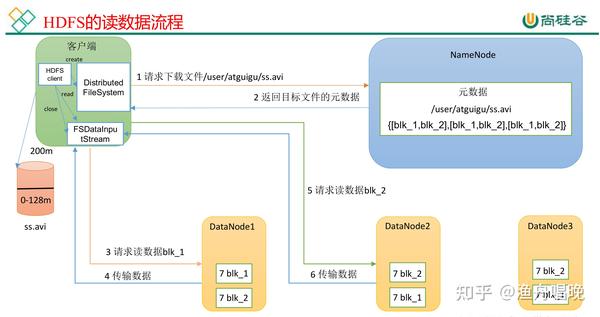

DataNode通过心跳(默认3秒)向NameNode发送块报告,频繁的元数据同步会占用约1-5%的带宽,高并发集群中可能累积显著。客户端读写操作

- 写入:客户端将数据拆分为Block后分发到不同DataNode,若DataNode负载不均,可能导致部分节点带宽饱和。

- 读取:未命中缓存时,需从远程DataNode拉取数据,跨机架读取会触发交换机上行链路带宽竞争。

Balancer工具执行

手动触发或自动均衡时,Balancer会移动Block以实现存储均衡,此过程产生大量临时网络流量,峰值带宽可达集群总带宽的20%-30%。

负载均衡策略对带宽的优化作用

数据节点存储均衡

- 问题:当某些DataNode存储量超过均值(如超过

dfs.balance.threshold的110%),客户端可能集中访问这些节点,导致网络带宽瓶颈。 - 优化:通过Balancer将超载节点的Block迁移至空闲节点,降低热点节点的读写压力,某节点存储使用率从120%降至100%,可减少30%的跨机架读取流量。

- 问题:当某些DataNode存储量超过均值(如超过

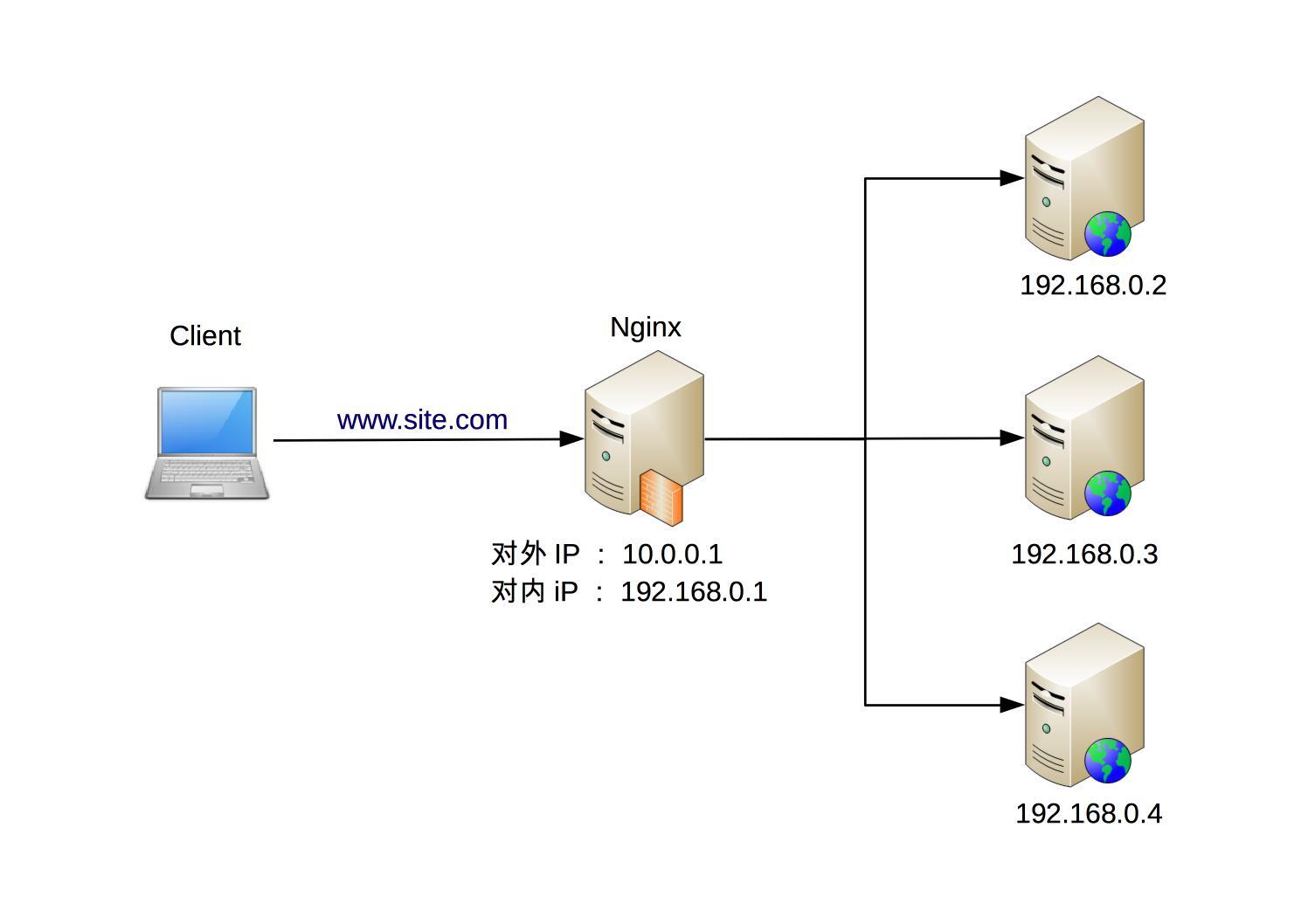

机架感知(Rack Awareness)策略

- 原理:NameNode根据网络拓扑分配副本,确保至少一个副本在本地机架,其他副本分布在不同机架。

- 效果:减少跨机架数据传输,本地机架内副本满足80%读取需求时,可节省约50%的骨干网带宽。

动态副本调整

- 场景:针对高频访问文件,可临时增加副本数(

dfs.replication),但需平衡带宽消耗,将热数据副本从3个增至5个,可能提升20%读取性能,但增加67%的写入带宽。

- 场景:针对高频访问文件,可临时增加副本数(

关键参数调优与带宽控制

| 参数 | 默认值 | 调优建议 | 对带宽的影响 |

|---|---|---|---|

dfs.replication | 3 | 热数据调高至5,冷数据调低至2 | 副本数↑→写入带宽↑,读取带宽↓ |

dfs.block.size | 128MB | 大文件设为256MB,小文件设为64MB | Block增大→元数据开销↓,传输次数↓ |

ipc.client.connect.max.retries | 3 | 高延迟网络调至10 | 减少因超时重试产生的额外流量 |

dfs.datanode.max.transfer.threads | 40 | 高带宽节点调至100 | 提升并发传输能力,减少线程等待 |

带宽优化实战案例

案例1:跨机架带宽瓶颈解决

某集群出现DataNode1(机架A)带宽持续100%占用,经分析,其存储了70%的热数据,导致其他机架客户端频繁跨机架读取,通过Balancer将20% Block迁移至机架B的DataNode2,读取带宽降低40%。

案例2:Balancer执行时间优化

默认Balancer并发线程为4,在100节点集群中需数小时,调整dfs.balance.max.concurrent.moves为20后,均衡速度提升3倍,且峰值带宽控制在总带宽的15%以内。

监控与故障排查工具

带宽监控

- 使用

Hadoop Metrics2采集DataNode网络IO(如dfs.DS-DATANODE-NET-BYTES-IN)。 - 结合Prometheus+Grafana可视化带宽趋势,识别异常峰值。

- 使用

负载均衡状态检查

- 命令:

hdfs dfsadmin -report

查看StorageUsed%、UnderReplicatedBlocks等指标,判断是否需要触发Balancer。 - 命令:

hdfs fsck / -blocks

检查Block分布是否均匀,例如理想状态下各机架存储偏差应<5%。

- 命令:

常见问题与解决方案(FAQs)

Q1:如何判断集群是否存在负载不均衡导致的带宽问题?

- 检查方法:

- 执行

hdfs dfsadmin -report,若某DataNode存储使用率超过均值20%且持续升高,可能存在倾斜。 - 监控Network UI中DataNode的

Packets In/Out,若部分节点长期处于高流量状态,需均衡负载。

- 执行

- 解决步骤:

- 手动运行

hdfs balancer或设置自动均衡(dfs.balance.automatic=true)。 - 调整

dfs.balance.threshold(默认1.1)为1.05,提前触发均衡。

- 手动运行

Q2:高并发写入场景下如何优化HDFS带宽?

- 优化策略:

- 增大Block尺寸:将

dfs.block.size从128MB提至256MB,减少Block数量,降低NameNode元数据压力。 - 启用本地写入优化:设置

dfs.client.write.packet.delay为50ms,合并小数据包,减少网络碎片。 - 调整副本写入策略:设置

dfs.replication为2(若容灾允许),降低写入带宽消耗,原3副本需3份传输,改为2副本后减少33%流量。 - 使用异步复制:开启

dfs.client.block.write.lazy.enable,允许客户端快速返回,后台异步完成副本传输,平滑带宽峰值。

- 增大Block尺寸:将

HDFS的负载均衡与带宽优化是相辅相成的过程,通过合理设计数据分布、调优关键参数、监控网络流量,可显著提升集群吞吐量并降低延迟,实际应用中需结合业务特点(如实时性要求、数据访问模式)动态调整策略,例如对高频查询的热数据采用就近存储,而对批量处理的冷数据