上一篇

分布式数据存储包含的组件

- 行业动态

- 2025-05-09

- 4

分布式数据存储包含存储节点、元数据管理、一致性协议、客户端接口、负载均衡及数据分片与

分布式数据存储系统的核心组件与架构解析

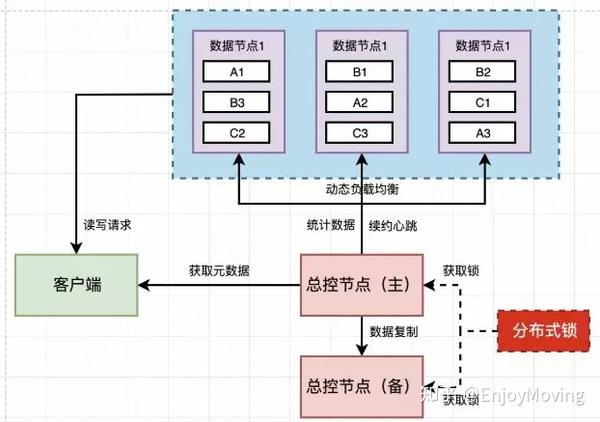

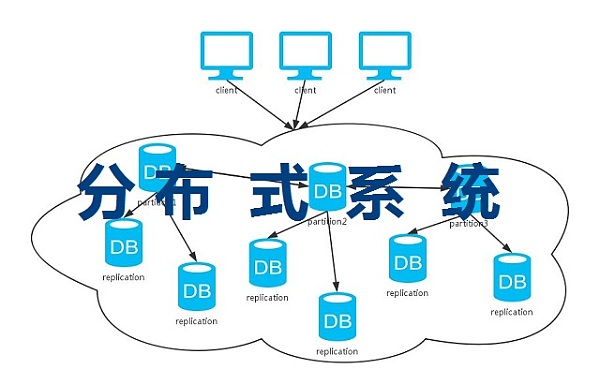

分布式数据存储系统通过将数据分散存储在多个节点上,实现高可用性、可扩展性和容错能力,其架构设计涉及多个关键组件,每个组件承担特定职责,共同保障系统的稳定性和性能,以下是分布式数据存储系统的主要组件及其功能详解:

核心组件

| 组件名称 | 功能描述 | 典型实现 |

|---|---|---|

| 客户端(Client) | 负责发起数据读写请求,与存储系统交互,客户端可能需要处理数据分片、路由逻辑。 | SDK(如AWS SDK、HDFS Client) |

| 存储节点(Storage Node) | 实际存储数据的物理或虚拟服务器,负责数据持久化、读写操作。 | 普通服务器、JBOD/SAN存储设备 |

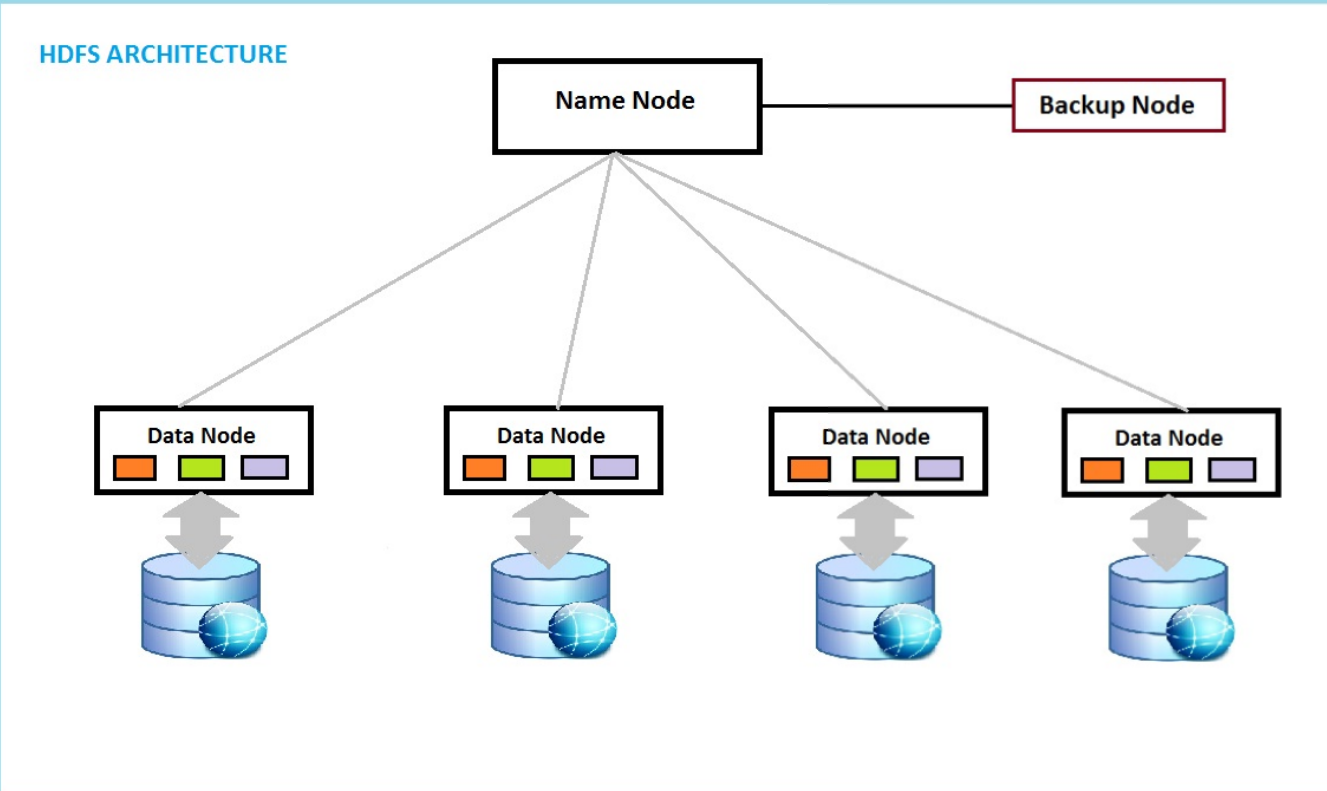

| 元数据管理(Metadata Management) | 维护文件/数据块的元信息(如位置、权限),支持快速检索。 | Master节点(如HDFS NameNode)、etcd集群 |

| 数据分片与复制模块 | 将数据拆分为多个分片(Shard),并通过复制机制保证高可用性。 | 哈希分片、Range分片;RAID、Erasure Coding |

| 一致性协议(Consensus Protocol) | 确保分布式环境下的数据一致性,解决节点间状态同步问题。 | Paxos、Raft、ZAB(ZooKeeper) |

辅助组件

负载均衡器(Load Balancer)

- 作用:分配客户端请求到不同存储节点,避免单点过载。

- 类型:

- 内部负载均衡:基于一致性哈希(Consistent Hashing)将数据均匀分布到节点。

- 外部负载均衡:通过LVS(Linux Virtual Server)或反向代理(如Nginx)分发流量。

监控与运维模块

- 监控指标:节点状态、磁盘使用率、网络延迟、数据一致性水位。

- 工具:Prometheus(数据采集)、Grafana(可视化)、ELK Stack(日志分析)。

- 自动恢复:通过心跳检测触发故障转移(Failover),或动态扩容/缩容节点。

安全机制

- 数据加密:传输层(TLS/SSL)和存储层(AES-256)加密。

- 访问控制:基于角色的访问控制(RBAC)、令牌认证(如OAuth)。

- 审计日志:记录数据操作历史,满足合规性要求。

关键技术与协议

数据分片策略

- 哈希分片:根据Key的哈希值映射到节点,适合均匀分布的数据。

- 范围分片:按数据范围(如时间戳)划分分片,适合时序数据。

- 混合分片:结合哈希与范围,平衡负载与查询效率。

数据复制机制

- 同步复制:写操作需等待所有副本确认,强一致性但延迟高。

- 异步复制:写操作立即返回,副本后台同步,高可用但存在数据丢失风险。

- 多副本策略:典型配置为3副本(如HDFS)、纠删码(如Ceph)。

一致性模型

- 强一致性:所有节点数据完全一致(如分布式数据库)。

- 最终一致性:允许短期不一致,最终达到一致(如DynamoDB)。

- CAP定理权衡:在分区容忍(Partition Tolerance)下,需选择一致性(Consistency)或可用性(Availability)。

典型架构示例

以Ceph分布式存储系统为例,其组件分工如下:

| 组件 | 功能 |

|————————|—————————————–|

| Monitor(MON) | 维护集群状态地图,管理CRUSH算法(数据分布) |

| Object Storage(OSD) | 存储数据对象,处理读写请求 |

| Metadata Server(MDS) | 提供POSIX文件系统元数据服务 |

| Manager(MGR) | 监控集群健康状态,提供RESTful API |

FAQs

问题1:分布式存储系统中组件冗余是否会降低性能?

答:组件冗余(如多副本、多Metadata节点)会引入额外网络开销和同步延迟,但通过优化一致性协议(如Raft的选举机制)和本地缓存策略,可减少性能损耗,实际设计中需在冗余度与性能之间权衡,例如采用分层存储(热数据少副本、冷数据多副本)。

问题2:如何选择数据分片策略?

答:分片策略需根据业务场景决定:

- 哈希分片:适合随机访问、数据分布均匀的场景(如图片存储)。

- 范围分片:适合范围查询密集的场景(如日志分析)。

- 地理分片:若需跨数据中心部署,可按地域划分分片