上一篇

Google网络爬虫如何影响你的网站流量?

- 行业动态

- 2025-05-08

- 4

Google网络爬虫(Googlebot)是用于自动抓取和索引网页内容的程序,通过追踪网页链接发现新数据,分析文本、图片及视频等信息,并遵循robots.txt协议控制访问范围,其持续扫描更新内容,构建海量数据库支撑搜索引擎快速响应查询,同时优化算法平衡抓取频率与网站负载。

Google网络爬虫:它是如何工作的?如何优化你的网站?

互联网上的信息浩瀚如海,而Google网络爬虫(又称Googlebot)就像一位不知疲倦的“探索者”,每天在数十亿网页中穿梭,抓取内容并建立索引库,最终将这些信息呈现给用户,许多网站所有者对爬虫的工作机制和优化方法仍存在疑问,本文将从原理、技术细节到实践策略,带您深入了解Google网络爬虫,并提供符合搜索引擎算法的高价值优化建议。

Google网络爬虫的工作流程

Googlebot的核心任务是发现新内容、更新旧内容,并评估网页价值,其工作流程可分为以下步骤:

发现网页

- 从种子URL(如已收录的高权重网站)开始,通过解析页面中的超链接不断扩展抓取范围。

- 结合Sitemap文件、站长主动提交的URL,以及历史抓取记录,动态更新抓取队列。

抓取与解析

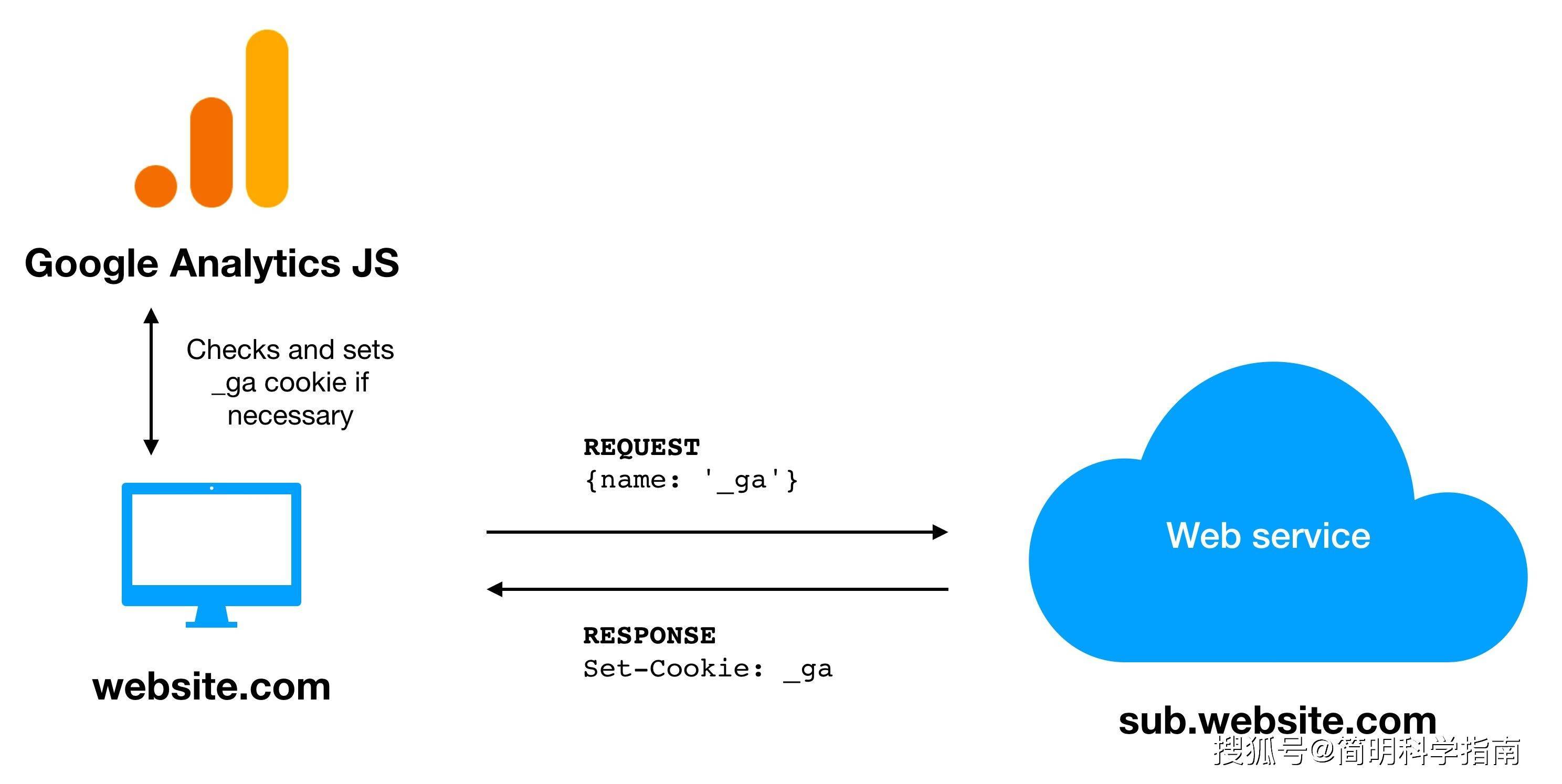

- 模拟浏览器访问页面,下载HTML、CSS、JavaScript等资源。

- 解析页面内容,提取文本、链接、结构化数据(如Schema标记)和媒体文件。

索引与排名

- 存入索引库,并根据页面质量(内容相关性、用户体验、权威性等)进行排序。

- 符合E-E-A-T(专业度、权威性、可信度)的页面更易获得高排名。

爬虫如何影响SEO?关键优化策略

想让Googlebot高效抓取并优先索引你的网站?需关注以下技术细节:

提升可抓取性

- 优化robots.txt:确保未错误屏蔽重要页面(如

Disallow: /会完全阻止抓取)。 - 规范化URL:避免重复内容,使用

rel="canonical"指定主版本。 - 响应状态码:检查404错误,301重定向失效链接,确保爬虫能访问目标页面。

加速索引效率

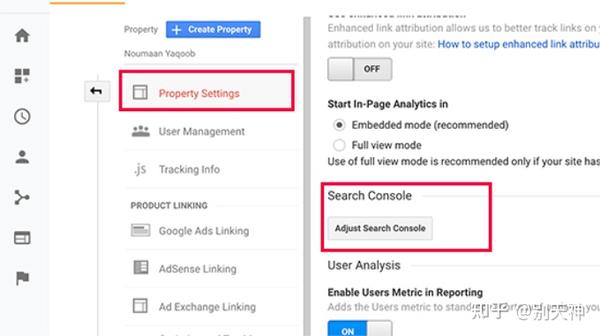

- 提交Sitemap:通过Google Search Console主动推送XML网站地图。

- API索引:针对高频更新的内容(如新闻网站),使用Indexing API实时通知爬虫。

- 内部链接优化:重要页面需有至少3-5个内部链接入口。

内容与技术协同优化

- 移动端优先索引:确保移动版与桌面版内容一致,加载速度低于3秒。

- 结构化数据:添加产品、文章、FAQ等Schema标记,帮助爬虫理解内容。

- 动态渲染处理:若使用JavaScript框架(如React、Vue),需通过预渲染或SSR保障爬虫解析。

常见问题与解决方案

Q1:为什么我的新页面迟迟未被收录?

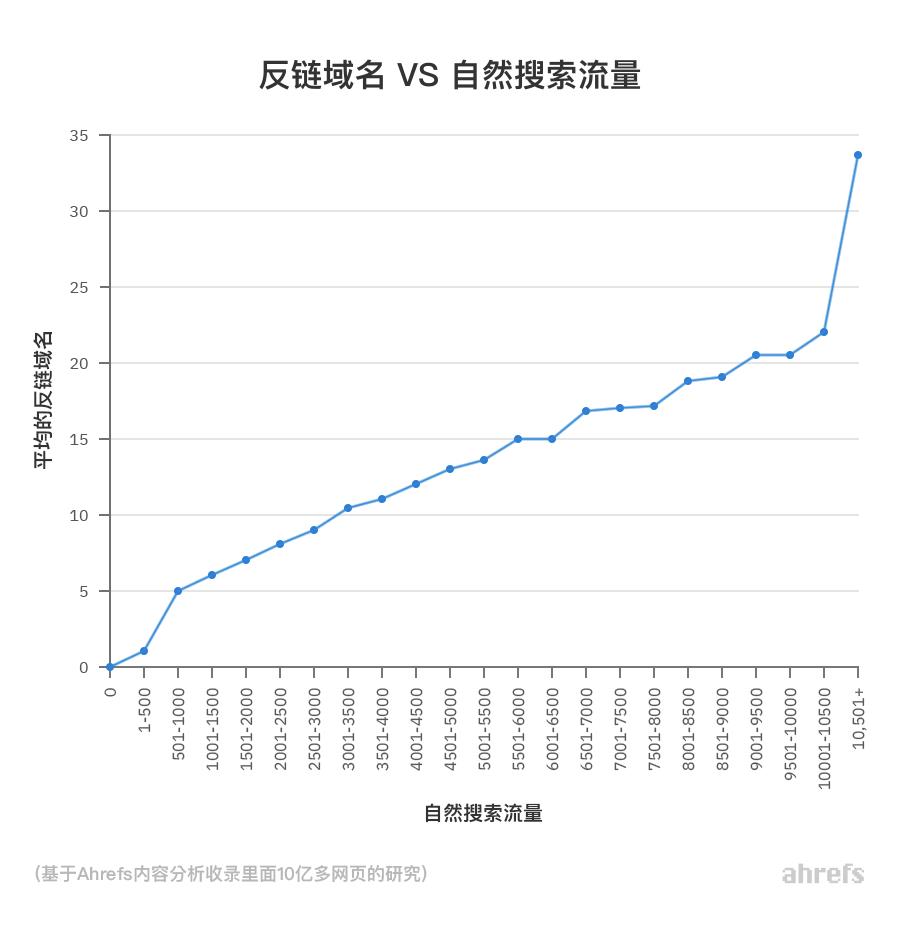

- 可能原因:网站权威度低、外链不足、robots.txt限制。

- 解决方案:通过Search Console提交URL,增加高质量外链,优化内部导航。

Q2:爬虫会抓取所有内容吗?

- 不,Googlebot有抓取预算(Crawl Budget),优先处理高权重网站和更新频繁的页面,若网站加载慢或存在大量低质页面,可能被降级抓取。

Q3:如何阻止爬虫抓取敏感内容?

- 除了robots.txt,还可在页面中添加

<meta name="robots" content="noindex">标记(但需确保爬虫能访问该页面以读取指令)。

符合E-E-A-T的高阶技巧

Google的算法越来越注重内容的专业性和可信度,建议:

- 作者身份透明化:在“关于我们”页面展示团队资质,文章署名附专家简介。

- 引用权威来源:学术论文、政府网站或行业报告的数据可增强可信度。

- 用户参与度信号:降低跳出率、提升停留时间,间接向爬虫传递内容价值。

Google网络爬虫的运作逻辑是SEO优化的基石,通过技术细节的精准把控(如抓取效率、索引速度)与内容质量的深度提升(符合E-E-A-T原则),网站可显著提升在搜索结果中的表现,爬虫并非“对手”,而是连接优质内容与用户需求的桥梁。

引用说明

- Google官方文档《How Search Works》

- Moz博客《Understanding Crawl Budget》

- Search Engine Journal《E-E-A-T and SEO: A Complete Guide》

- 斯坦福大学《Web Crawler Architecture Design》研究报告