上一篇

hive表如何清理数据库

- 行业动态

- 2025-05-06

- 2

Hive清理数据库可通过DROP TABLE删除表,ALTER TABLE DROP PARTITION清理分区,外部表需手动删HDFS数据,配合MSCK REPAIR TABLE修复元

Hive表清理数据库的详细方法与实践指南

Hive作为大数据领域常用的数据仓库工具,其表数据管理直接影响集群存储效率和查询性能,随着业务积累,表数据(尤其是分区表)可能占用大量HDFS存储空间,需定期清理无效或过期数据,本文将从操作命令、存储优化、自动化策略等角度,系统说明Hive表清理数据库的方法。

Hive表数据清理的核心场景

| 场景 | 典型需求 |

|---|---|

| 删除过期分区 | 按时间周期保留数据(如仅保留最近3个月的数据) |

| 清理小文件过多问题 | 合并小文件以提升查询效率 |

| 回收删除数据的存储空间 | 彻底删除数据并释放HDFS存储资源 |

| 优化表存储格式 | 将非高效格式(如Text)转换为列式存储(如ORC/Parquet) |

| 清理临时表或中间表 | 删除不再需要的测试表或任务生成的中间表 |

Hive表清理的核心操作命令

删除表或分区

DROP TABLE:彻底删除表及元数据

DROP TABLE IF EXISTS database_name.table_name;

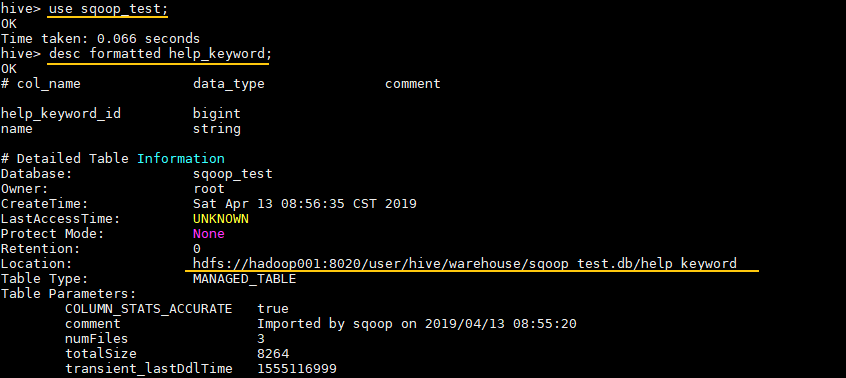

- 注意:内部表(Internal Table)的DROP会删除HDFS中的数据,外部表(External Table)仅删除元数据,需手动清理HDFS。

TRUNCATE TABLE:清空表数据但保留表结构

TRUNCATE TABLE table_name;

- 适用场景:适用于需要快速清空数据但保留表定义的情况(如日志聚合表)。

删除分区:按分区键清理数据

ALTER TABLE table_name DROP IF EXISTS PARTITION (partition_column=value);

- 示例:删除

dt='2023-01-01'分区ALTER TABLE user_logs DROP IF EXISTS PARTITION (dt='2023-01-01');

- 示例:删除

修复元数据与回收存储空间

MSCK REPAIR TABLE:同步HDFS与Hive元数据

当直接删除HDFS中的文件(如rm -r操作)后,Hive元数据与实际存储不一致,需执行:MSCK REPAIR TABLE table_name;

此命令会扫描HDFS路径并更新Hive元数据,标记已删除的文件。

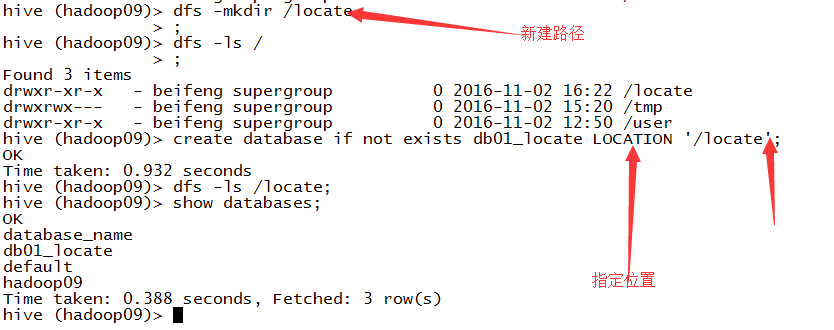

HDFS手动清理:针对外部表或绕过Hive的删除操作

hdfs dfs -rm -r /user/hive/warehouse/database_name.db/table_name/

存储优化与空间回收

小文件合并

- 问题:大量小文件会导致HDFS NameNode内存压力大、MapReduce任务启动慢。

- 解决方案:

- INSERT OVERWRITE:通过覆盖写入合并文件

INSERT OVERWRITE DIRECTORY output_dir SELECT FROM table_name;

- Hive CONCAT命令:合并多个小分区(需Hive 3.0+)

ALTER TABLE table_name CONCATENATE;

- INSERT OVERWRITE:通过覆盖写入合并文件

表存储格式转换

| 原格式 | 目标格式 | 命令示例 |

|---|---|---|

| Text | ORC | INSERT OVERWRITE DIRECTORY output_dir STORED AS ORC SELECT FROM table_name; |

| CSV | Parquet | INSERT OVERWRITE DIRECTORY output_dir STORED AS PARQUET SELECT FROM table_name; |

压缩与索引优化

- 开启Bloom过滤器:减少IO扫描范围

ALTER TABLE table_name SET TBLPROPERTIES ('orc.bloom.filter.columns'='id,name'); - Snappy压缩:降低存储空间占用

ALTER TABLE table_name SET TBLPROPERTIES ('orc.compress'='SNAPPY');

自动化清理策略

基于时间的分区清理

- 脚本示例(清理3个月前的分区):

current_date=$(date +%Y-%m-%d) hive -e " ALTER TABLE sales_data DROP IF EXISTS PARTITION (dt='$current_date'); ALTER TABLE sales_data DROP IF EXISTS PARTITION (dt<DATE_SUB('$current_date', INTERVAL 90 DAY)); "

生命周期策略

- 配置方式:通过Hive参数设置分区保留周期

SET hive.metastore.partition.retention.days=30; -保留30天

- 结合调度工具:使用Airflow或Oozie定期执行清理脚本。

动态分区管理

- 自动删除空分区:通过

hive.auto.drop.empty.partitions=true配置,在插入数据时自动清理无数据的分区。

注意事项与风险规避

- 权限控制:DROP/TRUNCATE操作需具备

ALL权限,建议先备份重要数据。 - 事务表限制:ACID事务表(如ORC格式)支持原子操作,但需启用

hive.support.concurrency=true。 - 外部表清理:仅删除元数据,需手动清理HDFS路径:

hdfs dfs -rm -r /external/path/to/data;

- 存储成本:删除前确认数据是否需归档(如冷存储至廉价存储系统)。

FAQs(常见问题解答)

Q1: 删除Hive表后,HDFS存储空间未释放怎么办?

A1: Hive内部表的DROP TABLE会删除HDFS中的数据,但若为外部表或直接删除HDFS文件,需手动执行:

hdfs dfs -expunge -r /path/to/data # 彻底释放Block占用的空间

可检查是否有其他快照或副本占用空间。

Q2: 如何避免因误删分区导致数据丢失?

A2: 建议以下措施:

- 备份分区列表:执行

SHOW PARTITIONS table_name保存分区信息。 - 启用Hive元数据版本控制:通过

hive.metastore.event.db.notification=true记录操作日志。 - 分步删除:先

ALTER TABLE table_name DROP IF EXISTS PARTITION测试,再批量清理