分布式数据采集问题怎么解决

- 行业动态

- 2025-05-05

- 2

分布式数据采集问题的解决方案与实践

在现代大数据场景中,分布式数据采集是核心环节之一,其目标是从多个异构数据源(如物联网设备、服务器日志、数据库、API接口等)高效、可靠地获取数据,并统一传输至处理中心,分布式环境天然存在数据源多样性、网络波动、高并发压力、数据一致性等问题,如何解决这些问题成为关键,以下从问题分析、解决思路、技术方案、工具对比、实施步骤及优化策略等方面展开详细解答。

分布式数据采集的核心问题

| 问题类型 | 具体表现 |

|---|---|

| 数据源异构性 | 数据格式(JSON、XML、二进制等)、协议(HTTP、MQTT、TCP等)、频率(实时/批量)差异大 |

| 网络不稳定性 | 跨地域传输可能出现丢包、延迟、断连,影响数据采集完整性 |

| 高并发压力 | 海量设备或用户同时上传数据,对采集系统的吞吐量和响应能力提出挑战 |

| 数据一致性 | 分布式环境下需保证数据顺序、去重、幂等性,避免重复或丢失 |

| 实时性要求 | 部分场景(如监控告警、实时分析)需低延迟数据采集 |

| 资源与成本限制 | 硬件资源(带宽、存储)、运维复杂度与成本需平衡 |

解决思路与技术架构

分层架构设计

典型的分布式数据采集系统可划分为以下层级:

- 采集层:负责对接各类数据源,支持多协议解析与转换。

- 传输层:通过消息队列或流式处理框架实现数据的可靠传输。

- 存储层:将数据统一写入分布式存储系统(如HDFS、数据库)。

- 监控层:实时监控采集状态、性能指标及异常告警。

关键技术选型

| 组件 | 功能 | 主流工具 |

|——————|——————————————|—————————————–|

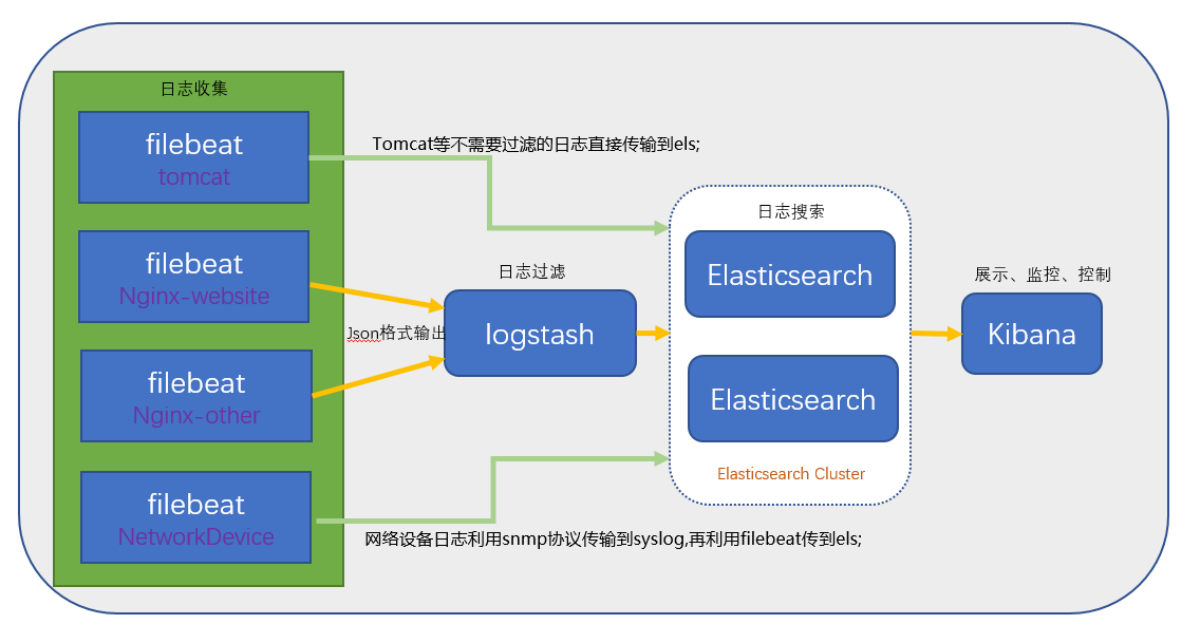

| 数据采集 | 连接数据源,提取并初步处理数据 | Flume、Logstash、Telegraf、Apache NiFi |

| 消息队列 | 缓冲高并发数据,保证可靠传输 | Kafka、RabbitMQ、Redis Streams |

| 流处理框架 | 实时处理与路由数据 | Flink、Spark Streaming、Kafka Streams |

| 分布式协调 | 管理集群元数据与配置 | Zookeeper、Consul |

| 监控与日志 | 系统健康状态与性能分析 | Prometheus、Grafana、ELK Stack |

核心设计原则

- 幂等性:确保重复采集的数据不会被多次处理。

- 容错性:通过重试机制、数据持久化应对网络抖动或节点故障。

- 扩展性:支持动态添加数据源或扩容采集节点。

- 低耦合:采集逻辑与业务逻辑解耦,便于独立维护。

工具对比与场景适配

数据采集工具对比

| 工具 | 适用场景 | 优势 | 局限性 |

|—————-|———————————|—————————————|—————————|

| Apache Flume | 日志流式采集(如Web服务器日志) | 轻量级、高吞吐量、支持拦截器预处理 | 扩展性较弱,不适合复杂ETL |

| Logstash | 多格式数据解析与转换(ELK栈) | 灵活过滤、支持Grok解析、插件丰富 | 资源消耗较高,需配合Kibana |

| Telegraf | 物联网设备与指标采集 | 低资源占用、支持多种输入/输出插件 | 社区规模较小,文档较少 |

| Apache NiFi | 数据路由与复杂流程编排 | 可视化界面、支持数据溯源与加密传输 | 学习成本高,性能略低 |

消息队列对比

| 工具 | 适用场景 | 优势 | 局限性 |

|—————-|———————————|—————————————|—————————|

| Kafka | 高吞吐量、持久化存储的实时数据 | 分区机制、水平扩展性强、生态完善 | 依赖Zookeeper,配置复杂 |

| RabbitMQ | 可靠性要求高的异步任务 | 镜像队列、消息确认机制、多协议支持 | 性能低于Kafka,需磁盘存储 |

| Redis Streams | 轻量级实时消息队列 | 低延迟、与Redis其他功能无缝集成 | 持久化依赖AOF,容量有限 |

实施步骤与最佳实践

需求分析与规划

- 明确数据源类型(如日志、传感器、API)、数据量级、实时性要求。

- 设计数据流向与存储目标(如数据湖、时序数据库)。

数据采集层设计

多协议适配:针对不同数据源开发或配置采集插件(如MQTT for IoT、HTTP for API)。

数据预处理:在采集端完成格式转换(如JSON→Avro)、字段过滤、压缩(如Snappy)。

示例配置(Flume):

# Source: 监听TCP端口接收日志 a1.sources.r1.type = netcat a1.sources.r1.bind = 0.0.0.0 a1.sources.r1.port = 44444 # Sink: 写入Kafka主题 a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink a1.sinks.k1.kafka.bootstrap.servers = kafka-broker:9092 a1.sinks.k1.topic = logs

传输层优化

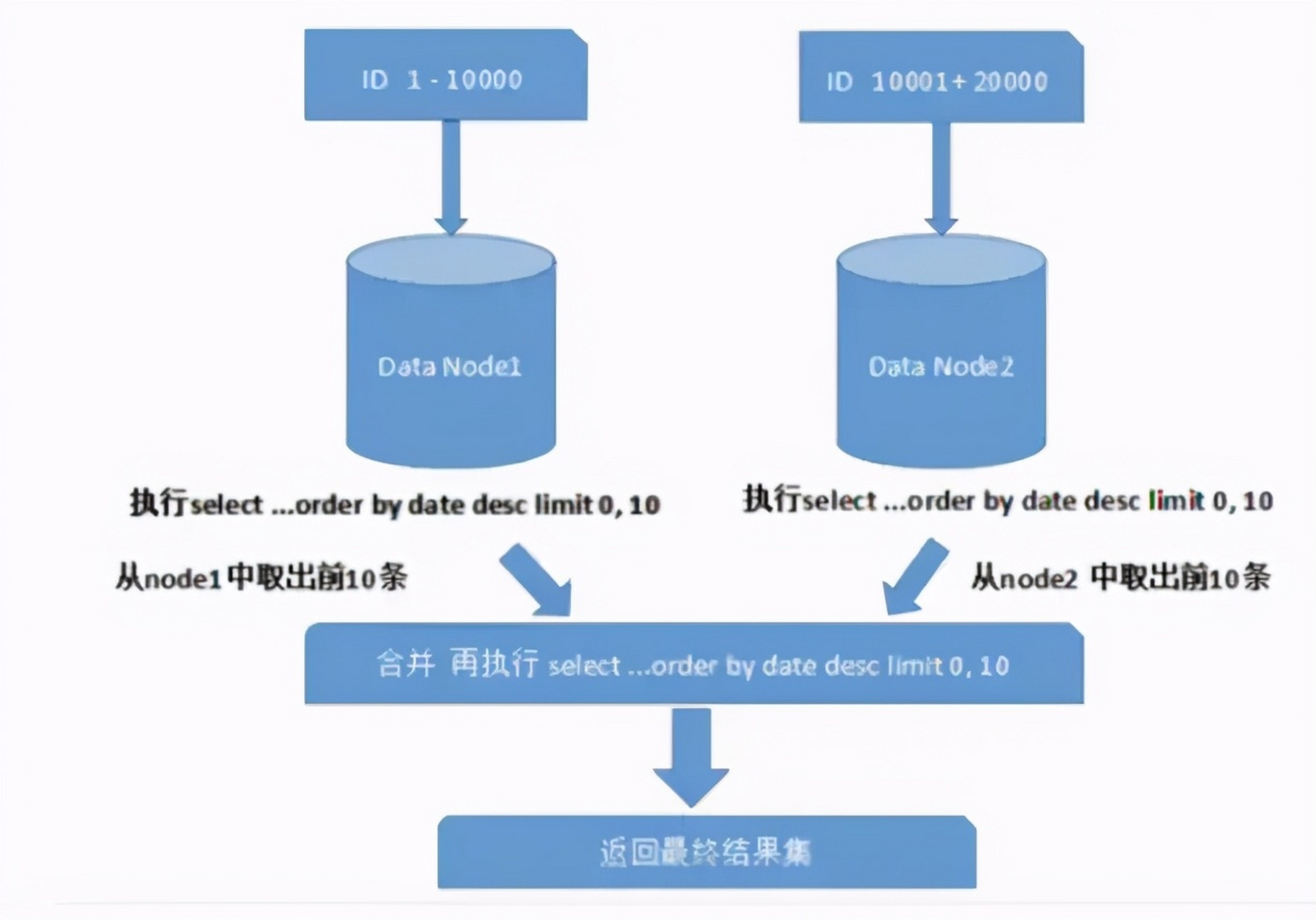

- 分区策略:按数据源或时间分区(如Kafka按Hash分区),提升并行度。

- 批量传输:合并小数据包(如每秒批量发送),减少网络开销。

- 压缩算法:采用Snappy或LZ4压缩,平衡CPU与带宽消耗。

容错与监控

- 重试机制:采集失败后指数退避重试(如3次,间隔1/5/10秒)。

- 监控指标:采集延迟、吞吐量、失败率、队列长度(通过Prometheus+Grafana)。

- 告警规则:延迟>1s或失败率>5%时触发邮件/短信告警。

典型挑战与优化策略

| 挑战 | 优化方案 |

|---|---|

| 数据丢失 | 启用消息队列持久化(Kafka日志+分区副本)、采集端本地缓存 |

| 高延迟 | 优化批量大小、减少数据转换逻辑、使用内存缓冲区 |

| 节点故障 | 部署多活采集节点、消息队列多副本、自动故障转移(如Kafka Leader选举) |

| 数据倾斜 | 哈希分片或一致性哈希分配数据源,避免单点过载 |

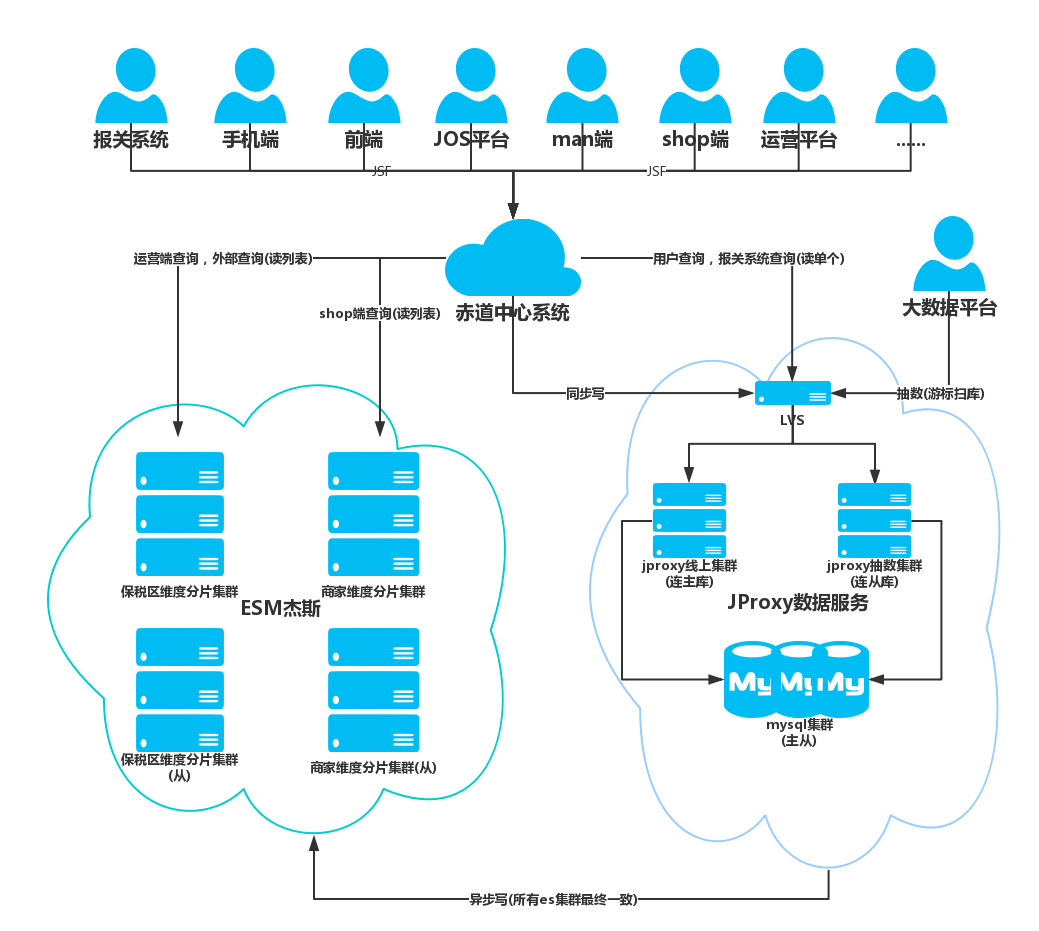

案例分析:电商平台实时用户行为采集

- 场景:全球多地电商平台需采集用户点击、下单、支付等行为数据,并实时分析。

- 方案:

- 采集层:边缘节点部署Logstash采集Web日志,过滤敏感信息后推送至Kafka。

- 传输层:Kafka集群按地域分区,设置3个副本保证高可用。

- 处理层:Flink消费Kafka数据,实时计算UV、转化率,结果存入Redis和HBase。

- 效果:端到端延迟<500ms,日均处理10亿+事件,故障自动恢复。

FAQs

Q1:如何选择分布式数据采集工具?

A1:根据数据源类型、实时性要求和团队熟悉度选择:

- 日志/文件采集:Flume或Logstash;

- 物联网设备:Telegraf或NiFi;

- 高吞吐量实时流:Kafka+自研采集客户端。

Q2:如何保证分布式数据采集的实时性?

A2:

- 减少数据采集与传输链路(如边缘计算预处理);

- 优化批量大小与压缩算法;

- 使用内存队列(如Kafka的PageCache)加速写入;

- 监控延迟指标