存储器分页机制如何影响你的电脑性能?

- 行业动态

- 2025-04-28

- 2

存储器分页机制通过将物理内存和虚拟地址空间划分为固定大小的页,利用页表实现地址动态映射,该机制避免了外部碎片,提高内存利用率,支持多进程并行运行,操作系统通过页表管理虚拟页到物理页的转换,现代系统采用多级页表和快表(TLB)优化访问性能。

原理、作用与实现

什么是分页机制?

存储器分页机制(Paging)是现代操作系统管理物理内存和虚拟内存的核心技术之一,它的核心思想是将物理内存和虚拟内存划分为固定大小的“页”,通过页表(Page Table)建立虚拟地址到物理地址的映射关系,从而实现内存的高效利用和程序间的隔离。

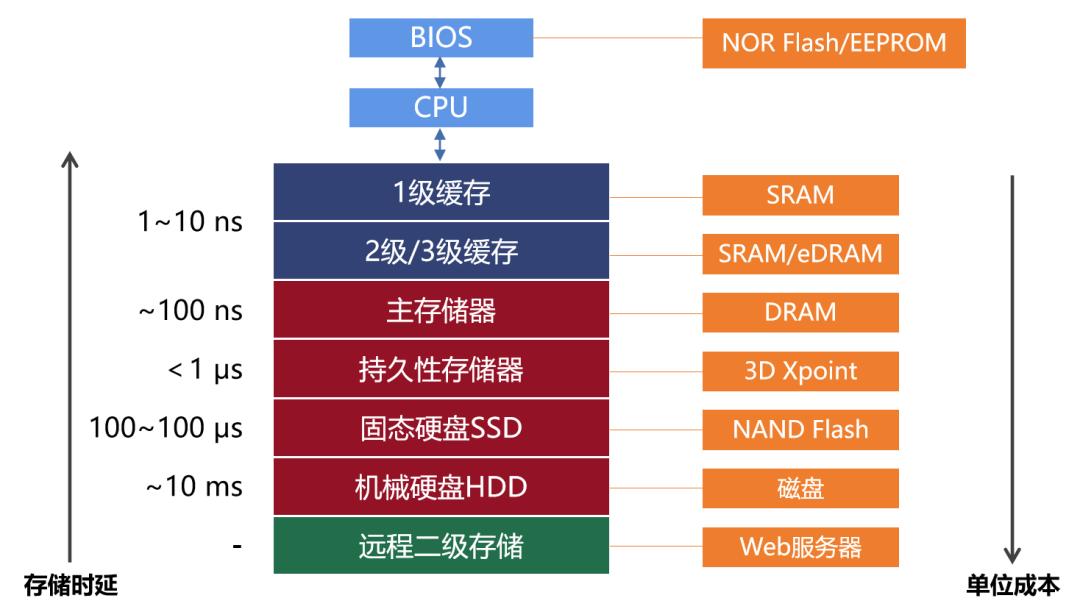

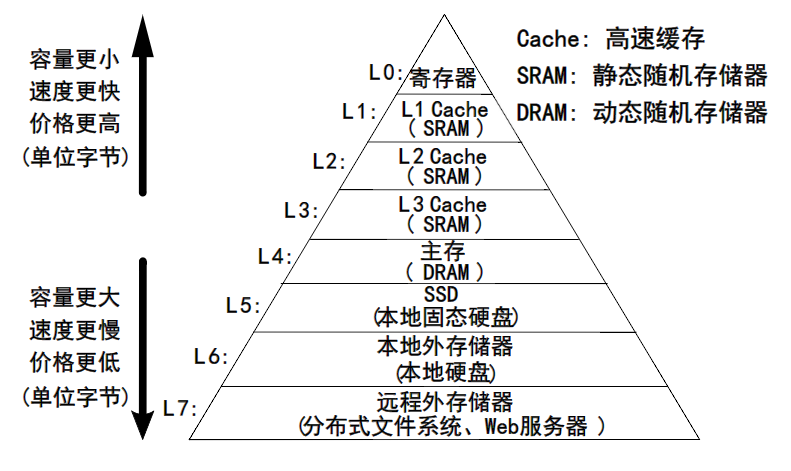

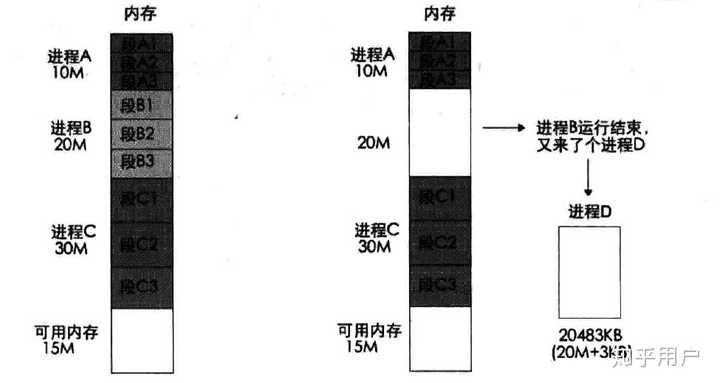

分页机制的诞生源于早期内存管理技术的局限性,20世纪60年代,随着多道程序设计的普及,传统的内存分区分配方式(如分段)容易导致内存碎片化,而分页机制通过固定大小的内存块分配,显著提升了内存利用率。

分页机制如何工作?

内存划分

- 页(Page):虚拟内存的固定大小单元(如4KB、2MB)。

- 页框(Frame):物理内存中与页大小相同的存储区域。

地址转换

当程序访问一个虚拟地址时,硬件(如MMU,Memory Management Unit)会将地址拆解为两部分:

- 页号(Page Number):用于查询页表,定位物理页框。

- 页内偏移(Page Offset):直接映射到物理页框内的具体位置。

(示意图:虚拟地址通过页表转换为物理地址)页表的作用

页表存储每个虚拟页到物理页框的映射关系,每个进程拥有独立的页表,确保内存隔离。- 页表项(PTE):包含物理页框号、访问权限(读/写/执行)、状态位(如是否在内存中)。

多级页表

现代系统(如x86-64)采用多级页表(如四级页表),减少内存占用,虚拟地址被分为多个索引字段,逐级查询页表。

分页机制的优势

消除外部碎片

固定大小的页分配避免内存碎片问题,物理内存利用率更高。支持虚拟内存

通过将部分页暂存于磁盘(如交换空间),实现“内存扩展”,允许运行比物理内存更大的程序。内存保护与共享

- 通过权限位限制非规访问(如写只读页会触发异常)。

- 共享库或代码页可被多个进程映射,减少重复加载。

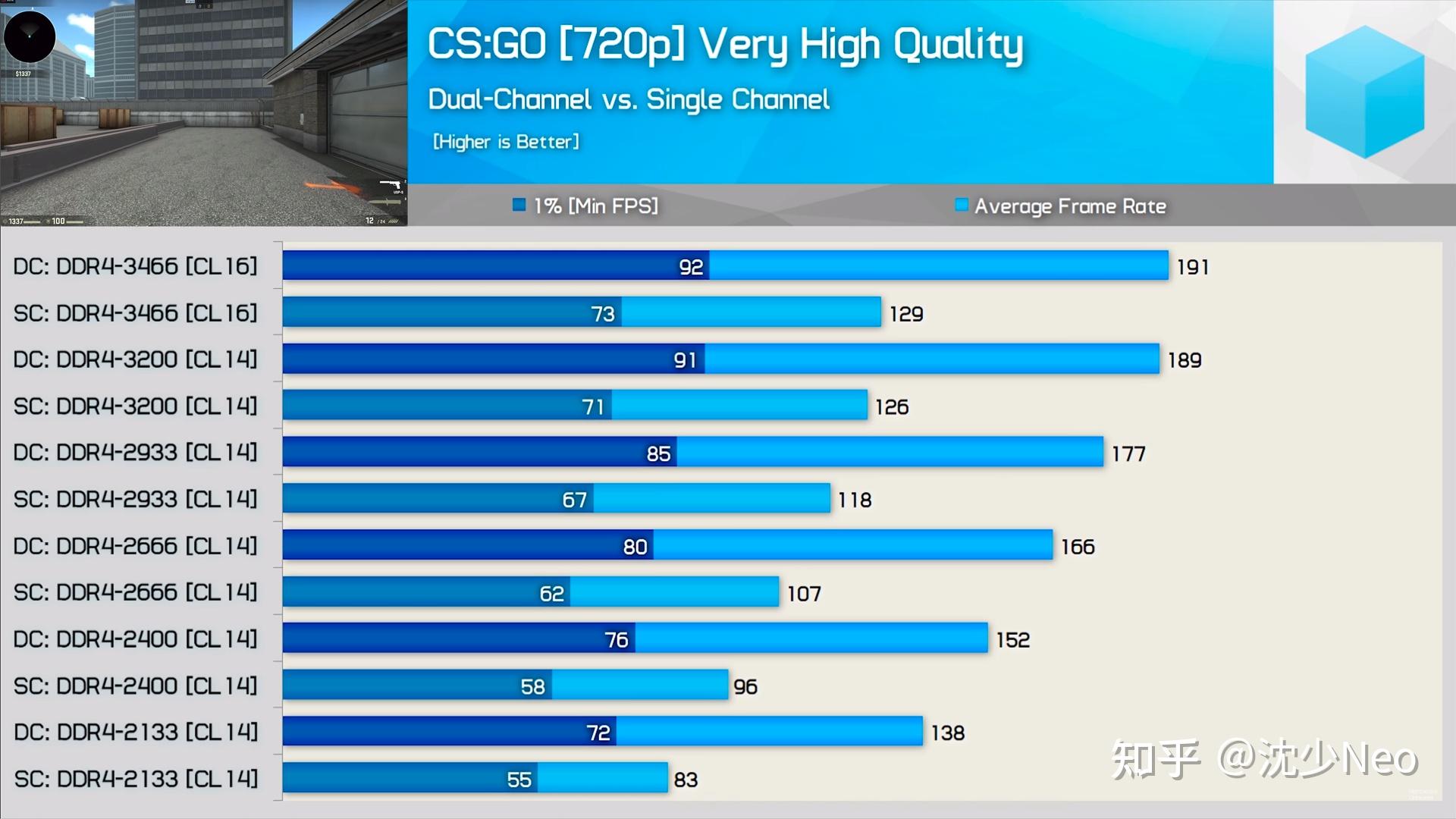

高效的地址转换加速

借助TLB(Translation Lookaside Buffer)缓存频繁访问的页表项,将地址转换时间从数百周期缩短至几个周期。

分页机制的挑战与优化

- 页表空间开销

- 解决方案:多级页表、反向页表(如PowerPC的哈希页表)。

- 页错误(Page Fault)处理

当访问的页不在内存时,触发缺页中断,操作系统需从磁盘加载页并更新页表。- 优化手段:预取(Prefetching)、工作集算法(Working Set)。

- TLB未命中惩罚

- 硬件优化:增大TLB容量、支持大页(如2MB或1GB页)。

分页在现代系统中的实际应用

- Linux内核的分页实现

- 默认页大小为4KB,支持大页(Huge Pages)。

- 使用伙伴系统(Buddy System)管理物理页框分配。

- Windows的内存管理

- 分页文件(Pagefile.sys)作为虚拟内存的磁盘扩展。

- 采用按需分页(Demand Paging)和写时复制(Copy-on-Write)。

- 嵌入式系统的调整

针对资源受限设备(如IoT设备),可能禁用分页以降低开销,或使用更小的页(如1KB)。

存储器分页机制通过精巧的设计,在硬件与操作系统的协同下,实现了内存的高效管理、程序隔离和扩展性,尽管面临空间开销和性能挑战,但结合多级页表、TLB等优化技术,它依然是现代计算机系统的基石之一。

引用说明

- 《深入理解计算机系统》(Computer Systems: A Programmer’s Perspective)

- Intel® 64 and IA-32 Architectures Software Developer’s Manual

- Linux内核源码分析(kernel.org)

- Microsoft Windows Internals, Part 1 7th Edition