怎么像数据库的表录入数据

- 数据库

- 2025-08-25

- 22

基础概念铺垫

在开始前需明确两个关键点:①“表”是关系型数据库(如MySQL、PostgreSQL)中存储结构化数据的二维对象,由行(记录)和列(字段)组成;②录入数据本质是将符合表结构的外部信息转化为数据库可识别的格式并持久化保存,不同工具对应不同的实现逻辑,但核心目标一致——确保数据的完整性、准确性与高效性。

常用录入方式及操作步骤

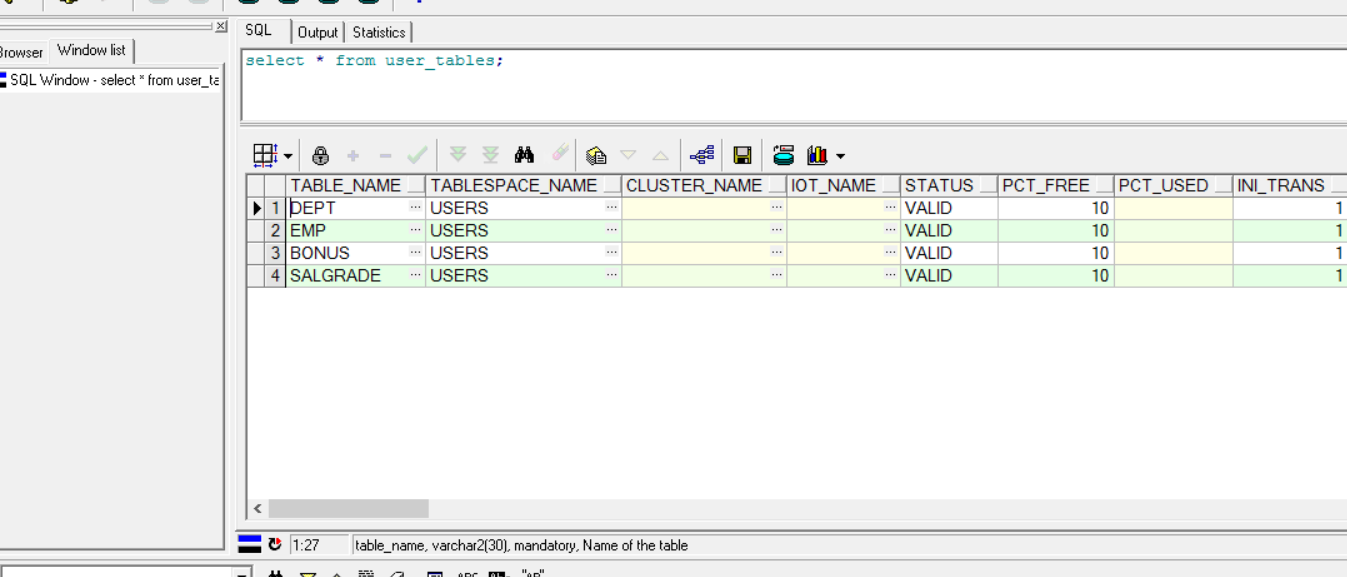

SQL语句直接插入(最通用的方法)

这是所有开发者必须掌握的基础技能,适用于单条或批量写入场景,以MySQL为例:

-

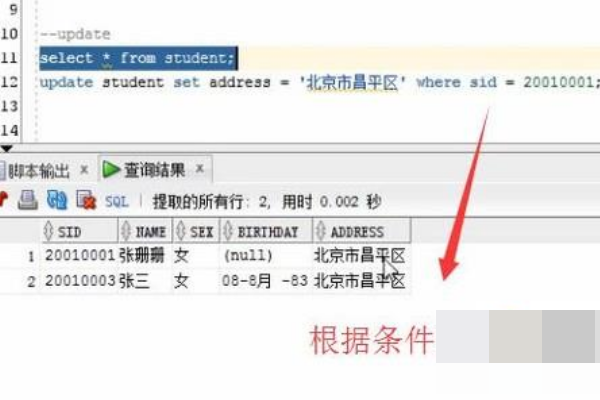

单条插入:使用

INSERT INTO语法,需指定目标列(可选)和对应值,例如向学生表students(含id、name、age三列)添加一条新记录:INSERT INTO students (id, name, age) VALUES (1001, '张三', 20);

若省略列名,则默认按表中定义的顺序赋值(风险较高,建议显式声明列名)。

-

批量插入:通过逗号分隔多组值,显著提升效率,例如同时添加3名学生:

INSERT INTO students (id, name, age) VALUES (1002, '李四', 19), (1003, '王五', 21), (1004, '赵六', 18);

注意:部分数据库支持从外部文件加载数据(如MySQL的

LOAD DATA INFILE),适合大规模导入。 -

带约束的处理:若表中存在主键、唯一索引或外键约束,需提前校验数据合法性,例如主键冲突时会报错,此时可通过

ON DUPLICATE KEY UPDATE实现“存在则更新”的逻辑:INSERT INTO students (id, name, age) VALUES (1001, '新张三', 22) ON DUPLICATE KEY UPDATE name=VALUES(name), age=VALUES(age);

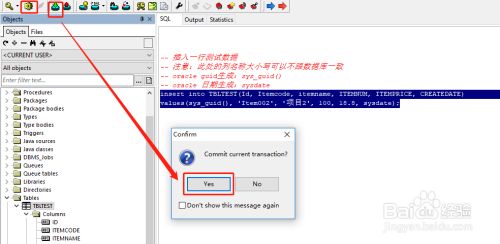

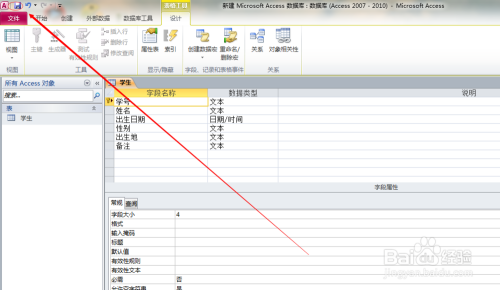

图形化界面工具(GUI)操作

对于非技术人员或临时测试场景,使用Navicat、DBeaver等可视化工具更直观,以Navicat为例:

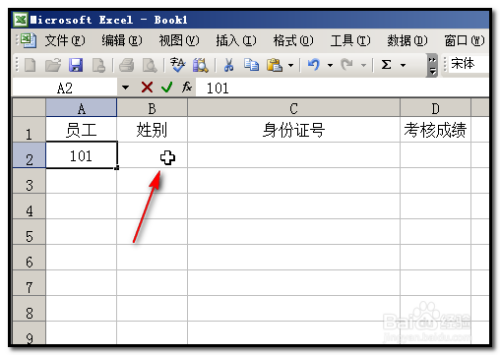

- 步骤1:连接数据库后展开目标库,找到目标表并右键选择“打开表”;

- 步骤2:在弹出的表格视图中直接点击空白行的单元格输入数据(类似Excel);

- 步骤3:完成输入后点击工具栏的“保存”按钮提交更改。

此方法优点是无需编写代码,但缺点是无法高效处理大量数据(超过百条时卡顿明显)。

编程语言API调用(自动化场景首选)

实际开发中,通常通过程序动态生成并插入数据,以Python+PyMySQL为例:

import pymysql

# 建立连接

conn = pymysql.connect(host='localhost', user='root', password='your_pwd', db='test_db')

cursor = conn.cursor()

# 准备SQL模板(防SQL注入!)

sql = "INSERT INTO students (id, name, age) VALUES (%s, %s, %s)"

# 构造待插入的数据列表(每个元素是一个元组)

data = [

(1005, '陈七', 23),

(1006, '周八', 24)

]

try:

cursor.executemany(sql, data) # executemany用于批量执行相同结构的多条语句

conn.commit() # 必须提交事务才会真正保存到数据库

except Exception as e:

conn.rollback() # 出错时回滚未提交的操作

print(f"插入失败: {e}")

finally:

cursor.close()

conn.close()

关键细节:①使用参数化查询(占位符%)避免SQL注入攻击;②务必调用commit()提交事务(默认自动提交可能关闭);③异常处理时及时回滚以保证数据一致性。

其他语言如Java(JDBC)、C#(ADO.NET)原理类似,均需遵循“连接→准备语句→绑定参数→执行→提交”的流程。

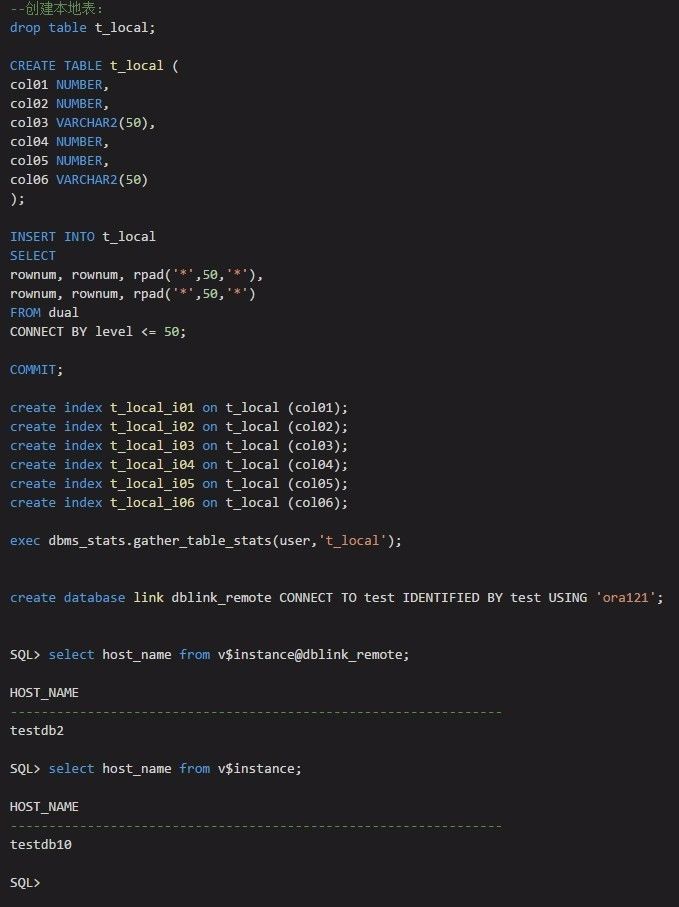

ETL工具批量导入(大数据场景必备)

当需要从CSV、Excel或其他系统迁移海量数据时,ETL(Extract-Transform-Load)工具是最优选择,以Apache Spark为例:

- 读取源文件(如CSV):通过

spark.read.csv("input.csv")加载原始数据; - 清洗转换:利用DataFrame API过滤无效行、修正格式错误(如将字符串类型的年龄转为整数);

- 写入数据库:使用

df.write.jdbc(url="jdbc:mysql://localhost:3306/test_db", table="students", mode="append")完成最终导入。

此类工具的优势在于分布式计算能力,可处理TB级甚至PB级数据,且支持复杂的预处理逻辑。

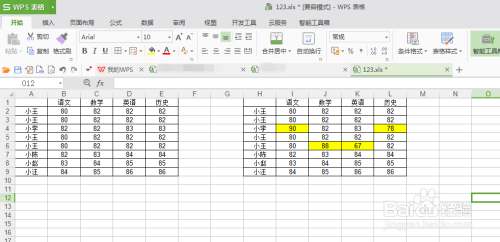

关键注意事项

| 维度 | 具体要求 | 后果示例 |

|---|---|---|

| 数据类型匹配 | 确保输入值与字段定义的类型一致(如INTEGER列不能存字符串“abc”) | 报错或隐式转换导致精度丢失 |

| 主键/唯一性 | 避免重复的主键值或违反唯一约束的值 | 插入失败,事务回滚 |

| 非空约束 | NOT NULL字段必须提供有效值 | 直接拒绝插入 |

| 外键关联 | 引用其他表的主键必须存在于被引用表中 | 破坏参照完整性,触发级联删除等 |

| 编码问题 | 统一字符集(如UTF-8),防止乱码 | 存储后的文本显示为问号??? |

| 性能优化 | 批量插入时禁用索引、减少事务日志量 | 单条插入效率低至10倍以下 |

常见问题答疑(FAQs)

Q1:插入数据时提示“主键冲突”,如何解决?

A:首先检查是否误用了已存在的主键值;若业务允许更新而非报错,可在SQL中添加ON DUPLICATE KEY UPDATE子句(如MySQL);若需强制插入新记录,则需修改主键生成策略(例如改用自增ID),示例:将原语句改为INSERT ... ON DUPLICATE KEY UPDATE ...后,当主键已存在时会自动更新对应字段的值。

Q2:如何高效批量插入10万条数据?

A:推荐两种方案:①使用数据库原生的批量加载命令(如MySQL的LOAD DATA LOCAL INFILE),直接读取本地文件并解析,速度比逐条插入快数十倍;②通过编程语言的批量执行接口(如Python的executemany),配合事务批处理(每5000条提交一次),减少网络往返开销,避免逐条执行INSERT