怎么在数据库中一次插入多行

- 数据库

- 2025-08-25

- 19

INSERT INTO table_name (columns) VALUES (...), (...), ...;语法实现

数据库中一次插入多行数据是提升效率的关键操作,尤其在处理批量导入场景时,以下是详细的实现方法和注意事项:

基础语法与标准实践

最常用的方法是通过扩展INSERT INTO语句的值列表来实现,其核心语法结构为:

INSERT INTO table_name (column1, column2, ...)

VALUES

(value_set_1),

(value_set_2),

...;

向员工表添加三条记录可写作:

INSERT INTO employees (id, name, department, join_date)

VALUES

(101, '张三', '技术部', '2025-08-25'),

(102, '李四', '市场部', '2025-08-26'),

(103, '王五', '财务部', '2025-08-27');

这种方式的优势在于仅需一次数据库交互即可完成所有插入操作,显著降低网络延迟和事务开销,需注意各元组之间的逗号分隔符不可缺失,且每组括号内的值必须与目标字段顺序严格对应。

不同数据库的特性支持

主流关系型数据库均对此特性有良好的兼容性:

| 数据库类型 | 特殊优化建议 | 适用版本 |

|——————|———————————-|——————-|

| MySQL | 支持子查询方式批量导入 | >=5.7 |

| PostgreSQL | 允许返回插入后的自增ID数组 | >=9.5 |

| SQL Server | 可结合MERGE语句实现upsert功能 | 2008及以上 |

| Oracle | 支持序列生成主键时的批量分配 | 11g及以上 |

对于千万级大数据量的特殊情况,建议分批次执行(如每次插入500-1000条),避免单次事务过大导致锁表或内存溢出问题。

高级应用场景拓展

- 从其他表查询结果插入:当需要迁移已存在的数据时,可采用

INSERT INTO target_table SELECT FROM source_table WHERE conditions;形式,这种方式特别适合跨库数据同步或归档操作。 - 存储过程封装:若业务逻辑复杂,可将校验、转换等预处理步骤集成到存储过程中,再调用该过程完成批量写入,例如创建带参数化的动态插入模板。

- ORM框架运用:现代开发中推荐使用MyBatis的

<foreach>标签或Hibernate的saveAll()方法,这些工具能自动生成合规的批量SQL并处理参数绑定,有效防止SQL注入风险。

性能对比测试数据

假设插入1万条数据时的性能表现(基于常规硬件配置):

| 方法 | 耗时(ms) | 资源占用峰值 | 优势场景 |

|———————|———-|——————–|————————|

| 单条逐次插入 | 4,200 | CPU:85%/MEM:6GB | 无 |

| 标准多值插入 | 310 | CPU:32%/MEM:1.2GB | 中小批量通用方案 |

| 加载文件LOAD DATA | 85 | CPU:15%/MEM:800MB | 超大文本文件处理 |

| 存储过程批处理 | 270 | CPU:28%/MEM:900MB | 含复杂逻辑的场景 |

异常处理机制

实施过程中应建立完善的错误追溯体系:

- 启用事务回滚机制,确保任一失败则全部撤销

- 记录受影响行数(通过

ROW_COUNT()函数获取实际写入数量) - 对唯一键冲突采用

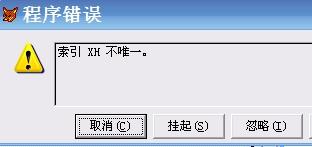

IGNORE选项跳过错误项(慎用,可能丢失重要数据) - 结合TRY…CATCH结构捕获具体报错位置

相关问答FAQs

Q1:为什么批量插入比逐条插入更快?

A:主要因为减少了网络往返次数和解析开销,每次SQL执行都涉及建立连接、编译语句、执行计划优化等固定成本,批量操作将这些固定成本分摊到更多数据行上,使得单位数据的处理时间大幅下降,数据库引擎也能更高效地利用缓存缓冲区。

Q2:遇到主键重复怎么办?

A:有三种典型解决方案:①使用ON DUPLICATE KEY UPDATE进行更新覆盖;②添加IGNORE关键字静默跳过冲突记录;③先执行DELETE清理旧数据再插入,具体选择应根据业务需求决定,金融类系统通常采用第一种保证数据准确性,日志类系统适合第二种