上一篇

java怎么读取汉字文件

- 后端开发

- 2025-08-17

- 19

使用

new InputStreamReader(new FileInputStream(file), "GBK")或”UTF-8″指定编码,配合`BufferedReader

在Java中读取包含汉字的文件时,核心挑战在于字符编码的正确解析,由于中文字符集(如GBK、UTF-8)与默认的ASCII编码存在差异,若未显式指定编码格式,程序可能出现乱码或读取失败,以下从原理到实践全面解析实现方案,并提供完整示例与避坑指南。

关键概念梳理

| 术语 | 说明 |

|---|---|

| 字节流 | FileInputStream直接操作二进制数据,需配合解码器转为字符 |

| 字符流 | FileReader基于默认平台编码(易出错),建议改用带编码参数的版本 |

| 编码转换 | 将文件中的字节序列按指定规则映射为Unicode字符(如UTF-8→U+00E4=ä) |

| BOM标记 | UTF-8/16文件开头的特殊标识符,帮助IDE自动识别编码类型 |

| 缓冲机制 | BufferedReader通过预加载数据块提升IO效率,尤其适合大文件处理 |

️ 重要原则:始终明确文件的实际编码格式,并在读取时显式声明,多数中文系统默认使用GBK,但现代开发推荐统一采用UTF-8。

主流实现方案对比

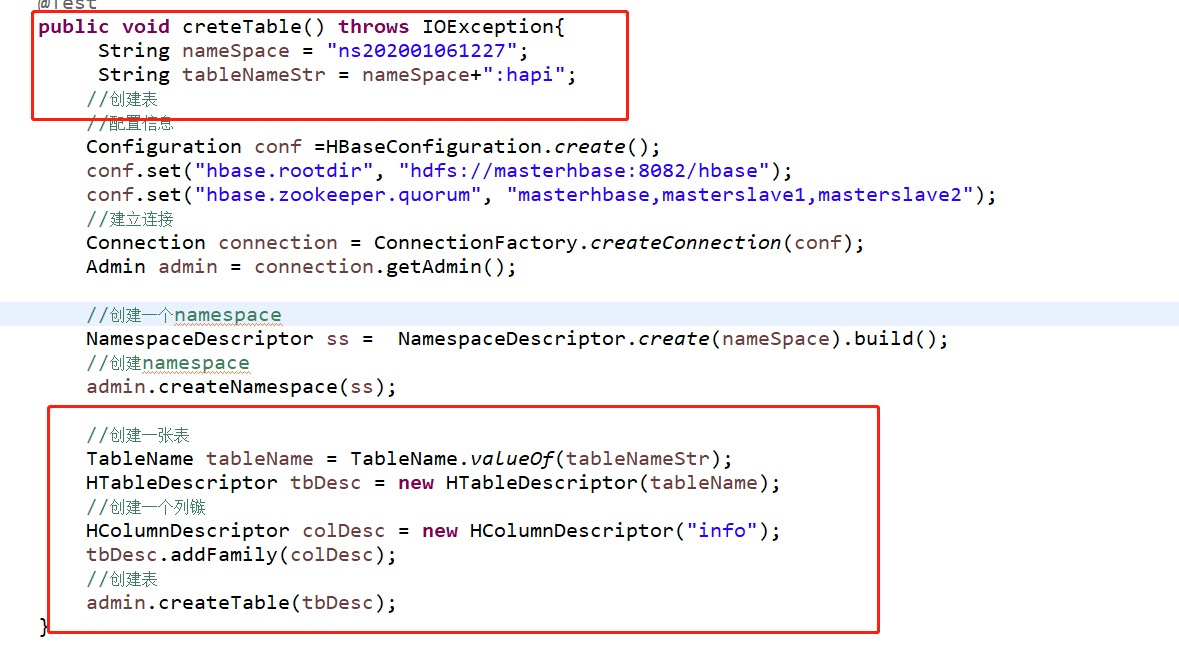

推荐方案1:InputStreamReader + FileInputStream(灵活控制编码)

import java.io.;

public class ChineseFileReader {

public static void main(String[] args) {

String filePath = "test.txt"; // 替换为你的文件路径

String encoding = "UTF-8"; // 根据实际文件编码修改

try (

FileInputStream fis = new FileInputStream(filePath);

InputStreamReader isr = new InputStreamReader(fis, encoding);

BufferedReader br = new BufferedReader(isr)

) {

String line;

while ((line = br.readLine()) != null) {

System.out.println(line); // 正常输出中文

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

优势:

- 精确控制编码格式,避免平台依赖

- 支持任意编码类型(GBK/UTF-8/Big5等)

- 结合

BufferedReader实现高效逐行读取 - 自动关闭资源的try-with-resources语法

适用场景:已知文件编码且需要跨平台兼容的场景。

备选方案2:FileReader(慎用!依赖系统默认编码)

// 不推荐!当系统默认编码非文件实际编码时会乱码

try (FileReader fr = new FileReader("test.txt");

BufferedReader br = new BufferedReader(fr)) {

// ...同上...

}

风险警示:Windows系统默认编码为GBK,Linux/macOS多为UTF-8,此方案在不同环境下表现不一致。

️ 进阶方案3:第三方库Hutool(简化复杂操作)

添加Maven依赖:

<dependency>

<groupId>cn.hutool</groupId>

<artifactId>hutool-all</artifactId>

<version>5.8.16</version>

</dependency>

使用示例:

import cn.hutool.core.io.FileUtil;

String content = FileUtil.readUtf8String("test.txt"); // 自动处理换行符

特点:封装了常见编码检测逻辑,适合快速开发但对性能要求不高的场景。

常见问题排查手册

| 现象 | 原因分析 | 解决方案 |

|---|---|---|

| 显示▯或□符号 | 编码不匹配 | 修改InputStreamReader的编码参数 |

| 抛出MalformedInputException | 文件头缺少BOM标记 | 改用new InputStreamReader(fis, StandardCharsets.UTF_8) |

| 多出空行 | 换行符处理不当 | 启用br.readLine()而非fis.read() |

| 内存溢出 | 超大文件未分块读取 | 改用NIO的FileChannel或流式处理 |

实战案例:某用户反馈读取CSV文件时姓名列乱码,经查证,该文件虽扩展名为.csv,但实际保存为GBK编码,修正后的代码如下:

new InputStreamReader(new FileInputStream(file), "GBK")

完整功能增强版代码

import java.io.;

import java.nio.charset.StandardCharsets;

import java.util.Scanner;

public class AdvancedChineseReader {

public static void main(String[] args) {

Scanner scanner = new Scanner(System.in);

System.out.print("请输入文件路径:");

String path = scanner.nextLine();

System.out.print("请输入文件编码(留空自动检测):");

String charsetName = scanner.nextLine().trim();

Charset charset;

if (charsetName.isEmpty()) {

// 简单启发式检测:前三个字节是否符合UTF-8特征

try (DataInputStream dis = new DataInputStream(new FileInputStream(path))) {

byte b1 = dis.readByte();

byte b2 = dis.readByte();

byte b3 = dis.readByte();

if ((b1 & 0xFF) == 0xEF && (b2 & 0xFF) == 0xBB && (b3 & 0xFF) == 0xBF) {

charset = StandardCharsets.UTF_8;

} else {

charset = StandardCharsets.GBK;

}

} catch (IOException e) {

System.err.println("检测失败,默认使用GBK编码");

charset = StandardCharsets.GBK;

}

} else {

charset = Charset.forName(charsetName);

}

processFile(path, charset);

}

private static void processFile(String path, Charset charset) {

try (

FileInputStream fis = new FileInputStream(path);

InputStreamReader isr = new InputStreamReader(fis, charset);

BufferedReader br = new BufferedReader(isr)

) {

int lineNum = 0;

String line;

while ((line = br.readLine()) != null) {

lineNum++;

System.out.printf("第%d行: %s%n", lineNum, line);

}

} catch (IOException e) {

System.err.println("读取文件出错:" + e.getMessage());

}

}

}

新增特性:

- 交互式输入路径和编码

- 简单的BOM检测逻辑

- 带行号的结构化输出

- 完善的异常捕获机制

性能优化建议

| 优化方向 | 实施方法 | 效果提升 |

|---|---|---|

| 减少对象创建 | 复用同一个StringBuilder收集多行数据 |

降低GC压力 |

| 异步读写 | 使用CompletableFuture配合AsynchronousFileChannel |

提升吞吐量 |

| 内存映射 | MappedByteBuffer处理超大型日志文件 |

突破堆内存限制 |

| 压缩解压集成 | 结合GZIPInputStream直接读取.gz压缩包中的中文文件 |

节省存储空间 |

相关问答FAQs

Q1: 为什么同样的代码在Windows能正常显示中文,放到Linux就变成乱码?

A: 这是由于不同操作系统的默认编码不同导致的,Windows中文版默认使用GBK编码,而大多数Linux发行版默认使用UTF-8,解决方案是在InputStreamReader构造函数中显式指定文件的真实编码,new InputStreamReader(fis, "UTF-8")。

Q2: 读取Excel文件里的中文内容该怎么处理?

A: Excel文件本质是二进制格式,不能直接用文本方式读取,推荐使用Apache POI库:

import org.apache.poi.ss.usermodel.;

import java.io.FileInputStream;

Workbook workbook = WorkbookFactory.create(new FileInputStream("data.xlsx"));

Sheet sheet = workbook.getSheetAt(0);

Row row = sheet.getRow(0);

Cell cell = row.getCell(0);

String chineseText = cell.getStringCellValue(); // 自动处理中文

workbook.close();

该方法能正确解析Excel内部存储的Unicode字符