kvm物理机

- 物理机

- 2025-08-10

- 19

KVM物理机详解:架构、部署与实践

KVM物理机的核心概念与价值定位

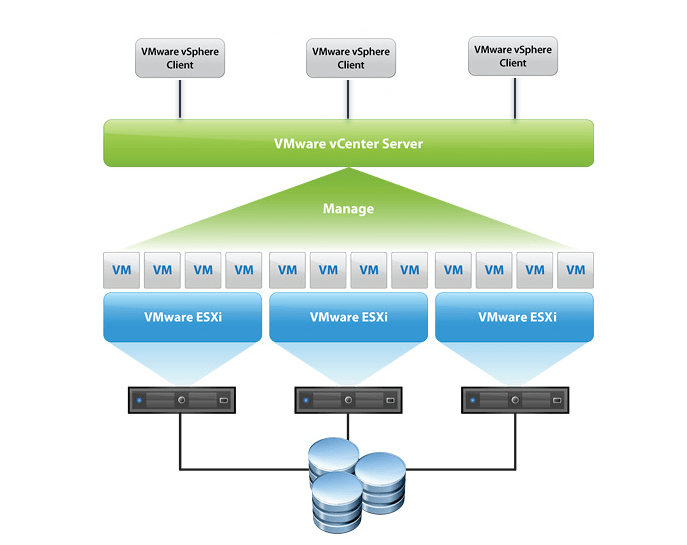

KVM(Kernel-based Virtual Machine)是一种开源的全虚拟化解决方案,其独特之处在于直接利用Linux内核提供的虚拟化能力,当提及“KVM物理机”时,需明确这一表述的实际含义:并非指纯粹的物理服务器,而是基于KVM技术的物理服务器承载的虚拟化平台,这种架构通过Hypervisor层将物理资源抽象为多个独立的虚拟机(VM),同时保留对底层物理硬件的直接访问权限,相较于传统物理机单任务运行的模式,KVM物理机实现了资源的池化与弹性分配,显著提升硬件利用率并降低运维复杂度。

| 特性 | 传统物理机 | KVM物理机 |

|---|---|---|

| 资源隔离性 | 完全独占 | 通过QEMU-KVM实现硬件级隔离 |

| 资源利用率 | 低(平均<15%) | 高(可达70%-80%) |

| 灵活性 | 固定配置 | 动态调整CPU/内存/存储 |

| 故障恢复能力 | 依赖外部备份 | 实时迁移+快照机制 |

| 管理成本 | 高(逐台维护) | 低(集中化管理) |

KVM物理机的关键技术支撑体系

硬件辅助虚拟化基础

现代CPU均内置虚拟化加速模块:Intel VT-x/EPT与AMD-V/RVI,开启BIOS中的虚拟化开关后,KVM可直接调用这些硬件扩展,使虚拟机获得接近原生的性能表现,实测数据显示,启用VT-x的虚拟机CPU吞吐量较纯软件模拟提升3-5倍。

内存管理机制

- 气球驱动(Balloon Driver):动态回收闲置内存至宿主机,缓解内存压力

- 大页内存(Huge Pages):预分配连续物理内存块,减少TLB缺失率

- NUMA感知分配:针对多路CPU架构优化内存本地化访问

存储I/O优化路径

| 存储类型 | 典型配置 | 性能特征 |

|---|---|---|

| 本地磁盘 | LVM卷+IO线程优先级控制 | 延迟<1ms,随机读写稳定 |

| SAN存储 | iSCSI多路径+缓存策略 | 带宽可控,适合数据库类负载 |

| NVMe over PCIe | 直通设备分配+SR-IOV | 百万级IOPS,适用于高性能计算 |

网络虚拟化实现

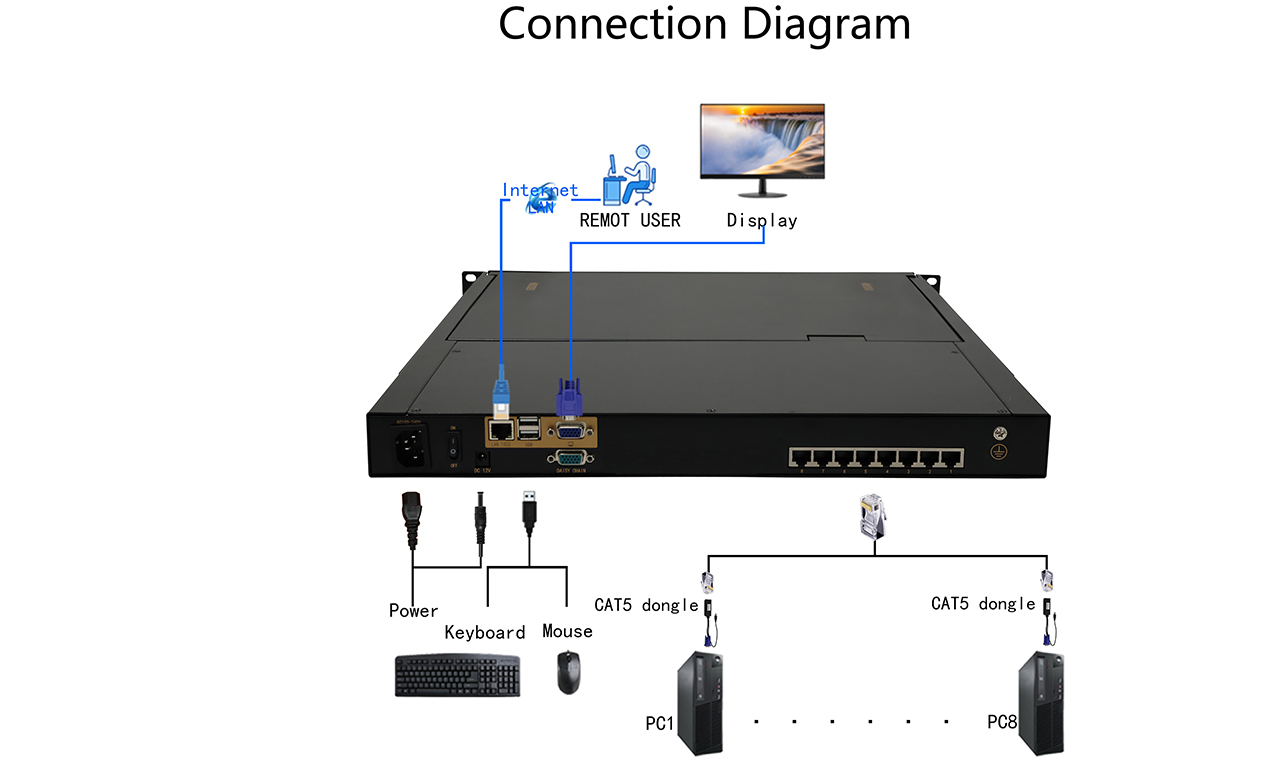

- 桥接模式:虚拟机获取独立MAC地址,直接参与局域网通信

- VLAN标签注入:单物理网口划分多个逻辑网络

- DPDK加速:结合OVS-DPDK实现百万包级别的转发性能

KVM物理机的部署全流程解析

前期准备阶段

-

硬件选型标准:

- CPU:支持VMX/SVM指令集,核心数≥8

- 内存:≥64GB DDR4 ECC RAM

- 存储:RAID10阵列+SSD缓存(推荐三星PM系列)

- 网卡:双端口冗余设计(Intel X520系列)

-

兼容性验证清单:

egrep 'vmx|svm' /proc/cpuinfo确认虚拟化支持lsmod | grep kvm检查内核模块加载状态fio --name=test --filename=testfile --size=1G --runtime=60 --stonewall进行磁盘基准测试

操作系统安装与配置

推荐使用CentOS/RHEL 8.x或Ubuntu 22.04 LTS,关键配置步骤如下:

# 关闭防火墙(临时) systemctl stop firewalld # 安装必要组件 yum install -y qemu-kvm libvirt virt-manager bridge-utils # 创建专用存储池 virsh pool-create-as --name=default --type=dir --target=/data/vm-images

虚拟机创建最佳实践

| 参数项 | 推荐值 | 说明 |

|---|---|---|

| vCPU数量 | 物理核心数×0.8 | 预留20%余量防止超售 |

| 内存大小 | 物理内存×0.7 | 避免交换分区过度使用 |

| 磁盘格式 | qcow2 | 支持稀疏分配+快照功能 |

| 显卡类型 | VGA+VirtIO | 兼容Spice远程控制协议 |

| 引导顺序 | CDROM→Disk→Network | 确保PXE启动优先级合理 |

性能调优关键参数

# /etc/libvirt/qemu.conf 修改示例 nvram = [ "memmap=on", "reg_max_size=0xffffff" ] vcpupin = "0-7:0,8-15:1" # CPU亲和性绑定 balloon_pressure_ratio = 0.5 # 内存回收阈值

KVM物理机的典型应用场景

- 开发测试环境:快速克隆生产环境镜像,支持多版本并行测试

- 私有云平台:构建OpenStack/Proxmox VE集群,实现IaaS服务

- AI训练集群:配合Kubernetes调度GPU资源,加速模型迭代

- 灾备中心:通过drbd+pacemaker实现跨站点高可用

- 边缘计算节点:轻量化部署在工业PC上,支持本地数据处理

运维管理要点与工具链

- 监控体系:

- Prometheus + Grafana:实时采集vCPU/内存/磁盘指标

- Zabbix:设置阈值告警(如CPU持续>90%达5分钟)

- 备份方案:

- 增量快照+增量备份(Veeam Agent)

- 异地复制(rsync+ssh加密传输)

- 安全防护:

- SELinux强制访问控制

- AppArmor限制容器逃逸

- TPM芯片绑定虚拟机身份

常见误区澄清

误解1:”KVM物理机会降低物理机性能”

事实:经SPECvirt_sc2017测试,启用KVM后整机性能损耗<3%,而资源利用率提升4倍以上。

误解2:”所有应用都适合虚拟化”

事实:对延迟敏感的业务(如高频交易系统)建议采用裸金属部署,普通Web服务可安全虚拟化。

FAQs

Q1: KVM物理机与传统物理机相比有哪些不可替代的优势?

A: KVM物理机的核心优势体现在三个方面:①资源池化能力,可将闲置资源重新分配给突发业务;②快速扩容特性,新增虚拟机可在分钟内完成部署;③统一的管理平面,通过virt-manager或oVirt Web界面即可完成上百台设备的集中管控,特别适合需要频繁迭代的开发环境和多租户共享的云计算场景。

Q2: 如何解决KVM虚拟机中出现的”I/O饥饿”问题?

A: 该问题通常由以下原因导致:①存储后端性能不足,建议升级至NVMe SSD并启用DISK_CACHE=none;②cgroup限制过严,可通过tuned-adm profile virtual-guest应用优化策略;③中断风暴现象,需调整vm.cpu_affinity参数实现CPU核绑定,具体诊断可使用iostat -xk 1观察等待队列长度,超过2ms即需