上一篇

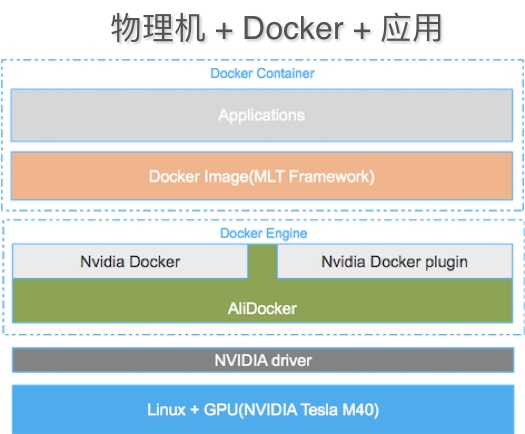

物理机跑docker

- 物理机

- 2025-08-04

- 22

机可安装Docker引擎,配置存储与网络后,便能像云主机般运行容器化

是关于在物理机上运行Docker的详细说明:

核心优势分析

- 资源利用率最大化:物理机直接承载Docker引擎时,无需经过虚拟化层(如Hypervisor),可减少性能损耗,例如CPU、内存等硬件资源能被容器更高效地调用,尤其适合需要高密度部署多个服务的场景;通过镜像技术实现环境标准化,避免传统多应用共存导致的库版本冲突问题。

- 轻量化隔离环境:每个容器本质是进程级封装,启动速度比虚拟机快数倍,且单个容器内存开销低,这种特性使得在单台物理机上并行运行数十个相互独立的业务成为可能。

- 灵活的环境管理:支持快速切换不同版本的依赖组件,开发者可以在不同项目中指定精确的基础镜像,实现开发/测试/生产环境的一致性复制。

- 便捷的批量操作:配合Docker Compose工具,可通过yaml文件定义多容器间的依赖关系与启动顺序,实现复杂系统的一键编排。

适用场景判断标准

| 维度 | 推荐使用Docker的情况 | 不建议使用的情况 |

|---|---|---|

| 应用数量 | 同时运行≥3个相互独立的应用程序或微服务 | 仅维护单一简单应用 |

| 环境复杂度 | 存在跨语言依赖、特殊配置需求或异构技术栈组合 | 所有组件均可用包管理器统一安装 |

| 资源敏感度 | 需要动态分配CPU核心/内存配额进行压力测试 | 对硬件资源有严格独占要求的实时系统 |

| 生命周期管理 | 频繁迭代更新的版本控制需求 | 长期稳定的静态服务架构 |

实施关键步骤详解

- 环境初始化:安装最新版Docker Engine并配置加速器镜像源,建议启用Swap限制防止内存溢出,验证安装成功可通过

docker run hello-world测试基础功能可用性。 - 镜像构建策略:采用分层构建原则,优先继承官方基础镜像,对于Java类应用,可选择OpenJDK作为基底;前端项目则适合使用Nginx镜像作为载体,注意保持镜像体积精简,避免无关组件残留。

- 端口与目录映射:通过

-p参数实现宿主机与容器间的端口转发,如-p 8080:80将内部Web服务暴露至外部访问,数据持久化方面,使用-v参数绑定主机目录到容器内路径,确保重启后数据不丢失。 - 资源约束设置:针对关键业务容器,显式指定

--memory=2g --cpus=2等参数进行资源硬限制,防止某个异常进程耗尽整机资源影响其他服务稳定性。 - 安全加固措施:启用AppArmor安全模块限制容器权限,定期扫描镜像破绽,生产环境中应关闭远程API接口,必要时通过HTTPS+TLS认证进行管理。

典型故障排查方案

当遇到容器响应缓慢时,可按以下流程诊断:

- 执行

docker stats查看实时资源占用情况; - 使用

docker inspect <container_id>获取详细配置信息; - 进入容器内部运行

top命令定位高负载进程; - 检查日志输出是否存在异常堆栈跟踪;

- 对比宿主机与容器内的网络延迟情况。

性能优化实践

- 镜像分层优化:合并RUN指令减少中间层数量,利用构建缓存加速后续编译过程,定期清理未使用的镜像和容器释放磁盘空间。

- 存储驱动选择:根据文件系统特点选用合适的存储后端,机械硬盘优先选择overlay2驱动以提升随机读写性能。

- 网络模式调优:默认bridge模式满足大多数场景,如需跨主机通信可配置overlay网络,数据库类应用建议启用macvlan模式获得独立IP地址。

FAQs:

-

问:物理机运行Docker是否会影响主机稳定性?

答:合理规划资源配额的前提下不会显著影响主机稳定性,但需注意避免过度分配导致Swap频繁换页,建议保留至少20%的冗余资源供系统应急使用。 -

问:如何实现物理机与容器间的文件同步?

答:除基本的-v挂载方式外,还可通过Docker插件实现双向同步,例如使用Flocker工具创建分布式存储卷,或配置NFS共享目录实现多容器间文件