上一篇

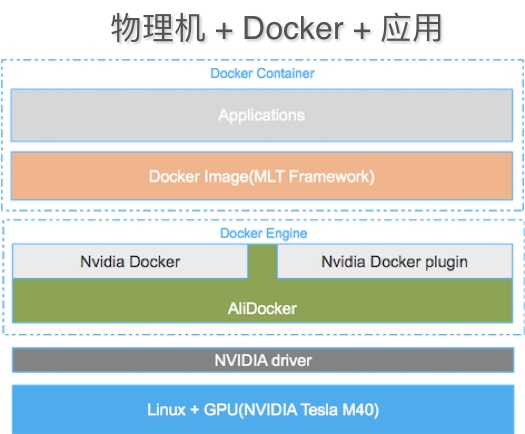

物理机 docker 数量

- 物理机

- 2025-08-04

- 18

机上可运行的Docker容器数量取决于其CPU、内存等

“物理机与Docker数量”的关系,这是一个涉及技术架构、资源分配和性能优化的复杂话题,以下是详细分析:

影响单台物理机能运行的Docker容器数量的因素

-

硬件资源配置

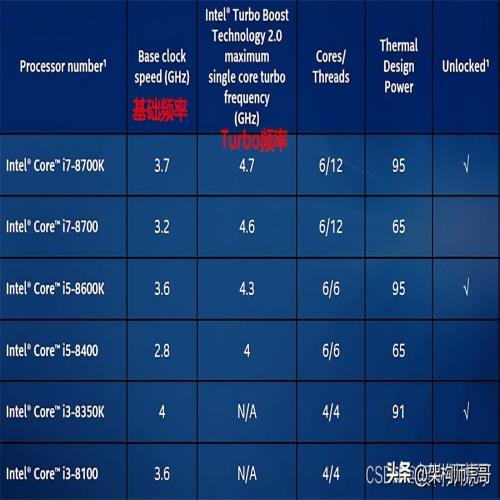

- CPU核心数与频率:每个容器至少需要分配一定比例的CPU时间片,若一个Web服务需0.5个逻辑核心,则16核服务器理论上可支持约32个此类实例;但高负载应用可能独占多个核心,显著减少并发数量。

- 内存容量:容器的总内存占用不能超过宿主机的可用RAM,轻量级服务(如Nginx)可能仅需几十MB,而数据库或AI模型推理任务可能需要数GB甚至更多;此外还需考虑系统本身及其他进程的开销。

- 磁盘I/O与存储空间:镜像文件、数据卷及日志会持续写入硬盘,低速存储设备可能成为瓶颈,SSD相比HDD能提供更高的读写吞吐量,适合承载更多容器。

- 网络带宽:多容器同时进行大量数据传输时易造成拥堵,尤其是依赖端口映射的场景下,端口冲突也可能限制规模扩展。

-

操作系统层面的约束

- 内核参数设置:Linux通过cgroups和namespaces实现资源隔离,但默认的限制(如最大进程数、打开文件句柄数)可能阻碍高密度部署,管理员可通过调整

ulimit值或修改内核模块参数来放宽这些限制。 - 交换分区策略:启用SWAP可缓解短期内存压力,避免因OOM错误导致容器被强制终止;然而过度依赖虚拟内存会影响整体性能稳定性。

- 内核参数设置:Linux通过cgroups和namespaces实现资源隔离,但默认的限制(如最大进程数、打开文件句柄数)可能阻碍高密度部署,管理员可通过调整

-

应用特性差异

- 工作负载类型:静态网页服务器的资源消耗远低于实时视频转码服务,同一台机器上混合部署不同性质的应用时,实际承载能力需按加权平均计算。

- 初始化模式:长时间运行的守护进程型容器比频繁启停的批处理任务更稳定,后者可能因瞬时资源争抢引发连锁反应。

-

编排工具的影响

- 调度算法效率:Kubernetes等平台采用智能调度机制,优先将新任务分配至资源利用率较低的节点,从而提升集群整体吞吐率;手工管理则难以达到同等优化效果。

- 健康检查机制:自动化的健康监测能快速替换故障容器,维持服务可用性,间接提高有效利用率。

典型场景下的估算示例

| 硬件规格 | 典型应用类型 | 预估最大容器数 | 备注 |

|---|---|---|---|

| 4核8GB内存 | 轻量级Web服务 | 数十~上百个 | 假设单容器约0.1核/100MB内存 |

| 16核32GB内存 | 中等复杂度微服务 | 约64个 | 按0.5核+512MB基准计算 |

| 高端服务器集群 | 混合型工作负载 | 成千上万个 | 配合Kubernetes动态调配资源 |

规模化管理的关键技术方案

-

集群化部署工具

- Docker Swarm:原生支持跨主机编排,适合快速搭建同构环境,通过

docker swarm init初始化管理节点后,其他物理机可便捷加入集群。 - Kubernetes:提供更细粒度的控制能力,支持自动扩缩容、服务发现等高级特性,使用kubeadm初始化Master节点,再通过join命令纳入Worker节点构建完整体系。

- Docker Swarm:原生支持跨主机编排,适合快速搭建同构环境,通过

-

自动化运维实践

- 脚本批处理:利用Bash或Ansible实现标准化安装流程,批量配置Swarm/K8s环境,减少人工干预成本。

- 监控告警体系:集成Prometheus采集指标数据,结合Grafana可视化展示系统状态;ELK栈集中处理日志信息,便于追溯问题根源。

-

性能调优策略

- 资源配额管理:为关键业务设置优先级策略,防止非重要进程耗尽全局资源,例如使用

--cpus="1.5"和--memory="1g"参数明确界定单个容器上限。 - 网络插件选择:根据业务特点选用Calico、Flannel等CNI插件优化东西向流量通信质量,降低延迟抖动。

- 资源配额管理:为关键业务设置优先级策略,防止非重要进程耗尽全局资源,例如使用

相关问答FAQs

-

问:一台物理机真的能运行无限个Docker容器吗?

答:技术上没有硬性限制,但实际数量受CPU、内存、磁盘IO等硬件条件制约,一个仅运行基础监控组件的机器可能托管上百个休眠状态的容器,而满载数据库服务的同配置设备可能只能支撑几个活跃实例。 -

问:如何判断当前系统的容器密度是否合理?

答:建议持续观察三个核心指标:CPU使用率应保持在70%以下以避免饱和;内存剩余量不低于总容量的20%;磁盘写入速率不超过存储子系统的标称最大值的80%,当接近阈值时,可通过水平扩展添加新节点或垂直升级现有设备来解决瓶颈。

物理机与Docker容器的数量关系并非固定不变,而是动态平衡的过程,通过科学规划、精细管理和持续优化,可以在有限资源内实现最大化的服务承载能力