物理机挂载ceph

- 物理机

- 2025-08-03

- 20

是关于物理机挂载Ceph的详细操作指南:

前期准备与环境搭建

-

部署Ceph集群

- 节点规划:至少需要3台物理机作为存储节点(OSD),并可选部署监控节点(MON)、管理网关(MGR)和元数据服务器(MDS),某案例中使用了三台不同品牌的物理机(如Huashan Technologies R4900 G2、Sugon I620-G20等),每台配置多块硬盘用于数据存储,系统盘采用RAID1保证可靠性,数据盘根据RAID卡支持情况选择单盘RAID0或直通模式。

- 网络配置:确保所有节点间网络互通,建议使用专用局域网(如10Gbps带宽),并配置DNS解析以便于管理,可通过修改

/etc/resolv.conf和NetworkManager.conf实现内网域名解析。 - 安装依赖包:在所有节点上安装Ceph相关组件,包括ceph-deploy工具、基础软件包及YUM源配置,通过挂载ISO镜像到FTP服务,为各节点提供统一的安装介质。

-

创建存储池与RBD镜像

- 在Ceph集群中创建名为

rbd的存储池,并基于该池生成RBD图像(RBD Image),这一步将为后续的块设备映射提供基础资源。

- 在Ceph集群中创建名为

配置iSCSI网关实现远程挂载

由于OpenStack原生驱动不支持物理机的远端卷挂载,需借助iSCSI协议进行间接接入:

- 部署iSCSI网关节点

部署2~4台虚拟机或物理机作为iSCSI网关,这些节点需同时作为Ceph客户端加入集群],其作用是将Ceph的RBD镜像导出为SCSI磁盘设备(LUN),并通过TCP/IP网络暴露给目标物理机。

- 设置认证与目标服务

在网关节点上创建iSCSI Target,配置CHAP认证信息(用户名/密码)及客户端访问白名单,将之前创建的RBD镜像绑定到此Target下,形成可被发现的存储目标。

- 映射到存储节点本地卷

存储节点作为iSCSI发起端,主动发现并登录到网关节点的Target服务,完成RBD设备的本地化映射,这一过程涉及修改认证参数、建立会话连接,最终使存储节点识别出新增的逻辑卷。

控制节点调度与卷分配

- 构建LVM逻辑卷体系

根据映射后的底层物理卷(PV),依次创建物理卷组(VG)、指定卷类型(如线性映射),然后生成可供物理机使用的LVM逻辑卷(LV),该步骤由控制节点自动化完成,确保资源隔离性和灵活性。

- 关联物理机与卷标识符

当用户请求为某台物理机挂载特定卷时,控制节点记录两者的绑定关系(包括IP地址、卷ID等元数据),并将这些信息同步至计算节点,计算节点会在对应的Node信息中添加卷的唯一标识符,保持控制侧与物理侧状态一致。

物理机端的发现与登录流程

- 查询卷元数据

用户通过卷ID发起查询请求,控制节点返回当前状态(是否已挂载)、对应的iSCSI Target IP地址及认证凭据,若状态为“in-use”,则附带完整的连接参数;否则仅返回基础属性。

- 执行iscsiadm命令

- 在目标物理机上运行

iscsiadm -m discovery扫描可用目标,匹配之前获取的IP地址和Target名称,随后使用iscsiadm -l login携带CHAP凭证完成登录,系统将自动挂载识别到的设备文件(如/dev/sdx)。

- 在目标物理机上运行

验证与优化

- 检查挂载结果

- 确认设备文件已正确出现在文件系统中,可通过

lsblk或fdisk -l查看磁盘布局,同时验证I/O性能是否满足需求,必要时调整Ceph的CRUSH算法参数以优化数据分布。

- 确认设备文件已正确出现在文件系统中,可通过

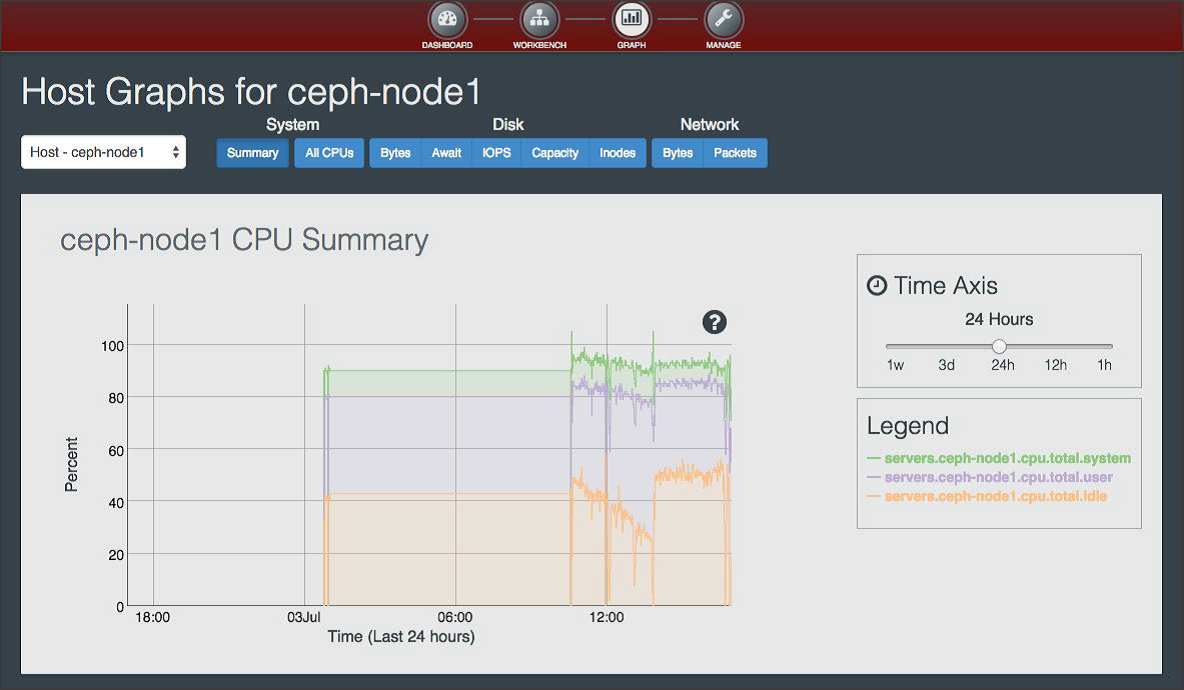

- 监控集群健康度

- 定期查看Ceph的整体状态(

ceph health detail),关注PG(Placement Group)分布合理性、OSD负载均衡性等指标,避免因热点导致性能瓶颈。

- 定期查看Ceph的整体状态(

FAQs:

-

问:为什么物理机无法直接使用Ceph RBD作为后端存储?

答:因为OpenStack管理物理裸机的驱动不支持远端卷挂载机制,而iSCSI协议通过标准SCSI指令集实现了跨网络的块设备共享,从而绕过这一限制。 -

问:如何确保迁移后的物理机能持续访问同一卷?

答:Ceph的分布式特性决定了卷数据不绑定具体节点,只要目标物理机能接入集群网络并持有有效认证,即可通过相同的iSCSI Target名称重新发现并挂载原卷,无需数据拷贝