上一篇

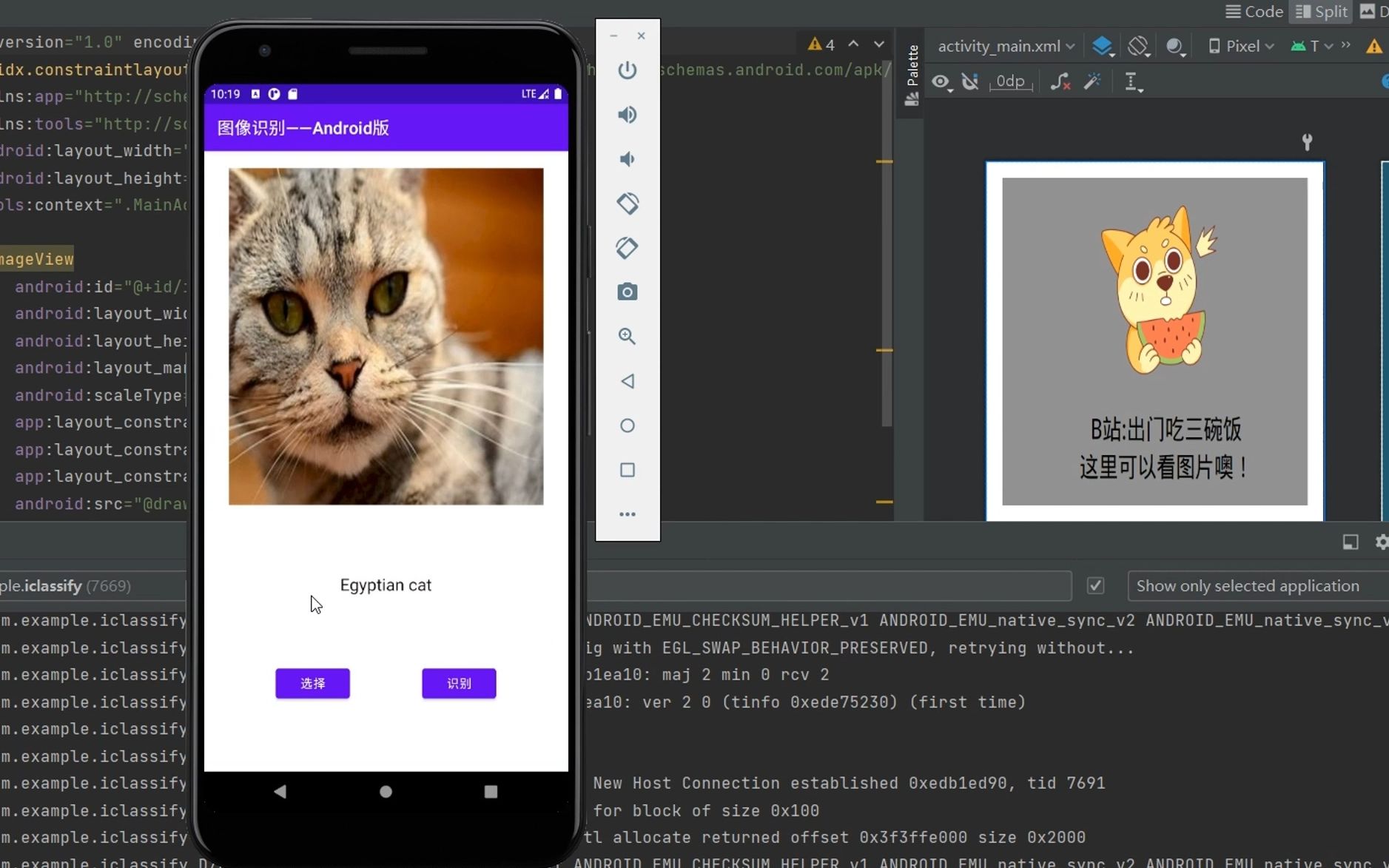

安卓图像识别分类

- 行业动态

- 2025-04-23

- 6

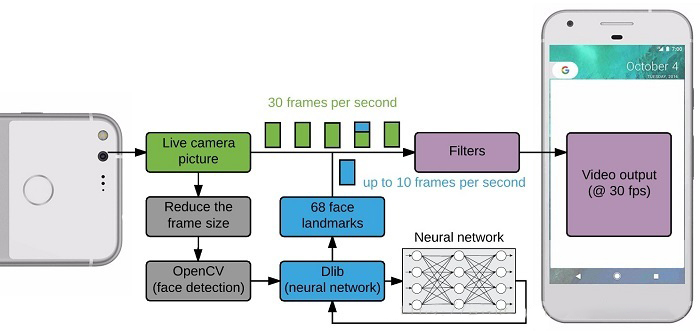

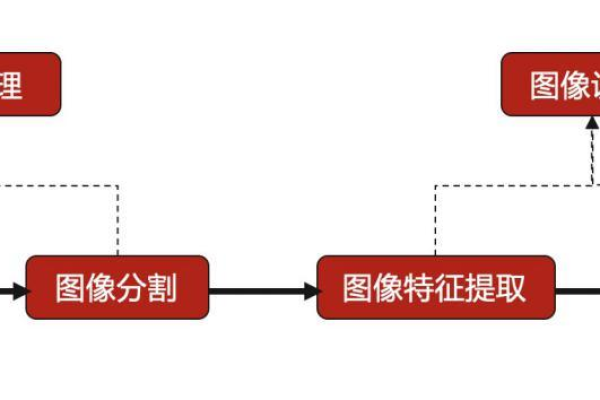

安卓图像识别分类通过卷积神经网络(CNN)模型实现,利用TensorFlow Lite/ML Kit等框架部署轻量化模型,结合摄像头实时采集图像,经预处理、特征提取后完成目标分类,适用于物体识别、场景分类等移动应用场景

技术框架与工具选择

安卓图像识别分类主要依赖机器学习框架与移动端优化技术,常见方案如下:

| 工具/框架 | 特点 | 适用场景 |

|---|---|---|

| TensorFlow Lite | 轻量级TF框架,支持模型量化、GPU加速,跨平台兼容性强 | 本地推理,需高性能模型 |

| ML Kit(Firebase) | 谷歌提供的现成API,支持多种预训练模型(如文本、物体检测),无需模型训练 | 快速集成,云端/本地混合方案 |

| OpenCV + DNN | 开源计算机视觉库,支持自定义模型加载,需手动优化性能 | 复杂算法定制,需灵活控制 |

| Core ML(仅限iOS) | 苹果生态优化,若需跨平台需额外适配 | iOS端部署 |

模型选择与优化策略

模型轻量化

移动端需平衡准确率与计算资源,常用轻量模型:

- MobileNet:深度可分离卷积,参数少(如MobileNetV3)

- EfficientNet:复合缩放策略,精度更高但计算稍大

- SqueezeNet:极小参数量,适合低功耗设备

模型量化

| 量化方式 | 特点 | 效果 |

|---|---|---|

| FP32→INT8 | 降低模型体积4倍,加速推理 | 部分精度损失,需校准 |

| 动态范围量化 | 运行时动态量化,无需重训练 | 精度损失较小,速度提升有限 |

硬件加速

- GPU:通过OpenGL/Vulkan加速卷积运算(如TFLite GPU委托)

- NNAPI:调用安卓神经网络API,利用NPU/DSP(华为/三星等设备)

- Delegate:框架自带的硬件加速接口(如TFLite的NNAPI委托)

开发流程与关键步骤

环境搭建

- 安装Android Studio,配置NDK(C++支持)

- 添加依赖库(如

tflite或mlkit):// TensorFlow Lite示例 implementation 'org.tensorflow:tensorflow-lite:2.9.0' implementation 'org.tensorflow:tensorflow-lite-gpu:2.9.0'

模型转换

- TF模型转TFLite:

import tensorflow as tf converter = tf.lite.TFLiteConverter.from_saved_model('model_dir') tflite_model = converter.convert() with open('model.tflite', 'wb') as f: f.write(tflite_model) - 量化操作:

converter.optimizations = [tf.lite.Optimize.DEFAULT] converter.representative_dataset = representative_data_gen # 校准数据生成器

代码实现

加载模型:

MappedByteBuffer model = FileUtil.loadMappedFile(context, "model.tflite"); Interpreter interpreter = new Interpreter(model, options);

预处理与推理:

// 输入预处理(如归一化、resize) Bitmap bitmap = ... // 获取相机图像 float[][] input = preprocess(bitmap); // 执行推理 float[] output = new float[1]; interpreter.run(input, output);

性能调优

- 多线程处理:将图像采集、推理、UI更新分离至不同线程

- 分辨率适配:根据设备性能动态调整输入图像尺寸(如224×224→112×112)

- 内存优化:复用输入/输出数组,避免频繁GC

常见问题与解决方案

模型精度不足

- 原因:过度量化导致特征丢失,或训练数据与实际场景差异大

- 解决:

- 使用更大数据集进行模型校准

- 采用混合精度量化(部分层保留FP32)

- 微调模型(Fine-tune)以适应特定任务

设备兼容性问题

- 原因:不同芯片架构(ARM/x86)、安卓版本API差异

- 解决:

- 使用

Build.SUPPORTED_ABIS检查CPU架构 - 通过

PackageManager检测NNAPI支持状态 - 提供CPU回退方案(如TFLite仅用CPU委托)

- 使用

相关问题与解答

Q1:如何提升安卓图像分类的实时性?

- A1:

- 模型优化:选择超轻量模型(如MobileNetV3-NAS),或知识蒸馏压缩模型

- 硬件加速:强制使用GPU/NPU委托,启用多线程并行处理

- 输入优化:降低图像分辨率(如224→112),减少通道数(RGB→灰度)

- 缓存机制:复用输入/输出缓冲区,预加载模型到内存

Q2:如何处理不同安卓设备的模型兼容性?

- A2:

- 动态配置:检测设备API级别(

Build.VERSION.SDK_INT),禁用不支持的功能(如NNAPI<25) - 模型多版本:为不同架构(ARMv7/v8)提供兼容模型文件

- 异常捕获:在

Interpreter初始化时捕获异常,切换至CPU模式:try { Interpreter interpreter = new Interpreter(model, options); } catch (Exception e) { // 回退到基础配置 options.setNumThreads(1); Interpreter fallback = new Interpreter(model, options); }

- 动态配置:检测设备API级别(