虚拟机如何独占物理网卡提升性能?

- 物理机

- 2025-07-02

- 2668

虚拟机分配物理网卡:深入解析直通技术(PCI Passthrough)

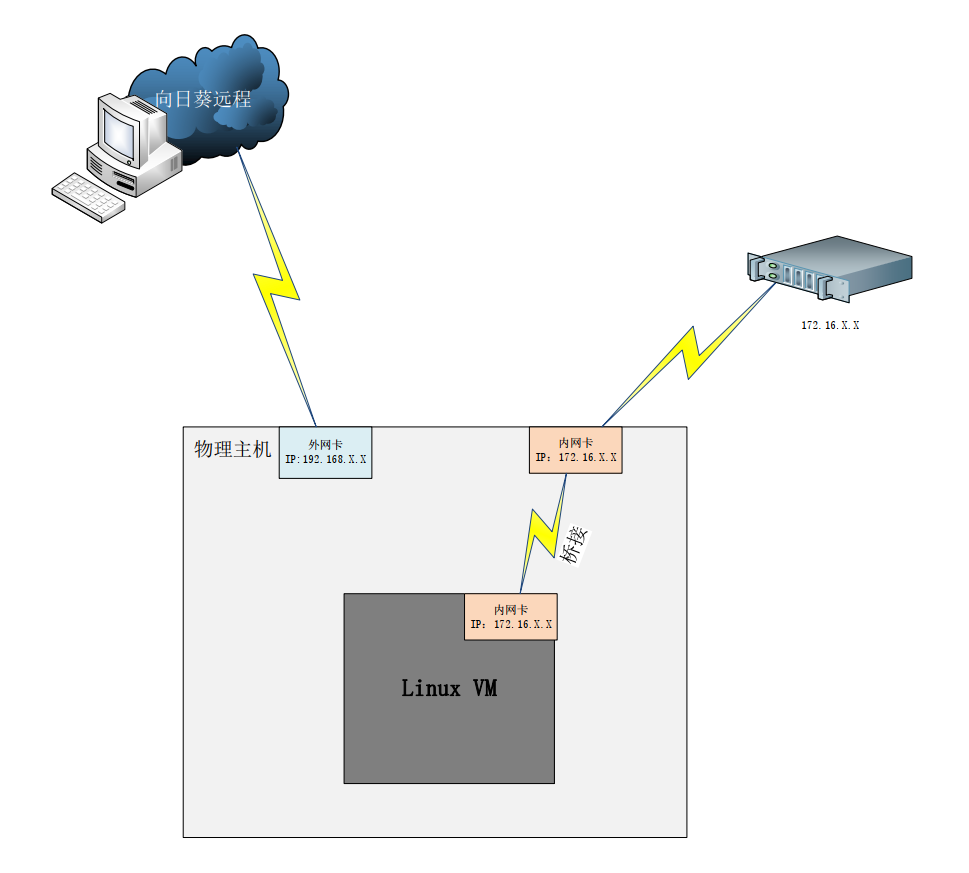

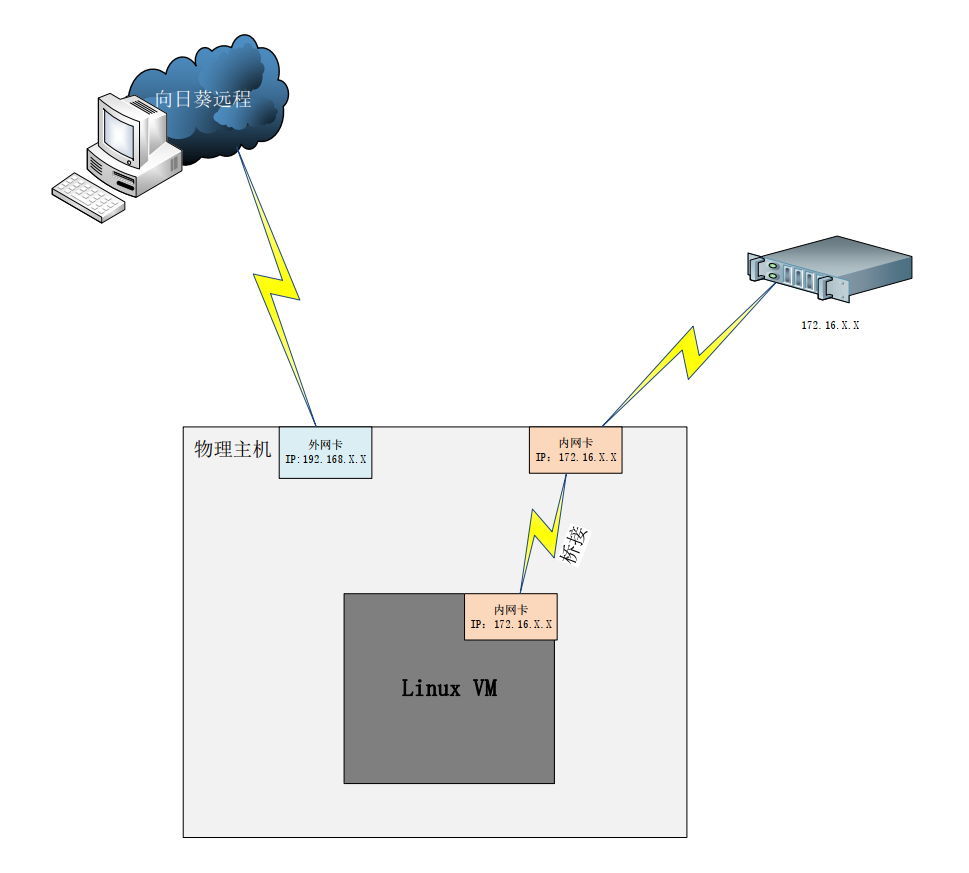

在虚拟化环境中,虚拟机(VM)通常使用由宿主机(Host)虚拟化层提供的虚拟网络接口卡(vNIC)进行网络通信,这种模式在大多数场景下工作良好,提供了灵活性、可管理性和安全性,对于某些特定的高性能、低延迟或需要直接硬件访问的应用场景,将物理网卡直接分配给虚拟机(也称为PCI Passthrough或网卡直通)成为了一个关键的技术选项,本文将深入探讨这一技术的原理、优势、适用场景、实现步骤以及需要注意的关键事项。

为什么需要将物理网卡分配给虚拟机?

虚拟网卡(vNIC)虽然方便,但其性能、功能和访问方式存在一些固有局限:

- 性能瓶颈: 所有通过vNIC的网络流量都需要经过宿主机的虚拟化层(Hypervisor)进行软件模拟或半虚拟化处理,这不可避免地引入了额外的CPU开销和延迟,尤其在高吞吐量(如10Gbps、25Gbps、40Gbps及以上)或对延迟极其敏感(如高频交易、实时音视频处理)的场景下,会成为性能瓶颈。

- 功能限制: 某些物理网卡的高级硬件特性(如特定类型的硬件卸载:TCP/UDP校验和、TSO/LRO/GRO、SR-IOV虚拟化、RDMA/RoCE/iWARP支持、精确时间戳PTP、特定VLAN处理模式等)可能无法完全或高效地通过虚拟化层暴露给虚拟机使用。

- 操作系统/驱动依赖: 虚拟机使用的vNIC依赖于Hypervisor提供的虚拟化驱动,如果虚拟机内的操作系统或应用需要特定物理网卡的原生驱动程序才能发挥最佳性能或支持特殊功能(例如某些专业的网络设备、安全设备或需要特定驱动栈的应用),虚拟网卡就无法满足。

- 隔离性与安全性需求: 在某些高安全要求的环境下,需要确保虚拟机网络流量完全绕过宿主机内核的网络栈,实现物理层面的隔离,减少潜在的攻击面。

物理网卡直通(PCI Passthrough)的工作原理

PCI Passthrough技术的核心思想是:绕过Hypervisor的虚拟化层,将物理PCIe设备(这里是网卡)的控制权直接、独占性地交给指定的虚拟机。

其关键步骤和依赖的技术包括:

- 硬件虚拟化支持 (Intel VT-d / AMD-Vi): 这是实现PCI Passthrough的基础硬件要求,现代服务器CPU(Intel VT-d 或 AMD-Vi/RVI)和主板芯片组必须支持输入输出内存管理单元(IOMMU),IOMMU的主要作用:

- 地址转换: 将虚拟机看到的设备物理地址(GPA – Guest Physical Address)转换为主机真实的物理地址(HPA – Host Physical Address)。

- 设备隔离: 确保直通设备只能访问其被分配到的虚拟机内存,无法访问宿主机或其他虚拟机的内存,这是安全性的基石。

- 中断重映射: 将设备产生的中断直接路由到正确的虚拟机CPU。

- Hypervisor支持: 主流的Hypervisor(如 VMware ESXi, KVM/QEMU (Linux), Microsoft Hyper-V, Xen)都支持PCI Passthrough功能,但具体的配置方法和名称可能略有不同(在VMware中常称为“Passthrough”,在KVM中通过VFIO框架实现)。

- VFIO (Virtual Function I/O) – Linux KVM 核心: 在基于KVM的Linux虚拟化环境中,VFIO是现代、安全、推荐的PCI Passthrough实现框架,它取代了旧的

pci-stub和KVM PCI assignment方法,VFIO提供了强大的用户空间设备驱动模型,确保了更好的安全隔离性和性能。 - 独占性访问: 一旦物理网卡被直通给某个虚拟机:

- 该网卡完全脱离宿主机的控制,宿主机操作系统无法再看到或使用该网卡。

- 目标虚拟机独占使用该物理网卡,就像该网卡是直接插在虚拟机内部一样。

- 虚拟机需要安装该物理网卡的原生驱动程序。

物理网卡直通的主要优势

- 接近物理机的网络性能: 消除了Hypervisor层的软件开销,显著提升吞吐量(带宽),大幅降低网络延迟(Latency)和抖动(Jitter),这对于高性能计算(HPC)、网络功能虚拟化(NFV)、金融交易、实时流媒体处理等至关重要。

- 支持硬件高级特性: 虚拟机可以直接利用物理网卡的所有硬件加速功能(如各种Offload、RDMA、PTP等),充分发挥网卡硬件的潜力。

- 原生驱动支持: 虚拟机使用物理网卡的原厂驱动,兼容性和稳定性更好,尤其对于需要特定驱动支持的应用或设备仿真。

- 增强隔离性: 网络流量直接在物理网卡和虚拟机之间传输,不经过宿主机网络栈,减少了宿主机被攻击或影响虚拟机网络的可能性(但需注意安全配置,见下文)。

- 简化网络配置: 对于需要复杂网络配置(如绑定多个物理口、特定VLAN设置)的虚拟机,直接在虚拟机内部配置物理网卡可能比在Hypervisor层配置虚拟交换机更直观或必要。

典型的应用场景

- 高性能网络应用:

- 高性能计算集群节点间的通信

- 低延迟金融交易系统

- 大规模数据迁移/备份节点

- 高带宽视频流处理/转码服务器

- 网络功能虚拟化 (NFV):

- 虚拟路由器(vRouter)、虚拟防火墙(vFirewall)、虚拟负载均衡器(vLB)

- 需要线速处理或特定硬件加速的网络设备

- 需要RDMA的应用:

基于RoCE (RDMA over Converged Ethernet) 或 iWARP 的高性能存储(如 NVMe over Fabrics)或计算通信

- 特定硬件或驱动依赖:

- 运行需要特定物理网卡及其原生驱动程序的遗留应用或专业软件

- 将虚拟机作为网络设备(如透明防火墙、IDS/IPS)部署,需要直接接入物理网络

- 安全隔离需求: 对网络流量隔离性要求极高的环境。

如何实现物理网卡直通(通用步骤概述)

重要提示: 具体步骤因Hypervisor(ESXi, KVM, Hyper-V等)和操作系统(Linux发行版)而异,以下以广泛使用的KVM/QEMU (Linux) 为例,概述关键步骤:

- 验证硬件支持:

- CPU: 确保CPU支持Intel VT-d 或 AMD-Vi (IOMMU),在Linux中可通过命令查看:

dmesg | grep -e DMAR -e IOMMU(检查内核启动日志)grep -E '(vmx|svm)' /proc/cpuinfo(检查CPU虚拟化支持)

- 主板/BIOS/UEFI: 必须在BIOS/UEFI设置中明确启用 VT-d (Intel) 或 AMD-Vi (IOMF/IOMMU) 功能,这是必须且关键的一步,否则后续无法进行。

- 物理网卡: 确认网卡型号支持直通(大多数现代服务器网卡都支持),对于SR-IOV网卡,可以选择直通整个物理功能(PF)或单个虚拟功能(VF)。

- CPU: 确保CPU支持Intel VT-d 或 AMD-Vi (IOMMU),在Linux中可通过命令查看:

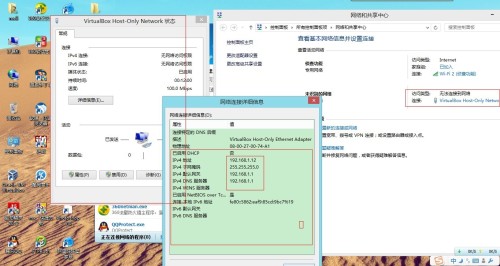

- 启用IOMMU: 在Linux宿主机启动时,需要在内核引导参数中启用IOMMU,编辑

/etc/default/grub文件,在GRUB_CMDLINE_LINUX行添加:- Intel:

intel_iommu=on - AMD:

amd_iommu=on GRUB_CMDLINE_LINUX="... intel_iommu=on iommu=pt ..."iommu=pt(Pass-Through) 选项通常建议添加,它只为用于直通的设备启用IOMMU,减少对不需要直通设备的开销。- 更新grub配置 (

update-grub或grub2-mkconfig -o /boot/grub2/grub.cfg) 并重启宿主机。

- Intel:

- 识别设备ID: 使用

lspci -nn命令找到要直通的物理网卡的PCI地址(如0000:03:00.0)和厂商/设备ID(如[8086:10fb])。 - 解绑设备驱动 (Unbind): 告诉宿主机内核停止使用该网卡,这通常通过将设备ID写入

/sys/bus/pci/devices/<pci_address>/driver/unbind实现。 - 绑定到VFIO驱动 (Bind to VFIO):

- 确保加载了

vfio-pci内核模块 (modprobe vfio-pci)。 - 将设备的厂商和设备ID添加到

vfio-pci的驱动绑定列表中,可以通过/sys/bus/pci/drivers/vfio-pci/new_id接口或更持久地通过/etc/modprobe.d/vfio.conf文件配置(options vfio-pci ids=8086:10fb)。 - 确认设备已被

vfio-pci驱动接管 (lspci -nnk查看对应设备的Kernel driver in use)。

- 确保加载了

- 配置虚拟机XML (Libvirt): 使用

virsh edit <vm_name>编辑虚拟机的XML配置文件,在<devices>部分添加类似下面的设备直通段落:<hostdev mode='subsystem' type='pci' managed='yes'> <source> <address domain='0x0000' bus='0x03' slot='0x00' function='0x0'/> <!-- 替换为你的PCI地址 --> </source> <address type='pci' domain='0x0000' bus='0x00' slot='0x0a' function='0x0'/> <!-- 虚拟机内部PCI地址,通常自动分配 --> </hostdev>managed='yes'表示由libvirt自动处理设备的解绑/重绑定。 - 启动虚拟机并安装驱动: 启动虚拟机,在虚拟机操作系统中,该物理网卡应该作为新的“未知设备”出现,安装该网卡对应的原生驱动程序(从网卡厂商官网获取)。

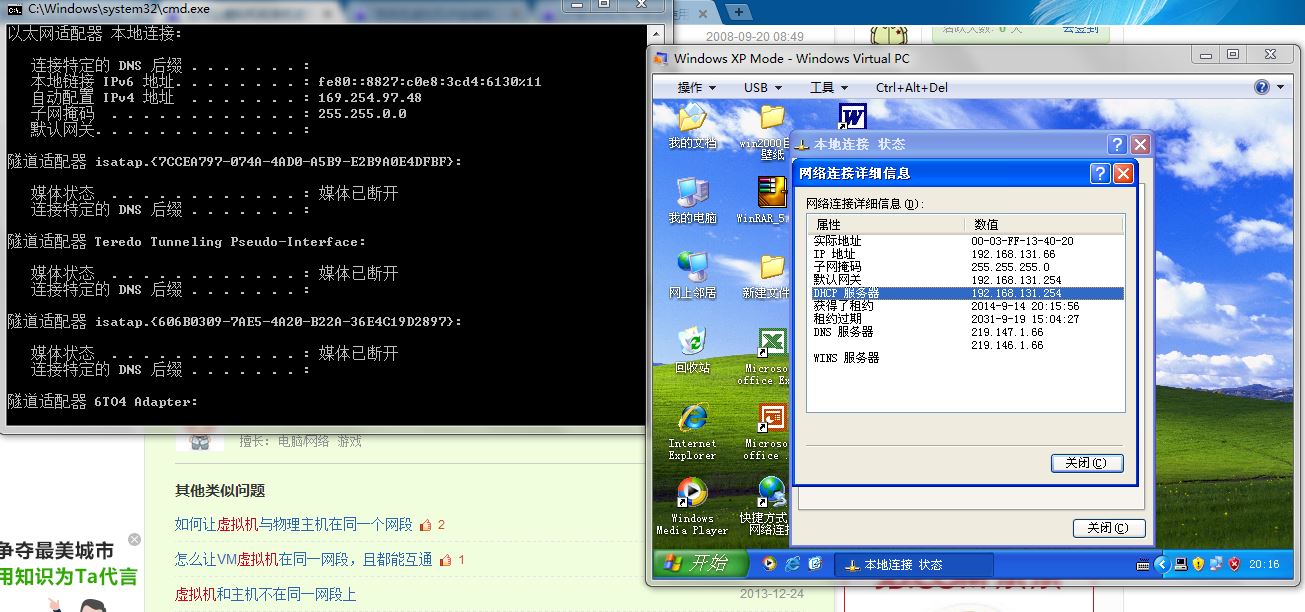

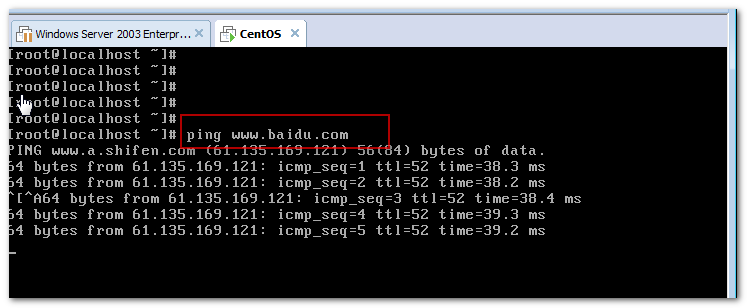

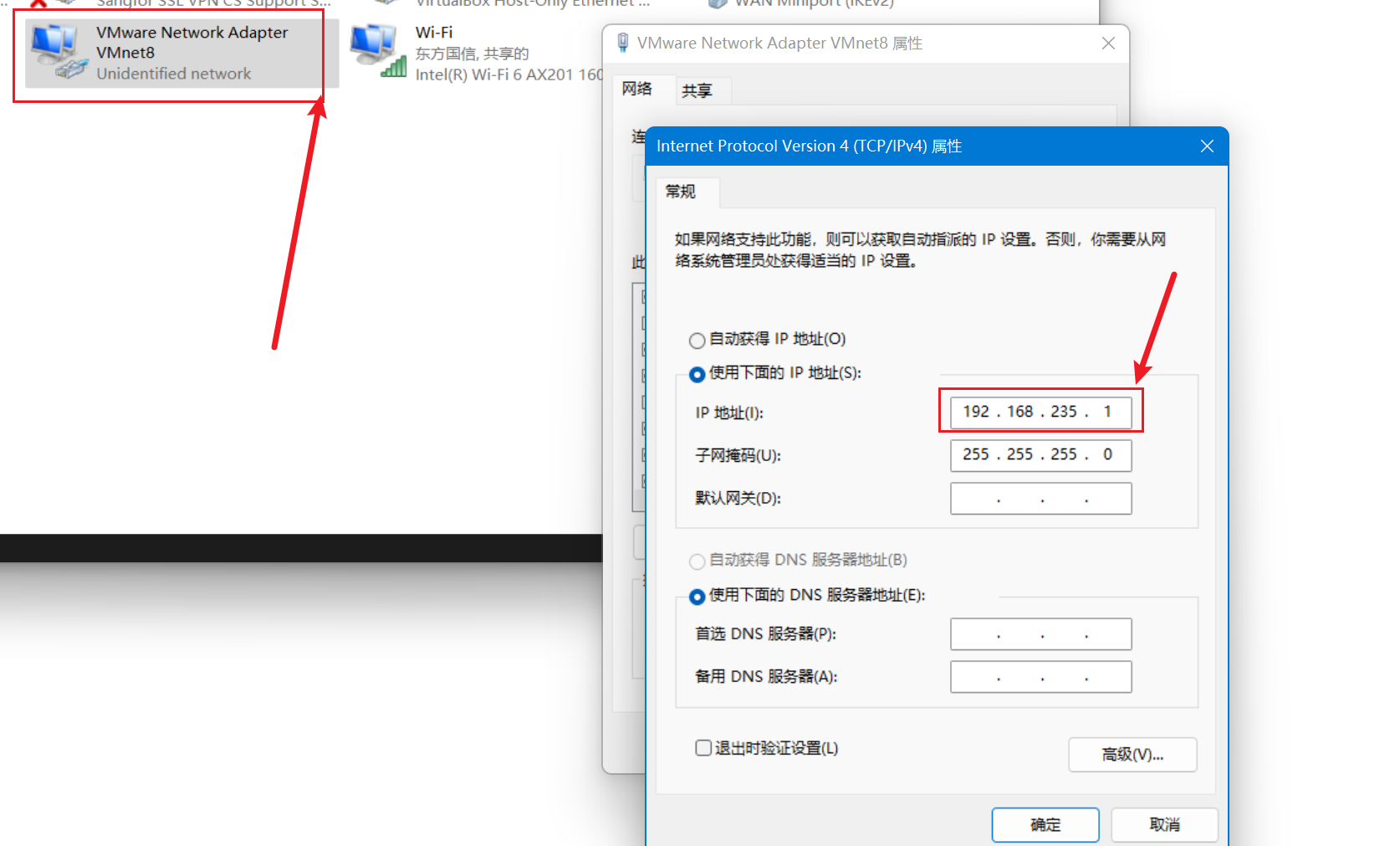

- 配置虚拟机网络: 在虚拟机内部,像配置物理服务器上的网卡一样,配置IP地址、子网掩码、网关、VLAN等网络参数。

关键注意事项与挑战

- 硬件兼容性: 并非所有网卡、主板和CPU组合都能完美支持直通,务必查阅硬件厂商(服务器、主板、网卡)的兼容性列表和支持文档。

- 宿主机无法使用: 被直通的物理网卡在宿主机上完全不可见且不可用,宿主机自身的网络连接需要依赖其他未被直通的网卡。

- 虚拟机迁移 (vMotion/Live Migration) 限制: 这是最大的限制之一。 使用PCI直通设备的虚拟机通常无法进行实时迁移(Live Migration),因为目标宿主机上必须有完全相同的物理设备(相同厂商、型号、固件版本)且处于空闲可直通状态,迁移过程需要断开设备连接,导致业务中断,计划内迁移(关机迁移)不受此限制。

- 依赖特定Hypervisor/硬件: 直通配置与底层Hypervisor和硬件紧密耦合,迁移到不同环境(尤其是不同Hypervisor)可能很困难。

- 安全考虑:

- DMA攻击风险: 理论上,有缺陷或被反面利用的直通设备可能通过DMA访问宿主机或其他虚拟机内存,IOMMU是主要的防护机制,确保其正确配置和启用至关重要。

- 虚拟机逃逸: 如果虚拟机内的反面软件利用了直通设备驱动或固件的破绽,理论上存在虚拟机逃逸(攻击宿主机)的风险,保持驱动和固件最新非常重要。

- 网络隔离: 直通网卡直接暴露在物理网络中,虚拟机内部的网络安全配置(防火墙等)变得极其重要。

- 配置复杂性: 相比使用虚拟网卡,直通的配置过程更复杂,涉及硬件BIOS设置、宿主机内核参数、驱动绑定、虚拟机配置等多个环节,出错点更多。

- 热插拔限制: 在虚拟机运行时,通常无法动态添加或移除直通的PCI设备(虽然部分高级Hypervisor/硬件组合支持有限的热插拔)。

- SR-IOV vs. 全卡直通: 如果物理网卡支持SR-IOV(单根I/O虚拟化),更推荐将虚拟功能(VF) 直通给虚拟机,而不是整个物理功能(PF),VF直通保留了PF在宿主机上的控制权(用于管理SR-IOV),通常支持更多的虚拟机使用同一块物理网卡,并且在某些Hypervisor上可能对迁移(需要特定支持如MDEV)更友好。

将物理网卡直接分配给虚拟机(PCI Passthrough)是一项强大的技术,为需要极致网络性能、低延迟、访问特定硬件功能或实现高级隔离的场景提供了解决方案,它绕过了虚拟化层的开销,让虚拟机能够直接、独占地使用物理网络硬件资源。

这项技术也伴随着显著的代价:硬件兼容性要求高、配置复杂、牺牲了虚拟机实时迁移的灵活性、引入了额外的安全考量点,并且使宿主机失去了对该网卡的使用权,在决定是否采用PCI Passthrough之前,务必仔细权衡其带来的性能/功能收益与引入的复杂性和限制。

对于大多数通用工作负载,使用优化良好的虚拟网卡(如支持SR-IOV的VF、virtio-net with vhost-net/vhost-user)通常是更简单、灵活且性能足够的选择,但当性能或功能需求达到临界点,且能够接受其限制时,物理网卡直通仍然是虚拟化工具箱中不可或缺的利器,在实施前,强烈建议进行充分的测试验证,并确保理解相关的安全配置要求。

引用说明:

- 本文核心概念和技术原理基于对行业标准虚拟化技术(KVM, VMware ESXi, Hyper-V, Xen)和硬件虚拟化规范(Intel VT-d, AMD-Vi)的理解。

- 关于VFIO框架的实现细节,参考了Linux内核官方文档 (

Documentation/driver-api/vfio.rst) 及相关社区资料。 - 硬件兼容性和具体配置步骤的细节,通常需要查阅特定服务器硬件厂商(如Dell, HPE, Lenovo)、网卡厂商(如Intel, Mellanox/NVIDIA, Broadcom)以及所使用Hypervisor(如Red Hat Virtualization, VMware, Microsoft)的官方产品文档和支持知识库。

- 安全风险分析参考了常见的虚拟化安全最佳实践和关于DMA攻击、虚拟机逃逸的研究文献。