上一篇

Hadoop必须用物理服务器?

- 物理机

- 2025-06-10

- 4694

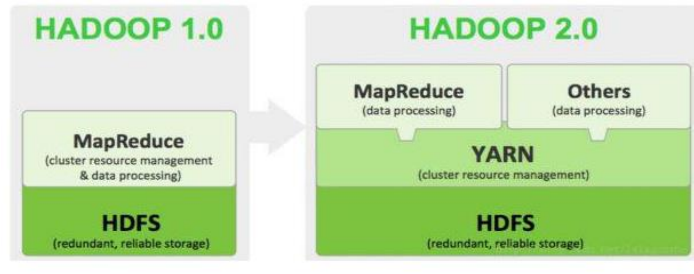

Hadoop搭建不必须使用物理机,它可以在物理服务器集群上部署,也能在虚拟机环境或云平台(如AWS, Azure, GCP)上运行,虚拟化和云方案提供了灵活性和资源弹性,是常见且可行的选择。

Hadoop搭建必须要用物理机吗?

答案很明确:不是必须的。 Hadoop 完全可以在虚拟机、容器(如 Docker/Kubernetes)以及公有云/私有云平台上成功部署和运行,物理机只是众多部署选项中的一种,选择哪种方案取决于您的具体需求、预算、技术栈和运维能力。

为什么有人会认为需要物理机?

早期 Hadoop 设计和文档确实倾向于物理机部署,主要基于以下几点考虑:

- 性能: 物理机直接访问 CPU、内存、磁盘和网络硬件,避免了虚拟化层(Hypervisor)或容器引擎带来的额外开销,对于早期 Hadoop 版本和需要极致 I/O 吞吐量(尤其是 HDFS 写密集型负载)的场景,物理机的原生性能优势更明显。

- 资源隔离与稳定性: 物理机提供绝对的资源隔离(CPU、内存、磁盘 I/O、网络带宽),在虚拟化环境中,如果管理不当,一个虚拟机的资源争抢(如“邻居噪音”)可能影响运行 Hadoop 的虚拟机性能甚至导致不稳定。

- 磁盘 I/O: Hadoop(特别是 HDFS 和 MapReduce/Spark)是磁盘 I/O 密集型框架,物理机通常能配置多块本地磁盘(JBOD),HDFS 可以充分利用这些磁盘进行并行读写,获得最佳 I/O 性能,虚拟机的共享存储或虚拟磁盘有时可能成为瓶颈。

- 网络: 物理机节点间通常通过高速物理网络(如万兆以太网)直连,网络延迟低、带宽高且稳定,虚拟化网络或云网络可能引入额外的延迟和不确定性。

非物理机方案的可行性、优势与挑战

-

虚拟机 (Virtual Machines – VMs)

- 可行性: 非常成熟且广泛使用的方案,主流虚拟化平台(VMware vSphere, KVM, Microsoft Hyper-V)都支持部署 Hadoop 集群。

- 优势:

- 资源利用率高: 在物理服务器上整合多个 Hadoop 节点 VM,显著提高硬件资源利用率,降低总体成本(TCO)。

- 灵活性: 快速创建、克隆、迁移、扩展(Scale-Up/Out)或收缩节点,简化资源管理和分配。

- 隔离性: 虽然不如物理机绝对,但现代虚拟化技术提供了良好的资源隔离(CPU、内存、网络带宽、磁盘 I/O),配合合理的资源池配置和管理,可以满足大部分 Hadoop 工作负载的需求。

- 高可用与容灾: 轻松利用虚拟化平台的高级特性(如 vMotion/Live Migration, HA, FT)实现 Hadoop 节点的高可用和快速恢复,甚至跨数据中心容灾。

- 运维便捷: 统一的虚拟化平台管理界面简化了服务器生命周期管理(打补丁、升级、监控)。

- 挑战与注意事项:

- 性能开销: 虚拟化层会引入一定的 CPU、内存、I/O 开销,需选择高性能虚拟化平台并优化配置(如使用半虚拟化驱动、透传磁盘控制器/NVMe)。

- I/O 优化: 为 DataNode 配置直通磁盘 (Passthrough/RDM/DirectPath) 或高性能虚拟磁盘(如基于 SSD 的存储、精简置备优化)至关重要,避免使用慢速的共享存储(如传统 NAS)存放 HDFS 数据。

- 网络优化: 使用 SR-IOV 或 vSphere DirectPath I/O 等技术降低网络虚拟化开销,确保 VM 间网络带宽和低延迟,合理配置网络资源池。

- 资源配置: 为 Hadoop VM(特别是 DataNode)分配足够的 vCPU、内存,并预留资源(Reservations)以避免争抢,避免 CPU 超售过度。

-

容器 (Containers – Docker/Kubernetes)

- 可行性: Apache Hadoop 社区和各大云厂商都在积极拥抱容器化,Hadoop 组件(HDFS, YARN)可以容器化运行在 Kubernetes 上,项目如 Apache Hadoop Ozone(对象存储)原生支持 K8s,Spark on K8s 已非常成熟。

- 优势:

- 极致轻量与高效: 容器共享主机 OS 内核,启动更快,资源开销(磁盘、内存)远低于 VM。

- 更高密度与弹性: 在相同物理资源上可运行更多容器实例,实现更细粒度的资源调度和更快速的弹性伸缩(秒级)。

- 标准化与可移植性: 容器镜像封装了应用及其依赖,确保环境一致性,简化部署流程,易于在开发、测试、生产环境及不同云平台间迁移。

- 现代化编排: Kubernetes 提供强大的自动化部署、扩缩容、服务发现、负载均衡、自愈能力。

- 挑战与注意事项:

- 存储挑战: 容器短暂生命周期与 HDFS 持久化需求存在矛盾,需要结合持久卷 (Persistent Volumes – PV) 和持久卷声明 (Persistent Volume Claims – PVC),并确保 PV 能提供高性能、低延迟的本地存储或网络存储(如 CSI Driver 对接本地盘、高性能云盘)。StatefulSets 用于管理有状态应用(如 DataNode)。

- 网络挑战: 需要高性能容器网络接口(CNI)插件(如 Calico, Cilium)支持高吞吐量和低延迟的 Pod 间通信,网络策略配置可能更复杂。

- 安全隔离: 容器间共享内核,其隔离性弱于 VM,需要强化安全配置(如 Seccomp, AppArmor/SELinux, 非 root 运行)。

- 成熟度与复杂性: Hadoop 核心组件(特别是 HDFS NameNode/YARN ResourceManager 的高可用部署)在纯 K8s 上的成熟度和易用性仍在发展中,相比 VM 方案配置更复杂,需要深厚的 K8s 运维能力。云托管 Hadoop 服务或混合方案(核心组件在 VM,计算任务在容器)是目前更常见的落地方式。

-

公有云/私有云平台

- 可行性: 主流云平台(AWS, Azure, GCP, 阿里云, 酷盾等)都提供成熟的 Hadoop 托管服务(如 Amazon EMR, Azure HDInsight, Google Dataproc, 阿里云 E-MapReduce)以及支持在其 IaaS 虚拟机或容器服务上自建 Hadoop。

- 优势:

- 零基础设施管理: 托管服务完全负责底层服务器、存储、网络、Hadoop 集群的部署、配置、监控、扩缩容、打补丁和高可用,用户只需关注应用和数据。

- 极致弹性: 按需快速创建集群,用完即销毁,按实际使用量付费(计算+存储+网络),轻松应对业务峰值。

- 丰富的生态集成: 天然集成云平台的其他服务(对象存储、数据库、流处理、AI/ML 服务、监控日志等)。

- 成本模型灵活: 托管服务通常提供多种实例类型(计算/内存/存储优化)和竞价实例(Spot Instances)以优化成本,IaaS 自建也只需为运行中的资源付费。

- 高可用与全球部署: 云平台天然具备跨可用区(AZ)甚至跨区域的容灾能力。

- 挑战与注意事项:

- 成本控制: 长期运行大型集群成本可能很高,需要精细的成本监控和优化策略(如自动启停集群、合理选择实例类型和存储、利用预留实例/节省计划、清理不必要资源)。

- 数据存储位置与传输成本: 需关注数据存储位置(Region/AZ)带来的合规要求,以及跨 AZ/Region 的数据传输费用。

- 网络延迟: 云网络延迟通常高于本地物理网络(尤其是跨 AZ/Region),可能影响某些对延迟敏感的应用。

- 供应商锁定风险: 深度使用云厂商特有服务或 API 会增加迁移到其他云或回迁本地的难度。

- 自建 IaaS 的挑战: 在云 IaaS 上自建 Hadoop 仍需面对前述 VM 或容器方案的挑战(性能、存储、网络优化),同时还需自行管理集群软件栈。

部署方案对比概览

| 特性 | 物理机 (Bare Metal) | 虚拟机 (Virtual Machines) | 容器 (Containers/K8s) | 云托管服务 (Managed Service) |

|---|---|---|---|---|

| 核心优势 | 极致性能 (CPU/内存/磁盘I/O/网络),强隔离 | 高资源利用率,灵活性,高可用/容灾,易管理 | 极致轻量,超高密度,快速弹性,标准化,可移植 | 零运维,极致弹性,开箱即用,集成生态 |

| 主要劣势 | 成本高,资源利用率低,扩展慢,运维复杂 | 有虚拟化开销,需精细优化存储/I/O/网络 | 存储/网络配置复杂,安全隔离弱,Hadoop核心组件成熟度 | 长期运行成本可能高,供应商锁定风险,网络延迟 |

| 适用场景 | 超高性能需求,极致低延迟,强合规隔离 | 平衡性能与灵活性,利用现有虚拟化平台 | 敏捷开发,云原生环境,Spark等计算框架 | 快速启动,弹性需求强,降低运维负担,利用云生态 |

| 存储关键 | 本地直连磁盘 (JBOD) | 直通磁盘或高性能虚拟磁盘 (SSD) | 持久卷 (PV/PVC) + 高性能存储 (CSI) | 托管存储或集成对象存储 (S3, ADLS, GCS) |

| 网络关键 | 高速物理网络 (万兆+) | SR-IOV / DirectPath I/O,网络资源池优化 | 高性能 CNI 插件 (Calico, Cilium) | 云VPC/子网配置,考虑跨AZ/Region延迟成本 |

| 运维复杂度 | 非常高 | 中高 | 非常高 (尤其K8s) | 非常低 |

如何选择?关键考虑因素

- 性能需求: 您的应用对 CPU 计算、内存带宽、磁盘 I/O 吞吐量、网络延迟的要求有多高?是否达到物理机是唯一选择的程度?

- 预算: 初始硬件投入成本、电力冷却机房成本、长期运维人力成本 vs. 云服务的按需付费/订阅成本,哪种 TCO 模型更适合您?

- 工作负载特性: 是长期运行的稳定集群,还是短期、突发的分析任务?是否需要频繁扩缩容?

- 敏捷性与弹性: 对快速部署、环境一致性、按需扩展能力的需求有多高?

- 现有技术栈与技能: 您是否已有成熟的虚拟化平台(如 VMware)或 Kubernetes 环境?团队是否具备相应的运维技能?

- 高可用与容灾要求: 需要达到什么级别的 RTO/RPO?不同方案实现高可用和容灾的复杂度和成本差异很大。

- 数据安全与合规: 是否有严格的数据驻留、隔离或合规要求?

- 云战略: 您是否有上云计划或已经是云优先策略?

Hadoop 的部署早已超越了物理机的单一模式。物理机并非必须,而是一种选择。 虚拟机方案在性能、成本和灵活性之间取得了良好的平衡,是目前企业本地部署的主流选择,容器化(尤其是 Kubernetes)代表了云原生时代的发展方向,特别适合计算框架(如 Spark)和敏捷场景,但存储密集型组件(HDFS)的成熟部署仍需努力,云托管服务则提供了无与伦比的便捷性和弹性,是快速启动、降低运维负担和利用云生态的绝佳选择。

最终决策应基于对自身业务需求、技术能力、成本模型和未来发展规划的综合评估。 混合部署(核心 HDFS 在物理机或优化过的 VM 上,YARN 计算任务提交到云或 K8s 集群)也是一种值得考虑的务实策略,评估性能、成本、敏捷性、运维复杂度的权衡点,选择最适合您当前和未来一段时间需求的方案。

引用说明:

- 本文观点综合参考了 Apache Hadoop 官方文档关于硬件推荐的讨论(强调磁盘和网络性能的重要性)。

- 虚拟机部署最佳实践参考了 VMware、Red Hat (KVM) 等主流虚拟化平台供应商发布的 Hadoop 优化白皮书和知识库文章。

- 容器化部署参考了 Kubernetes 官方文档关于 StatefulSets、持久化存储的阐述,以及社区在运行大数据工作负载(如 Spark on K8s)的经验分享。

- 云托管方案信息来源于 AWS EMR、Azure HDInsight、Google Dataproc 等服务的官方产品文档和架构概述。