如何选择英伟达服务器显卡才能最大化提升计算性能?

- 云服务器

- 2025-05-29

- 3814

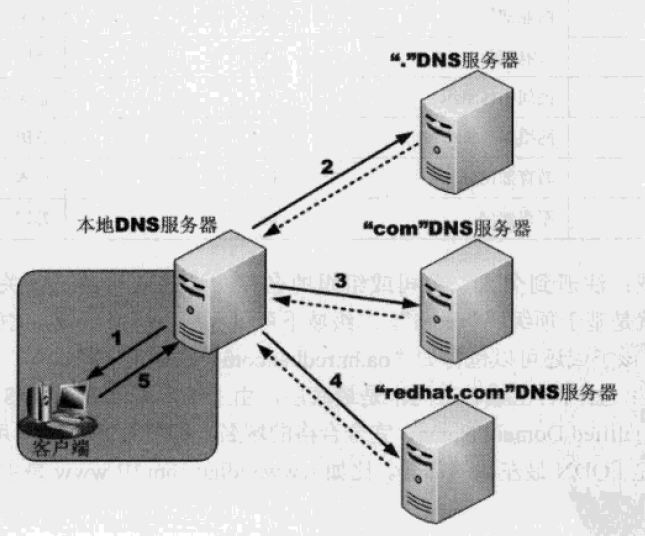

英伟达服务器显卡专为高性能计算与AI加速设计,采用Ampere/Hopper架构,搭载Tensor Core和CUDA核心,支持大规模并行运算,适用于深度学习训练、科学模拟及数据中心负载,具备高吞吐量、低延迟特性,通过NVLink实现多卡互联,优化分布式计算效率,满足企业级AI模型部署与实时推理需求。

在数字经济的浪潮下,算力已成为驱动科技创新与产业升级的核心引擎,作为全球GPU技术引领者,英伟达(NVIDIA)推出的服务器专用显卡凭借革命性架构设计与全栈优化能力,正重塑数据中心、人工智能与科学计算领域的技术边界,本文将深入解构英伟达服务器级GPU的技术特性、应用场景与选型指南,为行业用户提供专业参考。

技术架构:从底层硬件到软件生态的全方位突破

英伟达服务器显卡采用模块化设计理念,通过三大核心技术维度构建竞争优势:

-

并行计算架构迭代

- Ampere架构(A100/A40):集成第三代Tensor Core与FP64双精度单元,支持稀疏计算加速,单卡提供312 TFLOPS的AI算力

- Hopper架构(H100):引入Transformer Engine与DPX指令集,大语言模型训练速度较前代提升30倍

- 显存子系统升级至HBM2e/HBM3,A100 80GB版本带宽突破2TB/s,可承载千亿参数模型

-

能效比革命

通过TSMC 4N制程与动态频率调节技术,H100在同等性能下功耗较V100降低42%,每瓦性能比达到3.6 TFLOPS/W -

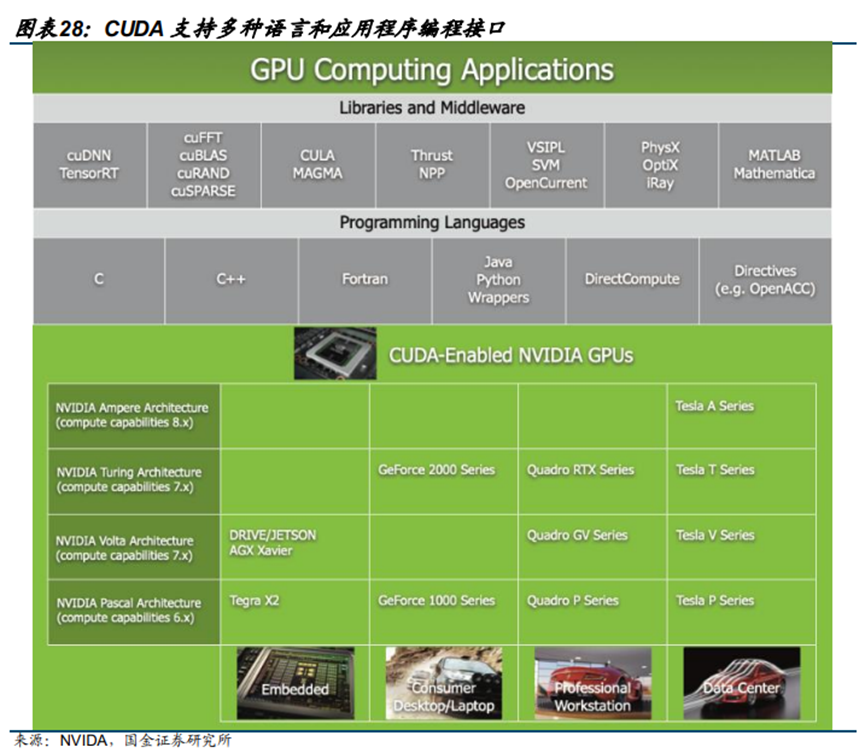

全栈软件生态

- CUDA 12.0开发平台:新增异步执行与多进程服务功能

- NGC容器仓库:提供预训练模型与行业解决方案

- DOCA 2.0数据平面架构:实现200Gbps网络零拷贝数据传输

行业应用:驱动八大核心场景智能化转型

| 应用领域 | 典型场景 | 推荐产品 | 性能指标 |

|---|---|---|---|

| AI训练 | 千亿参数大模型分布式训练 | H100 SXM5 集群 | 4 exaflops FP8计算能力 |

| 推理服务 | 实时视频分析/推荐系统 | L40S/T4 | 130 TOPS INT8推理吞吐 |

| 科学计算 | 分子动力学模拟/气候建模 | A100 PCIe | 5 TFLOPS FP64性能 |

| 元宇宙渲染 | 数字孪生/实时3D引擎 | RTX 6000 Ada | 142 RT-TFLOPs光线追踪 |

| 边缘计算 | 自动驾驶决策系统 | Orin AGX | 275 TOPS端到端时延<50ms |

| 云计算 | 弹性GPU虚拟化服务 | A16/A2 | 支持128路vGPU实例切分 |

| 医疗影像 | 病理切片AI辅助诊断 | RTX A6000 | 84 TFLOPS单精度性能 |

| 金融科技 | 高频交易风险建模 | H100 NVL | 2TB HBM3显存池化 |

选型决策树:四维度精准匹配需求

- 算力需求评估

- 训练场景:优先选择Tensor Core数量与显存带宽

- 推理场景:关注INT8/FP16计算密度与能效比

- 部署环境适配

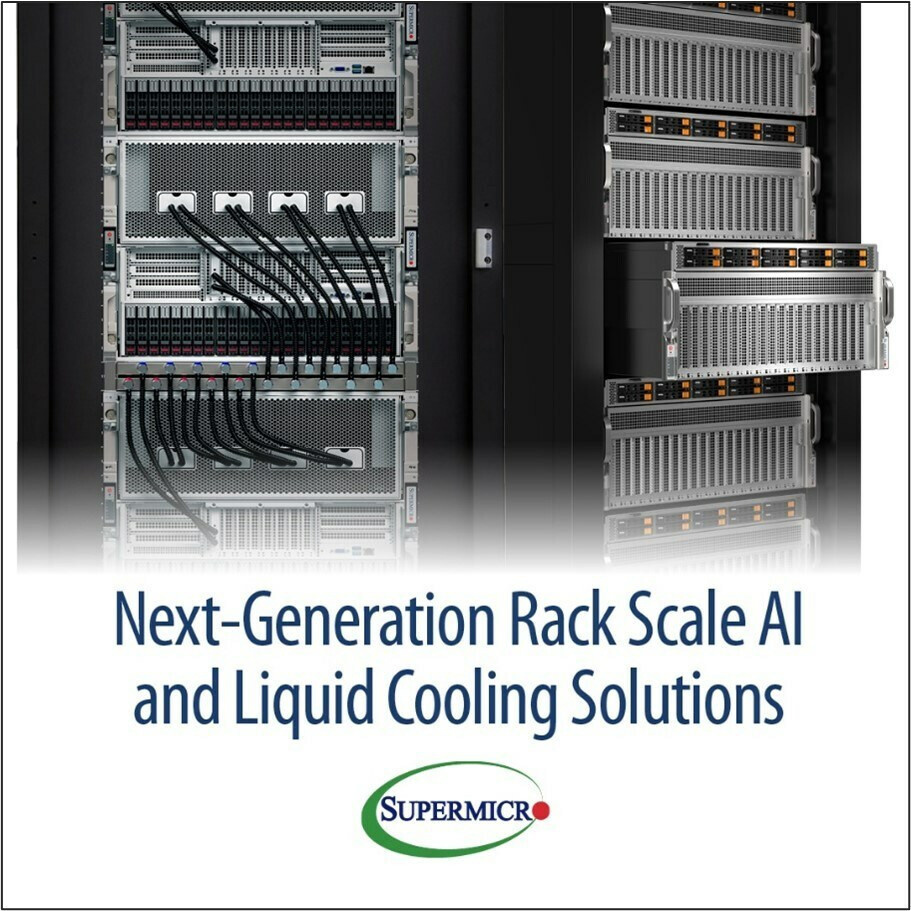

- 数据中心:SXM形态卡提供更高密度(如HGX H100)

- 边缘节点:PCIe版卡支持更灵活扩展

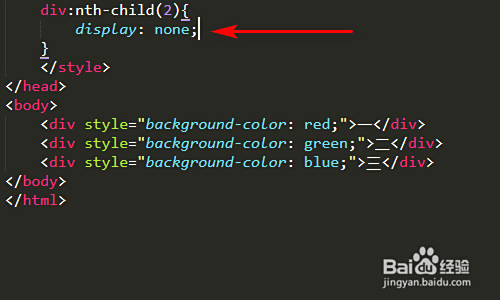

- 软件兼容性验证

- 检查CUDA版本与框架支持(PyTorch/TensorFlow)

- 确认NGC镜像对特定行业工具链的适配

- TCO成本优化

- 采用MIG技术实现单卡7实例切分

- 结合vGPU授权策略降低单位成本

运维实践:保障99.99%可用性的关键策略

- 硬件监控体系

部署DCGM 3.0工具链,实时监测GPU利用率/温度/ECC错误率,支持预测性维护 - 能效管理方案

应用NVML动态调频技术,在负载低谷期自动降低30%功耗 - 容灾架构设计

通过NVIDIA Magnum IO实现跨节点内存共享,构建故障域隔离机制

技术演进:三大未来趋势预判

- 架构革新

2025年将推出的Blackwell架构将集成光子互联模块,突破现有PCIe总线瓶颈 - 存算一体

HBM4显存与计算单元3D堆叠,显存带宽有望突破5TB/s - 量子混合计算

CUDA Quantum平台将实现GPU与量子处理器的协同加速

常见问题深度解析

Q:服务器显卡与消费级产品的本质差异?

A:专业级产品具备ECC显存纠错、FP64双精度单元、7×24小时持续负载设计,并通过NVIDIA认证程序(NGC)确保软件栈稳定性。

Q:如何构建弹性计算集群?

A:采用NVSwitch 3.0互联技术,单机柜可扩展至256颗H100 GPU,配合NVIDIA AI Enterprise软件套件实现资源动态调度。

Q:国产化替代进程中的注意事项?

A:需重点验证CUDA生态兼容性,建议采用容器化方案隔离硬件差异层,并通过NVIDIA Fleet Command进行混合架构管理。

引用说明

[1] NVIDIA A100 Tensor Core GPU架构白皮书,2020

[2] TOP500超算榜单性能分析报告,2025年6月

[3] IDC《全球人工智能基础架构跟踪报告》2025Q2

[4] MLPerf推理测试基准v3.0官方数据

[5] 英伟达开发者博客技术文章(developer.nvidia.com)