分布式数据库搭建

- 行业动态

- 2025-05-09

- 2

分片策略确定数据分布,节点间通信保障一致性,负载均衡与容错机制确保高可用,最终实现分布式数据库的高效搭建

分布式数据库搭建详解

分布式数据库核心概念

分布式数据库通过将数据分散存储在多个物理节点上,结合网络通信与协同管理技术,实现数据的高效存储与访问,其核心目标在于解决传统单机数据库的性能瓶颈、容量限制及单点故障问题。

关键特性对比表:

| 特性 | 传统数据库 | 分布式数据库 |

|—————|————————–|—————————-|

| 数据存储 | 单一节点集中存储 | 多节点分片存储 |

| 扩展性 | 纵向扩展(硬件升级) | 横向扩展(增加节点) |

| 高可用性 | 依赖主备机切换 | 自动故障转移与数据冗余 |

| 性能瓶颈 | 受单机硬件资源限制 | 可线性扩展读写能力 |

| 数据一致性 | 强一致性(ACID) | 最终一致性(BASE理论) |

架构设计要素

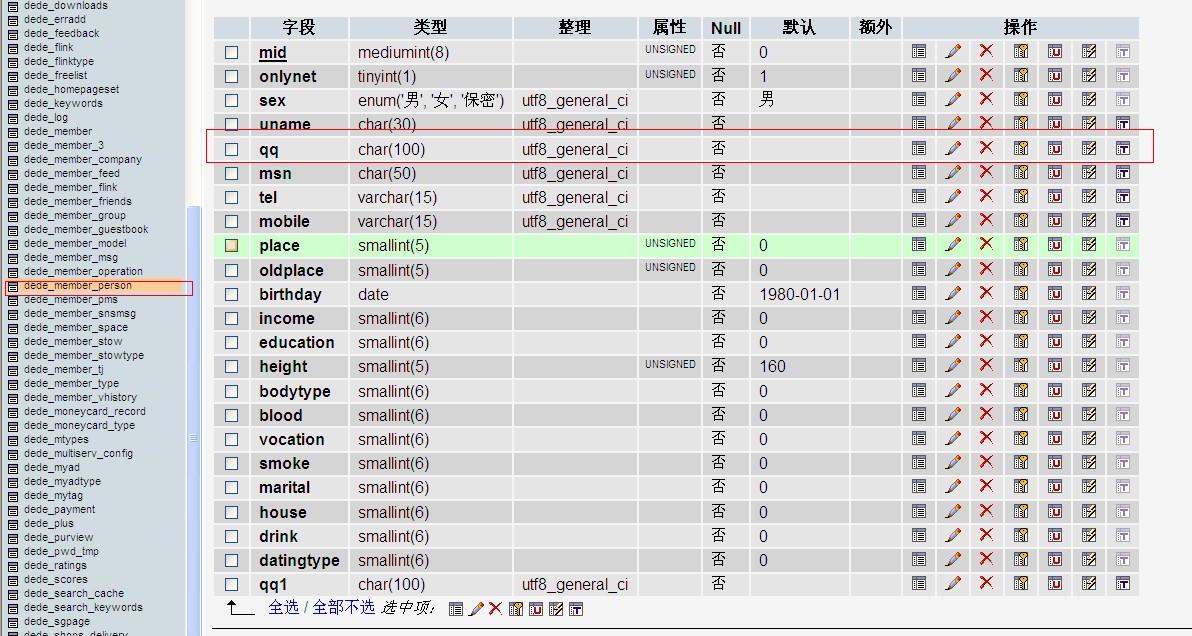

数据分片(Sharding)

- 水平分片:按行拆分数据,如按用户ID取模分配

- 垂直分片:按列拆分数据,如订单库与商品库分离

- 混合分片:先垂直分片后水平分片

数据复制(Replication)

- 主从复制:异步/半同步模式

- 多主复制:支持双向写入(需解决冲突)

- Paxos/Raft协议:实现分布式一致性

元数据管理

- 维护全局数据路由表

- 记录分片位置与副本状态

- 典型实现:ZooKeeper集群、etcd服务

事务处理机制

- 两阶段提交(2PC):强一致性但性能损耗大

- TCC(Try-Confirm-Cancel)模型

- 基于时间戳的乐观并发控制

技术选型指南

| 维度 | 关系型(如CockroachDB) | 非关系型(如Cassandra) | NewSQL(如TiDB) |

|---|---|---|---|

| 数据模型 | 严格Schema | 灵活Schema | 兼容SQL |

| 扩展方式 | 自动分片 | 手动配置分片规则 | 自动/手动混合 |

| ACID支持 | 完整支持 | 仅支持单行事务 | 完整支持 |

| 场景适配 | 金融交易 | 互联网日志分析 | 混合业务场景 |

| 学习成本 | 高(类似传统DB) | 中(NoSQL经验) | 低(SQL兼容) |

部署实施步骤

环境准备

- 硬件:至少3个数据中心,每个中心部署奇数个节点(建议5+)

- 网络:万兆光纤互联,跨机房延迟<50ms

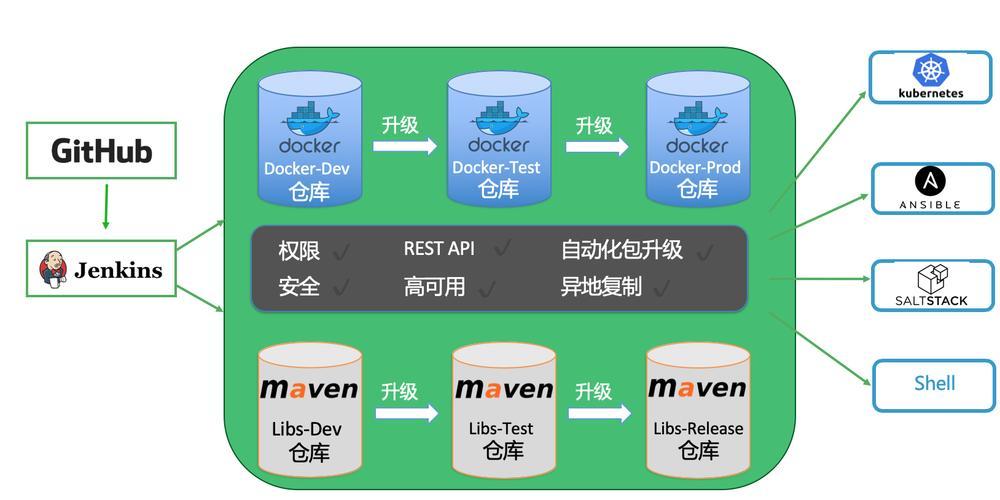

- 系统:CentOS/Ubuntu+Docker/K8s容器化

集群初始化

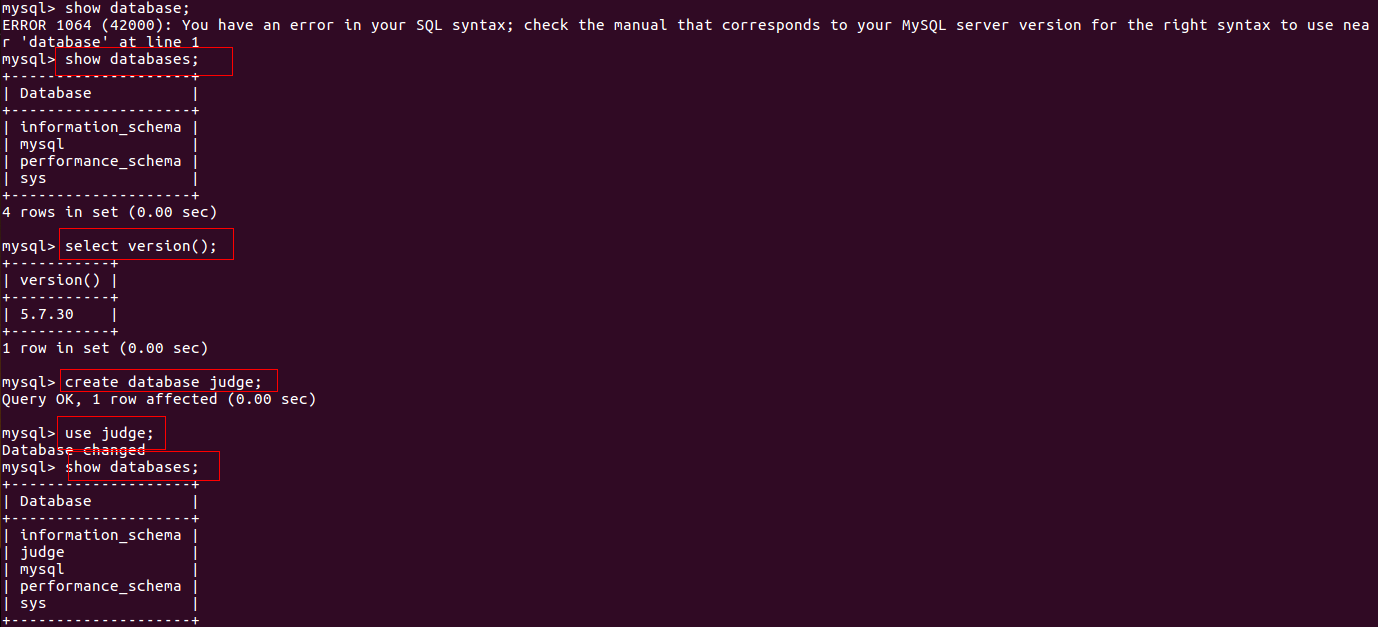

# 以TiDB为例的部署命令 ansible-playbook -i inventory/hosts deployment.yml -e "pd_nodes=3,tidb_nodes=5,tikv_nodes=5,tiflash_nodes=2"

数据迁移策略

- 在线迁移:使用DSC(Data Subscription and Change)工具

- 分阶段迁移:先读后写,逐步切换流量

- 数据校验:CRC64校验+业务层对账

监控体系搭建

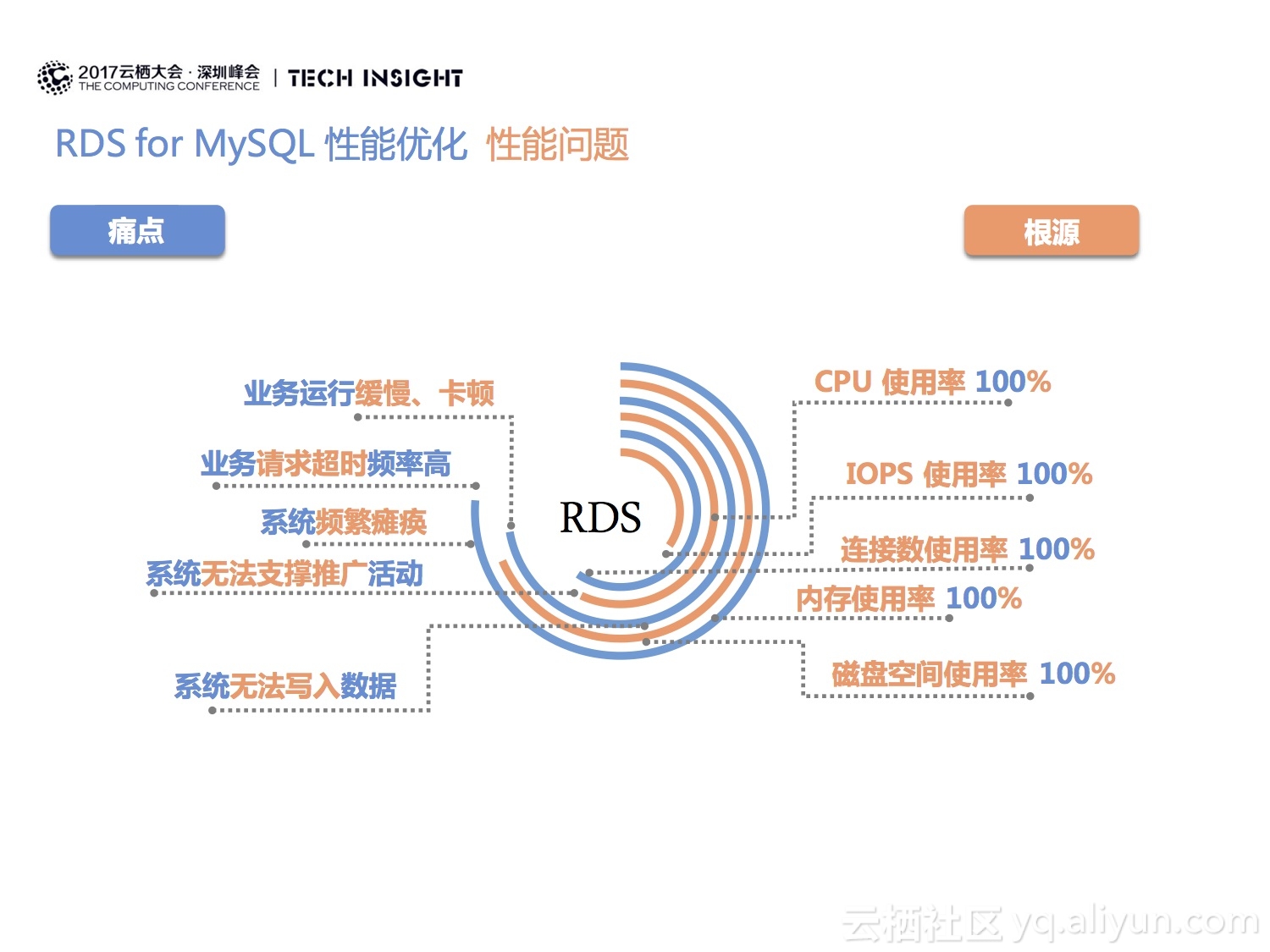

- 基础监控:Prometheus+Grafana(采集CPU/MEM/DISK/NET)

- 数据库监控:自定义Exporter(采集QPS/TPS/慢查询)

- 链路追踪:Jaeger+OpenTracing(跟踪跨节点请求)

性能优化策略

查询优化

- 建立全局二级索引(GSI)

- 使用本地执行计划(Colocated Query)

- 热点数据预加载到内存引擎(如Redis)

存储优化

- LSM-Tree结构写入优化

- 列式存储压缩(如Parquet格式)

- SSD+HDD混合存储(热温冷数据分层)

网络优化

- RDMA技术降低延迟

- 数据局部性原则(计算节点靠近存储节点)

- 压缩算法选择(Zstandard vs LZ4)

典型故障处理

脑裂问题

- 现象:双主节点同时提供服务

- 解决方案:引入仲裁节点(Quorum机制),设置合理的心跳超时时间(通常为RTT的3倍)

数据倾斜

- 检测方法:统计各分片容量标准差

- 处理流程:

- 启用动态分片平衡功能

- 调整哈希算法(如MurmurHash替代MD5)

- 重新分配热点数据(真空填充法)

成本分析模型

| 成本项 | 传统方案(百万级) | 分布式方案(十万级) |

|---|---|---|

| 硬件成本 | ¥800万/年 | ¥200万/年 |

| 运维人力 | 10人团队 | 3人自动化运维 |

| 扩展周期 | 6个月 | 1小时(弹性扩容) |

| 可用性 | 9% | 99% |

| TCO(5年) | ¥4000万 | ¥1000万 |

安全合规实践

数据加密

- 传输层:TLS1.3+国密SM4

- 存储层:AES-256全盘加密

- 应用层:字段级加密(如身份证号掩码)

审计合规

- GDPR/CCPA数据主权要求

- 三级等保审计支持

- 数据血缘追踪(Lineage Tracking)

典型案例分析

电商大促场景:

- 峰值压力:每秒50万订单写入

- 架构方案:

- 分片策略:用户ID^订单类型联合分片

- 缓存层:Redis集群承载热点商品库存

- 异步处理:Kafka削峰填谷订单日志

- 效果:99.99%响应成功率,资损率<0.0001%

FAQs

Q1:分布式数据库是否需要停服才能扩容?

A1:现代分布式数据库普遍支持在线扩容,以TiDB为例,新增节点时会自动进行数据再平衡,业务无需中断,但需注意:大规模扩容(超过30%节点)时建议分批次操作,避免触发全局元数据更新风暴。

Q2:如何验证分布式事务的一致性?

A2:可通过以下方法验证:

- 使用事务冲突测试工具(如sysbench)模拟ABA问题

- 检查事务隔离级别是否达到可重复读(RR)或串行化(SERIALIZABLE)

- 在分片边界执行跨节点更新,验证全局提交协议有效性

- 查看事务日志中的prepare/commit标记是否