上一篇

hive数据仓库技巧

- 行业动态

- 2025-05-07

- 2

Hive数据仓库优化技巧:合理分区减少扫描,使用索引加速查询,调整执行参数提升并行度,采用ORC

Hive数据仓库技巧详解

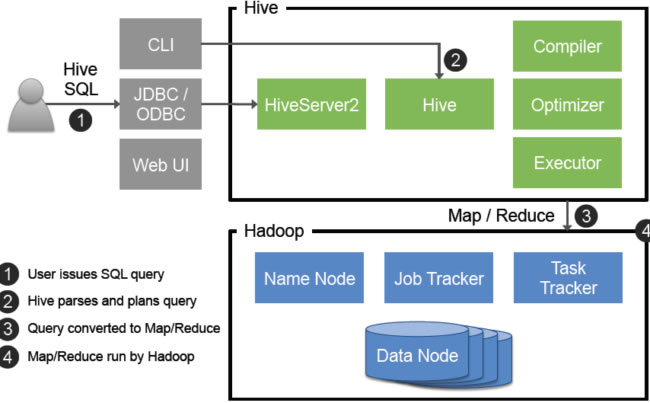

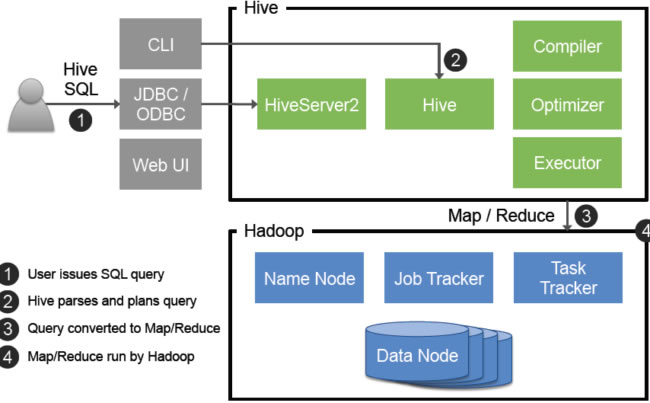

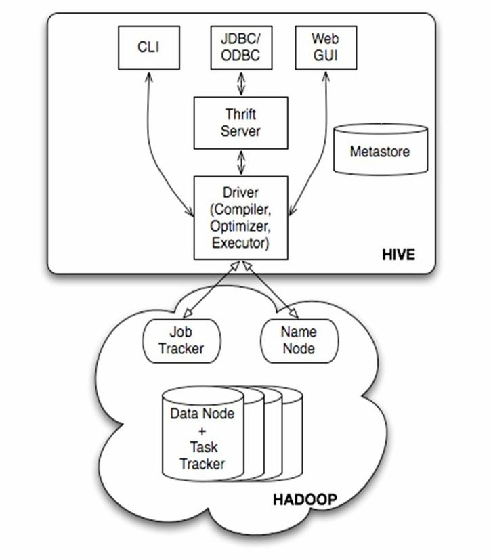

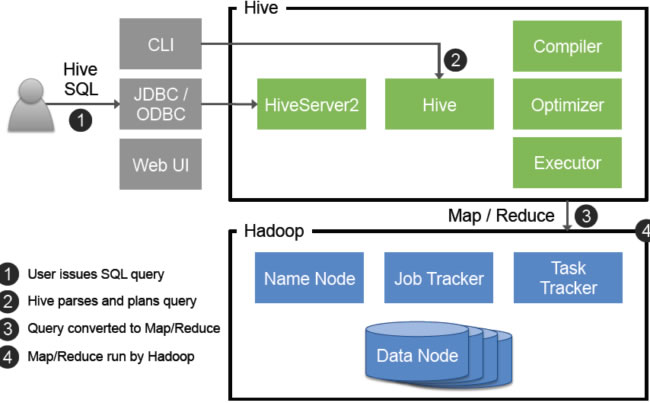

Hive作为大数据领域常用的数据仓库工具,其设计目标和实现方式与传统数据库有显著差异,在实际使用中,掌握一些核心技巧可以显著提升数据处理效率、优化资源利用率,并增强数据管理的灵活性,以下从架构设计、性能优化、数据管理、高级功能等多个维度归纳Hive数据仓库的实用技巧。

架构设计与表结构优化

分区表的合理设计

- 作用:通过分区(Partition)将数据按特定字段(如时间、地域)划分,减少查询时的数据扫描范围。

- 技巧:

- 选择高频查询条件作为分区字段(如

date、country)。 - 避免过多分区(如按天分区时需定期清理历史分区)。

- 动态分区需开启

hive.exec.dynamic.partition=true并设置hive.exec.dynamic.partition.mode=nonstrict。

- 选择高频查询条件作为分区字段(如

- 示例:

CREATE TABLE sales (id BIGINT, amount DECIMAL, date STRING) PARTITIONED BY (year STRING, month STRING) STORED AS ORC;

分桶表(Bucketing)与倾斜优化

- 作用:通过分桶(Bucket)将数据均匀分配到多个文件,优化Join和聚合操作。

- 技巧:

- 分桶字段需选择高基数(Cardinality)字段(如用户ID、商品ID)。

- 桶数量需与集群资源匹配(通常为

num_reducers 3)。 - 处理数据倾斜时,可结合

MAPJOIN或skew join优化。

- 示例:

CREATE TABLE user_logs (uid BIGINT, event STRING) CLUSTERED BY (uid) INTO 10 BUCKETS;

存储格式选择

- 对比:

| 格式 | 压缩支持 | 列式存储 | 分割读取 | 适用场景 |

|————|———-|———-|———-|————————|

| Text | 否 | 否 | 否 | 日志类数据(低性能) |

| ORC | 是 | 是 | 是 | 通用场景(高压缩比) |

| Parquet | 是 | 是 | 是 | 与Spark兼容(高性能) |

| Avro | 是 | 是 | 否 | Schema演化需求 | - 推荐:优先使用

ORC或Parquet,并开启SNAPPY压缩(hive.exec.orc.compression.codec=SNAPPY)。

- 对比:

性能优化核心策略

小文件合并与存储优化

- 问题:大量小文件会导致HDFS寻址开销增加、Map任务数激增。

- 解决方案:

- 使用

CONCATENATE合并小文件(需开启hive.merge.mapfiles=true)。 - 插入数据时设置

hive.merge.size.per.task=256MB,强制合并输出文件。 - 采用

SequenceFile或ORC格式减少文件数量。

- 使用

索引与统计信息

- 索引:对高频查询字段创建Compacted(紧凑型)或Bitmap索引。

CREATE INDEX idx_userid ON COLUMNS(user_id) AS 'COMPACT';

- 统计信息:开启

ANALYZE TABLE自动收集表/分区的统计信息(如行数、列基数),优化查询计划。ANALYZE TABLE orders COMPUTE STATISTICS;

- 索引:对高频查询字段创建Compacted(紧凑型)或Bitmap索引。

资源调优参数

- 关键参数:

| 参数 | 默认值 | 优化建议 |

|——————————|———–|——————————|

|mapreduce.map.memory.mb| 1024 | 根据节点内存调整(如4096MB) |

|mapreduce.reduce.memory.mb| 1024 | 根据任务复杂度调整 |

|hive.exec.parallel| false | 开启并行执行 |

|hive.exec.orc.stripe.size| 250MB | 设置为128MB以加速查询 |

- 关键参数:

数据管理与治理

分区与生命周期管理

- 分区归档:通过脚本定期将历史分区导出为归档文件(如

.tar.gz),并删除原始分区。 - 分区保留策略:结合业务需求设置分区保留周期(如保留最近12个月数据)。

- 分区归档:通过脚本定期将历史分区导出为归档文件(如

数据质量与一致性

- 约束检查:启用

BASIC或UR模式实现ACID事务,保证数据插入的原子性。SET hive.support.concurrency=true; -开启事务支持 SET hive.enforce.bucketing=true; -强制分桶表写入

- 数据校验:使用

HIVE_CHECK_FOREIGN_KEY约束或自定义UDF验证数据完整性。

- 约束检查:启用

权限与安全

- RBAC模型:通过

GRANT语句精细化权限控制(如SELECT、INSERT)。GRANT SELECT ON TABLE sales TO ROLE analyst;

- 加密存储:启用

hive.encrypted.default.key对敏感字段加密。

- RBAC模型:通过

高级功能与场景应用

事务表与实时处理

- 事务表:支持

UPDATE和DELETE操作,适合实时数据更新场景。CREATE TRANSACTIONAL TABLE realtime_data (id BIGINT, status STRING) STORED AS ORC;

- 流式加载:结合

Kafka+Flume实现近实时数据导入。

- 事务表:支持

复杂查询优化

- 子查询优化:将复杂子查询改写为

JOIN或临时表,减少嵌套层级。 - 窗口函数:利用

ROW_NUMBER()、RANK()实现排名分析。 - CTE(公共表表达式):通过

WITH语句复用查询逻辑。WITH user_agg AS (SELECT user_id, COUNT() AS cnt FROM logs GROUP BY user_id) SELECT FROM user_agg WHERE cnt > 10;

- 子查询优化:将复杂子查询改写为

与其他工具集成

- Spark集成:通过

set hive.execution.engine=mr;切换为Tez/Spark引擎提升性能。 - BI工具对接:配置

ODBC或JDBC连接,支持Tableau、PowerBI直接查询。

- Spark集成:通过

常见问题与解决方案

Q1:Hive查询速度慢,如何定位瓶颈?

- 排查步骤:

- 检查是否扫描全表(无分区或分桶)。

- 查看Job执行计划(

EXPLAIN命令)。 - 确认统计信息是否最新(

ANALYZE TABLE)。 - 调整并行度参数(如

mapreduce.job.reduces)。

Q2:如何避免ORC文件过大导致Map任务失败?

- 解决方法:

- 设置

orc.stripe.size=128MB,控制单个 Stripe 大小。 - 启用

hive.exec.orc.split.strategy=BI,按Block边界分割文件。

- 设置