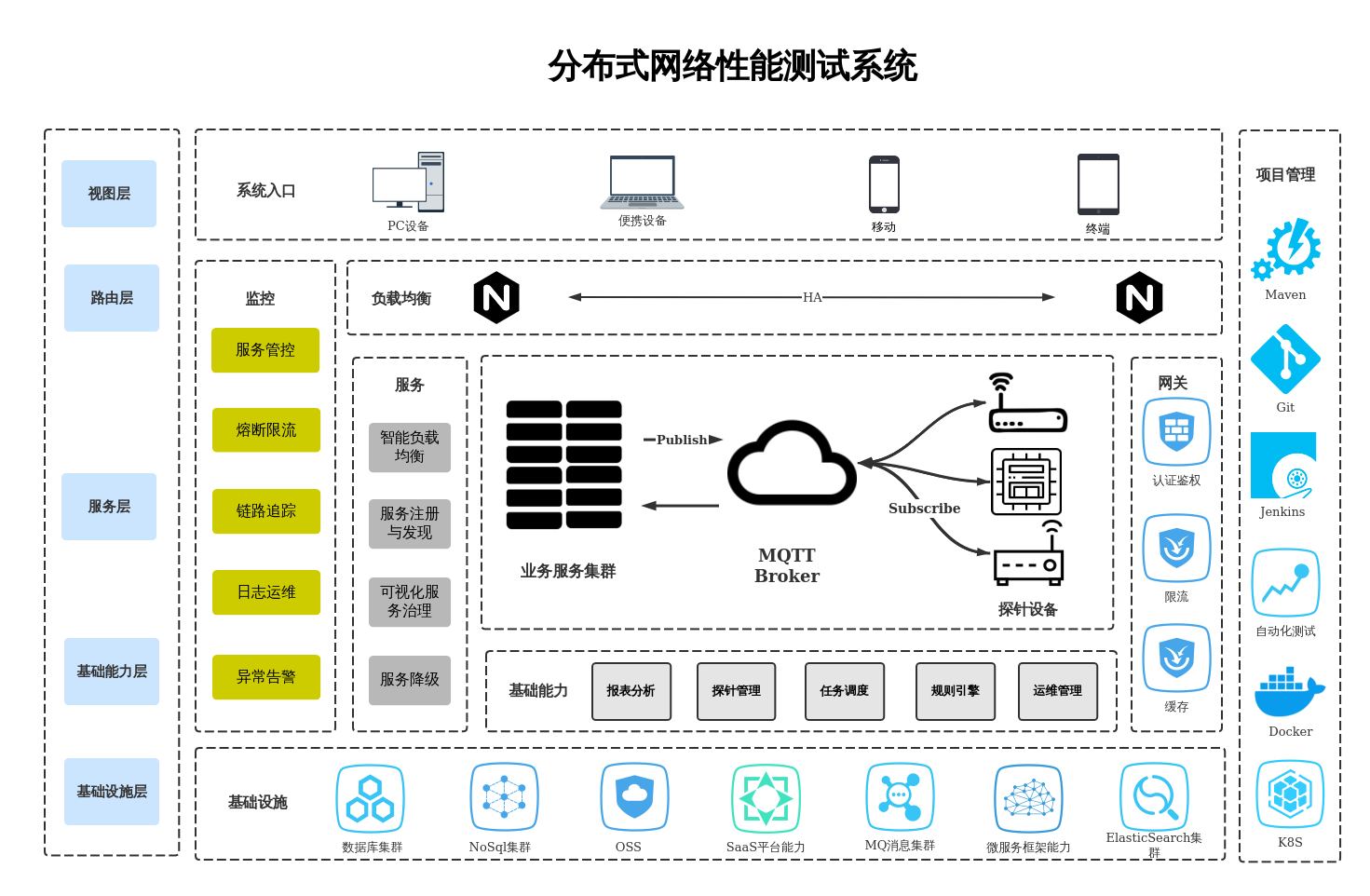

分布式测试服务器

- 行业动态

- 2025-05-07

- 2

架构设计与实践指南

核心概念与应用场景

分布式测试服务器是一种通过多台物理或虚拟服务器协同工作的测试环境,旨在模拟高并发、高负载场景下的系统行为,其核心目标是解决传统单机测试的局限性,例如资源瓶颈、单点故障等问题,典型应用场景包括:

- 压力测试:模拟海量用户请求(如电商大促、社交平台峰值流量)

- 分布式事务验证:测试微服务架构下的跨节点数据一致性

- 容灾演练:模拟数据中心故障时的服务降级能力

- 持续集成/持续交付(CI/CD):自动化测试流水线中的并行执行

核心组件与技术栈

| 组件类别 | 功能描述 | 主流技术选型 |

|---|---|---|

| 负载生成器 | 模拟客户端请求 | JMeter、Gatling、Locust(支持分布式模式) |

| 任务调度器 | 分配测试任务到各节点 | Apache Mesos、Kubernetes原生调度、Celery(需Redis/RabbitMQ) |

| 监控中心 | 实时采集测试数据 | Prometheus+Grafana、Elasticsearch+Logstash+Kibana(ELK)、InfluxDB+Telegraf |

| 结果聚合 | 汇总多节点测试报告 | Allure、Jenkins集成插件、自定义Python/Go脚本 |

| 存储层 | 持久化测试数据与日志 | Ceph分布式存储、MinIO(对象存储)、HDFS、MySQL Cluster |

架构设计要点

分层架构模型

- 物理层:至少3个可用区部署(避免单机房故障)

- 逻辑层:

- 接入层:Nginx/HAProxy负载均衡

- 业务层:Docker容器集群(K8s管理)

- 数据层:Ceph存储+MySQL主从复制

关键设计指标

| 指标类型 | 目标值 | 实现方案 |

|—————-|———————————|————————————————————————–|

| 并发能力 | ≥10万QPS(可线性扩展) | 采用K8s水平扩展机制,结合Istio流量控制 |

| 数据一致性 | CAP定理下优先保证AP特性 | 使用Redis Sentinel实现最终一致性,配合Sagas事务补偿机制 |

| 故障恢复 | <5分钟自动切换 | Keepalived+VIP漂移,数据库采用MHA多主热备 |网络拓扑设计

graph TD A[客户端] -->|HTTP/HTTPS| B{负载均衡器} B --> C[应用服务器集群] B --> D[数据库集群] C -.-> E[监控系统] D -.-> E E --> F[日志分析平台] F -.-> G[告警中心]

实施步骤详解

环境准备阶段

- 硬件配置:每节点至少16核CPU/64GB内存,SSD磁盘(RAID10)

- 网络规划:预留10Gbps带宽,配置VLAN隔离测试流量

- 安全基线:启用SELinux/AppArmor,配置防火墙dmz区

集群部署流程

# 示例:基于K8s的测试环境初始化 kubectl create -f https://raw.githubusercontent.com/helm/charts/master/prometheus/values.yaml helm install stable/ceph-mon ./ceph-helm-chart --set monitor.count=3

典型测试场景配置

- 压力测试:

# Locust分布式测试示例 from locust import HttpUser, task, between class WebsiteUser(HttpUser): wait_time = between(1, 5) @task def index(self): self.client.get("/") - 故障注入测试:

# 使用Chaos Monkey进行随机服务终止 java -jar chaos-monkey-1.0.0.jar --scanPackages com.example.service --terminateOneInstancePerApp true

- 压力测试:

性能优化策略

资源调度优化

- 使用Kubelet cgroup限制容器资源占用

- 配置HPA(Horizontal Pod Autoscaler)动态扩缩容

数据传输优化

| 优化方向 | 实施方案 |

|—————-|————————————————————————–|

| 网络IO | 启用RDMA(远程直接内存访问),配置Jumbo Frame(9000字节MTU) |

| 存储IO | Ceph CRUSH算法优化,设置replica size=3,osd_pool_size=10PB |

| 序列化效率 | Protobuf替代JSON,使用FlatBuffers减少二进制解析开销 |测试数据生成

- 使用Faker库生成模拟数据

- 配置DataFactory创建符合业务特征的数据集

- 示例:

dd if=/dev/zero of=testfile bs=1M count=10240生成10GB测试文件

常见挑战与解决方案

| 问题类型 | 典型表现 | 解决方案 |

|---|---|---|

| 时钟同步问题 | 分布式追踪时序错误(如Zipkin显示乱序请求) | 部署NTP服务,配置chrony时间同步精度<1ms |

| 状态共享难题 | 购物车服务会话状态不一致 | 采用Redis Cluster集中式缓存,设置maxmemory-policy=allkeys-lru |

| 资源争用瓶颈 | JVM堆内存溢出导致测试中断 | 配置JVM参数:-Xms4g -Xmx4g -XX:MaxMetaspaceSize=256m |

成本控制方案

| 成本维度 | 优化措施 |

|---|---|

| 硬件采购 | 采用白盒服务器,使用OpenStack管理异构硬件 |

| 云服务替代 | 非核心组件使用Serverless(如AWS Lambda处理日志分析) |

| 能效管理 | 配置Kubernetes节能模式(如cpu.cfs_qos_enable=1),设置空闲节点自动休眠 |

FAQs

Q1:如何快速扩展测试节点?

A1:推荐使用容器编排平台的自动伸缩功能,例如在K8s中配置Horizontal Pod Autoscaler,根据CPU使用率(target=70%)或自定义指标(如QPS>10k)自动创建新实例,同时需确保底层IaaS支持API快速创建虚拟机。

Q2:测试过程中出现节点宕机如何处理?

A2:应建立三级容错机制:① 负载均衡器自动摘除故障节点(如HAProxy的server Intercept errors);② 任务调度器重新分配未完成测试(如Celery的retry机制);③ 监控系统触发告警(Prometheus Alertmanager发送钉钉通知),恢复后需