上一篇

如何高效申请GPU云服务器并快速部署?

- 行业动态

- 2025-05-08

- 6

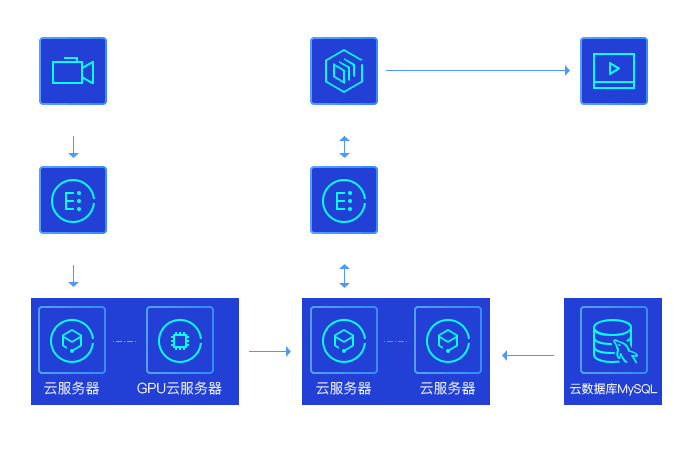

申请GPU云服务器需先选择云平台(如阿里云、 酷盾、AWS等),注册账号并完成实名认证,进入控制台后,选择GPU实例类型,按需配置显存、计算核心等参数,提交订单并支付费用,部分平台需审核资质,通过后即可部署环境并通过SSH或远程桌面连接使用。

如何申请GPU云服务器?详细指南

在现代人工智能、深度学习和高性能计算场景中,GPU云服务器已成为企业和开发者的重要工具,本文将详细介绍申请GPU云服务器的完整流程,并提供实用建议,助您高效完成配置。

申请GPU云服务器的核心步骤

明确需求与预算

- 计算需求:根据任务类型(如模型训练、渲染、数据分析)选择GPU型号(如NVIDIA A100/V100/T4)。

- 存储与网络:预估数据集大小、内存需求和带宽要求。

- 预算规划:按需选择按时计费或包年包月模式。

选择云服务提供商

主流平台对比:- 国内平台:阿里云、酷盾、华为云(合规性强,适合国内业务);

- 国际平台:AWS、Google Cloud、Azure(支持全球节点,GPU型号丰富)。

注册与实名认证

- 提供企业/个人证件(如营业执照、身份证),完成实名审核(通常需1-2个工作日)。

- 国际平台需绑定国际信用卡(如Visa/MasterCard)。

配置实例参数

- GPU型号:根据框架兼容性选择(如TensorFlow优先兼容CUDA计算能力高的GPU)。

- 镜像系统:预装环境(如PyTorch/TensorFlow镜像)或自定义镜像。

- 存储配置:挂载SSD云盘或高性能文件存储(如NAS)。

支付与开通

- 选择付费方式:按量付费(灵活,适合短期任务)或预留实例(成本更低)。

- 开通后获取登录信息:IP地址、SSH密钥/密码。

连接与部署环境

- 通过SSH或远程桌面连接服务器。

- 安装驱动(如NVIDIA驱动、CUDA工具包)和依赖库。

监控与管理

- 使用云平台控制台监控GPU利用率、显存占用。

- 设置自动告警(如GPU负载超过90%时触发通知)。

注意事项与避坑指南

资源配额限制

- 新账号可能默认无GPU配额,需提交工单申请(注明用途和所需型号)。

- 部分平台限制单账户GPU实例数量(如AWS vCPU配额机制)。

费用透明度

- 注意隐藏成本:公网流量费、存储快照费、GPU闲置费用。

- 建议开启“预算告警”功能(如阿里云费用中心设置阈值)。

合规性与许可证

- 国内业务需确保数据存储在境内节点。

- 检查框架许可证(如某些深度学习库禁止商用需授权)。

技术支持优先级

- 企业级客户可申请专属客户经理,获得7×24小时技术支持。

- 社区版用户建议通过工单或论坛解决问题。

推荐的主流GPU云平台

| 平台 | 优势 | 适用场景 |

|---|---|---|

| 阿里云 | 国内低延迟、完善的ML生态(PAI平台) | 企业级AI训练、合规性要求高的项目 |

| AWS | 全球节点覆盖、EC2弹性GPU实例 | 跨国团队协作、大规模分布式训练 |

| 酷盾 | 性价比高、NVIDIA Ampere架构机型多 | 中小型创业公司、渲染加速 |

| Google Cloud | TPU/GPU混合调度、Kaggle集成 | 学术研究、实验性模型开发 |

常见问题解答

Q1:申请GPU服务器需要编程基础吗?

- 基础操作可通过图形化控制台完成,但环境部署和任务调试需掌握Linux命令及Python基础。

Q2:如何避免GPU资源浪费?

- 使用Jupyter Notebook交互式开发,或通过脚本监控任务进度,任务结束后及时释放实例。

Q3:不同型号GPU的价格差异有多大?

- 以阿里云为例:T4实例约5元/小时,A10约3元/小时,A100可达20元/小时。

Q4:是否支持临时扩容GPU?

- 多数平台支持“弹性伸缩组”,可在任务高峰期自动扩容(需提前配置策略)。

引用说明

本文参考以下平台官方文档:

- 阿里云GPU实例文档:https://help.aliyun.com

- AWS EC2用户指南:https://docs.aws.amazon.com

- NVIDIA CUDA兼容性列表:https://developer.nvidia.com/cuda-gpus