上一篇

分布式文件存储测试

- 行业动态

- 2025-05-08

- 2

分布式文件存储测试需多节点并发读写,验证数据一致性,评估吞吐量、延迟等性能

核心指标与实践方案

测试背景与目标

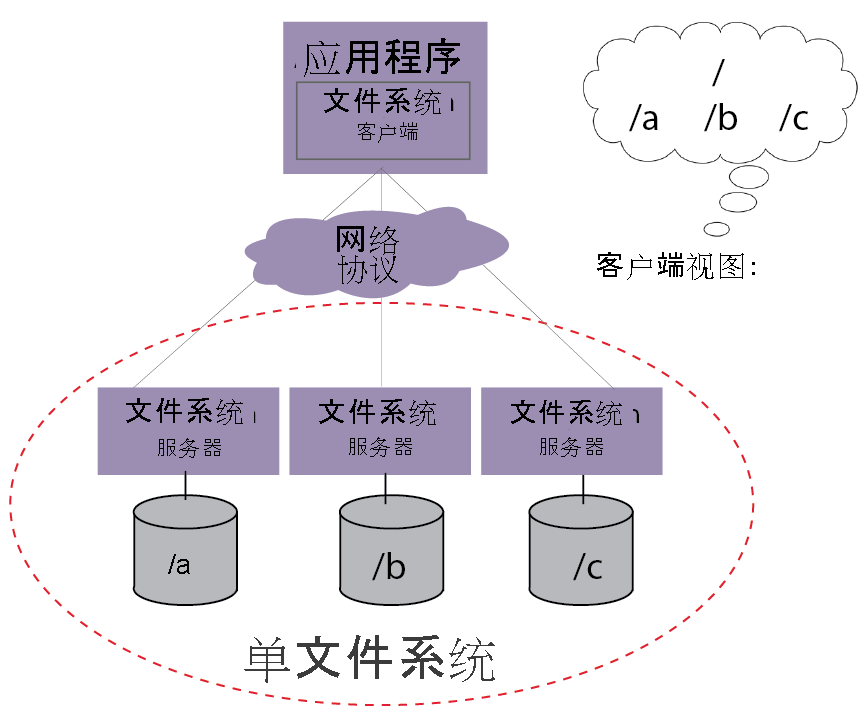

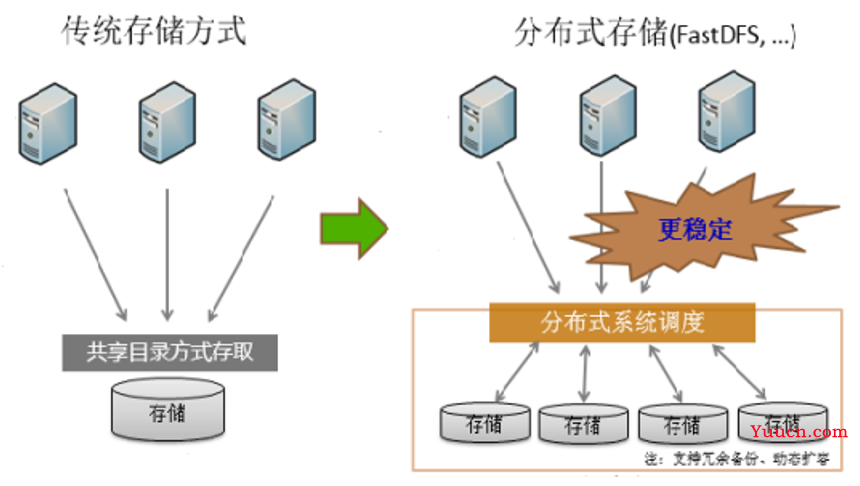

分布式文件存储系统(如Ceph、MinIO、GlusterFS)在云计算、大数据场景中广泛应用,其性能、可靠性、扩展性直接影响业务稳定性,测试需覆盖以下核心目标:

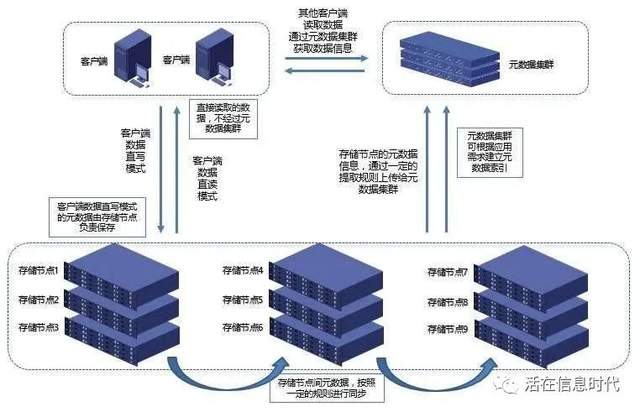

- 验证功能完整性:支持的文件协议(POSIX、S3)、权限管理、元数据操作等

- 量化性能指标:吞吐量、延迟、并发能力、网络带宽利用率

- 评估可靠性:数据冗余机制、故障恢复时间、数据一致性

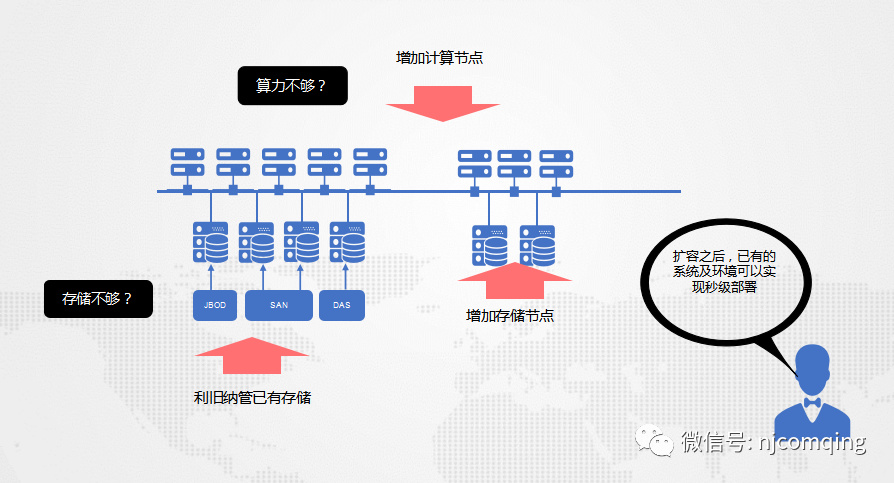

- 测试扩展性:节点增减对系统的影响、负载均衡效果

- 验证安全性:加密传输、访问控制、审计日志

测试环境搭建

| 组件 | 配置说明 | 数量 |

|---|---|---|

| 存储节点 | Intel Xeon Gold 6348 × 2 512GB RAM NVMe SSD × 4(RAID0) | 3-10节点 |

| 客户端 | i7-12700K 32GB RAM 10Gbps网卡 | 1-5节点 |

| 网络架构 | 10Gbps以太网/InfiniBand | 根据规模选择 |

| 测试数据集 | 混合类型文件(小文件<1KB/大文件>1GB) | 总容量≥10TB |

核心测试场景与方法

性能基准测试

测试工具:

- FIO:用于块设备IOPS/吞吐量测试

- S3Bench:模拟S3 API请求(适用于对象存储)

- MDTest(Ceph专用):元数据操作性能测试

- Netperf/Iperf:网络传输性能测试

关键指标:

| 指标 | 定义 | 目标值参考 |

|————–|————————————|—————-|

| 吞吐量 | 单位时间传输数据量(MB/s) | >10Gbps(10节点集群) |

| 延迟 | 单次操作响应时间(ms) | <10ms(99%分位) |

| IOPS | 每秒IO操作次数 | >100k(4K随机写) |

| 并发连接数 | 同时处理的客户端连接数量 | >5000(S3接口) |

典型测试用例:

- 小文件写入:创建100万个1KB文件,观察元数据服务压力

- 大文件流式写入:持续写入10GB单一文件,测试带宽上限

- 混合负载:70%读+30%写,模拟真实业务场景

可靠性验证

故障注入测试:

- 节点故障:随机关闭存储节点,验证数据重建时间(目标<30秒)

- 网络分区:切断部分节点网络,测试CAP定理下的可用性表现

- 磁盘故障:注入坏盘,检查EC/副本恢复机制

数据一致性验证:

- 强一致性测试:写入后立即读取,验证数据可见性

- 最终一致性测试:在高并发下检查数据收敛时间

- 跨区域复制:多数据中心部署时,验证异步复制延迟

扩展性测试

| 阶段 | 操作 | 观测指标 |

|---|---|---|

| 横向扩展 | 逐个添加节点 | 吞吐量线性比接近1:1 |

| 纵向扩展 | 升级硬盘/内存 | 性能提升比例符合硬件参数 |

| 负载均衡 | 动态迁移数据 | 各节点负载差异<5% |

测试结果分析框架

性能瓶颈定位

| 现象 | 可能原因 | 解决措施 |

|---|---|---|

| 吞吐量低于预期 | 网络带宽不足/磁盘IO瓶颈 | 启用RDMA/优化RAID配置 |

| 小文件性能差 | 元数据服务过载 | 增加MDS节点/使用对象存储网关 |

| 延迟抖动大 | 客户端网络不稳定/负载不均衡 | 启用流量控制/优化调度算法 |

可靠性量化评估

| 指标 | 计算方式 | 合格标准 |

|---|---|---|

| 数据持久性 | (总文件数 丢失文件数)/总文件数 | >99.999% |

| 故障恢复时间 | 从故障发生到服务恢复的时间 | <60秒(单节点故障) |

| 数据一致性概率 | 强一致性请求成功比例 | >99.9% |

典型问题与解决方案

元数据服务瓶颈

- 问题表现:大量小文件操作时IOPS骤降

- 优化方案:

- Ceph:增加MDS节点,启用元数据缓存

- MinIO:部署独立Metadata服务,开启dynamoDB后端

- GlusterFS:使用AFR(自动修复)模式减少锁竞争

网络带宽利用率低

- 根因分析:

- TCP协议开销过大

- 客户端并发连接数不足

- 存储节点间通信未优化

- 改进措施:

- 启用RDMA(远程直接内存访问)

- 配置JuiceFS等分布式缓存

- 优化CRUSH地图减少跨节点通信

测试报告模板(示例)

| 测试项目 | Ceph (RBD) | MinIO (S3) | GlusterFS |

|---|---|---|---|

| 10Gbps带宽利用率 | 89% | 93% | 72% |

| 百万级小文件写入 | 12min | 8min | 15min |

| 单节点故障恢复时间 | 23s | 18s | 35s |

| 最大并发连接数 | 8000 | 12000 | 6000 |

FAQs

Q1:如何判断分布式存储系统是否适合我的业务?

A:需评估三个关键维度:

- 数据特征:小文件占比超过50%建议Ceph/MinIO,大文件为主可选GlusterFS

- 性能需求:金融交易类需强一致性+低延迟,日志类可接受最终一致性

- 成本预算:EC编码比副本存储节省60%空间,但计算开销增加20%

Q2:测试中发现性能不达标,如何快速定位问题?

A:采用分层排查法:

- 网络层:使用pingcap/tc命令检查丢包率和带宽限制

- 存储层:通过iostat/dstat查看磁盘IO队列长度和利用率

- 应用层:启用fio的latency分布图,定位慢响应来源

- 配置层:检查CRUSH map是否导致数据倾斜