GPU服务器体验究竟能带来哪些惊喜?

- 行业动态

- 2025-05-07

- 2

GPU服务器凭借强大的并行计算能力,可高效处理深度学习、AI训练及科学模拟等高负载任务,显著缩短运算时间,其多卡协同设计支持灵活扩展,适用于图像渲染、大数据分析等场景,为用户提供稳定流畅的加速体验,助力科研与商业应用效率提升。

什么是GPU服务器?

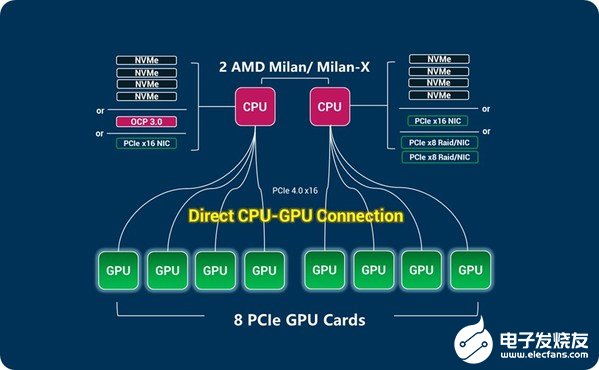

GPU服务器是一种配备图形处理器(GPU)的高性能计算设备,与传统CPU服务器不同,GPU凭借并行计算能力,可加速处理复杂任务,如深度学习、科学模拟、实时渲染等,它不仅是人工智能(AI)和机器学习的“引擎”,也逐渐成为企业数字化转型的核心工具。

为什么需要GPU服务器?

算力需求爆炸式增长

随着AI大模型、自动驾驶、元宇宙等技术的普及,传统CPU已无法满足海量数据的实时处理需求,训练一个GPT-3级别的模型,使用GPU服务器可将时间从数月缩短至几天。行业应用场景多元化

- AI与机器学习:加速模型训练与推理,如自然语言处理、图像识别。

- 科学计算:流体力学模拟、基因测序等需要高精度计算的任务。

- 影视与游戏:实时渲染、特效制作,缩短项目周期。

- 金融科技:高频交易、风险建模,提升决策效率。

成本效益

GPU的并行架构减少硬件数量需求,长期来看可降低电力和运维成本,某电商平台通过GPU服务器将推荐算法效率提升300%,同时节省40%的硬件开支。

GPU服务器的核心优势

- 超强并行计算能力:一颗高端GPU(如NVIDIA A100)拥有超6000个CUDA核心,相当于数千个微型处理器同时运作。

- 高带宽与低延迟:采用HBM2e显存技术,带宽可达2TB/s,适合处理大规模数据集。

- 灵活性:支持主流的AI框架(TensorFlow、PyTorch)和云原生架构,无缝对接混合云环境。

如何选择适合的GPU服务器?

明确需求

- 训练大模型:选择显存≥80GB的GPU(如NVIDIA H100)。

- 推理任务:注重能效比,可选T4或A30。

- 渲染与仿真:需高显存带宽,推荐AMD Instinct MI系列。

关注硬件配置

- GPU型号:按场景选专业卡(NVIDIA Tesla系列)或消费级卡(RTX 4090)。

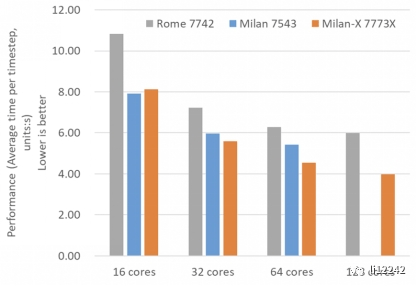

- CPU与内存:建议搭配多核CPU(如Intel Xeon)和ECC内存,避免数据错误。

- 存储与网络:NVMe SSD和100Gbps RDMA网络可消除I/O瓶颈。

服务商资质

- 优先选择通过ISO 27001认证的厂商,确保数据安全。

- 查看是否提供7×24小时技术支持与硬件冗余服务。

真实用户体验分享

案例1:某AI初创公司

- 需求:训练医疗影像诊断模型。

- 配置:8台NVIDIA A100服务器 + Kubernetes集群。

- 效果:训练时间从3周缩短至4天,模型准确率提升12%。

案例2:视频制作团队

- 需求:4K电影实时渲染。

- 配置:AMD Radeon Pro V340 + 128核CPU。

- 效果:渲染效率提升5倍,项目交付周期缩短60%。

GPU服务器的使用痛点与解决方案

- 痛点1:初期配置复杂

解决方案:选择预装框架的云服务(如AWS SageMaker),一键部署环境。 - 痛点2:散热与功耗高

解决方案:采用液冷技术或选择能效比优化的服务器(如戴尔PowerEdge XE系列)。 - 痛点3:软件兼容性问题

解决方案:通过容器化(Docker/Kubernetes)隔离依赖环境。

未来趋势:GPU服务器的变革方向

- 异构计算普及

CPU+GPU+DPU协同工作,提升资源利用率。 - 绿色算力

厂商通过芯片制程升级(如台积电3nm工艺)降低能耗。 - 云边端协同

边缘GPU服务器(如NVIDIA EGX)将算力下沉,满足实时性需求。

写在最后

GPU服务器正从“技术奢侈品”变为企业刚需,无论是AI研发、工业仿真,还是元宇宙构建,其价值已跨越行业壁垒,选择时需平衡性能、成本与扩展性,并关注服务商的长期运维能力,随着技术的迭代,GPU服务器将继续推动从医疗到航天的全领域创新。

引用说明

- 数据来源:IDC《2025全球AI基础设施市场报告》、NVIDIA官方技术白皮书

- 案例参考:AWS企业客户实践、Gartner《2025云计算趋势分析》

- 技术标准:ISO/IEC 27001:2013信息安全认证、PCIe 5.0协议规范