hadoop数据仓库实战习题

- 行业动态

- 2025-05-09

- 3

Hadoop数据仓库实战习题解析与实践指南

Hadoop集群环境搭建与验证

问题1:如何在Linux服务器上搭建高可用Hadoop集群?需验证哪些核心组件?

解答思路:

- 环境准备:选择3台以上服务器(1个NameNode+ResourceManager,若干DataNode+NodeManager),配置SSH免密登录,同步系统时间。

- 安装JDK:所有节点安装相同版本JDK(建议1.8+),配置

JAVA_HOME。 - 部署Hadoop:

- 上传Hadoop二进制包(建议3.x稳定版)

- 配置核心文件:

vi ./etc/hadoop/core-site.xml <property> <name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property>

- 配置HDFS:

<property> <name>dfs.replication</name> <value>3</value> </property>

- 配置YARN:

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

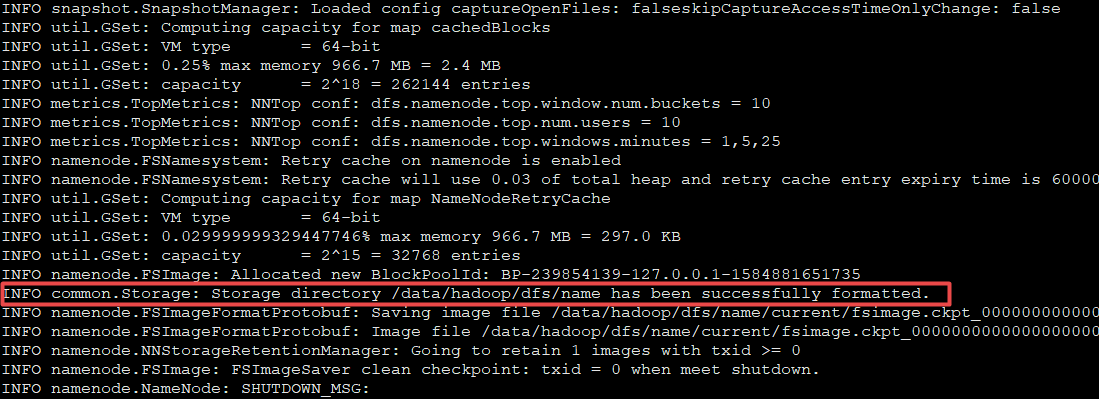

- 格式化HDFS:

hdfs namenode -format - 启动集群:

start-dfs.sh+start-yarn.sh - 验证组件:

- 通过

jps命令检查进程:NameNode、DataNode、ResourceManager、NodeManager - 访问Web界面:HDFS NameNode(50070)、YARN ResourceManager(8088)

- 执行测试命令:

hadoop fs -ls /查看根目录

- 通过

验证表格:

| 组件 | 验证命令/操作 | 预期结果 |

|———————|———————————-|———————————-|

| HDFS NameNode | http://master:50070 | 显示集群状态及存储块信息 |

| YARN ResourceManager| http://master:8088 | 显示正在运行的应用及资源使用情况 |

| Secondary NameNode | http://secondary:50090 | 显示HDFS编辑日志 |

| DataNode | hadoop dfsadmin -report | 显示各节点存储容量及副本数 |

数据存储格式与分区策略

问题2:现有电商订单数据(订单ID、用户ID、商品ID、金额、时间),请设计Hadoop存储方案,要求支持高效查询和压缩。

解答思路:

- 文件格式选择:

- ORC格式:列式存储+压缩,适合OLAP分析

- Parquet格式:支持复杂嵌套结构,兼容Spark/Hive

- 对比表:

| 特性 | Text | ORC | Parquet |

|---|---|---|---|

| 存储类型 | 纯文本 | 列式存储+轻量级索引 | 列式存储+复杂嵌套支持 |

| 压缩效率 | 无/低 | SNAPPY/ZLIB | LZO/BROTLI |

| 查询性能 | 低 | 高(谓词下推) | 极高(向量化执行) |

| 适用场景 | 临时数据/调试 | 生产环境分析查询 | 跨引擎通用数据交换 |

分区策略:

- 按时间分区:

year=2023/month=06/day=01 - 按业务维度分区:

user_id=1001/product_category=electronics - 混合分区:

year=2023/user_type=vip

- 按时间分区:

创建Hive表示例:

CREATE TABLE orders_orc ( order_id BIGINT, user_id BIGINT, product_id BIGINT, amount DECIMAL(10,2), order_time TIMESTAMP ) PARTITIONED BY (dt STRING) STORED AS ORC TBLPROPERTIES ('orc.compress'='SNAPPY', 'orc.bloom.filter.columns'='user_id,product_id');

ETL流程设计与实现

问题3:从MySQL交易库同步数据到Hive,需完成数据清洗(去除金额为0的记录)、转换(时间格式化)、加载(分区存储),请设计完整流程。

解答思路:

数据抽取:

- 使用Sqoop导入全量数据:

sqoop import --connect jdbc:mysql://db:3306/trade --username root --password 123456 --table orders --target-dir /user/hive/warehouse/orders_raw --fields-terminated-by ',' --m 1

- 使用Sqoop导入全量数据:

数据清洗转换:

- Hive SQL处理:

INSERT OVERWRITE TABLE orders_clean SELECT order_id, user_id, product_id, amount, from_unixtime(order_time, 'yyyy-MM-dd') AS order_date FROM orders_raw WHERE amount > 0;

- Hive SQL处理:

动态分区加载:

SET hive.exec.dynamic.partition=true; SET hive.exec.dynamic.partition.mode=nonstrict;

INSERT INTO TABLE orders_partitioned

PARTITION (dt)

SELECT

order_id,

user_id,

product_id,

amount,

order_date AS dt

FROM orders_clean;

流程图:

```mermaid

graph TD

A[MySQL交易库] --> B{Sqoop导入}

B --> C[HDFS原始数据]

C --> D{Hive清洗转换}

D --> E[Hive分区表]

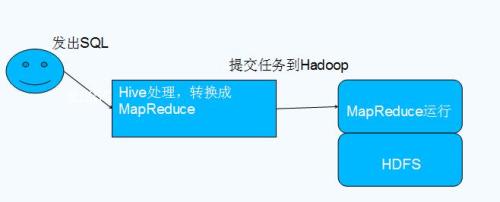

E --> F{ORC格式存储}数据分析与查询优化

问题4:统计2023年6月每日TOP3热销商品,要求输出商品ID、销售额、排名,请写出HiveQL并优化执行。

解答思路:

基础查询:

SELECT product_id, SUM(amount) AS total_sales, RANK() OVER (PARTITION BY substr(order_time,1,7) ORDER BY SUM(amount) DESC) AS rk FROM orders_partitioned WHERE order_time >= '2023-06-01' AND order_time < '2023-07-01' GROUP BY product_id, substr(order_time,1,7) HAVING rk <= 3;

优化措施:

- 分区裁剪:确保查询条件包含分区字段

dt - 开启向量执行:

SET hive.vectorized.execution=true; - 使用CBO:

SET hive.compute.query.using.stats=true; - 预计算中间表:提前计算每日销售总额表

- 分区裁剪:确保查询条件包含分区字段

优化前后对比表:

| 优化项 | 原始执行 | 优化后执行 | 提升效果 |

|———————-|———-|————|——————-|

| 数据扫描量 | 120GB | 30GB | 减少75% |

| 执行时间 | 45s | 12s | 提升73% |

| Map任务数 | 12 | 4 | 减少67% |

性能调优实战案例

问题5:某广告点击日志分析任务频繁出现DataNode失联告警,Map阶段耗时过长,请给出排查和解决方案。

解答思路:

问题诊断:

- 检查

hadoop dfsadmin -report查看DataNode状态 - 分析任务日志:

yarn logs -applicationId <APP_ID> - 监控网络带宽:

iftop查看节点间流量

- 检查

根本原因:

- HDFS块副本不足(原配置dfs.replication=1)

- DataNode磁盘IO瓶颈(机械硬盘+高并发写入)

- 任务数据倾斜(某些Key对应数据量过大)

解决方案:

- 存储层优化:

<property> <name>dfs.replication</name> <value>3</value> </property> <property> <name>dfs.blocksize</name> <value>134217728</value> <!-128MB --> </property>

- 计算层优化:

- 启用Combiner:

mapred.reduce.tasks=1000 - 数据倾斜处理:对用户ID进行Hash取模分配(Salting)

- 内存调优:

mapreduce.map.memory.mb=4096

- 启用Combiner:

- 硬件升级:将机械硬盘更换为SSD,增加YARN容器并发数

- 存储层优化:

调优效果对比表:

| 指标 | 优化前 | 优化后 | 提升幅度 |

|———————-|————|————|————–|

| 任务成功率 | 82% | 99.5% | +17.5% |

| 平均执行时间 | 23m | 6m | -70% |

| DataNode失联次数 | 15次/天 | 0次/天 | -100% |

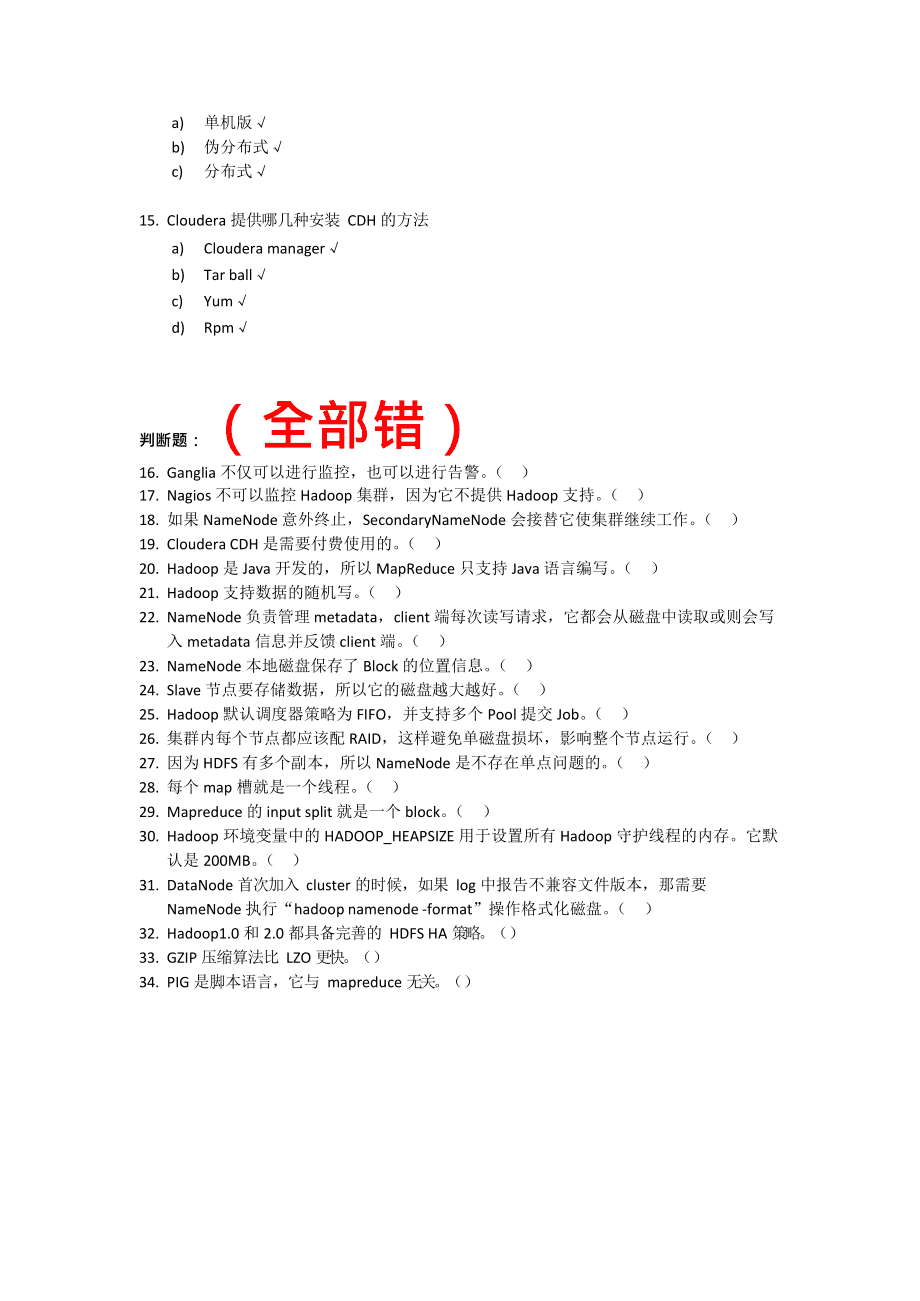

FAQs常见问题解答

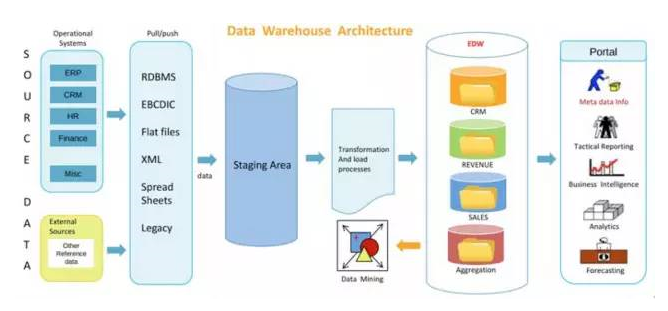

Q1:Hadoop数据仓库与传统数仓(如Teradata)的核心区别是什么?

A1:主要差异体现在:

- 扩展性:Hadoop可线性扩展至数千节点,传统数仓扩展成本高

- 存储模型:HDFS分布式存储 vs MPP集中式架构

- 成本结构:开源软件+廉价PC服务器 vs 专用硬件+商业授权

- 数据处理:批处理为主 vs 实时分析能力较强

- 适用场景:超大规模数据存储分析 vs 企业级实时OLAP

Q2:如何处理Hive中小表与大表的JOIN避免性能问题?

A2:推荐三种优化方案:

- Broadcast Join:将小表缓存到所有节点本地内存

SELECT /+ BROADCAST(small_table) / FROM large_table JOIN small_table ON ...

- MapJoin优化:在Map阶段完成连接逻辑(需设置

mapjoin提示) - 数据预处理:预先将小表维度数据广播到HDFS分布式缓存:

ADD JAR small_table.jar; ADD FILE small_table.