上一篇

分布式架构云原生质量

- 行业动态

- 2025-05-09

- 3

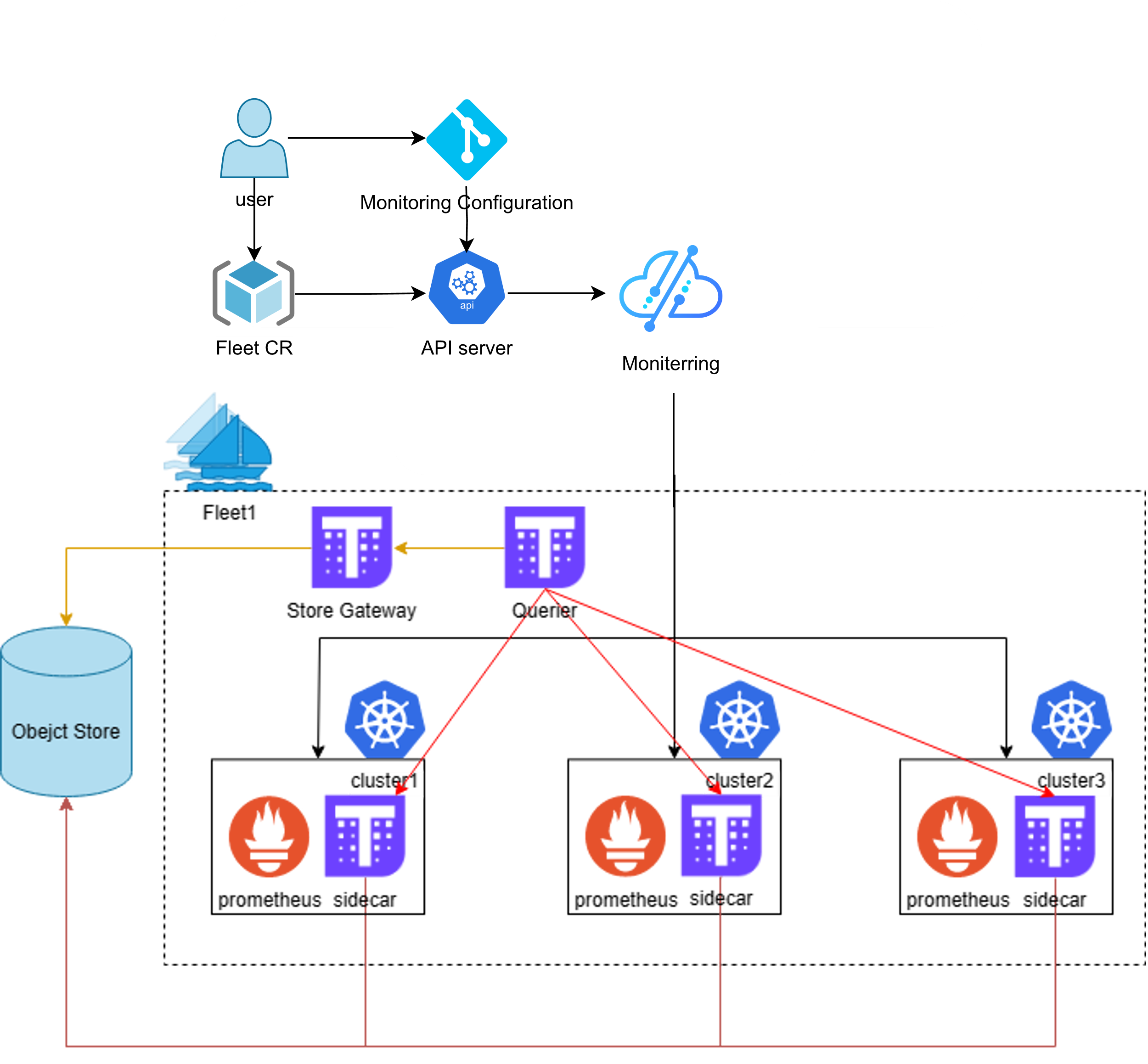

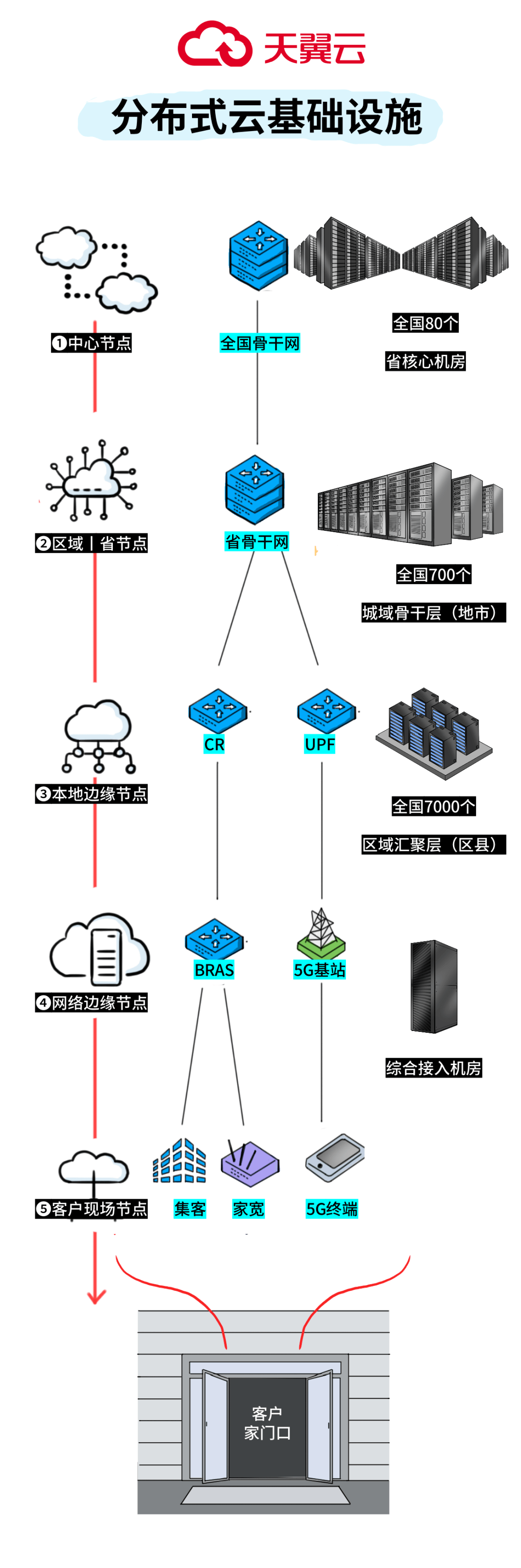

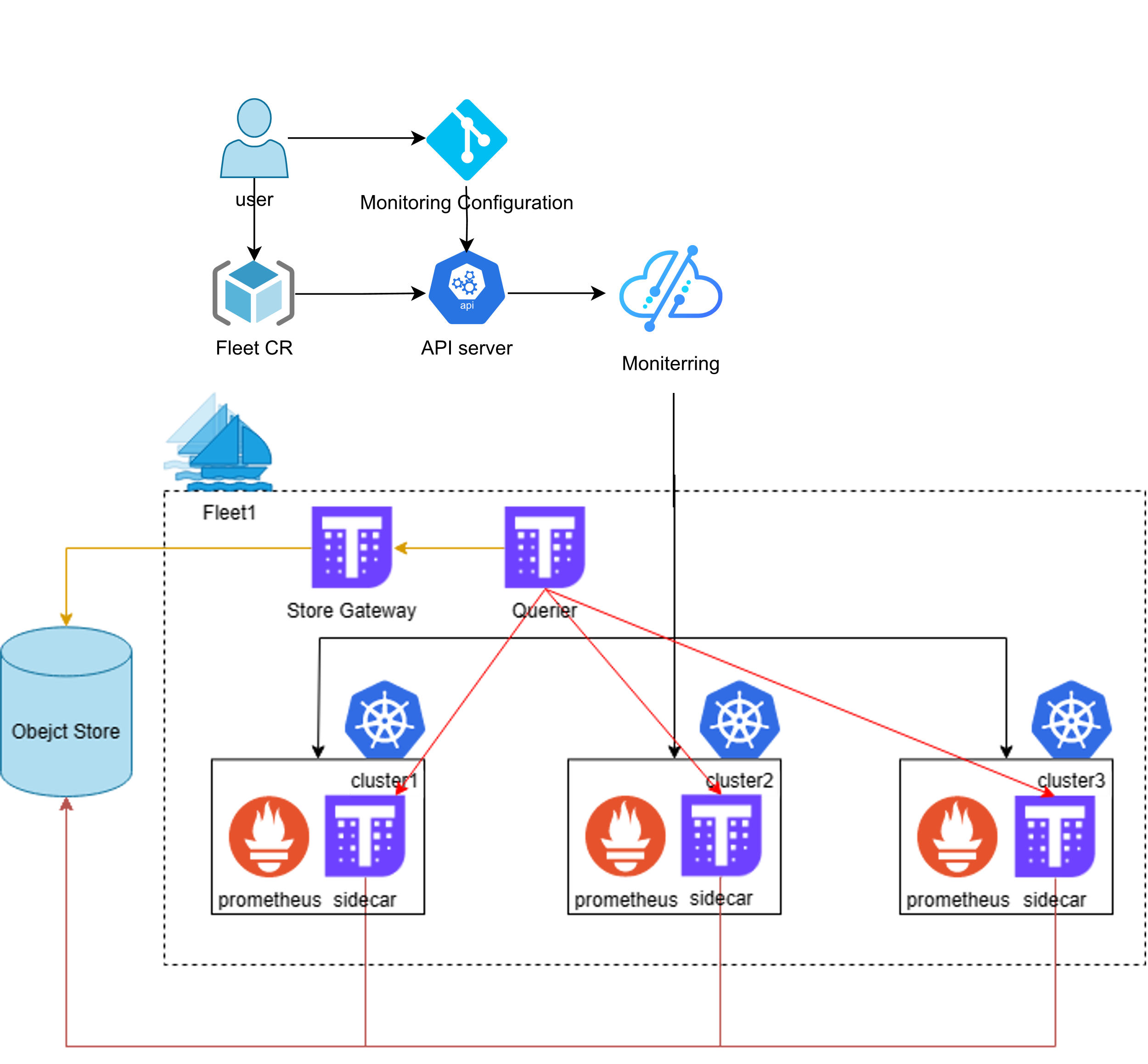

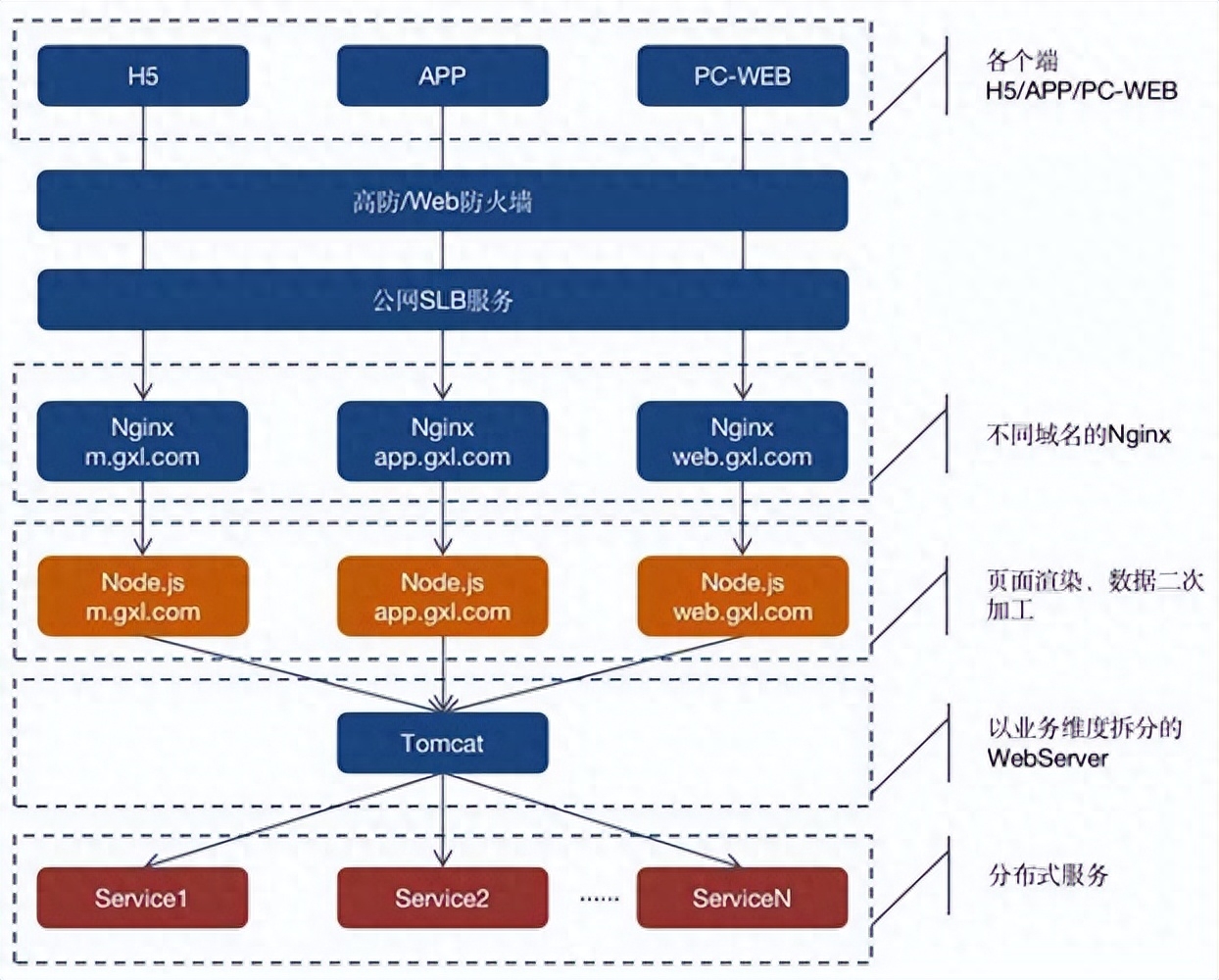

云原生赋能分布式架构,通过容器化、微服务实现弹性扩展,自动化运维保障系统高可用与

分布式架构与云原生技术融合下的质量保障体系

核心概念解析

| 概念 | 定义 | 技术特征 |

|---|---|---|

| 分布式架构 | 通过多节点协同处理请求的系统架构 | 服务拆分、网络通信、数据一致性、容错机制 |

| 云原生 | 基于云计算特性设计的应用开发与运维模式 | 容器化、微服务、不可变基础设施、声明式API管理 |

| 质量保障 | 确保系统功能、性能、安全等指标达标的完整体系 | 自动化测试、监控告警、混沌工程、SLO/SLA管理 |

分布式架构的云原生演进路径

容器化改造:

- Docker封装应用及依赖,消除环境差异

- Kubernetes实现弹性扩缩容(HPA/VPA)

- 服务网格(Istio/Linkerd)处理服务间通信

微服务治理:

- 服务注册发现(Consul/Eureka)

- API网关(Envoy/Kong)流量管理

- 熔断降级(Hystrix/Resilience4j)

存储与数据层:

- 云数据库(Aurora/CockroachDB)支持弹性扩展

- S3/MinIO对象存储替代传统NAS

- EventBridge/Kafka事件驱动架构

云原生质量保障关键技术矩阵

| 质量维度 | 云原生解决方案 | 实施要点 |

|---|---|---|

| 功能正确性 | GitLab CI/CD管道 | 集成单元测试(JUnit)、契约测试(Pact)、UI自动化(Cypress) |

| 性能效率 | 全链路压测平台(JMeter/Gatling) | 模拟百万级并发,识别数据库慢查询、服务瓶颈 |

| 可靠性 | 混沌工程(Chaos Monkey/Gremlin) | 注入网络延迟、节点宕机、磁盘故障,验证自愈能力 |

| 安全性 | 镜像安全扫描(Trivy/Clair) | 检测容器镜像破绽,符合CIS基准要求 |

| 可观测性 | Prometheus+Grafana+ELK | 统一监控指标(黄金指标)、日志聚合、分布式追踪(Jaeger) |

典型质量保障场景实践

蓝绿部署策略:

- 通过Ingress配置双版本路由

- 结合烟雾测试验证新版本健康状态

- 流量切转前保持旧版本待命

金丝雀发布流程:

graph TD A[代码提交] --> B[自动化构建] B --> C{灰度策略} C -->|Header-based| D[修改Istio权重] C -->|IP-based | E[修改Service selector] D & E --> F[探针检测] F --> G[全量发布]SRE应急响应:

- 建立Oncall轮换制度

- 制定标准操作手册(Runbook)

- 实施Postmortem复盘机制

质量门禁标准示例

| 质量门类 | 准入标准 | 检测手段 |

|---|---|---|

| 单元测试覆盖率 | 核心模块≥80%,新功能增量测试100% | SonarQube代码扫描 |

| API响应时间 | 99%请求<500ms,TP99<1s | Gatling负载测试 |

| 故障恢复时间 | 单节点故障自愈<30s,跨AZ切换<1min | Chaos Engineering演练 |

| 安全破绽修复 | CVSS评分≥7.0的破绽需在72小时内修复 | Dependabot自动生成PR |

FAQs

Q1:如何在分布式系统中定位偶发性故障?

A1:应采用三级定位策略:

- 通过Prometheus时序数据聚类分析异常指标峰值

- 使用Jaeger追踪特定时间段的调用链,观察延迟突变点

- 启用FlameGraph火焰图分析CPU热点,结合日志关键字检索定位代码位置

Q2:云原生改造中最常见的质量陷阱是什么?

A2:三大典型问题:

- 配置漂移:未使用ConfigMap/Secrets导致环境不一致

- 资源竞夺:多个StatefulSet争夺同一节点资源引发雪崩

- 监控盲区:未对Sidecar容器和服务网格代理进行指标